LSTM/RNN weight sharing/communication among units (parameter) in Keras?

deep-learning 228

原文标题 :LSTM/RNN weight sharing/communication among units (parameter) in Keras?

RNN/LSTM 层内的单元之间是否发生了任何类型的通信/共享?

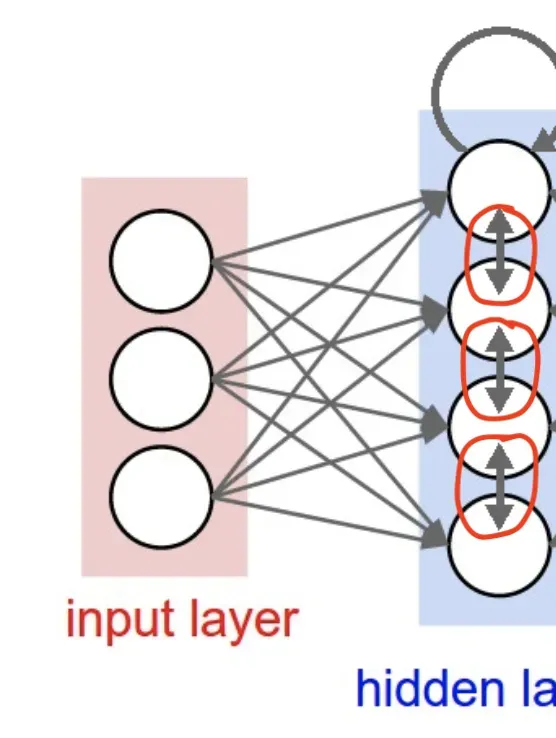

下图是从接受的答案中裁剪出来的,如何解释清楚Keras中units参数的含义?这里作者连接了RNN/LSTM层中的各个单元(标记为红色)。

我知道,在 RNN/LSTM 中,参数共享发生在时间步长上,但它发生在单元之间吗?

防爆代码

from keras.models import Sequential

from keras.layers import Dense, Dropout, Activation

from keras.layers import Embedding

from keras.layers import LSTM

model = Sequential()

model.add(LSTM(4, input_dim=3))

model.summary()

我遇到了这个讲座,教授说得很清楚,在同一层(Keras RNN/LSTM 中的单元)之间没有通信/共享/其他东西。

我认为通信/共享不会发生在同一层的单元之间。有人可以澄清/另想吗?