先读

https://blog.csdn.net/zhangjunhit/article/details/53536915

https://blog.csdn.net/qianqing13579/article/details/71076261

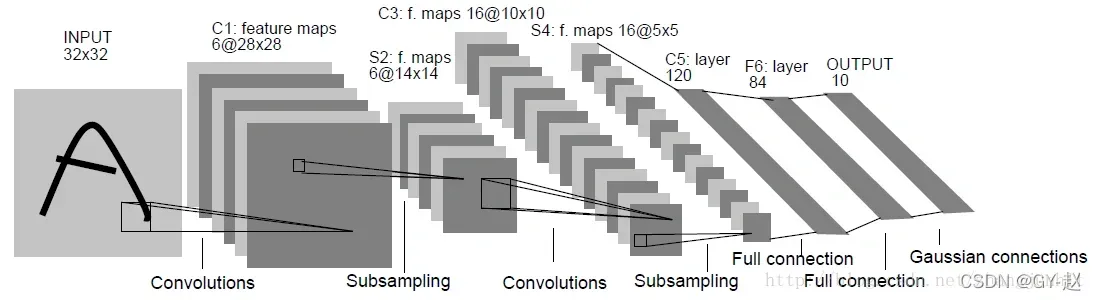

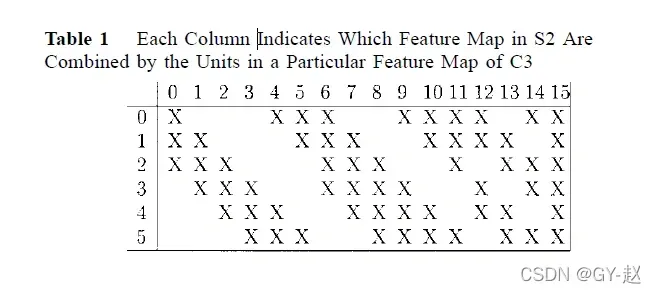

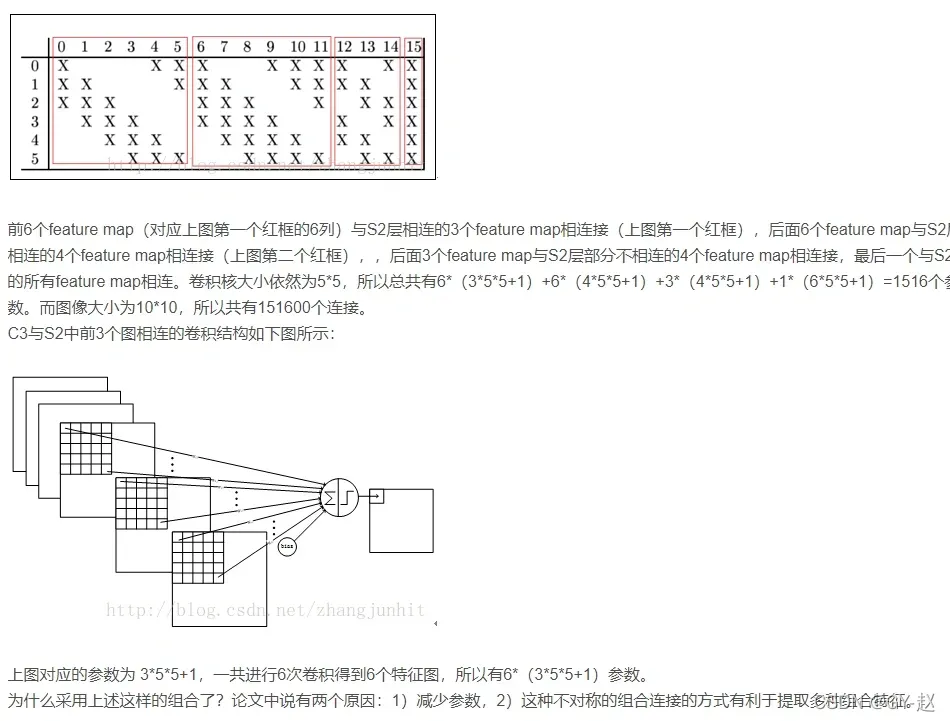

第三个卷积层,S2 6个1010的特征映射,C3是16个1010的特征映射,怎么做的呢?

关注C3层

Why not connect every S2 feature map to every C3 feature map? The reason is twofold. First, a noncomplete connection scheme keeps the number of connections within reasonable bounds. More importantly, it forces a break of symmetry in the network. Different feature maps are forced to extract different(hopefully complementary) features because they get different sets of inputs.

作者设计它有两个原因:

1.保持合理的连接数,减少参数数量

2.不同的输入组合迫使提取不同的特征

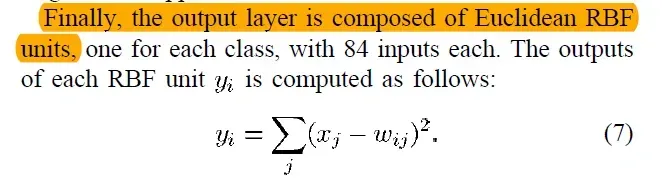

输出层

每个输出RBF单元计算其输入向量和参数向量之间的欧氏距离。输入距离参数向量越远,RBF输出越大。特定RBF的输出可以解释为一个惩罚项,用于测量输入模式和与RBF相关的类模型之间的拟合度。在概率方面,RBF输出可以解释为F6层配置空间中高斯分布的非规范化负对数似然。给定一个输入模式,应设计损失函数,以使F6的配置尽可能接近与模式所需类别对应的RBF参数向量。这些单元的参数向量由人工选择并保持固定(至少最初)。

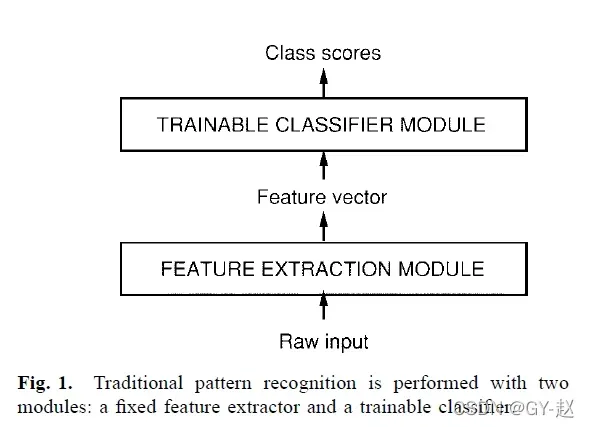

传统模式识别由人工设计的特征提取器和可训练的分类器组成

HOS 高阶统计量 可用于运动分割等领域

关于翻译不变性

不幸的是,没有这样的预处理是完美的:

笔迹通常在单词级别进行标准化,这可能导致单个字符的大小、倾斜度和位置发生变化。这与写作风格的多样性相结合,将导致输入对象中不同特征的位置发生变化。原则上,一个足够大的全连接网络可以学习产生不受这种变化影响的输出。然而,学习这样的任务可能会导致在输入的不同位置放置多个具有相似权重模式的单元,以便在输入的任何位置检测到不同的特征。学习这些权重配置需要大量的训练样本来覆盖可能的变化空间。在卷积网络中,如下所述,可以通过强制对权重配置进行空间复制来自动获得平移不变性。

局部感受野

其次,全连接架构的一个缺陷是输入的拓扑结构被完全忽略了。输入变量可以以任何(固定)顺序呈现,而不影响训练结果。相比之下,图像(或语音的时频表示)具有强大的二维局部结构:空间或时间相邻的变量(或像素)高度相关。局部相关性是在识别空间或时间对象之前提取和组合局部特征这一众所周知的优势的原因,因为相邻变量的配置可以分为少数类别(例如,边缘、角落等)。卷积网络通过将隐藏单元的感受野限制为局部来强制提取局部特征。

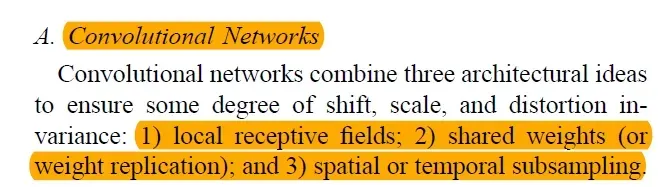

卷积神经网络由3个结构特性组成:局部感受野、共享权重、时间空间下采样

由于所有权重都是通过反向传播学习的,因此卷积网络可以看作是合成了自己的特征提取器。

A complete

convolutional layer is composed of several feature maps

(with different weight vectors), so that multiple features

can be extracted at each location

文章出处登录后可见!