第 1 章:数据加载和初步观察 + 探索性数据分析

实验代码

1.1 载入数据

1.1.1 任务一:导入numpy和pandas

# 导入numpy和pandas

import pandas as pd

import numpy as np

1.1.2 任务二:载入数据

注:上传本地数据 [ 在 Jupyter 中操作需要 Upload]

(1) 使用相对路径载入数据

pd.read_csv('train.csv')

(2) 使用绝对路径载入数据

import os # 添加此头文件 否则会报错

# 查询数据集的绝对路径

os.path.abspath('train.csv')

# 载入数据

pd.read_csv('C:\\Users\\DELL\\train.csv')

相对路径:指文件所在路径引起的与其他文件(或文件夹)的路径关系

绝对路径:指目录中的绝对位置,直接指向目标位置,通常是从盘符开始的路径

(3) 查看数据集头部和尾部数据

df = pd.read_csv('train.csv')

df.head()

df.tail()

(4) 数据转置

df.T

【思考】知道数据加载的方法后,试试pd.read_csv()和pd.read_table()的不同,如果想让他们效果一样,需要怎么做?

【思考回答】pd.read_table(‘C:\Users\DELL\train.csv’,sep = ‘,’)能够解决问题

pd.read_table('C:\\Users\\DELL\\train.csv')

pd.read_table() 以制表符 \t 作为数据的标志。以行为单位进行存储,所以没有分隔

pd.read_table('C:\\Users\\DELL\\train.csv',sep = ',')

【思考】了解一下’.tsv’和’.csv’的不同,如何加载这两个数据集?

【思考回答】TSV 文件和 CSV 的文件的区别是:前者使用 \t 作为分隔符,后者使用 , 作为分隔符。

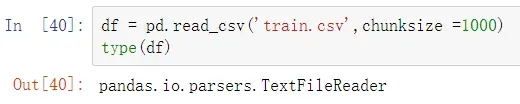

1.1.3 任务三:每1000行为一个数据模块,逐块读取

# 原数据类型

type(pd.read_csv('train.csv'))

# 模块读取数据的数据类型

df = pd.read_csv('train.csv',chunksize =1000)

type(df)

# 逐块读取

df.get_chunk()

[思考] 什么是逐块阅读?为什么要逐块读取?

【思考与回答】是将课文分成若干块;当面对大量数据时,我们只想截取其中的一部分进行问题分析。

【提示】chunker(数据块)是什么类型?

1.1.4 任务四:将表头改成中文,索引改为乘客ID [对于某些英文资料,我们可以通过翻译来更直观的熟悉我们的数据

# 将表头改成中文形式

# 方法一(替换)

df = pd.read_csv('train.csv')

df.columns = ['乘客ID','是否幸存','仓位等级','姓名','性别','年龄','兄弟姐妹个数','父母子女个数','船票信息','票价','客舱','登船港口']

df

# 方法二(增加)

df = pd.read_csv('train.csv', names=['乘客ID','是否幸存','仓位等级','姓名','性别','年龄','兄弟姐妹个数','父母子女个数','船票信息','票价','客舱','登船港口'])

df

1.2 初步观察

导入数据后,要对数据的整体结构和样例进行概览,比如说,数据大小、有多少列,各列都是什么格式的,是否包含null等

1.2.1 任务一:查看数据的基本信息

# 打印摘要

df.info()

# 描述性统计信息

df.describe()

【提示】有多个功能可以做到,可以做个总结

【提示回答】

df.info(): # 打印摘要

df.describe(): # 描述性统计信息

df.values: # 数据

df.to_numpy() # 数据 (推荐)

df.shape: # 形状 (行数, 列数)

df.columns: # 列标签

df.columns.values: # 列标签

df.index: # 行标签

df.index.values: # 行标签

df.head(n): # 前n行

df.tail(n): # 尾n行

pd.options.display.max_columns=n: # 最多显示n列

pd.options.display.max_rows=n: # 最多显示n行

df.memory_usage(): # 占用内存(字节B)

1.2.2 任务二:观察表格前10行的数据和后15行的数据

df.head(10)

df.tail(15)

1.2.3 任务三:判断数据是否为空,为空的地方返回True,其余地方返回False

# 判断是否为空

df.isnull()

【总结】以上操作都是在数据分析中对数据本身的观察。

1.3 保存数据

1.3.1 任务一:将你加载并做出改变的数据,在工作目录下保存为一个新文件train_chinese.csv

df.to_csv('train_chinese.csv')

1.4 了解数据

开始前导入numpy和pandas

import numpy as np

import pandas as pd

1.4.1 任务一:pandas中有两个数据类型DateFrame和Series,通过查找简单了解他们。

Series 一维标签数据结构

DateFrame 二维标签数据结构

# 简单了解

# Series随机生成数据

s = pd.Series(np.random.randn(5),index=['a','b','c','d','e'])

s

# Series规定生成

s = pd.Series([1,2,3,4,5],index=['a','b','c','d','e'])

s

# Series可以用字典实例化 (直接给标签)

s = pd.Series({'b':1,'a':0,'c':2})

s

用Series字典或字典生成DataFrame

生成的索引是每个Series索引的并集。先把嵌套字典转换为Series。如果没有指定到列,DataFrame的列就是字典键的有序列表。

# 用Series字典或字典生成DataFrame

d = {'one':pd.Series([1.,2.,3.],index=['a','b','c']),

'two':pd.Series([2.,3.,4.],index=['b','c','d'])}

d

df = pd.DataFrame(d)

df

1.4.2 任务二:根据上节课的方法载入”train.csv”文件

df = pd.read_csv('train.csv')

df

1.4.3 任务三:查看DataFrame数据的每列的名称

# 输出每一列的项

df.columns

1.4.4任务四:查看”Cabin”这列的所有值[有多种方法]

# 查看"Cabin"这列的所有值

# 方法一(直接查看)

df.Cabin

# 方法二(索引查找)

df['Cabin']

type(df['Cabin']) # 查看类型

# 返回DataFrame类型

df[['Cabin']]

1.4.5 任务五:加载文件”test_1.csv”,然后对比”train.csv”,看看有哪些多出的列,然后将多出的列删除

【发现】测试集test_1.csv 有一列是多余的,我们需要将这个多余的列删去

# 加载文件"test_1.csv"

df = pd.read_csv('test_1.csv')

df

# 多余的列删去

del df['a']

df.head(3)

# 注:重新输出原数据

# 显示删除的内容

df.pop('a')

[思考] 有没有其他方法可以删除多余的列?

# 删除指定的列(方法二)(此操作是在副本中进行删除)

df = pd.read_csv('test_1.csv')

df.drop(['a'],axis=1)

# 删除指定的列 (真正删除)

df = pd.read_csv('test_1.csv')

df.drop(['a'],axis=1,inplace=True)

df.head(3)

1.4.6 任务六: 将[‘PassengerId’,‘Name’,‘Age’,‘Ticket’]这几个列元素隐藏,只观察其他几个列元素

# 隐藏元素(在副本中进行操作,并未真正删除)

df = pd.read_csv('test_1.csv')

df.drop(['PassengerId','Name','Age','Ticket'],axis=1)

【思考】对比Task 5和Task 6,你是不是使用了不同的方法(功能)?如果使用相同的功能,如何完成以上不同的需求?

【思考回答】如果想要完全的删除你的数据结构,使用inplace=True,因为使用inplace就将原数据覆盖了,所以这里没有用

1.5 筛选的逻辑

在表格数据中,最重要的功能是具有过滤、选择所需信息、丢弃无用信息的能力。

1.5.1 任务一: 我们以”Age”为筛选条件,显示年龄在10岁以下的乘客信息。

# 以"Age"为筛选条件,显示年龄在10岁以下的乘客信息

df = pd.read_csv('test_1.csv')

df['Age']<10 # 直接筛选年龄小于10的信息,做出判断

# 显示筛选年龄小于10的信息

df[df['Age']<10] # df['Age']<10 充当索引

1.5.2 任务二: 以”Age”为条件,将年龄在10岁以上和50岁以下的乘客信息显示出来,并将这个数据命名为midage

# 将年龄在10岁以上和50岁以下的乘客信息显示出来

df[(df['Age']>10)& (df['Age']<50)]

# 将数据命名为midage

midage = df[(df['Age']>10) & (df['Age']<50)]

midage

【提示】了解pandas的条件筛选方式以及如何使用交集和并集操作

交叉点符号“&”

联合符号“|”

1.5.3 任务三:将midage的数据中第100行的”Pclass”和”Sex”的数据显示出来

# 将数据中特定数据显示出来

midage.loc[[100],['Pclass','Sex']]

[提示] 在提取数据时,我们希望数据的相对顺序保持不变。可以用什么函数来达到这个效果?

【提示回答】reset_index()函数

【思考】这个reset_index()函数的作用是什么?

【思考回答】将DataFrame的索引重新设置

reset_index()函数的参数

drop: 重新设置索引后是否将原索引作为新的一列并入DataFrame,默认为False

inplace: 是否在原DataFrame上改动,默认为False

level: 如果索引(index)有多个列,仅从索引中删除level指定的列,默认删除所有列

col_level: 如果列名(columns)有多个级别,决定被删除的索引将插入哪个级别,默认插入第一级

col_fill: 如果列名(columns)有多个级别,决定其他级别如何命名

1.5.4 任务四:使用loc方法将midage的数据中第100,105,108行的”Pclass”,”Name”和”Sex”的数据显示出来

# 将数据中特定数据显示出来

midage.loc[[100,105,108],['Pclass','Name','Sex']]

1.5.5 任务五:使用iloc方法将midage的数据中第100,105,108行的”Pclass”,”Name”和”Sex”的数据显示出来

# 使用iloc方法将数据中的特定数据显示出来

midage2.iloc[[100,105,108],[3,4,5]]

【思考】对比iloc和loc的异同

loc是根据index来索引,比如下边的df定义了一个index,那么loc就根据这个index来索引对应的行。

iloc并不是根据index来索引,而是根据行号来索引,行号从0开始,逐次加1

1.6 了解数据

实验代码

# 导入numpy和pandas

import pandas as pd

import numpy as np

# 使用相对路径载入数据

df = pd.read_csv('train_chinese.csv')

1.6.1 任务一:利用Pandas对示例数据进行排序,要求升序

自己构建一个都为数字的DataFrame数据

data = pd.DataFrame(np.arange(12).reshape((3,4)))

print(data)

# 生成一个二维数组(3*3)

# index 对象的索引列

# columns对象的索引行

data = pd.DataFrame(np.random.randn(3, 3),

index=list('213'),

columns=list('bca'))

data

构建的DataFrame中的数据根据某一列,升序排列

# 根据某一列,升序排列

data.sort_values('b')

sort_values这个函数中by参数指向要排列的列,ascending参数指向排序的方式(升序还是降序)

按升序对行索引进行排序

# 让行索引升序排序

data.sort_index()

按升序对列索引进行排序

# 让列索引升序排序

data.sort_index(axis=1)

按降序对列索引进行排序

# 让列索引降序排序

data.sort_index(axis=1, ascending=False)

同时对任意两列数据进行降序排序

# 让任选两列数据同时降序排序

data.sort_values(by=['a', 'c'], ascending=False)

1.6.2 任务二:对泰坦尼克号数据(trian.csv)按票价和年龄两列进行综合排序(降序排列)

# 按票价和年龄两列进行综合排序(降序排列)

df.sort_values(by=['票价', '年龄'], ascending=False)

【分析】票价越高,成活率越高;年龄越大,成活率越低

1.6.3 任务三:利用Pandas进行算术计算,计算两个DataFrame数据相加结果

# 生成一个二维数组(3*3)

# index 对象的索引列

# columns对象的索引行

x = pd.DataFrame(np.random.randn(3, 3),

index=list('213'),

columns=list('bca'))

y = pd.DataFrame(np.random.randn(3, 3),

index=list('413'),

columns=list('bcd'))

x + y

注:两个DataFrame相加后,会返回一个新的DataFrame,对应的行和列的值会相加,没有对应的会变成空值NaN

1.6.4 任务四:通过泰坦尼克号数据如何计算出在船上最大的家族有多少人?

df = pd.read_csv('train_chinese.csv')

max(df['兄弟姐妹个数']+df['父母子女个数']) # 最大值

1.6.5 任务五:学会使用Pandas describe()函数查看数据基本统计信息

df = pd.read_csv('train_chinese.csv')

df.describe()

from matplotlib import pyplot as plt

df = pd.read_csv('train_chinese.csv')

plt.hist(df['年龄'])

1.6.6 任务六:分别看看泰坦尼克号数据集中 票价、父母子女 这列数据的基本统计数据

df['票价'].describe()

【分析】票价高的乘客少,一般都是普通票价;舱位等级对票价有一定影响,也可以针对乘客的贫富差距较大。

df['父母子女个数'].describe()

df['兄弟姐妹个数'].describe()

【分析】大多数乘客的父母子女为0,并且兄弟姐妹人数也较少

df['是否幸存'].describe()

【分析】幸存者数量比较少,说明当时的死亡情况非常惨烈

【总结】

本章节主要借助详细且真实的数据,了解数据分析和熟悉数据分析的基本操作。理解数据各个字段的含义,通过函数的运用,得出更为深层次的信息,进行探索性分析,与此同时,利用Pandas进行排序、算术计算以及计算描述函数describe()的使用得出各数据字段间的关联性。在此过程中,分析思维得到了进一步的提升。

文章出处登录后可见!