修改自我的组会报告ppt。

介绍

从ICLR2020的论文中,选择了强化学习方向的五篇最新论文,简要描述一下论文的中心思想,具体细节请阅读原文。

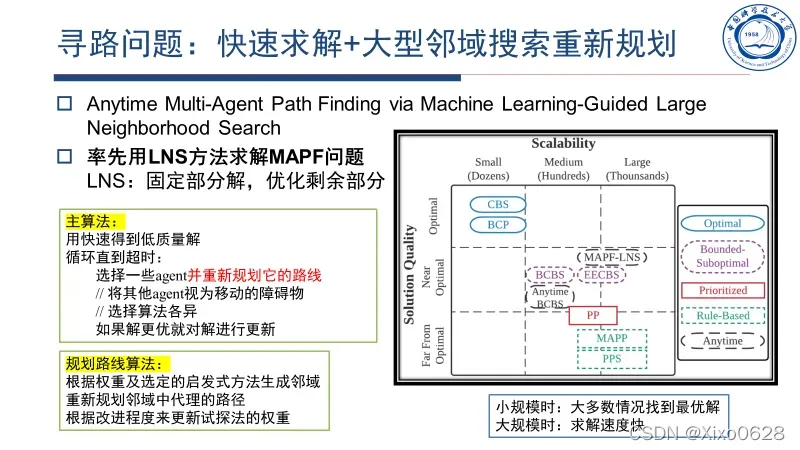

Anytime Multi-Agent Path Finding via Machine Learning-Guided Large Neighborhood Search

本文主要讨论的是方格世界寻路问题,每个agent前往一个目标地点,agent之间不能相互碰撞。主要的思想是用常规方法快速求出一个可行的低质量解,然后用大型领域搜索(LNS)的方式不断优化。

目前能稳定求高质量解的算法CBS和BCP只能适用于小规模问题,而适用于大规模问题的MAPP和PPS则只能求出低质量的解。本文的算法算是两者优点的一个结合。

关于LNS的方法,就是选择一些agent(可以用不同的选择算法,随机选也不太坏)当作一个整体,然后重新规划他们的路线,把其他的agent视作移动的障碍物。然后对于这样的一个松弛问题,如果解优于之前就对解进行更新。

路线规划算法都是关于基于权重和定义的启发式探索域。根据新算法的改进程度,更新启发式方法的权重,以实现更有效的路径启发式。

MAPF-LNS2: Fast Repairing for Multi-Agent Path Finding via Large Neighborhood Search

本文和上文基于相同的思想,不过本文的模型认为,允许少量的agent碰撞发生。也就是说问题相比上题更加松弛。

本文的解法也和上文类似,先找到一组低质量的解,然后选择有碰撞的路径,对路径相关的agent进行重新规划,尽量减少路径的冲突数量,直到路径变得无冲突。

当然,本文的方法不能保证在指定时间内返回无冲突的解决方案(我认为有可能陷入循环无法解决),但它总是返回路径规划方法有少量碰撞。文章认为,根据经验,该解决方案具有良好的运行速度和运行时间。

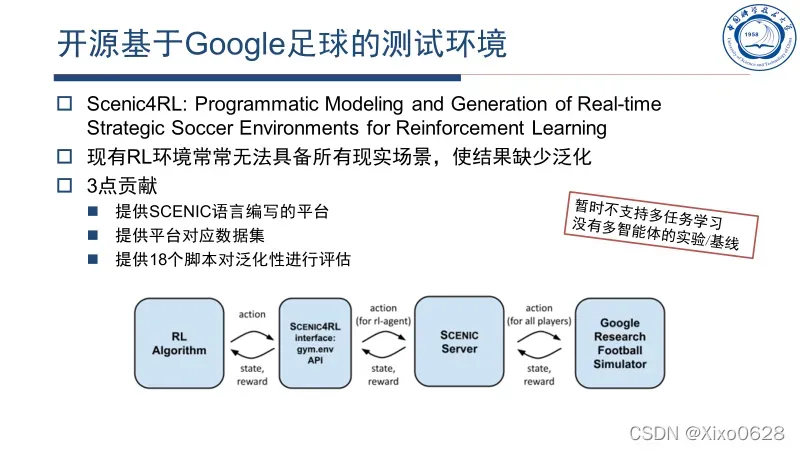

Scenic4RL: Programmatic Modeling and Generation of Real-time Strategic Soccer Environments for Reinforcement Learning

这篇文章我只看了个大概。核心就是开源了基于Google足球的测试环境。文章指出的三点贡献都列在图中,遗憾的是目前没有提供多智能体的实验/基线。

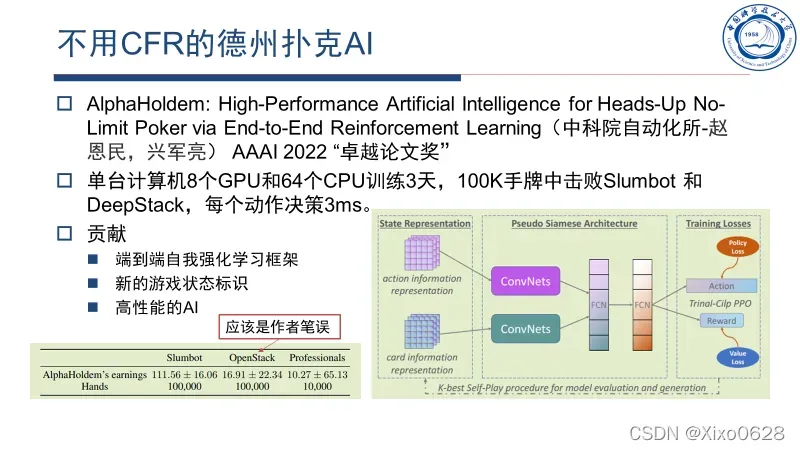

AlphaHoldem: High-Performance Artificial Intelligence for Heads-Up No-Limit Poker via End-to-End Reinforcement Learning

这篇文章感觉就比较厉害了,不用CFR的德州扑克AI,我去查了一下居然是国人写的。并且还获得了AAAI2022的卓越论文奖(这个奖大概只有10篇左右)。德州目前比较厉害的是前些年基于CFR(主要是博弈论那一套)的冷扑大师和冷扑2.0,基于深度神经网络的Slumbot和DeepStack其实水平都比较一般。

本文提供的算法训练速度快,效果好。

神经网络的结构如上图右下角所示,用伪孪生网络分辨对动作表征和牌面表征,使用全连接神经网络(FCN),使用强化学习中的PPO算法进行训练,用与之前K个最好的模型自博弈的方法不断优化自身策略。

该模型出人意料地简单,并且出人意料地运作良好。

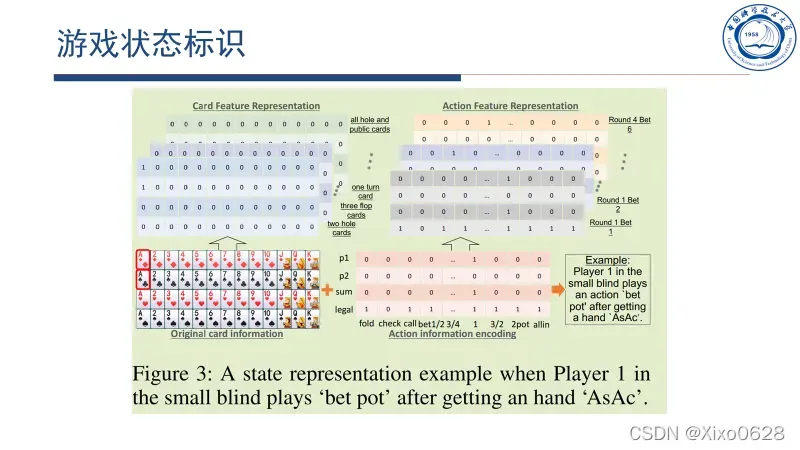

它的表征方式也很有趣,这里也提一嘴。用4个4*13的稀疏矩阵来分别表示手牌、翻牌、转牌和河牌。然后把动作也用类似地矩阵来表示。并规定每轮下注最多6轮(已经足够多了),然后翻前、翻牌、转牌和河牌各用一个矩阵来表示。上图红框就是翻前AA打了一个满池的动作表示。

正是这些稀疏矩阵用于使用伪连体网络进行学习。

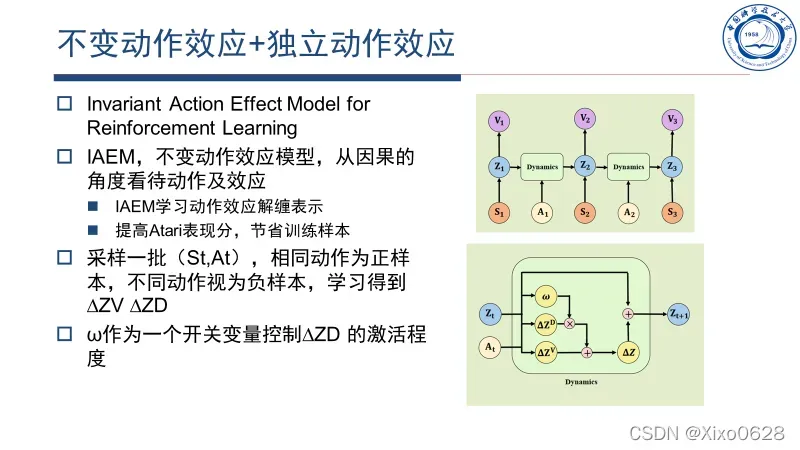

Invariant Action Effect Model for Reinforcement Learning

本文感觉上像是因果强化学习领域的文章。文章将动作产生的影响分为两部分,即不变动作效应(inv,∆ZV)和独立动作效应(ind,∆ZD)。然后把动作对环境的影响用右下角图的方式进行运算。∆ZV是动作直接、必然导致的结果,∆ZD是由于环境导致的结果。

比如方格世界中选择动作向上,人物向上一格的变化就是∆ZV,不管人站在何处∆ZV都不变。而如果撞墙等就会激活∆ZD,使得∆ZV+∆ZD为人物停留。把∆ZV+∆ZD作为最终人物的动作,使得人物停留在原地。

ω作为一个开关变量控制∆ZD 的激活程度,把激活后的∆ZD加到∆ZV上作为对环境的总影响。

文章出处登录后可见!