内容

介绍

相关工作

1、Unconditional normalization layers

2、Conditional normalization layers(这一部分挺重要的)

方法

3.1 、Spatially-adaptive denormalization

3.2 SPADE generator

3.3 为什么spade好

介绍

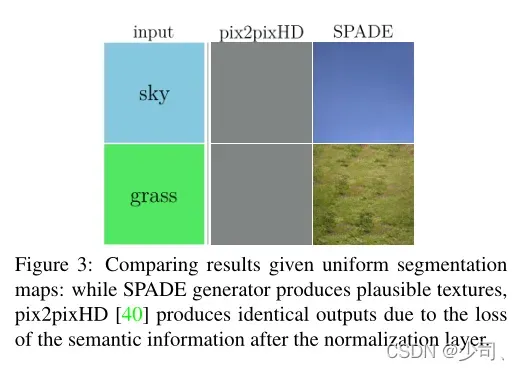

先前的工作(指的是pix2pix,pix2pixHD)是:semantic layout 作为网络input。作者认为由于normalization会洗掉语义信息,提出网络的输入the input layout for modulating the activations in normalization layers through a spatially adaptive, learned transformation.通过空间自适应学习转换使用输入语义布局来调制激活函数,这个翻译我一直不怎么理解。

这个怎么理解呢:Previous methods directly feed the semantic layout as input to the deep network, which is then processed through stacks of convolution, normalization, and nonlinearity layers.

这里要说明下,pix2pixHD的gen的输入就是semantic layout,之后通过后面的卷积。SPADE的gen的输入是经历过Spatially-Adaptive Normalization后的actvn:F.leaky_relu,然后一层一层conv啥的。

相关工作

1、Unconditional normalization layers

Local Response Normalization (LRN) in the AlexNet and Batch Normalization (BN) in the Inception-v2 network 等等, they do not depend on external data 。

这里的无条件理解为,bn层在train是学习的,test时候这个归一化固定了。SPADE指的是,根据input不同,bn输出结果是不同的。

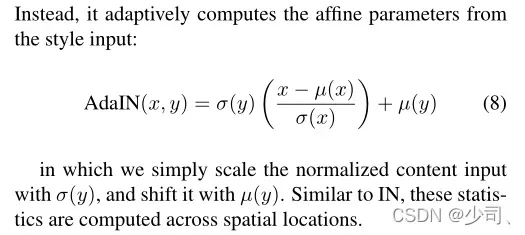

2、Conditional normalization layers(这一部分挺重要的)

Batch Normalization (Conditional BN) and Adaptive Instance Normalization (AdaIN).

基础 | batchnorm原理及代码详解_Double_V_的博客-CSDN博客_batchnorm这里对bn有一定说明。

方法

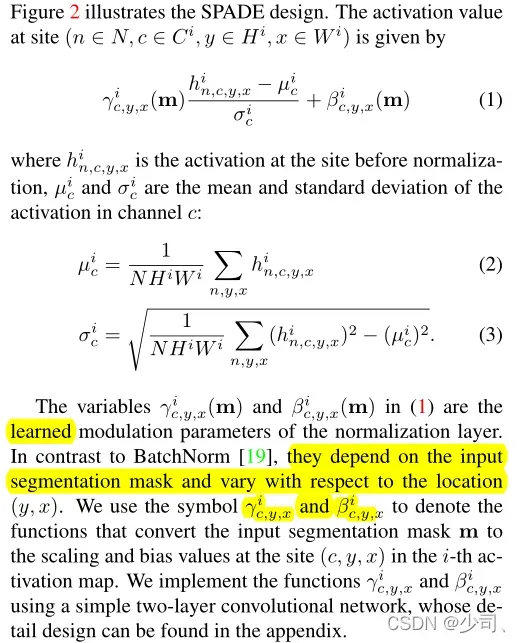

3.1 、Spatially-adaptive denormalization

Similar to Batch Normalization, the activation is normalized in the channel-wise manner, and then modulated with learned scale and bias.这两个因子是通过卷积学来的,作者认为they depend on the input segmentation mask and vary with respect to the location (y, x)。

注意这里的下标,ɥ和ɓ是和通道C相关的。这里gama和beta是和C,(y,x)相关的,具有位置信息,加上通道C,这也就是空间Spatially-Adaptive。注意这里的h是 the activation at the site。

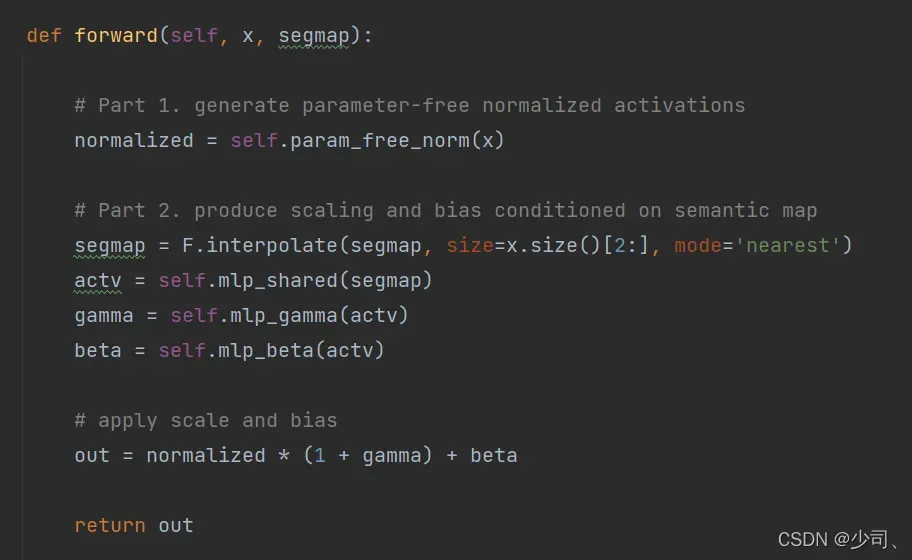

注意这里的代码:spade是先经历过norm的,输出经过actvn后再conv一大堆。而先前网路是直接喂入mask图后卷积balabala。

def actvn(self, x):

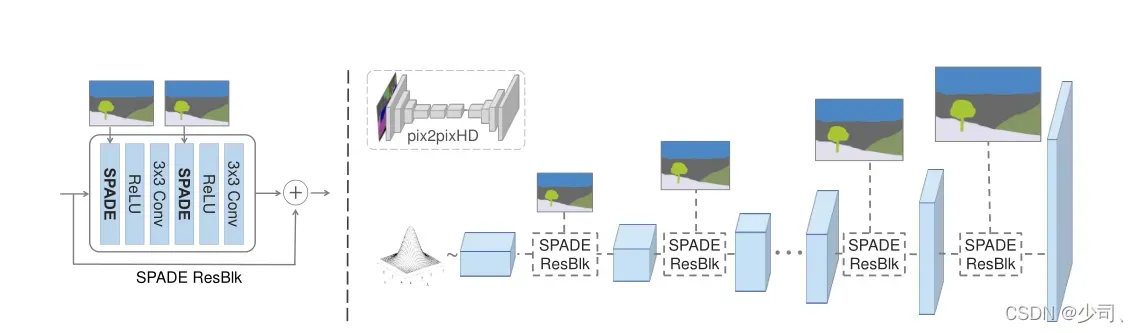

return F.leaky_relu(x, 2e-1)3.2 SPADE generator

作者舍弃了pix2pix和pix2pixHD中的encoder部分,这里作者认为 spade中的两个因子已经学到mask足够的信息。the learned modulation parameters have encoded enough information about the label layout.。为了多模态生成,使用随机变量作为一开始gen的输入。

说明了残差连接(好像,似乎残差连接再gan生成上效果一直较好)

3.3 为什么spade好

这里作者认为,spade比其他norm保留更好的语义信息。这里说一下对norm的理解,如有错误,请勘误!

假设norm的输入x的维度是 b, c, h, w,经历bn层是以b维度求均值、方差做归一化。后面加入可学习因子。

归一化的过程是线性操作,假设输入是b个二值图,背景的地方是在分布的最左边,目标类是右边。不影响什么。

那为什么作者说其他norm会洗掉 semantic information,出现在gama和beta因子上,这两个因子encoder enough information about the label layout。同时可以看见gen上,spade块有多次的mask输入,不会随着网络深度而消失。

原文解释:

现在有一个只有类的mask,例如天空image对应的mask,把mask作为input,先卷积后norm。卷积输出再次均匀化 ,不同的标签具有不同的均匀值 。现在 ,在我们将

InstanceNorm应用于输出之后,无论输入的语义标签是什么,标准化激活都将变为全零。SPADE Generator中的分割掩模通过空间自适应调制进行馈送而不进行归一化,仅前一层的激活被标准化。

实验

这部分证明了spade的有效、生成器、随机输入,证明了在gen上多次输入mask的好处。

文章出处登录后可见!