Introduction:

卷积神经网络(CNN)随着芯片和GPU的发展,应用的地方也越来越多,结构主要包括了输入层、卷积层、池化层、激活函数层、全连接层和输出sofmax层。其中卷积神经网络种类包括一维卷积神经网络(1DCNN)、二维卷积神经网络CNN和三维卷积神经网络(3DCNN),其分类标准主要是看内核在几维空间上移动。

如果使用全连接神经网络处理大规模图像,存在三个明显的缺点:

(1)首先将图像展开为向量会丢失空间信息;

(2)其次参数过多效率低下,训练困难;

(3)同时大量的参数也很快会导致网络过拟合。

卷积神经网络不存在这样问题,但是随着结构的复杂,对设备要求会高一些。

1、输入层

输入层就不多说了,依据你自己的数据是什么类型,然后选择合适卷积神经网络结构,最后根据所选CNN结构调整一下。

比如说1DCNN网络主要是在处理时间序列数据上使用;CNN网络主要是对基本的图像数据即(二维图像)进行处理;3DCNN主要处理3D图像数据,如处理医学上磁共振成像(MRI)数据。

2、卷积层

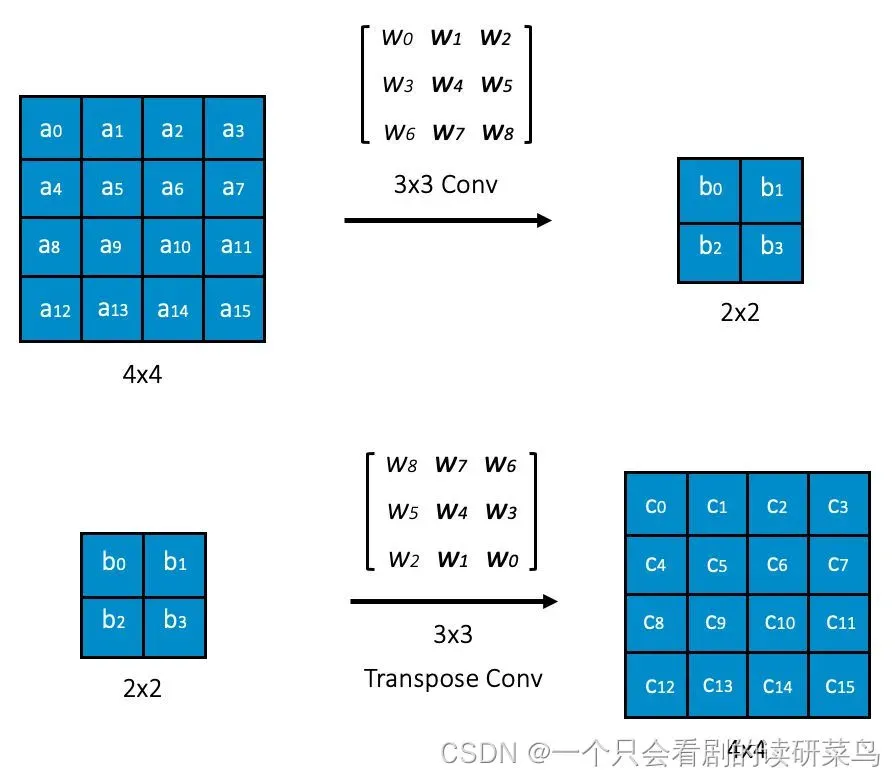

上述是一个二维卷积神经网络进行卷积和逆卷积的一个过程,其实也就是和正常的神经网络一样,输入数据×权重,不过这里就是有一个卷积核大小,还有移动步长,上述卷积核大小为3×3,移动步长为1。一般情况下, 特征图矩阵都是方阵, 这里设输入矩阵大小为 w, 卷积核大小为 k , 步长为 s , 补零层数为 p , 则卷积后产生的特征图大小计算公式为:

3、激活函数

卷积神经网络所选取的激活函数默认为Relu函数,其主要是对输入数据进行非线性化,更好的表达模型。还有其他激活函数tanh和sigmoid函数,可以对激活函数进行改进,使其非线性化更强,从而提升网络结构性能。

4、池化层

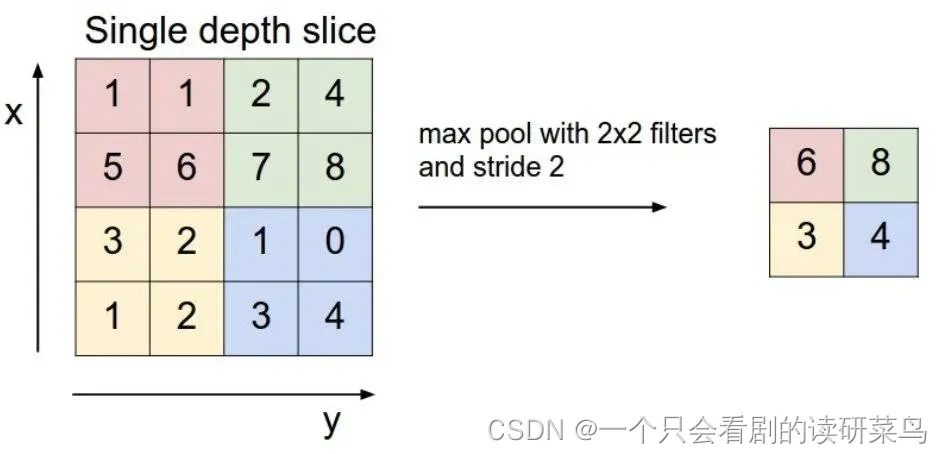

池化层的作用就是舍去一些特征,保存最明显的特征,减少了计算量。上图表述的就是池化大小为2×2,步长为2,使用最大池化方法进行池化,就是在2×2这四个数中取一个最大的。另外一种平均池化方法现在已基本被淘汰。

5、全连接层

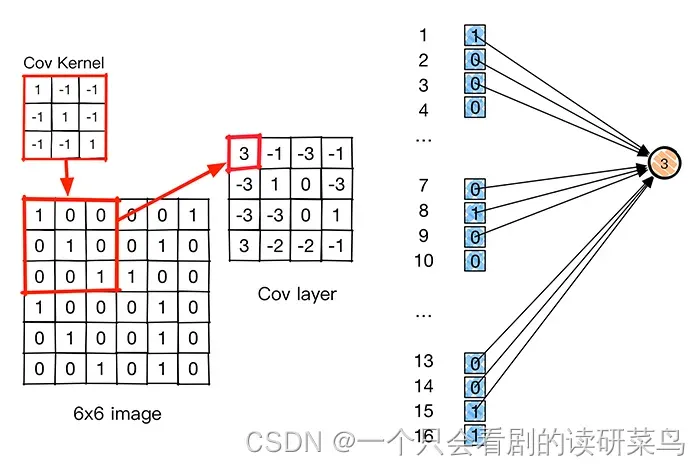

对于任一个卷积层,都存在一个能实现和它一样的前向传播函数的全连接层。该全连接层的权重是一个巨大的矩阵,除了某些特定部分,其余部分都是零;而在非 0 部分中,大部分元素都是相等的(权值共享),也和普通神经网络展开一样,权重×数据再加上偏差。

6、softmax层

Softmax层主要用于分类问题,我们可以得到当前样例属于不同种类的概率分布情况。

文章出处登录后可见!

已经登录?立即刷新