content

1. 背景[0]

2. 简介[0]

三、相关工作[0]

四、生成先验蒸馏法[0]

5. 基于对抗学习的图像转换[0]

6. 实验结果[0]

七、总结与讨论[0]

1. 背景

尽管图像转换有了发展,但要实现巨大的视觉差异还是较为困难。具有预训练类别条件的生成性先验GANs(如BigGAN)被用来学习丰富的内容对应关系,可以进行跨域较大的丰富内容的转换。

本文提出一个新框架,生成性先验引导的无监督的图像转换 (GP-UNIT)Generative Prior guided Unsupervised Image-to-image Translation。新方案由粗到精:提炼生成性先验,捕获一个可以在抽象语义层面连接目标的粗略级别内容表示,在此基础上自适应地学习细级别的内容特征,以获得更准确的多级内容对应。

优点:提高图像转换算法的质量和适用性,在健壮、高质量和多样化的图形生成中表现出色。

2. 简介

无监督的图像转换(UNIT):没有先验数据

主流的UNIT:假设转换的领域之间有转换关系,并利用循环一致性来建立转换的映射。虽然在跨域小的情况下效果较好,如马转斑马,但当跨域较大(形状外观差异较大)时这种方法效果急剧下降,如人脸转动物脸。

在广泛不同的领域进行转换需要在更高的语义级别上完成。例如,当人脸变成猫脸时,应该使用人脸和猫眼等面部成分之间更可靠的对应关系,而不是使用局部纹理。在较大的跨域情况下,比如动物到人造物体,转换关系需要在更高的抽象语义层次上确定,比如物体的朝向、物体在图像中的布局等。

在不同的语义层面建立转化,会降低UNIT模型找到不同语义之间的准确对应关系,训练此模型需要的这种复杂的对应关系,常不存在或不可收集。

通过生成性先验能克服上述问题,取得可喜成果。生成跨越图像对来挖掘出GAN的独特先验,并利用此来指导模型建立有效的、适应性强的跨类内容映射。

BigGAN:覆盖了大量的领域,成熟应用于多领域间转化。

缺点:虽然涉及领域广泛,但各个领域的质量和多样性发展有限。

新解决方案:将任务分解为粗到细的阶段

- 采用BigGAN进行生成性先验,以学习更稳定的高语义跨域映射关系。训练一个内容编码器,通过从BigGAN生成的内容相关数据中提炼出先验,来提取分解的内容表示。

- 对抗性学习图像转换,以在多个语义水平上建立更精细的适应性对应关系。将预先训练好的内容编码器应用于特定的翻译生成任务,不受BigGAN生成的影响,并提出一个动态链接模块来学习可适应的对应关系。

提出生成性先验引导的无监督的图像转换GP-UNIT框架,提高【原近领域的无监督的图像转换UNIT】与【BigGAN生成性先验】的质量与适用性。

- 捕捉各种物体和不对称领域的粗略对应关系,效果超过UNIT

- 从粗到细的阶段保留了基本的内容特征

- 在不同的语义级别上,自适应学习适用于跨域的各种对象的对应映射

三、相关工作

无监督的图像转换(UNIT):

无监督:CycleGAN提出循环一致性结论,以建立双向关系。为了更好地捕获领域不变特征,通常使用内容编码器和风格编码器分别提取领域不变内容特征和风格特征。

差异巨大的领域学习表征:COCO-FUNIT提出内容条件的风格编码器,防止转换与目标无关的外观信息。TGaGa使用地标来建立几何映射。TraVeLGAN提出连体网络来取到跨领域的共享语义特征。而U-GAT-IT使用一个注意模块集中注意区分两个域的重要信息。但这些方法对各种转换任务的适应性较差,对此提出新方案:由粗到细,在高度抽象的语义上进行粗级跨域的内容映射,在此基础上再逐步学习适应目标的精细级别的关联。

对抗性图像生成:GAN使用辨别器与生成器竞争的方式,对抗性地逼近真实的图像分布。StyleGAN用生成先验,通过限制生成的图像要在生成空间内,来确保高质量的图像质量。然而StyleGAN是无条件的,只在单一领域或距离较近的领域适用。BigGAN可以在不同的领域中协同处理图像,但往往质量与域内多样性较差。为解决这问题,本文把BigGAN生成的数据提炼出生成性先验,并将此应用于图像的转换中 ,以此提升生成图像的质量。

4. 生成先验提取方法

4.1 先验的跨域映射:

BigGAN生成的对象尽管来自多个领域,但由于是由同样的噪音潜码z生成的,所以也具有高度的内容相关性。图2显示了BigGAN的生成空间,特征是三个噪音潜码(z1,z2,z3),横跨五个领域。其中每个潜码是指对应关系,如狗和猫间可以观察到细粒度的对应关系,如面部特征和身体姿势。而鸟和车辆的对应关系则不同,可以在方向和图像布局方面观察到粗略的对应关系。尽管领域差异大,但是在高度抽象的语义层面也会有对应关系。

具有相同潜码的对象,在最初的几层是共享相似的代码表征,在此基础上再添加领域的细节。使用这种生成性先验的方式来建立起稳健的映射(使用BigGAN来做丰富的跨领域先验)。缺点有:

- 质量方面,BigGAN会生成一些不真实的物体,比如图2中狗的身体;

- 多样性方面 缺乏域内变化(同一域中,狗的纹理或鸟的颜色的多样性有限),导致在UNIT中使用此先验会使得模型对有限的表象过度拟合。BigGAN的基因空间只有ImageNet的1000个域(如图3中的四种家猫),对于实际的UNIT是不够的。

StyleGAN具有高质量与多样性的特点,常应用于在一个领域内通过潜码进行属性转移,但只能在单一的领域,不适合我们的任务。后来通过微调可实现StyleGAN的跨域转换,但跨域距离较小。

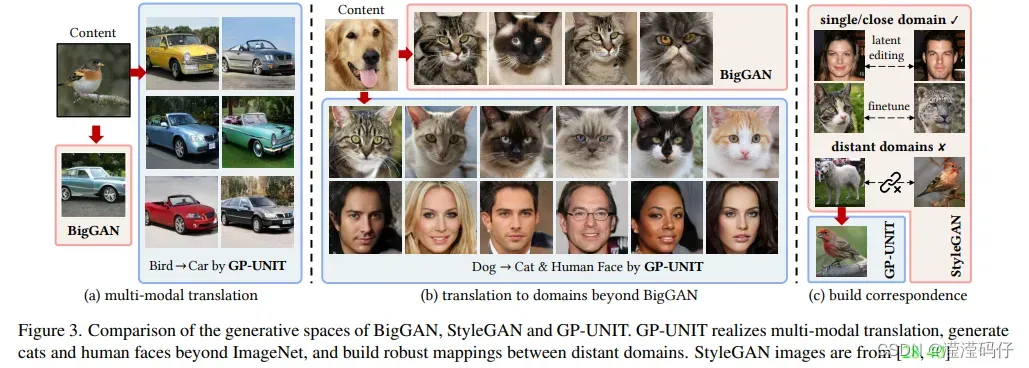

我们的框架能解决此问题,不是直接约束噪音潜码或图像空间,而是从BigGAN中提炼出一个通用的生成性先验,能独立地标记和训练转换的模块。以此实现多模式翻译(图3(a)),对ImageNet以外的类别进行生成(图3(b)),并在遥远的领域之间建立稳健的映射(图3(c))。

4.2 使用内容编码器进行事先提炼

- BigGAN从两个随机域X和Y中的公共随机潜码z生成的相关图像( x , y )。

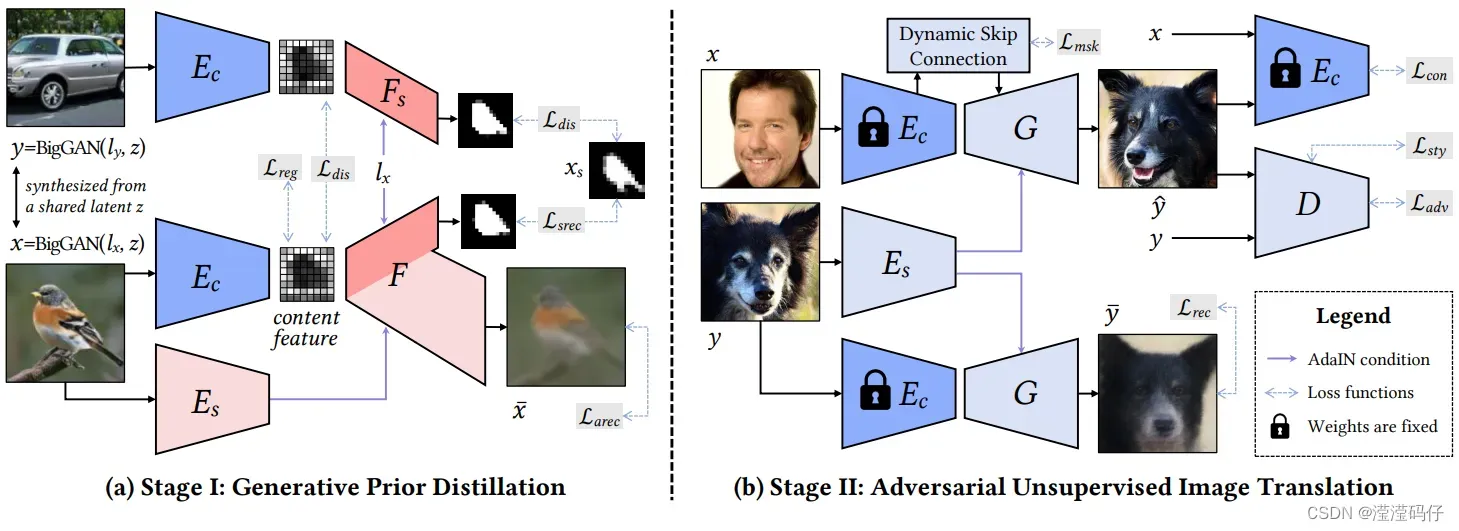

- 训练一个内容编码器Ec来提取BigGAN生成的一对图像它们共享的粗级内容特征,提取出的特征来重构它们的形状和外观。图4(a) 说明了这种用于生成先验精馏的自编码器流水线。

- 图4(b) 基于内容编码器Ec构建我们的翻译网络。为了简单起见,省略了分类器C。

- 使用一个解码器F,根据它的内容编码器Ec提取的内容特征Ec ( x )、一个样式编码器Es提取的样式特征Es ( x )和域标签lx来恢复外观x。

- 进一步利用F的浅层Fs来预测x ( 即由 HTC从 x中提取的实例分割图 xs )的形状。这样的辅助预测可以方便地对数百个领域进行训练。

除形状和外观重构外,我们进一步通过3种方式对内容特征进行正则化,以便提升泛化性:

- 1 ) x和y应共享相同的内容特征;

- 2 )引入具有梯度反转层R 的分类器C,使得内容特征域具有可辨识性;

- 3 )将Ec ( x )限制在一个信道上,以消除域信息,并加入固定方差的高斯噪声以提升鲁棒性。

目标函数为:

![]()

- Larec是一元损失,是计算外观重建的loss,Larec=

(

,输入内容x) 间的感知loss

- Lsrec是一元损失,是形状重建的loss,

- Ldis是二元损失,是配对输入缩小了x和y的内容特征之间的距离,用y的内容特征恢复x的形状的loss,

- Lreg是一元损失,是引导分类器C最大化分类精度同时推动Ec混淆分类器C,使内容特性具有域-不可知性。L2进一步应用于内容特征

对于Larec,Lsrec和Lreg的一元损失,我们还使用ImageNet 和CelebA – HQ 的真实图像进行训练,使Ec更通用。

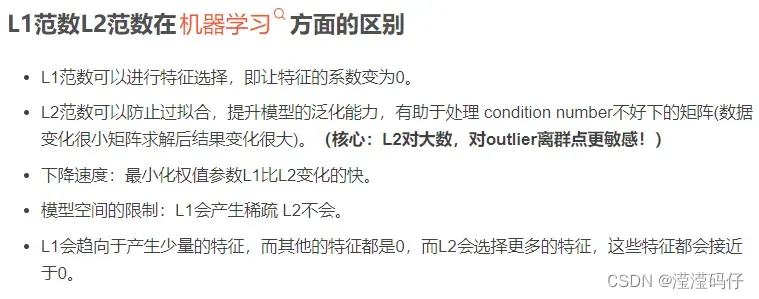

一些概念:

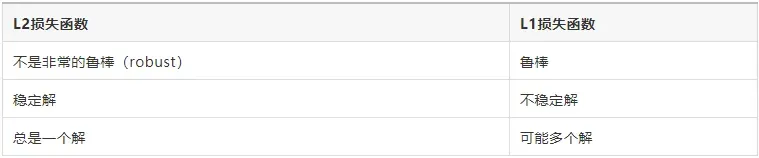

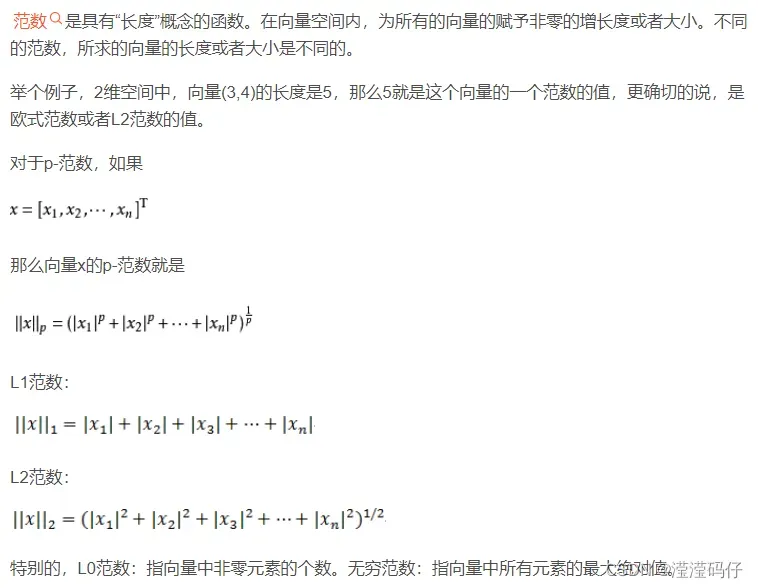

L1范数、L2范数

(L1范数是指向量中各个元素绝对值之和,L2范数定义为向量所有元素的平方和的开平方。)

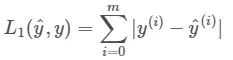

L1范数损失函数,也被称为最小绝对值偏差(LAD),最小绝对值误差(LAE)。总的说来,它是把目标值(Yi)与估计值(f(xi))的绝对差值的总和(S)最小化:

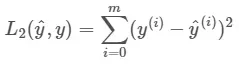

L2范数损失函数,也被称为最小平方误差(LSE)。总的来说,它是把目标值(Yi)与估计值(f(xi))的差值的平方和(S)最小化:

L1范数与L2范数作为损失函数的区别能快速地总结如下:

5. 基于对抗学习的图像转换

给定第一阶段预先训练好的固定内容编码器Ec,我们按照第二阶段的标准转移范式来构建我们的翻译网络。由于预先训练好的Ec为内容相似度提供了很好的度量,我们的框架不需要对Ec循环训练,只需要训练出Es即可。

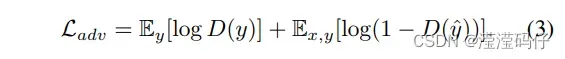

如图4(b)所示,我们的翻译网络接收到内容输入x∈X和风格输入y∈Y,网络分别提取其内容特征Ec(x)和风格特征分别Es(y)。然后生成器G通过AdaIN对Ec(x)进行调节以匹配y的样式,最终生成转化结果yˆ= G( Ec(x),Es(y) )。yˆ的逼真性通过一个辨别者D的对抗性训练得到加强。

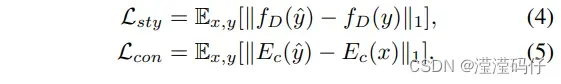

生成的yˆ要符合y的类型,同时保留x原有的内容特征,表述为style loss Lsty和content loss Lcon。其中fD是定义为D的中间层特征上的平均值的样式特征。

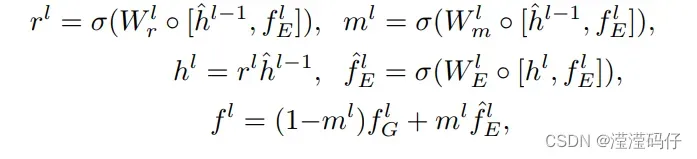

5.1 动态跳转链接

语义上接近域的内容对应关系需很细致,不能仅用抽象内容特征来描述。为了解决这一问题,我们提出了一个动态跳转连接模块,该模块将中间层特征从

传递到G,并预测掩码m,以此选择有效的元素来建立精细级内容对应。

动态跳转链接的灵感来自于循环神经网络GRU选择转移单元。GRU很聪明的一点就在于,使用同一个门控z就同时可以进行遗忘和选择记忆。

- 特别地,先设置第一个隐藏状态

,使用上采样卷积将

与

两者维数匹配

,其中

,o和

分别为上采样算子、卷积算子和卷积权重,激活层记为σ。

- 设上标l表示G中的一层,第l层的掩码

由同一层的编码器特征

和最后一层的隐藏状态

决定。

- 然后,第l层的模块更新隐藏状态

和编码器特征

。

- 并将编码器特征

与生成器特征

和预测掩码

融合

融合

其中[·,·]表示连接。与

具有相同的维数,既服务于通道注意,也服务于空间注意。此外,对

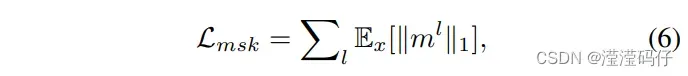

应用L1范数使其更稀疏,由此达到。只选择源领域中最有用的内容线索。

综合上述损失,我们的完整的目标:

![]()

新增重构损失Lrec:来衡量y和之间的L1和预知损失,

Lrec=L1(y,)。直观地说,我们希望一个图像的类型特征能够借助其内容特征精确地重构自己,从而使网络训练稳定。

类型采样:

为了在没有此类图像的情况下直接采样潜在类型特征以进行多模态生成,我们使用最大似然准则来训练基于后处理的映射网络,以将单位高斯噪声映射到潜在类型分布上。

6. 实验结果

数据集:

在第一阶段,我们准备了合成数据和真实数据。

- 对于合成的数据:我们使用官方的Big GAN 为291个域(包括动物和车辆)中的每个域生成随机潜码关联的相关图像。经过对低质量图像进行滤波处理,最终得到每一个域655幅图像,这些图像在所有域之间进行链接,其中600幅用于训练。我们将这个数据集表示为synImageNet-291。

- 对于真实数据:我们将HTC 应用到ImageNet 中,检测并裁剪对象区域。每个域使用600幅图像进行训练。我们将这个数据集表示为ImageNet – 291。

- 此外,还包括29K的CelebA-HQ人脸图像[ 23,33 ]进行训练。

第二阶段,我们对四个翻译任务进行评估。

- 1 ) 男性女性:CelebA-HQ 的28K训练图像;

- 2 ) 狗猫:AFHQ每域4K训练图像。

- 3 ) 人脸猫:4K AFHQ图像和29K CelebA – HQ图像。

- 4 )鸟狗汽车:ImageNet-291中的4类鸟、4类狗和4类汽车。

每四个类组成一个包含2.4K训练图像的域。我们使用“鸟->车”作为极端案例来测试GP-UNIT处理压力测试的能力。

网络训练:

- 设 λs = 5,λr = 0.001,λ1 = λ3 = λ4 = 1,λ2 = 50

- Cat→Human Face,我们新增一个身份loss,权重为1,以保持生成的人脸身份。

- 动态跳转链接被应用于G的第2层( l = 1 )和第3层( l = 2 )。

- 除男性女性外,我们不使用动态跳转链接去计算Lrec ( 通过将

设置为一个全零张量 )。

6.1 与最高水平技术的比较

定性比较

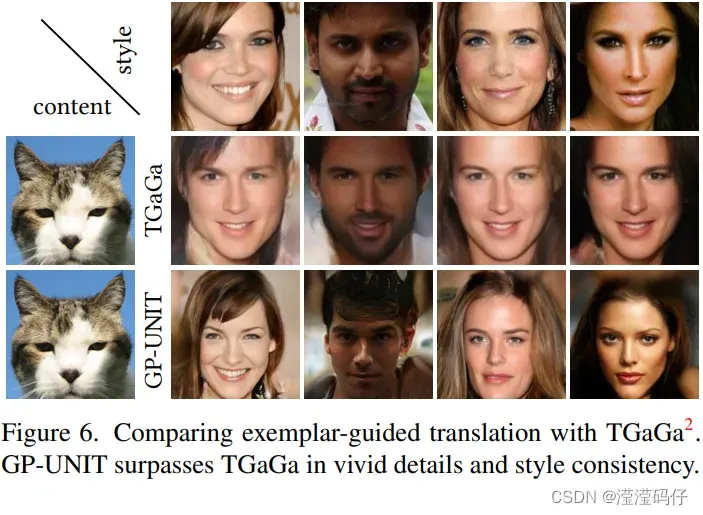

我们对图5和图6中6种最先进的方法进行了可视化比较。相比较而言,我们的方法与上述方法相比,在男性女性任务上具有可比性,在其他挑战性任务上表现出一致的优越性。

- 如图5所示,循环一致性引导的U-GAT-IT 、MUNIT 和StarGAN2 依靠输入图像的低级线索进行双向重建,导致了一些不希望出现的伪影,如带有狗耳朵的扭曲猫脸,以及生成的鸟图像中的吓人的狗腿。

- 同时,TraVeLGAN 和COCOFuNIT 未能建立合适的人类脸部猫、鸟汽车的内容对应关系。

- 在图6中,我们将我们的模型与TGaGa 进行了比较,TGaGa 也处理了范例引导转换中的大型几何变形。TGaGa产生模糊的结果,无法精确匹配示例外观,例如所有生成的人脸

GP-UNIT始终优于所有任务,并且随着任务变得更具挑战性,显示出更大的优越性( 从上到下)。

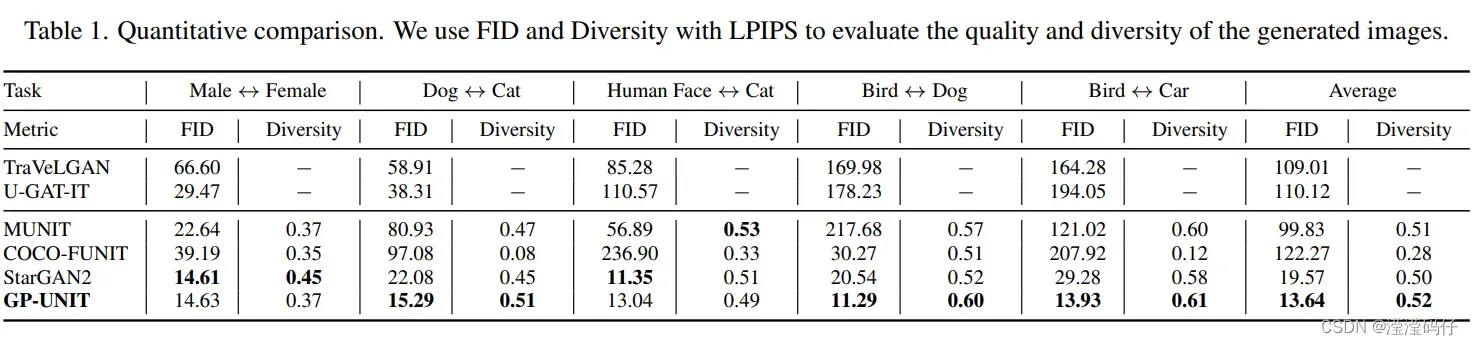

定量比较

进行质量和多样性的定量比较。FID 和LPIPS 分别用于评价生成数据与真实数据的图片质量与多样性。对于支持多模态转化的方法( MUNIT, COCO-FNIT, StarGAN2, GPUNIT),我们每次测试会生成10个配对翻译结果,我们从随机抽取潜在代码或示例图像来计算它们的平均多样性LPIPS距离。表1报告了所有测试图像的平均定量结果,与图5一致,即我们的方法效果达到或优于对比的方法,在困难任务上的优势更加明显,获得了最好的总体FID图像质量和LPIPS多样性。并发现GP-UNIT倾向于保留输入图像的背景。这种性质不利于多样性,但在某些应用中可能是有用的。虽然StarGAN2在Cat→Human Face上产生了逼真的人脸( 获得最好的FID图像质量 ),但它忽略了与输入猫脸的姿态对应关系( 内容一致性低于 GP-UNIT ),如图5所示。

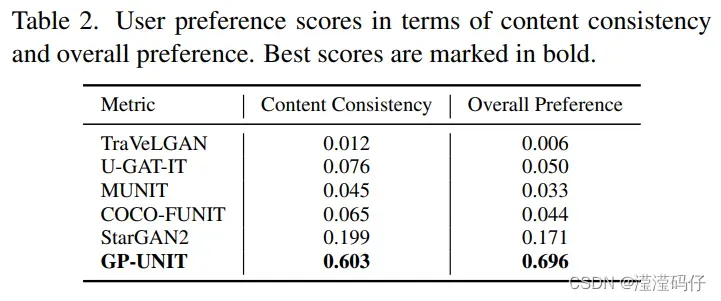

我们进一步进行用户研究来评估输入输出内容的一致性和整体转化性能。共有25名被试参与本研究,从这6种方法中选出他们认为最好的结果,并对50组结果进行了2500次选择。表2总结了平均偏好得分,其中所提方法在内容一致性和整体性能方面都受到显著的偏好。

6.2 消融实验(“控制变量法”地来查看每个部分起到的作用)

消融实验类似于“控制变量法”。假设在某目标检测系统中,使用了A,B,C,取得了不错的效果,但是这个时候你并不知道这不错的效果是由于A,B,C中哪一个起的作用,于是你保留A,B,移除C进行实验来看一下C在整个系统中所起的作用。

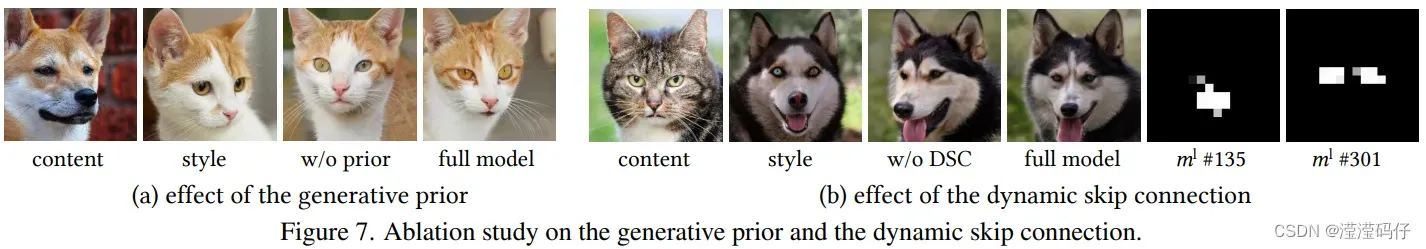

生成预提取

如图7 ( a )所示,如果我们在第二阶段与所有其他子网络一起从头开始训练我们的内容编码器Ec,就像大多数图像翻译框架一样,这个变种无法保存诸如眼睛位置等内容特征。相比之下,我们的预训练内容编码器预先成功地利用了生成器来更高效地构建有效的内容映射。指出了粗级内容特征的必要性,只有在此基础上才能学习有效的细级特征。因此,生成性先验是我们内容对应学习由粗到细方案成功的关键。

动态跳转连接

如图7 ( b )所示,在没有动态跳转连接( DSC )的情况下,模型不能保持鼻子和眼睛在内容图像中的相对位置。我们用全模型预测的掩模的第135和301通道有效地定位了这些特征,内容映射更为准确。

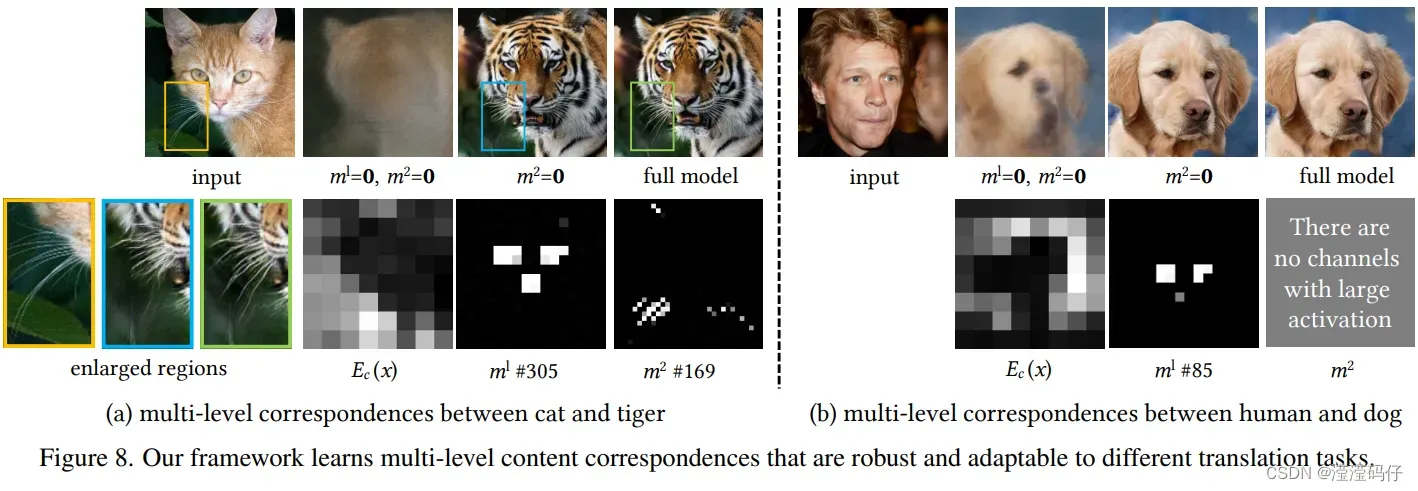

多层次的跨域对应

图8分析了学习到的多层次的跨域对应关系。最抽象的

图8分析了学习到的多层次的跨域对应关系。最抽象的只给出布局线索。如果我们只使用

( 通过将掩模

和

同时设置为0 ),则会导致得到的虎和狗脸没有细节。

关注中层细节,如在第305通道中猫脸的鼻子和眼睛,以及第85通道中人脸的眼睛等,这足以用

生成一个逼真的结果。

关注细微细节,用于近域,如第169通道中的猫须。

因此,我们的全多级内容特性使我们能够模拟极细级的长晶须。正如预期的那样,在更远的人和狗脸之间没有发现这种精细的对应关系,从而阻止了来自源域不必要的外观影响( 如图 5中生成的猫脸上的衣服 )。需要注意的是,这种合理的、适应性强的语义注意仅仅是通过先前的生成来学习的,没有任何明确的对应监督。

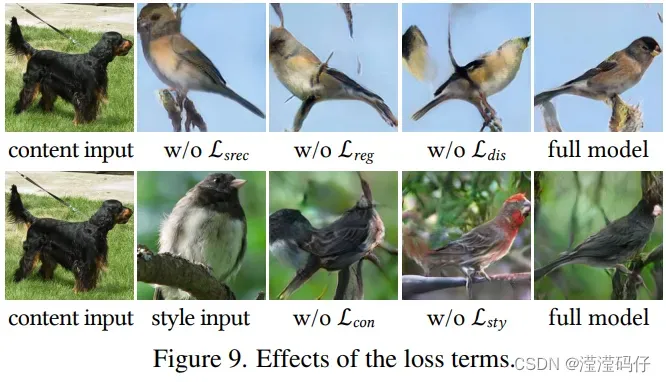

损失函数

图9研究了损失file:///C:/Users/Administrator/Desktop/a.png函数的影响。

在第一阶段(内容编码器Ec)

- Lsrec是学习正确内容特征的关键,或者没有建立对应关系。

- Lreg使得内容特征更加稀疏,以提高对不重要领域特定细节的鲁棒性。

- Ldis从源域(如狗尾巴)中发现领域共享特征以防止输出受到对象的影响。

在第二阶段(风格编码器)

- Lcon有助于加强对应位姿。

- 而Lsty则使输出更好地与示例图像的风格相匹配。

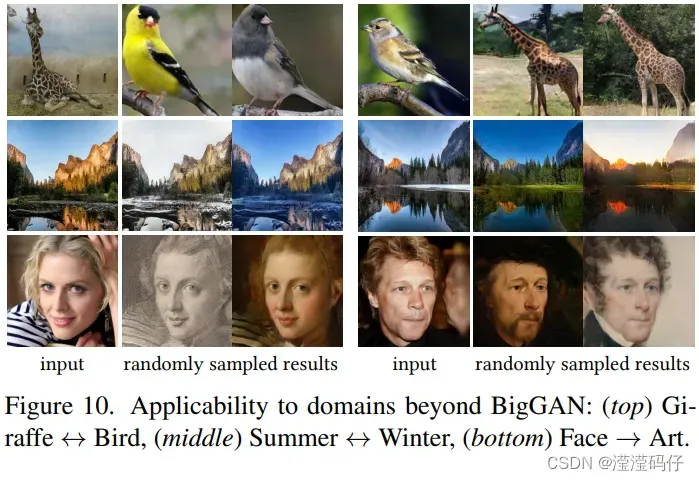

6.3 更多结果

泛化到BigGAN以外的领域

图10展示了物种转移、季节转移和面部造型三个应用。即使MS-COCO长颈鹿、Yosemite景观和Art肖像不在ImageNet 1000类中,同时也不被第一阶段的内容编码器所观测到,我们的方法能够很好地支持这些领域,并产生逼真的结果。

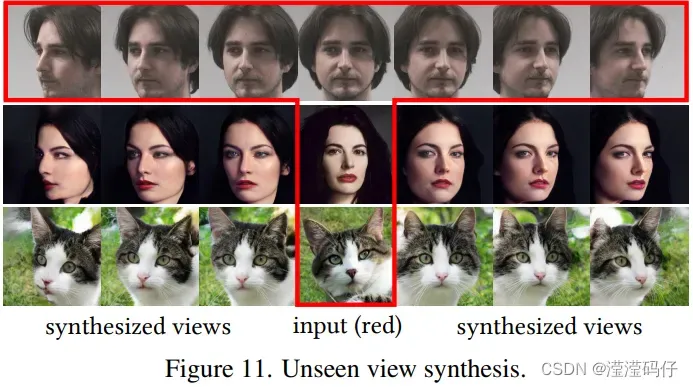

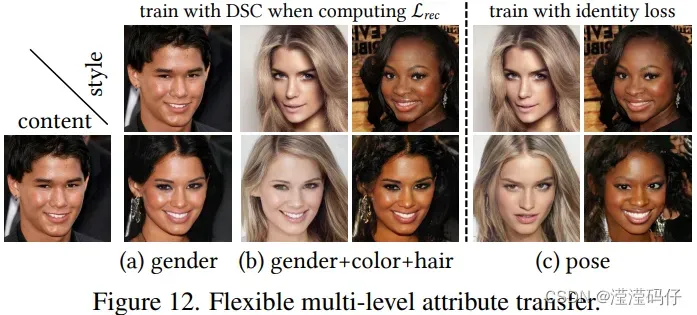

看不见的视图合成

图11显示了我们根据头部姿态图像数据库中的参考人脸在不同角度下合成的真实人脸和猫脸。为了转移身份和防止低水平的内容联系,我们添加了identity loss,并在计算Lrec时不使用DSC。

- 在计算Lrec时使用DSC:可以灵活地控制要传递的面部属性( 如图12 ),有助于保存面部内容的个体身份,适用于性别转移和颜色转移。(更注重content,注重细节)

- 使用identity loss,在计算Lrec时不使用DSC:除了姿态外,风格面的大部分属性都可以转移,适合于姿态转移。(更注重style,注重中层次)

6.4 出现的问题

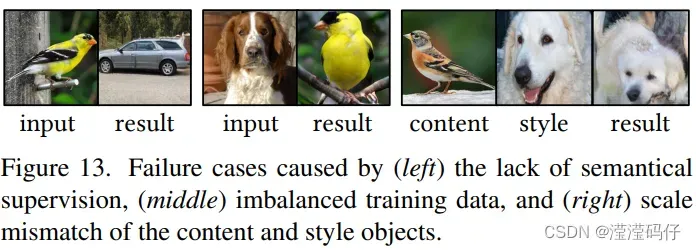

图13给出了我们方法的三个典型失败案例。

- 缺乏语义监督问题:仅从外观很难学习一些语义对应,例如汽车的哪一侧是它的前面。我们观察到鸟尾巴往往被翻译成汽车的前部,因为它们都是物体的较薄部分。

- 训练数据不平衡问题:由于缺乏直视摄像机的鸟类训练图像,我们的方法无法生成与狗共享头部方向的鸟类。因此,在使用此方法时,请注意可能存在的数据不平衡问题,尤其是数据集中的少数群体。

- 比例不匹配问题:当content内容图像和style风格图像中的对象具有非常不同的比例时,一些外观特征无法正确呈现。

七、总结与讨论

在本文中,我们在GAN生成之前建立了一个通用的UNIT框架。

我们的研究表明,所提出的两阶段框架能够在高语义水平上表征内容对应关系,以应对远距离域之间的多模态翻译任务。这样做的一个好处是,只要有域监督(即只知道每个图像所属的域),就可以发现这些内容的对应关系。

我们在第6.2节进一步发现,精细级别的内容关系仅通过生成任务就可以习得。这可能暗示了深度神经网络的一种有趣的行为,即通过从粗到细的方式自动查找和集成跨域的共享外观特征,以重建各种对象。它提出了一种生成学习的潜能:

- 通过生成和转换来建立对象关系。

- 另一个有趣的话题是学习对象外观之外的语义对应,例如在6.4节中的对象的正面。一个可能的方向是semi-supervised learning半监督学习,其中可标记少量数据以指定对应的语义。

参考:

欧氏距离,l2范数,l2-loss,l2正则化_Accelerating的博客-CSDN博客_l2范数计算公式范数、L1范数和L2范数的基本概念_lioncv的博客-CSDN博客_l2范数欧氏距离,l2范数,l2-loss,l2正则化_Accelerating的博客-CSDN博客_l2范数计算公式[0][1][2]

文章出处登录后可见!