论文链接:https://arxiv.org/pdf/2010.01057.pdf[0]

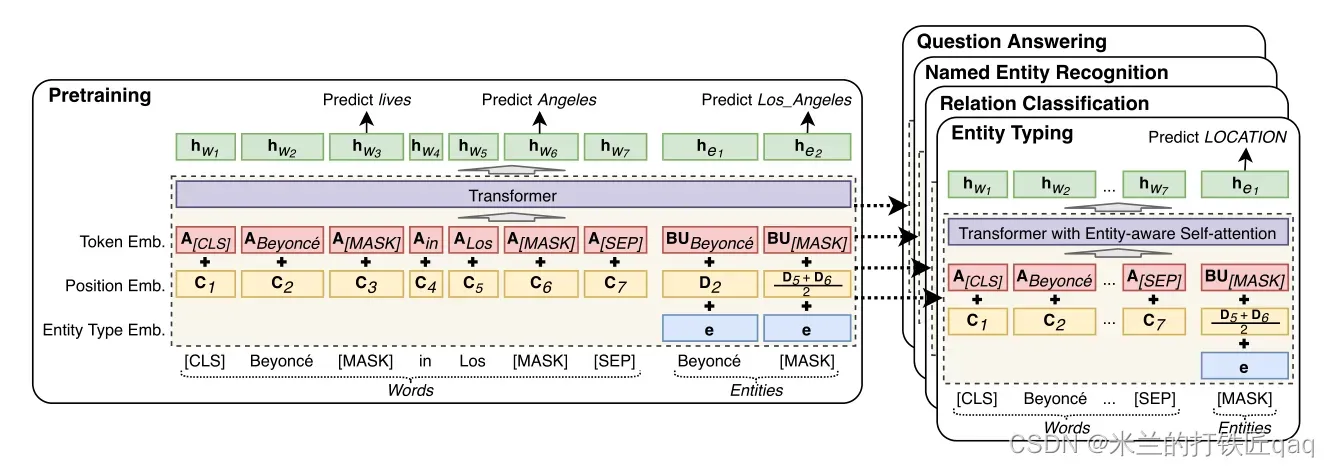

本文以Robert为基础训练模型,任务包括通过用[MASK]实体替换实体来随机屏蔽实体,并通过预测这些屏蔽实体的原件来训练模型。

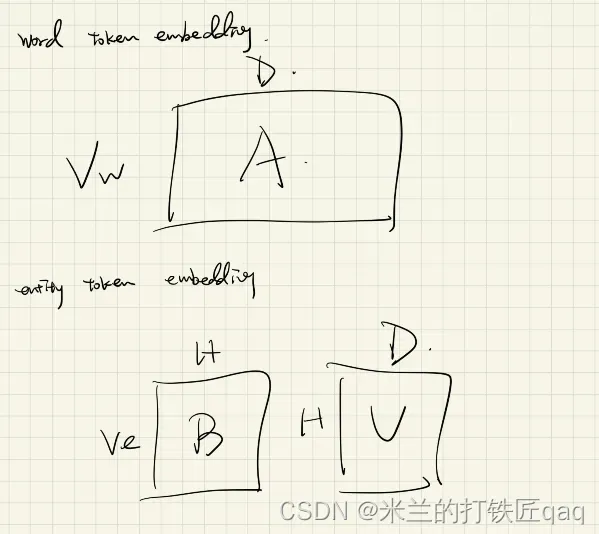

input respresentation:Token embedding + Position embedding + Entity type embedding(求和操作)

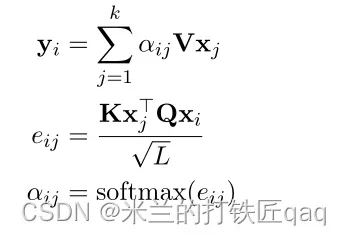

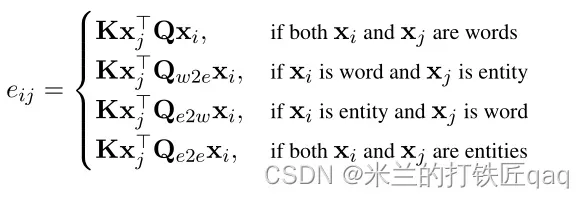

Entity-aware Self-attention:(entity与entity交互 entity与word交互 word与word交互)

Pretraing task:

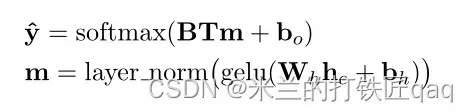

he是所有entity的预测的representation

Training detail:

我们随机屏蔽15%的所有词和实体。如果一个实体在词汇表中不存在,我们用[UNK]实体替换它。

nlp微调预训练模型已经是趋势了噢

文章出处登录后可见!

已经登录?立即刷新