1、什么是图注意力网络?

顾名思义,图注意力网络是图神经网络和注意力层的组合。要理解图注意力网络,我们首先需要了解什么是注意力层和图神经网络。首先,我们将看一下对图神经网络和注意力层的基本理解,然后我们将重点介绍两者的结合。让我们看一下图神经网络。

图神经处理是数据科学和机器学习领域研究的热点之一,因为它们具有通过图数据进行学习并提供更准确结果的能力。各种研究人员开发了各种最先进的图神经网络。图注意力网络也是一种将注意力机制应用于自身的图神经网络。

图注意网络可以解释为利用图神经网络中的注意机制,以便我们可以解决图神经网络的一些缺点。

(1)图神经网络(GNN)

图神经网络是能够处理和处理图结构信息或数据的网络。在我们的项目中使用图结构数据有很多好处,例如这些结构以图的顶点和节点的形式保存信息,并且神经网络很容易理解和学习存在于图形或三维结构。以与分类问题相关的数据为例,可以由节点形式的标签和顶点形式的信息组成。

大多数现实世界的问题都有非常庞大的数据,并且本身由结构信息组成。使用图神经网络可以提供最先进的执行模型。

(2)注意力层

在我们的一篇文章中,我们讨论了注意力层是一个使我们能够设计一个可以记忆长信息序列的神经网络的层。通常,我们在神经机器翻译问题中发现了这些层的用途。标准的神经网络通过以压缩上下文向量的形式对序列信息进行编码来工作。

如果网络中包含注意层,则网络将被迫通过在输入和上下文向量之间创建快捷方式来工作。注意层将帮助更改每个输出的快捷连接的权重。由于输入和上下文向量之间的连接提供了访问所有输入值的上下文向量,因此标准神经网络忘记长序列的问题得到了解决。

简单来说,我们可以说神经网络中注意力层的实现有助于关注数据中的重要信息,而不是关注整个数据。通过这种方式,我们可以使我们的神经网络更加可靠,并坚持唯一重要的信息。

在这里我们可以看到,到目前为止,我们一直在将注意力层应用于神经网络,但本文侧重于将注意力层或机制应用于图神经网络。让我们看看将注意力应用于图神经网络意味着什么。

(3)GNN和注意力层的结合

在以上几点中,我们已经讨论了图神经网络是处理具有长结构信息的数据的更好方法,而注意力层是一种有助于从长数据或大数据中仅提取有用信息的机制。这两件事可以结合起来,我们可以称之为图注意力网络。

图注意网络也可以解释为利用图神经网络中的注意机制,以便我们可以解决图神经网络的一些缺点。让我们以图卷积网络为例,这些网络通常用于解决与数据中存在的顺序信息相关的问题。

这些图网络应用堆叠层,其中节点可以由相邻节点的特征组成。将注意力应用于这些节点会使整个网络为仅存在于邻居中的不同节点指定不同的权重。通过这种方法,我们使网络能够仅使用那些有用的节点信息。

这里最重要的一件事是了解邻居节点对结果的行为和重要性。这些方法可以应用于归纳和转换问题。我们也可以说,将注意力应用于图神经网络是推进它或使其变得更好的方法。让我们看看通过将注意力机制应用于图神经网络得到了哪些改进。

2、增加对 GNN 的关注的好处

以图卷积网络作为我们的 GNN 的示例。到目前为止,我们知道图神经网络擅长从图结构数据中对节点进行分类。在许多问题中,我们可能会发现一个缺点是,由于图结构信息的聚合,图卷积网络正在损害图结构数据的泛化性。将图注意力网络应用于这些问题会改变信息聚合的方式。

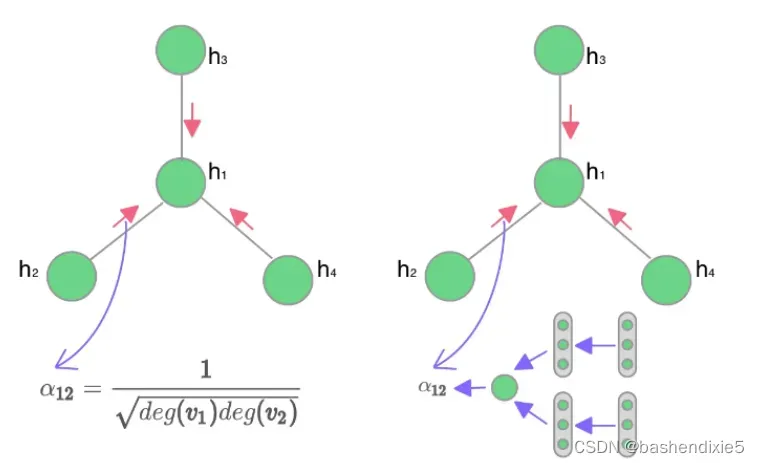

注意力可以提供静态归一化的卷积操作。下图是标准 GCN 和 GAT 之间差异的表示。

综上所述,我们可以说,通过对网络施加注意力,更重要的节点在邻域聚合过程中获得了更高的权重。

3、图注意力网络的架构

通常,我们发现这样的网络以堆叠的方式保持网络中的层。我们可以通过了解三个主要层的工作来了解网络的架构。

输入层:输入层可以这样设计,它由一组节点特征组成,并且应该能够产生一组新的节点特征作为输出。这些层还能够将输入节点特征转换为可学习的线性特征。

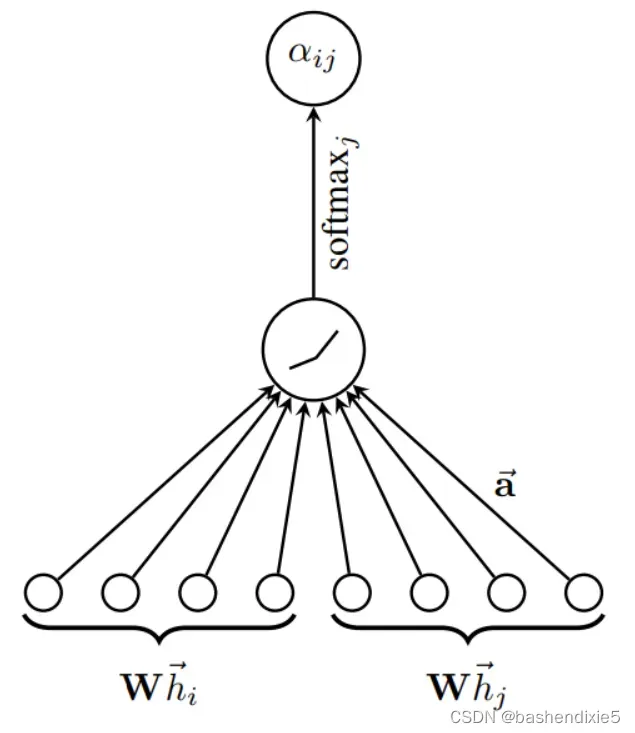

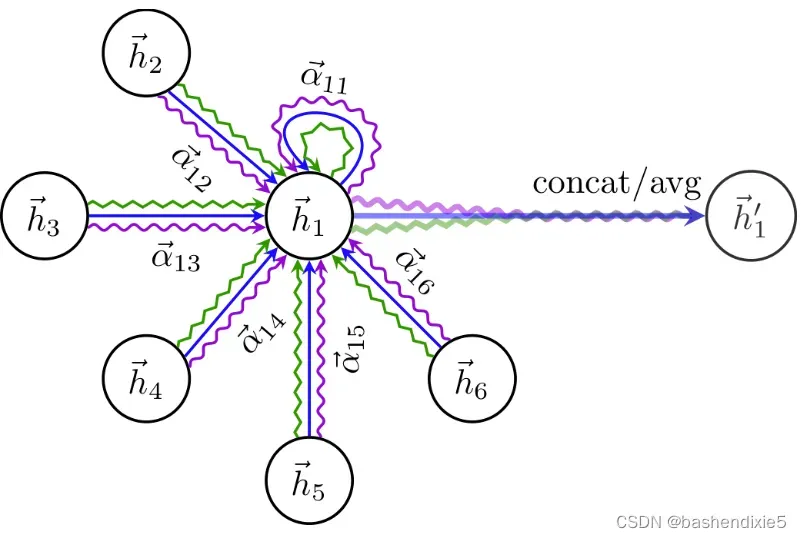

注意层:在转换特征后,可以在网络中应用注意层,其中注意层的工作可以通过使用权重矩阵的输入层的输出进行参数化。通过将此权重矩阵应用于每个节点,我们可以将自注意力应用于节点。机械地,我们可以暗示一个单层前馈神经网络作为我们的注意力层,它可以给我们一个归一化的注意力系数。

输出层:在获得归一化的注意力系数后,我们可以使用它们来计算与系数对应的特征集,并将它们作为来自网络的最终特征。为了稳定注意力的过程,我们可以使用多头注意力,以便可以应用各种独立的注意力来执行输出特征的转换和连接。

4、图注意力网络的优势

图注意力网络有如下优点:

由于我们在图结构中应用了注意力,我们可以说注意力机制可以以并行方式工作,这使得图注意力网络的计算非常高效。

将注意力应用于任何设置都会使模型的容量和准确性非常高,因为模型只需要学习重要的数据,或者我们可以说数据量更少。

如果注意力机制以共享的方式应用,那么图网络可以直接与归纳学习一起使用。

在应用注意力之后对学习的权重进行分析可以使网络的过程更具可解释性。

文章出处登录后可见!