人工智能的发展

神经网络:人脑智慧的物质基础。

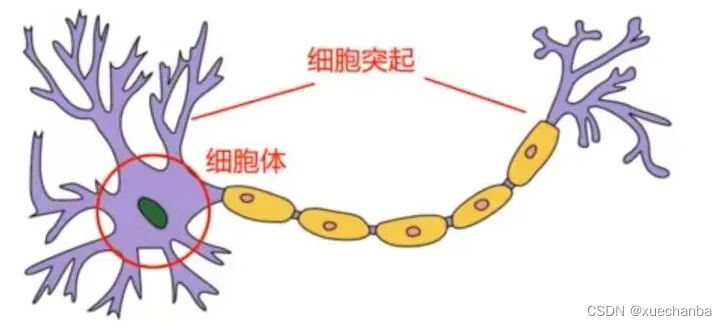

神经元/神经细胞:生物神经系统的基本单元。

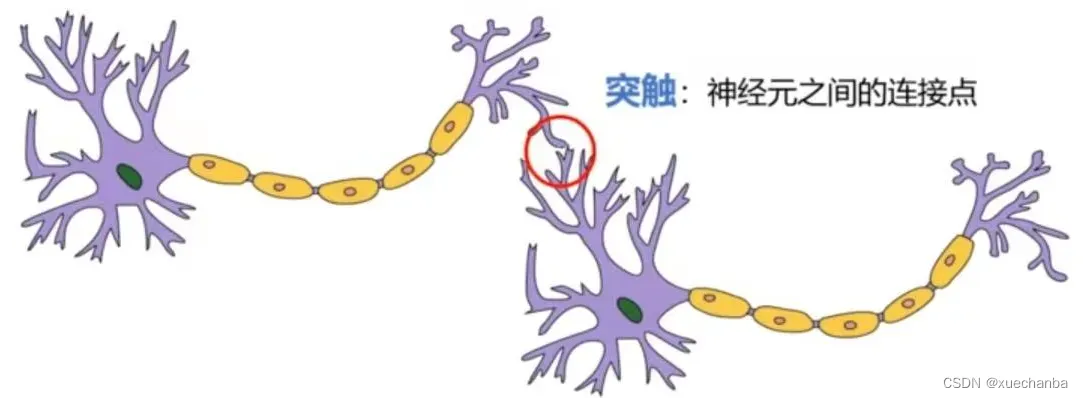

下图为典型的生物神经元:

生物神经元由细胞体和细胞突起组成,细胞突起是由细胞体延伸出来的细长部分,每个突起又会生出一些细分的触手,这些触手与其他神经元的触手相连接,形成神经网络。

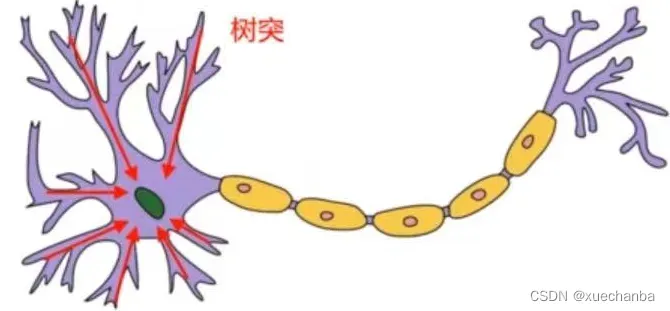

这些细胞突起又分为树突和轴突,树突是神经元的输入,

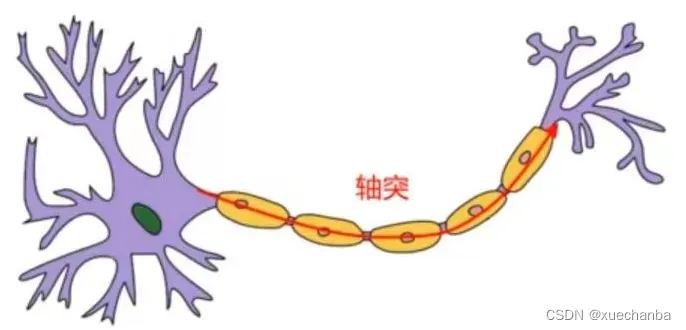

一个典型的椎体神经元有上千个树突,用来接收其他神经元传递过来的信号。轴突是神经元的输出,

每个神经元只有一个轴突,它的外面套有一层具有保护作用的鞘,轴突通常很长,可以延伸到全身的各个器官和组织中,轴突的末端是神经末梢。

树突和轴突之间的连接点称为突触。

通过突触,神经元就可以接收其他神经元传递过来的刺激并且发送信号给其他神经元。

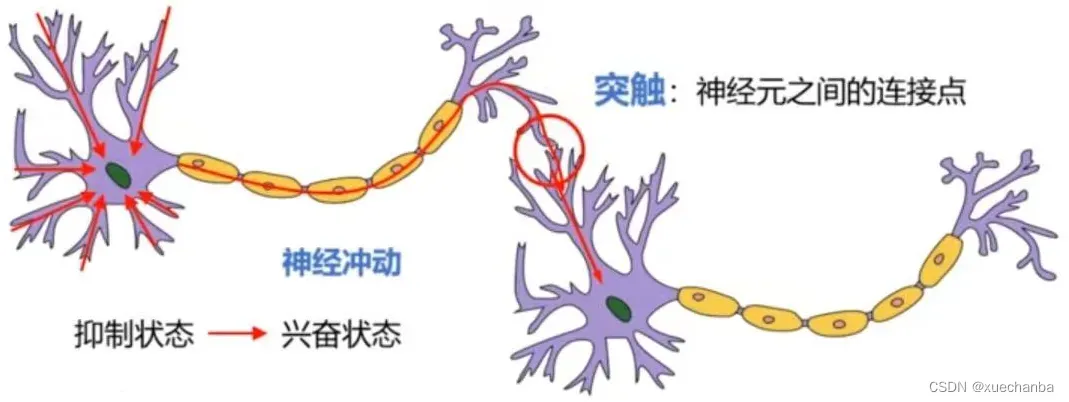

生物神经元有两种状态,兴奋和抑制。

当神经元处于抑制状态时,轴突并不向外输出信号,当树突中输入的刺激累计达到一定程度(超过一定阈值时),神经元就会从抑制状态转为兴奋状态。同时通过神经元向其他神经元发送信号。

这种能够传导的兴奋被称为神经冲动。

受到生物神经系统的启发,科学家们参考生物神经元的结构,提出了人造神经元模型。

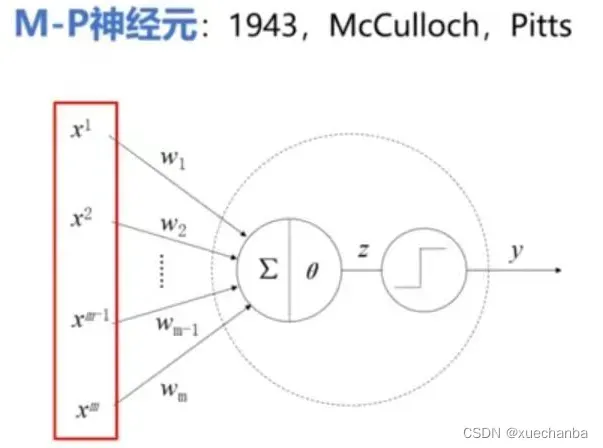

1、M-P神经元

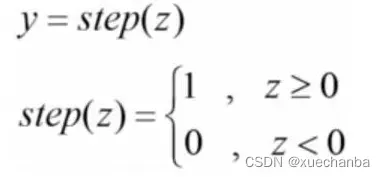

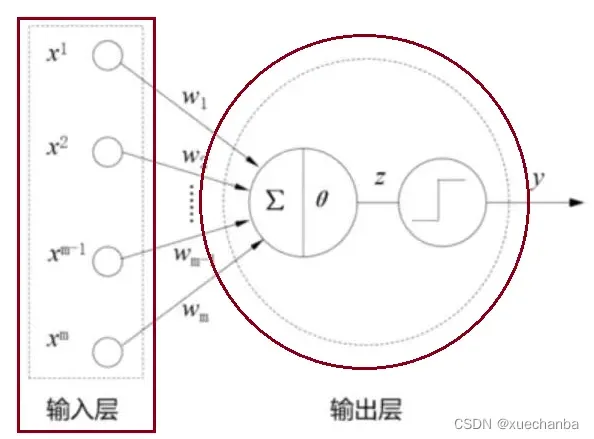

M-P神经元的输入信号用来模拟生物神经元的树突,接收来自其他神经元的信号(xm)。这些信号的来源不同,对神经元的影响也不同,因此给每个输入信号分配一个权重(wm),计算单元(图中的 ∑|θ 部分)模拟神经系统中的细胞核,对接收到信号进行加权求和 ∑ 之后,与产生神经兴奋的阈值θ 相比较,得到中间结果 z ,

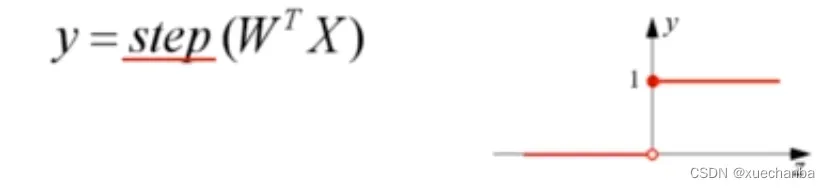

最后通过阶跃函数模拟神经兴奋,当 z 的值小于 0 时,神经元处于抑制状态,输出0, 而z 的值大于或等于 0 时,神经元处于兴奋状态,输出1。

这里的阶跃函数就被称为

![]()

输出 y 模拟生物神经元中的轴突,将神经元的输出信号传递给其他神经元。

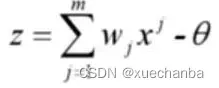

下图为 M-P 神经元完整的数学表达式:

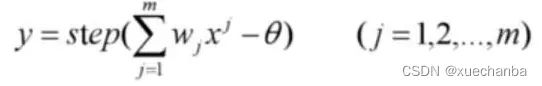

为了方便采用向量形式进行描述,

则上式可表示为:

![]()

或者表示为:

其中,W 和 X 都是 m+1 维的向量。

M-P神经元模拟了生物神经元,但是它的权值向量 W 无法自动学习和更新,不具备学习的能力。

2、神经心理学

在巴甫洛夫的实验中,

一定时间之后,只要响铃

狗就会流口水。

受到这个实验的启发,

![]()

这个人认为:

![]()

例如,铃声响起,有关听觉的神经元会被激发,在同一时间,食物的出现会激发与进食相关的神经元,随着反复的训练,这两种神经元间就会形成突触,并且不断强化,从而记住这两个神经元之间的联系。

相反,

![]()

例如,以后给狗喂食的时候都不再响铃了,那么狗听到铃声后,就不再会流口水了。

Hebb理论认为:神经细胞的突触上的连接强度是可以变化的,而大脑的学习过程,就是通过神经元之间突触的形成、连接和强度的变化来实现的。两个神经细胞交流越多,它们之间的连接就越强,即

受到Hebb理论的启发,一些计算科学家们就开始考虑,通过算法来调整神经元中的权值,从而模拟人类神经网络的学习能力。这就是今天人工神经网络的理论依据。

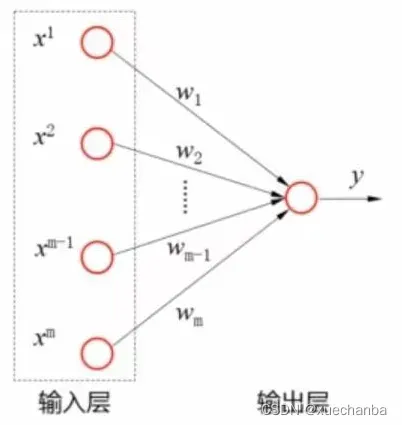

3、感知机

提出感知机模型,感知机有两层神经元组成。(注意看,和M-P神经元还是有一定区别的,比如感知机的输入层中有圆圈 ○)

输入层接收外界信号,输出层是 M-P 神经元,我们可以忽略掉 M-P神经元中的细节,把它简化成这种形式:

这里的每一个圆圈都表示一个神经元,也称为节点,输入层中并没有发生计算,因此通常不计入神经网络的层数。只有输出层这个神经元是发生计算的功能神经元。因此,感知机是一个单层神经网络。

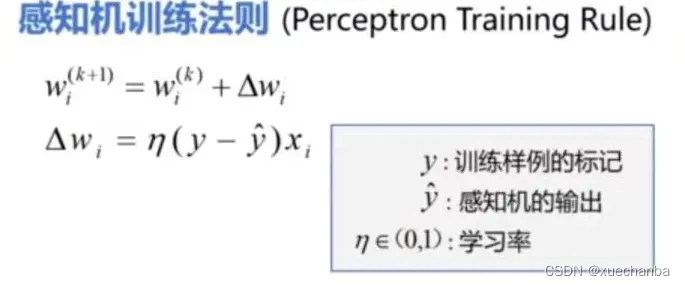

感知机的学习就是给定一个有标记的训练数据集,确定权值向量 W 的过程。

这个人给

出了一个感知机的训练法则。

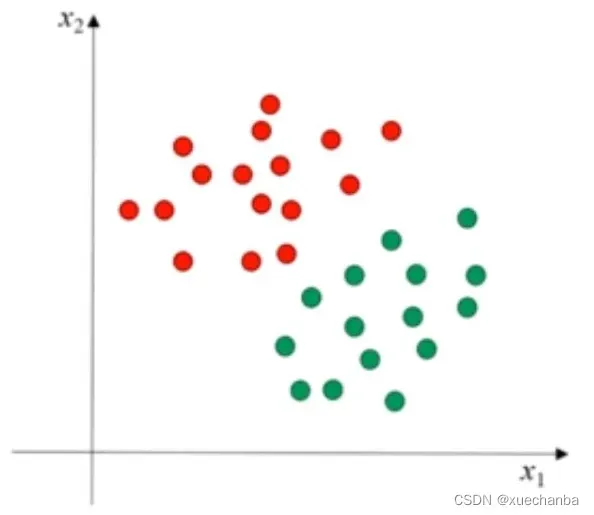

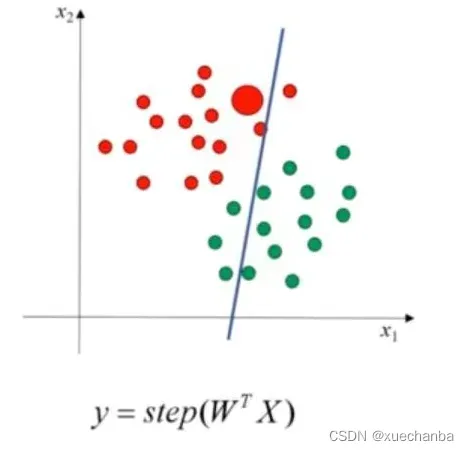

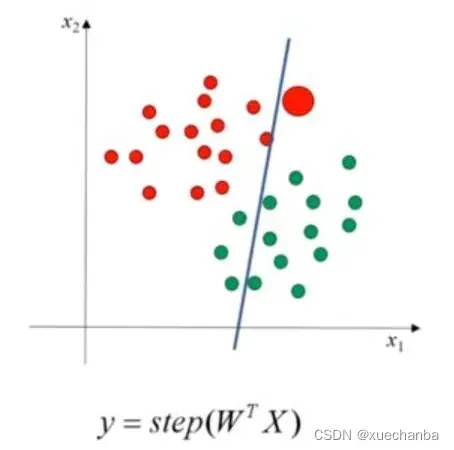

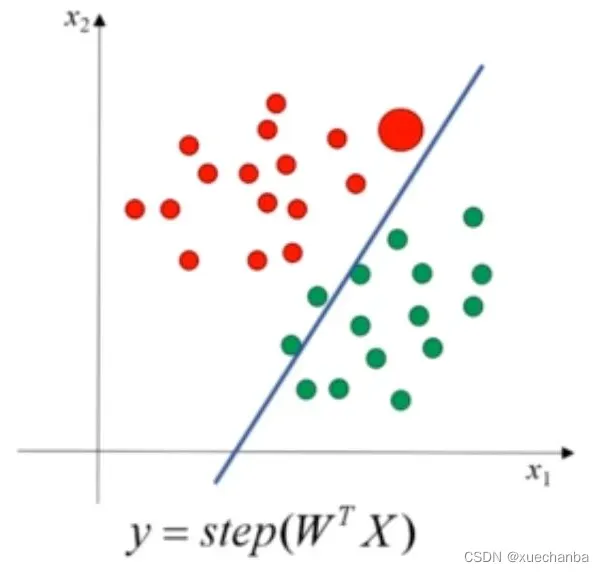

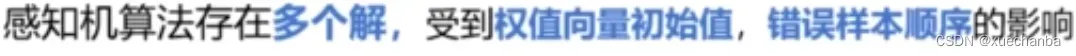

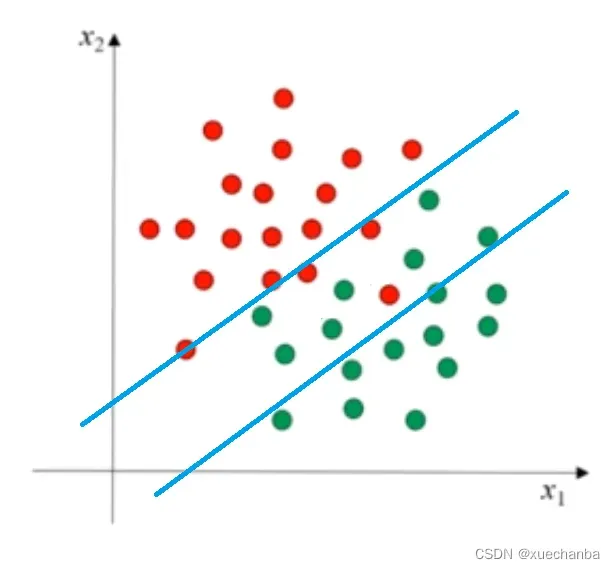

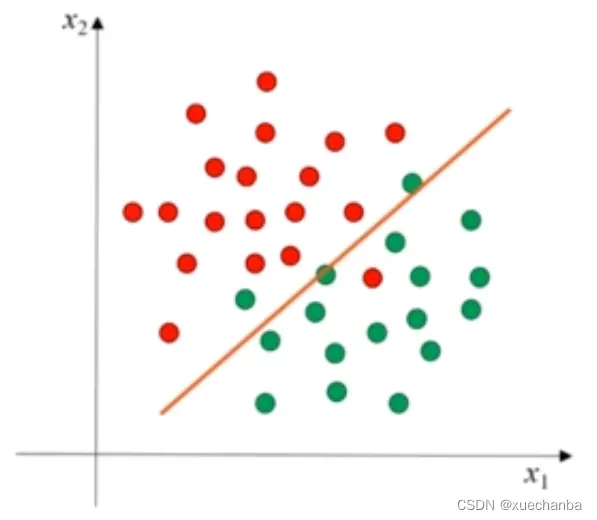

例如,下图为二维空间中的训练集:

其中,红色的点是正例,标记为1。而绿色的点则是负例,标记为0。

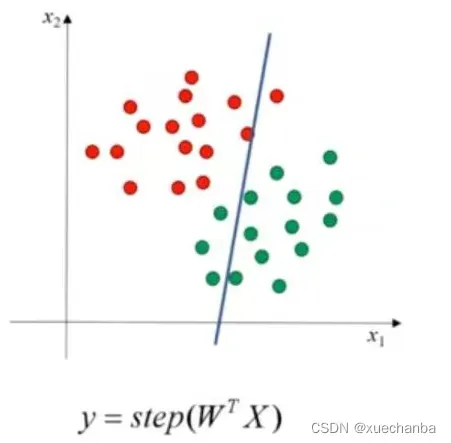

首先,随机设置一组权值作为初值,下图为它对应的分类直线:

然后,使用这个感知机,计算每个样本的估计值,例如,首先使用下图样本,

感知机的输出和样本标记相同,说明分类正确,直线不动,再去计算下一个样本,

这时,感知机的输出和样本标记不同,说明分类错误,就使用感知机训练法则去调整权值,让分类直线尽量靠进这个样本,最好能够跨过这个样本。

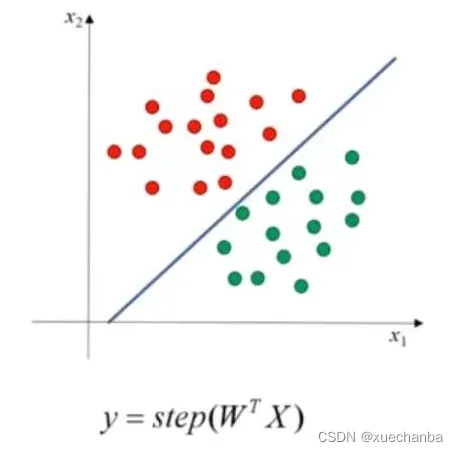

不断重复上述过程,最终,

使用感知机训练法则,能够根据训练过样本的标签值和感知机输出之间的误差来自动的调整权值,这就具备了学习的能力。

感知机是

![]()

它实现了一个二分类的线性分类器,在二维、三维及 m 维空间中,分类决策边界分别对应一条直线、一个平面和一个超平面。

此外,

当训练样本为非线性可分的数据集时,

迭代结果会一直震荡,为了克服感知机训练法则对非线性可分的数据集无法收敛的问题,科学家们又提出了 Delta 法则,

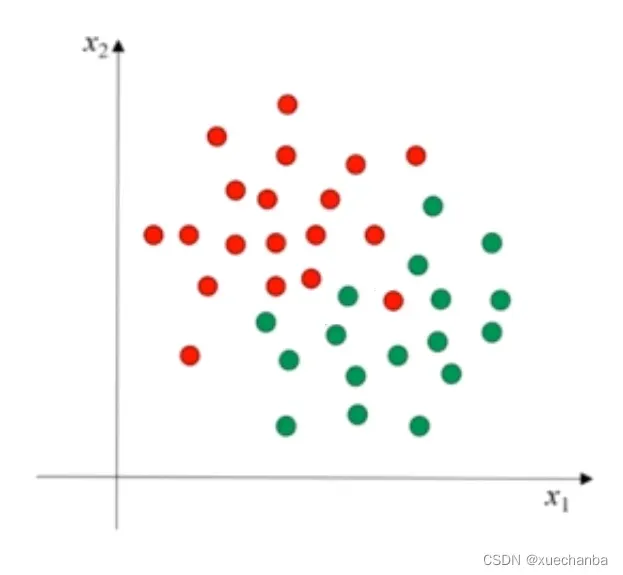

例如下图,

这两个类样本点是线性不可分的,无法找到一条直线把它们完全分开,使用感知机训练法则,这条线就会一直在这两条线之间跳来跳去,

无法收敛。而使用梯度下降法,可以收敛于一条直线。

从而把这两类点尽可能的分开,使错分的点尽可能的少。

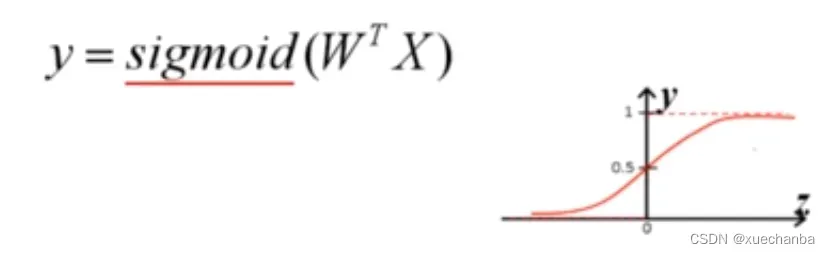

另外,因为阶跃函数具有不连续、转折点不可导、不光滑等不太好的性质,

实际中,经常使用

作为激活函数。

可以发现,上述内容其实就是前面所介绍的逻辑回归,实际上,逻辑回归可以看做是一个最简单的单层神经网络,单个感知机只有一个输出结点,只能够实现二分类的问题。

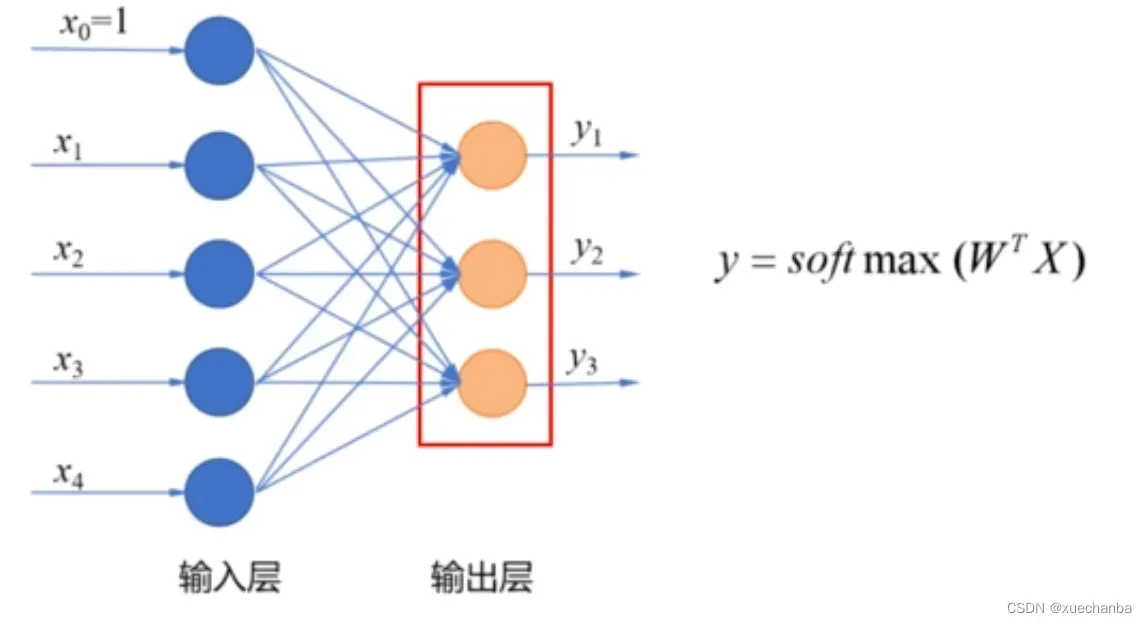

如果要实现多分类问题,就需要在输出层设置多个结点,例如:鸢尾花分类,可以在输出层设置三个结点,分别对应三种不同的鸢尾花品种。

在输出层使用

作为激活函数,得到属于不同品种的概率,可以发现这就是前面所介绍的softmax 回归,在这个网络中,也是只有输出层有计算能力的功能神经元,因此,它也是一个单层神经网络。

文章出处登录后可见!