目录

基本概念

激活函数:解决线性模型表达能力不足的缺陷。(神经元是线性函数,无论怎样复合结果还是线性的)

Softmax:用于分类问题作为神经网络的最后一层,是一种激活函数,将一个数值向量归一化为一个概率分布向量,且各个概率之和为1。

![]()

全连接:n-1层的任意一个节点,都和第n层所有节点有连接。

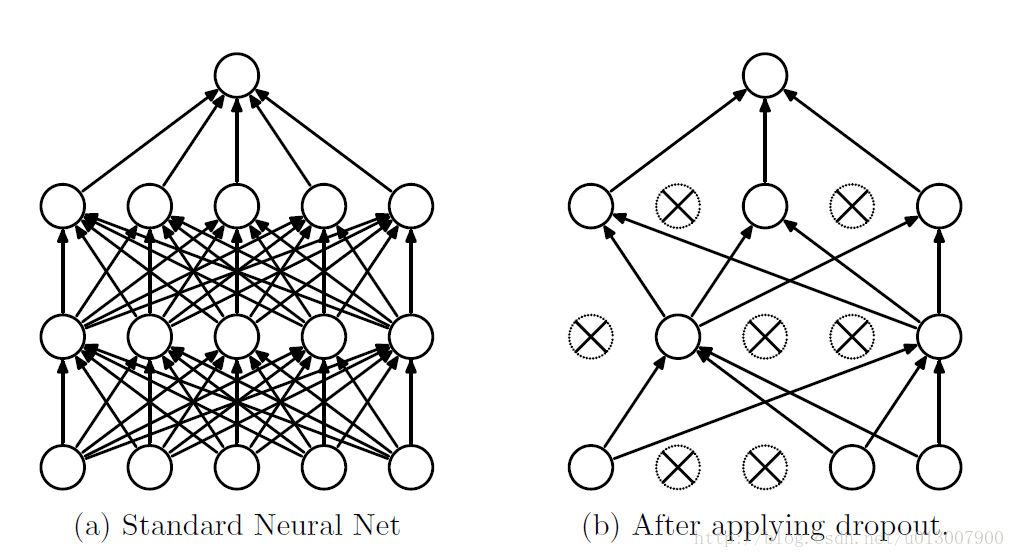

Drop-out:网络训练过程中,按照一定的概率将神经网络单元暂时从网络中丢弃。(随机杀死一些神经元;注意是暂时,对于随机梯度下降来说,由于是随机丢弃,故而每一个mini-batch都在训练不同的网络)

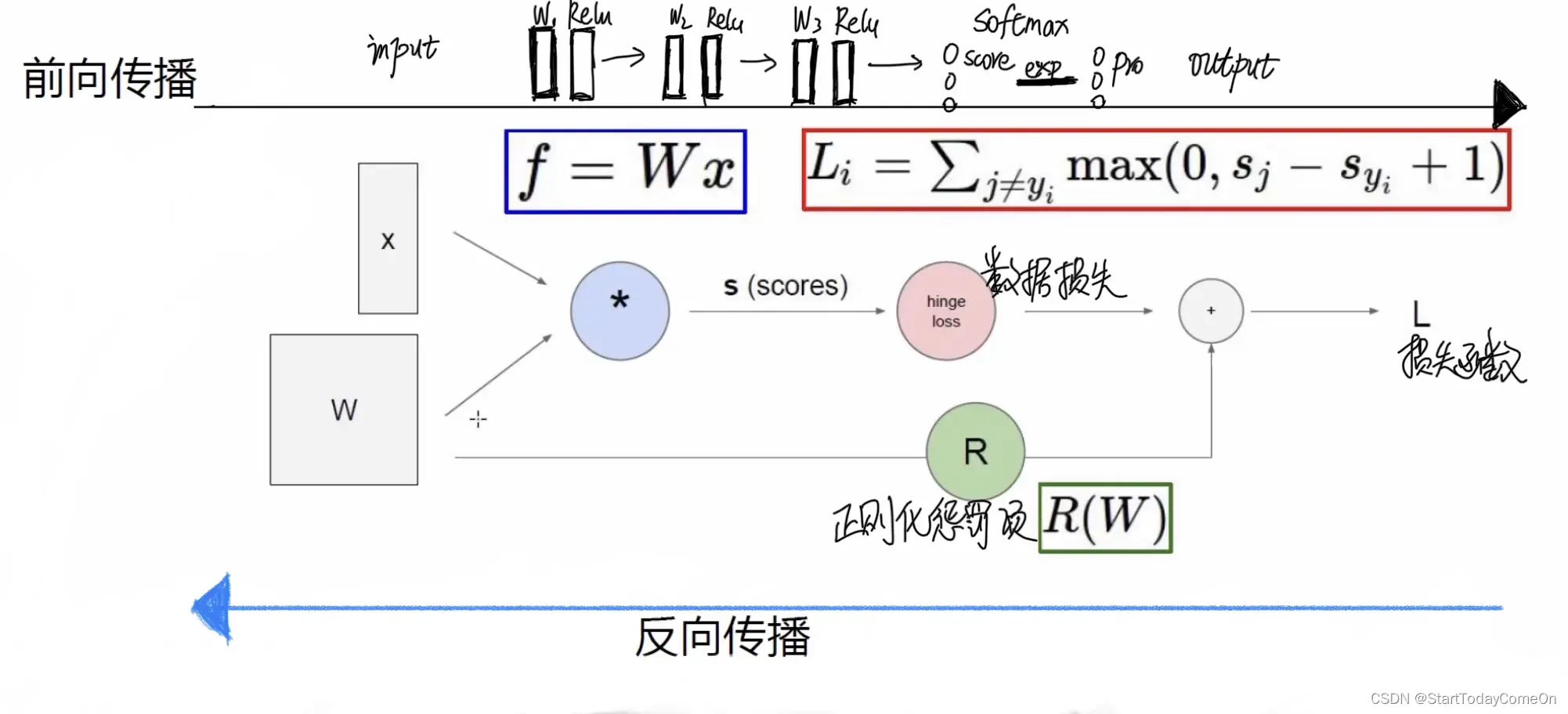

损失函数:用来衡量真实值 y和预测值 f(x)之间不一致的程度。损失函数=数据损失+正则化惩罚项

正则化惩罚项:

把整个模型中的所有权重w的绝对值加起来除以样本数量,λ表示对惩罚的重视程度。

惩罚系数λ=0.001伸出的爪子本质就是过拟合了(由于惩罚的程度不够),λ=0.1泛化能力强。

前向传播:信息从上一个神经元直接流转到下一个神经元,直到输出,依据每一个神经元的输入并根据相应规则可以计算出输出,最终得到在当前参数下的损失函数的过程。

反向传播:从神经网络的输出层向输入层依次计算损失函数对于各个参数的梯度,并在给定学习率下更新相关参数。

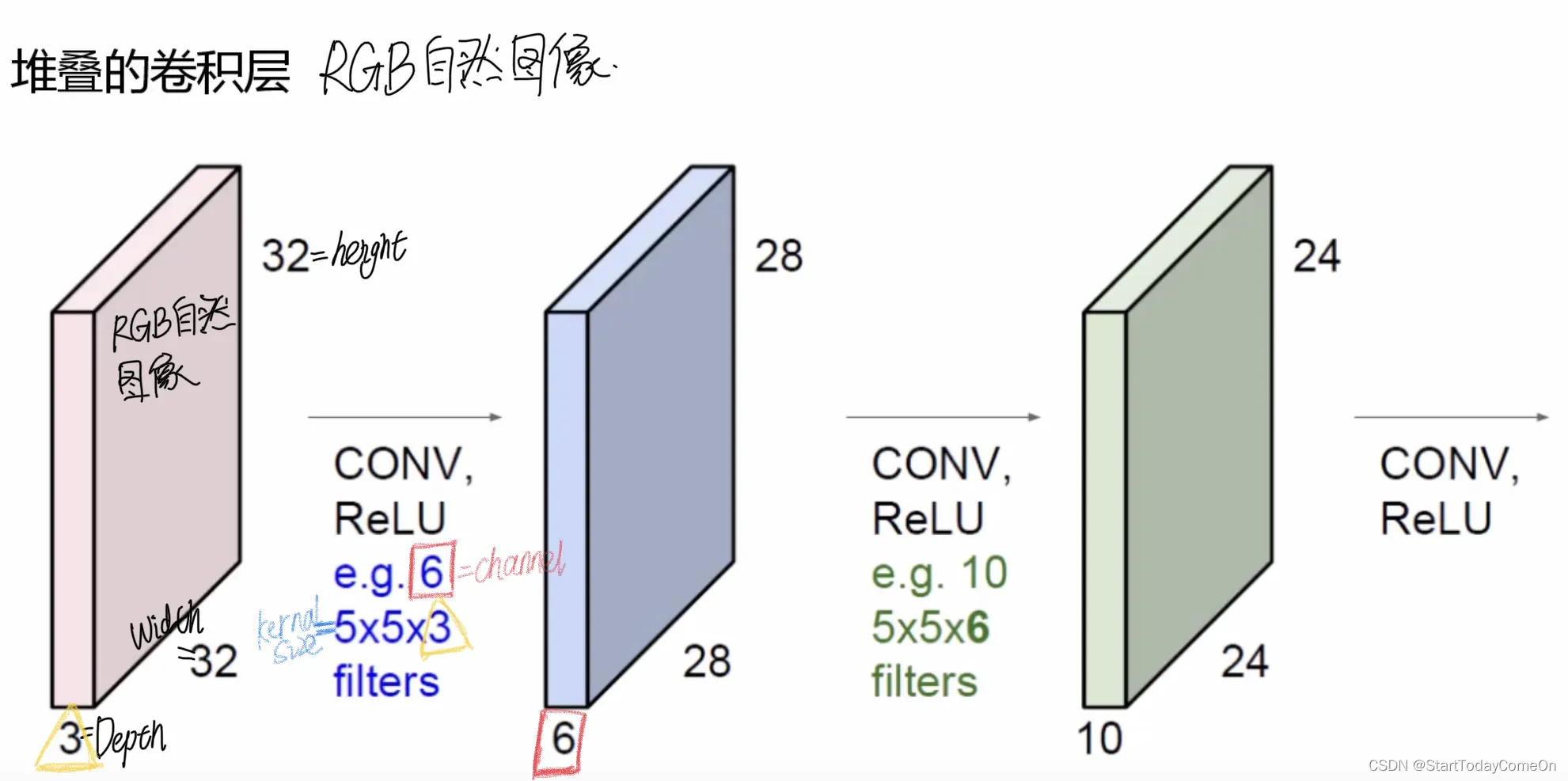

神经网络相关概念

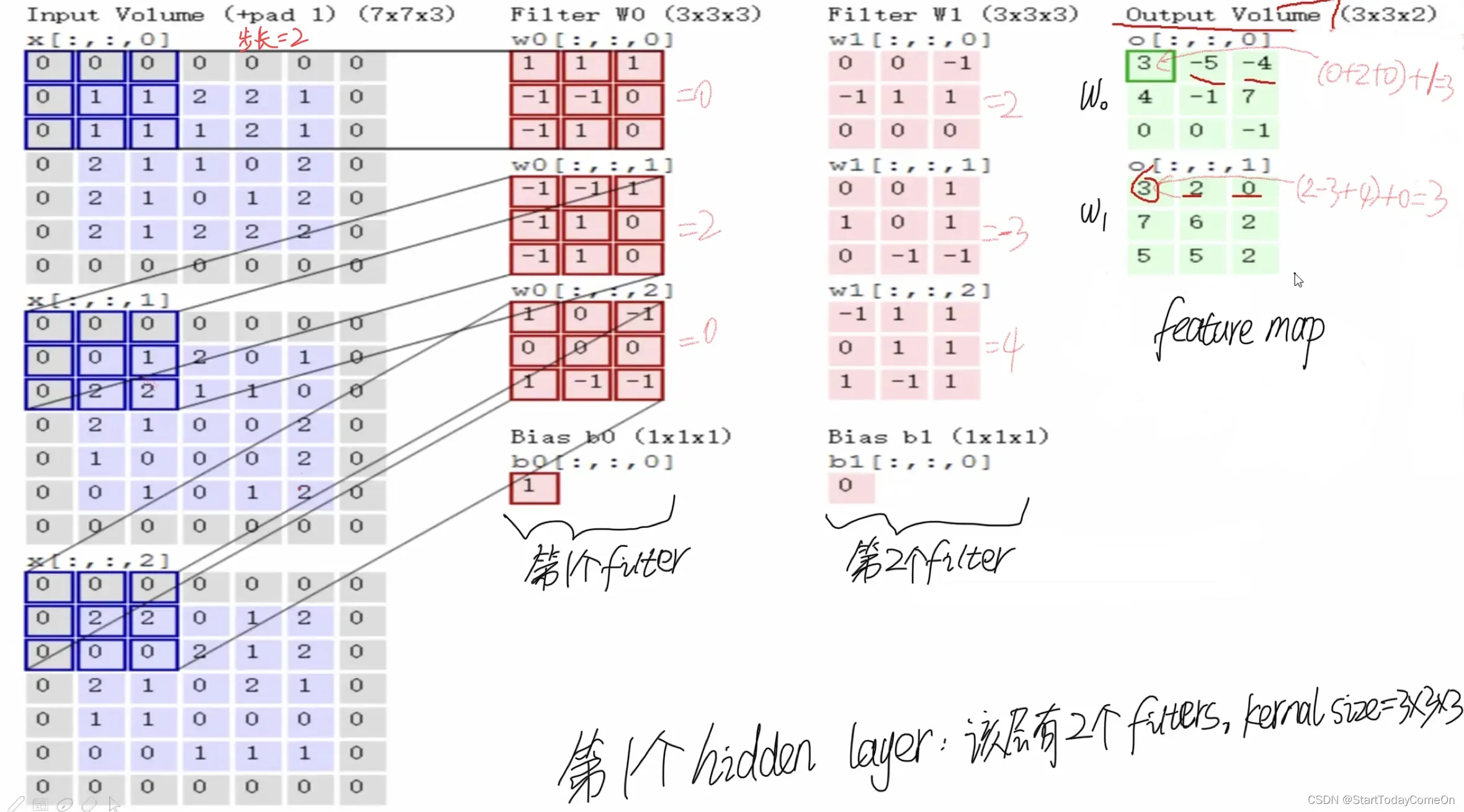

输入层;卷积层(滑动窗口步长、卷积核尺寸、边缘填充、卷积核个数);池化层;全连接层。

感受野:感受原始区域的大小。3个3×3的Conv VS 1个7×7,感受野都是7×7的大小

参数量更少:3*C*(3*3*C)=27C² VS 1*C*(7*7*C)=49C²,而且非线性特征更多:3个Relu VS 1个Relu.

方法可选项

1. 正则化惩罚项 L1 L2

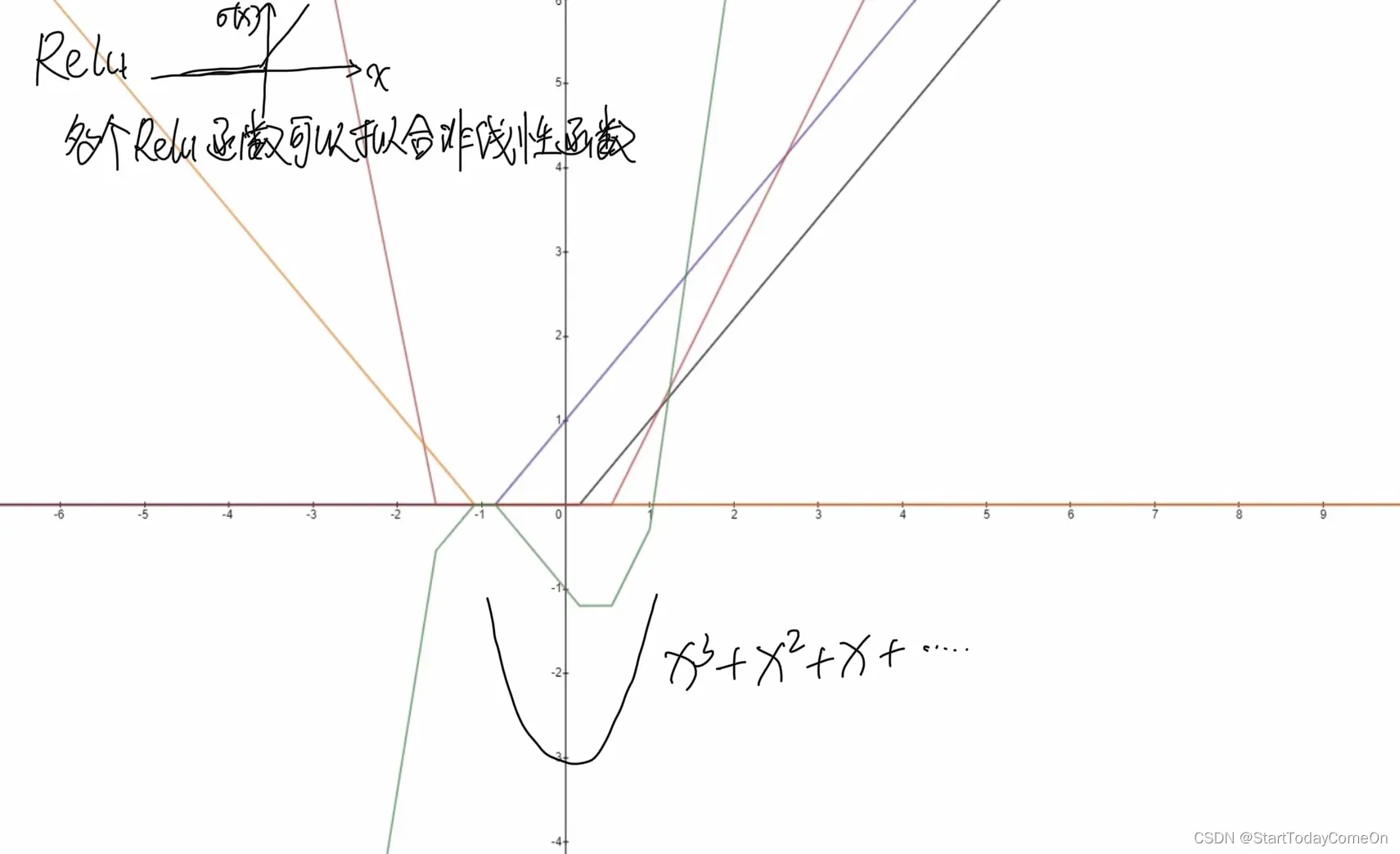

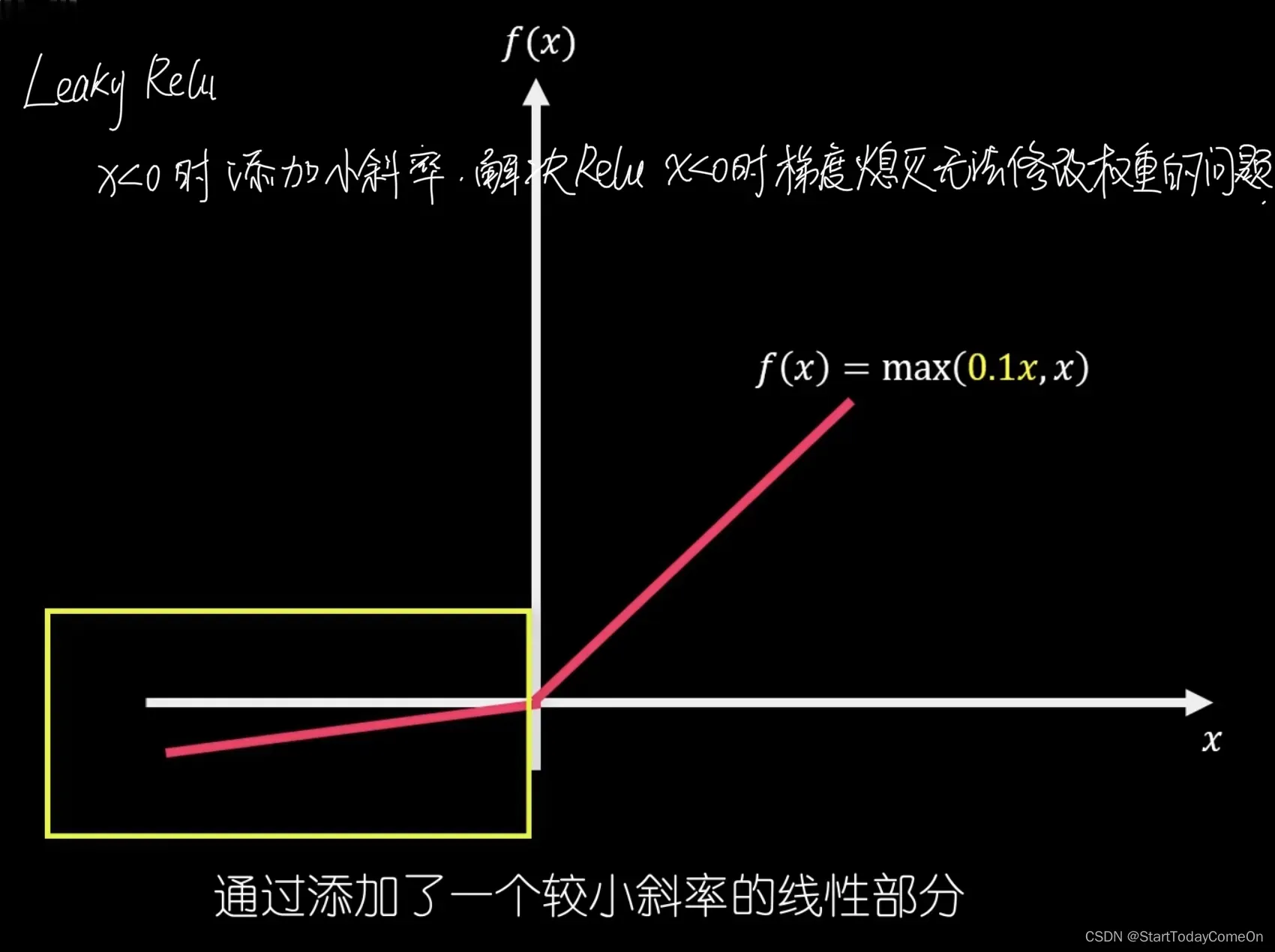

2. 激活函数:Sigmoid << Tanh << Relu << Leaky Relu

激活函数是解决神经元只有的线性性质(一次幂)的问题,加入激活函数后具有非线性性质,可以表示任意函数(多次幂)。

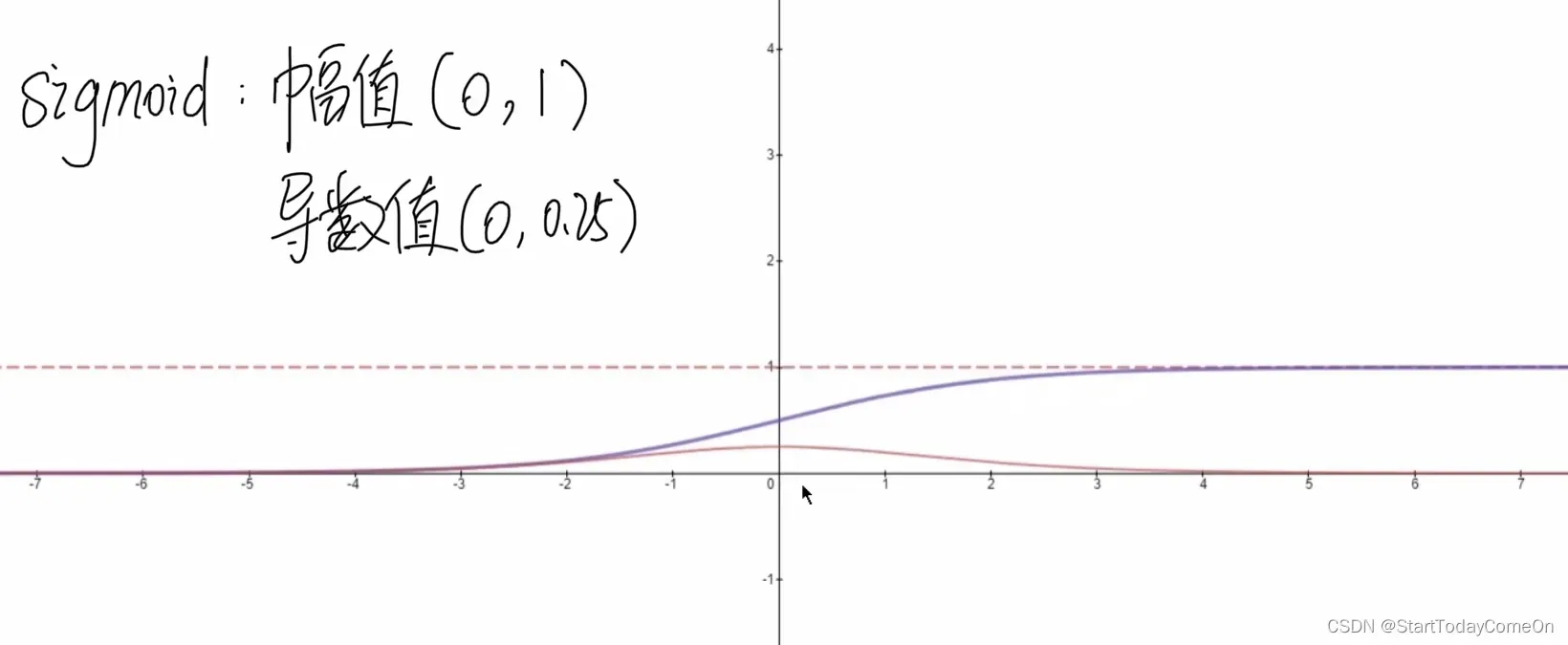

因为不同的激活函数,自身的求导存在导数太小的问题(Sigmoid导数范围0到0.25),当乘以的次数较多时,该值很小,会导致梯度消失。

![]()

![]()

![]()

![]()

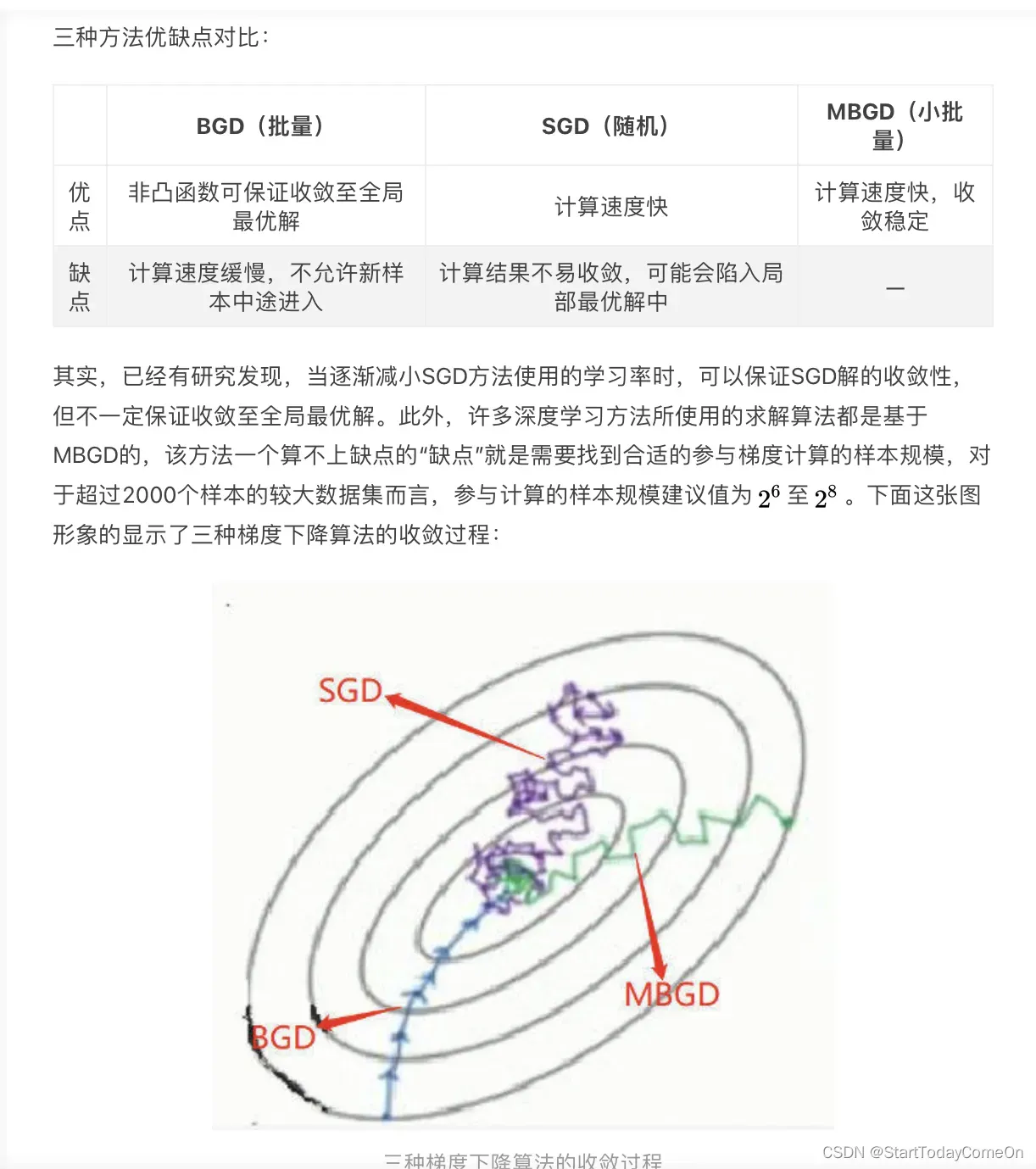

3. 梯度下降法:BGD(批量)、SGD(随机)、MBGD(小批量)

批量梯度下降法(Batch Gradient Descent, BGD)、小批量梯度下降法(Mini-batch Gradient Descent, MBGD)以及随机梯度下降法(Stochastic Gradient Descent, SGD)。

4 损失函数

| 分割 |

| 分类 |

| 检测 |

| 重建 |

经典卷积神经网络

1. Alexnet (2012年夺冠,近代开篇之作),问题很大,目前不用

2. Vgg (2014年),性能优于Alexnet,但训练时间远长于Alexnet (3 days >> 8 hours),目前可用

3. Resnet (2015年,解决层数越多性能越差的问题,加入残差结构,把CNN救活),目前首选,可以用于提取feature map,用相应loss 做不同任务,分类检测等。

![]()

![]()

![]()

补充:残差结构,解决层数越多性能越差的问题,差的卷积层置0 (网络自己学的),上一层输入“保底”,使网络至少不会变差。

![]()

常见的神经网络算法

1. CNN 卷积神经网络:

2. RNN 递归神经网络:考虑时间的相关性,对结果产生影响

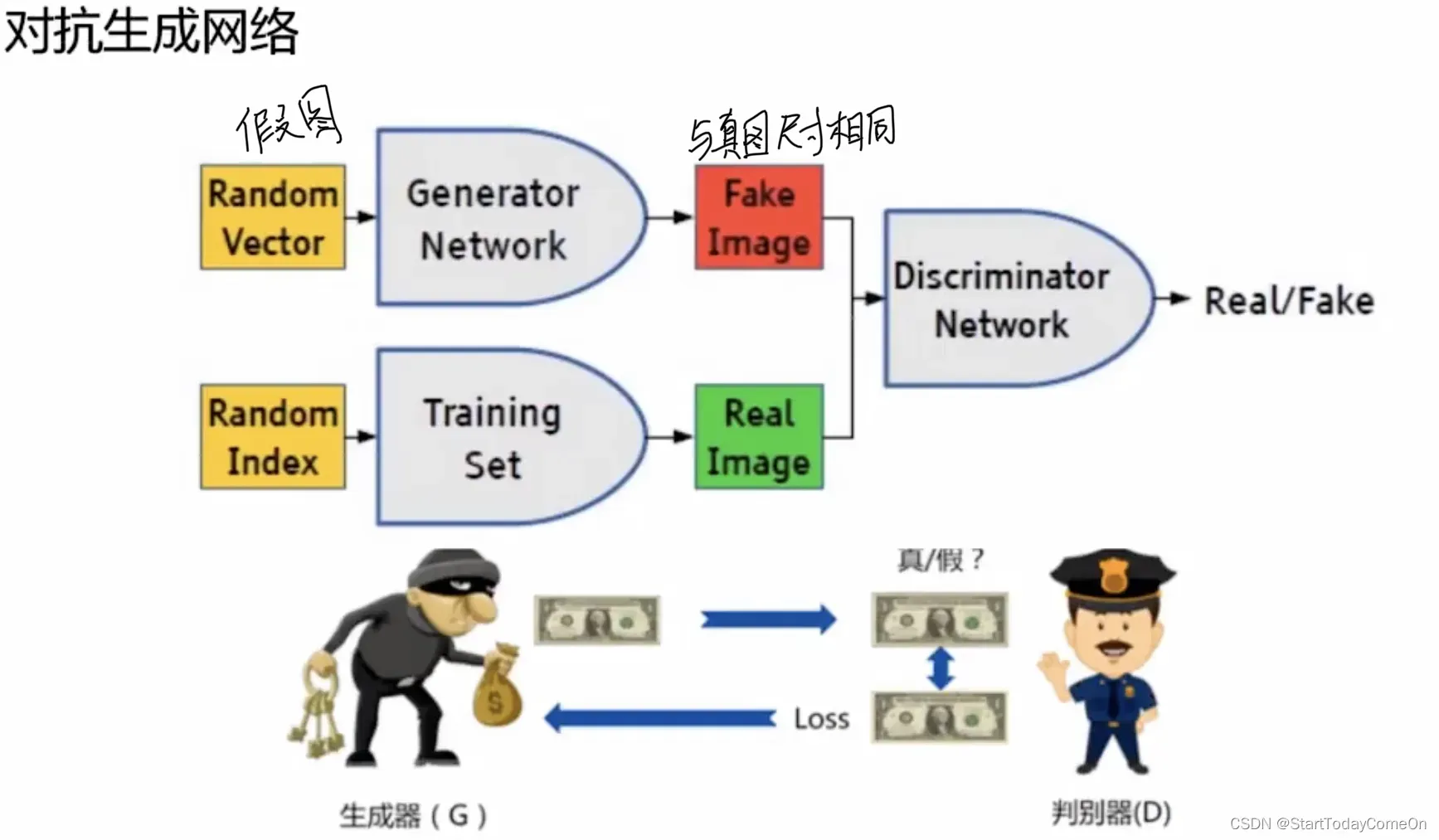

3. GAN 对抗生成网络:一张图像转化为另一种风格的图像;超分辨率重构。G生成的假币越真越好,直到骗过银行。D把假币分辨出来。

![]()

实操pytorch

很多截图来自“***”课件

文章出处登录后可见!