论文信息

论文标题:Deep Graph Clustering via Dual Correlation Reduction

论文作者:Yue Liu, Wenxuan Tu, Sihang Zhou, Xinwang Liu, Linxuan Song, Xihong Yang, En Zhu

论文来源: 2021,arXiv

论文地址:download

论文代码:DCRN,deep graph clustering

一、Introduction

现有的基于GCN的聚类算法在样本编码过程中通常存在表示崩溃问题,并且倾向于将不同类别的节点映射到相似的表示中。因此,节点表示不区分,聚类性能有限。

为了解决这个问题,我们提出了一种新的自监督深度图聚类方法,称为双重相关约简网络(DCRN),通过双重方式降低信息的相关性来避免表示崩溃。

二、Dual Correlation Reduction Network

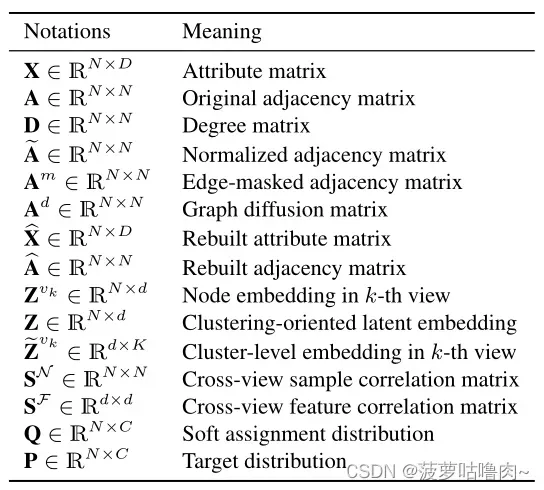

(一)符号汇总表

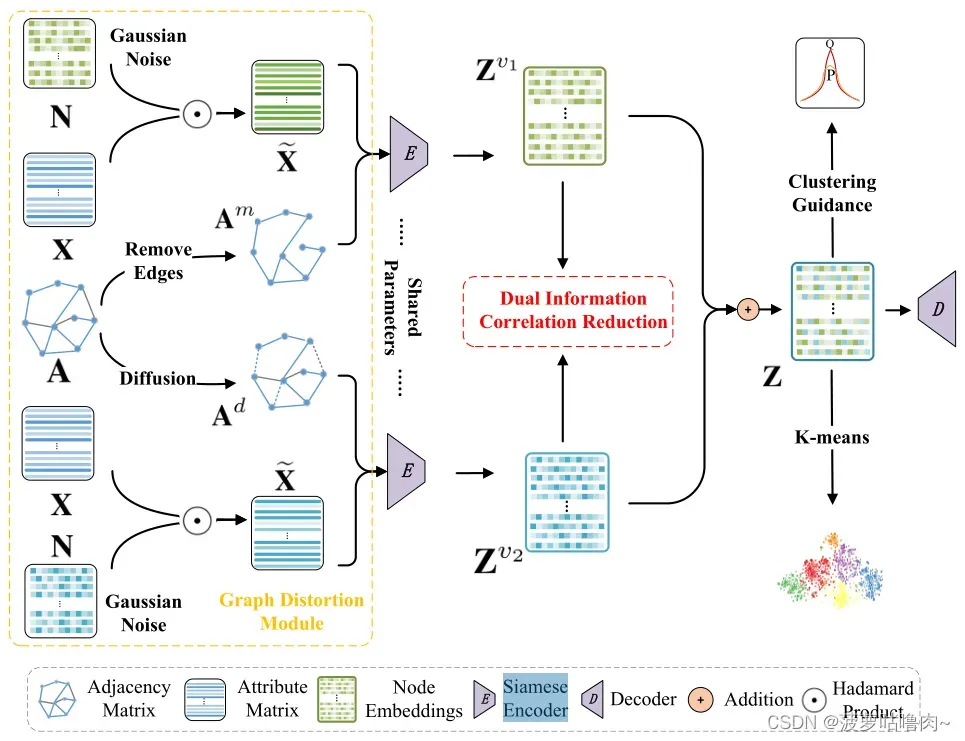

(二)整体框架

1.Graph Distortion Module

图失真可以使网络从节点的不同上下文中学习丰富的表示。

(1)Feature Corruption(属性级失真)

对于属性级失真,我们首先从高斯分布中采样一个随机噪声矩阵

,然后,生成的损坏属性矩阵

可公式化:

是Hadamard product。

(2)Edge Perturbation(边扰动)

除了破坏节点特征外,对于结构级失真,我们还引入了两种边扰动策略。一种是基于相似度的边去除,另一种是图扩散。

①基于相似度的边去除

首先计算潜在空间中样本对的余弦相似度,然后根据相似度矩阵生成一个屏蔽矩阵,其中最低的10%的连接关系将被手动删除。最后,边缘屏蔽邻接矩阵

被归一化,并计算为:

②图扩散

通过个性化网页排名(PPR)将归一化的邻接矩阵转化为图的扩散矩阵 。

其中是设定为0.2的远程传输概率。

最后,我们将

和

分别表示为图的两个视图。

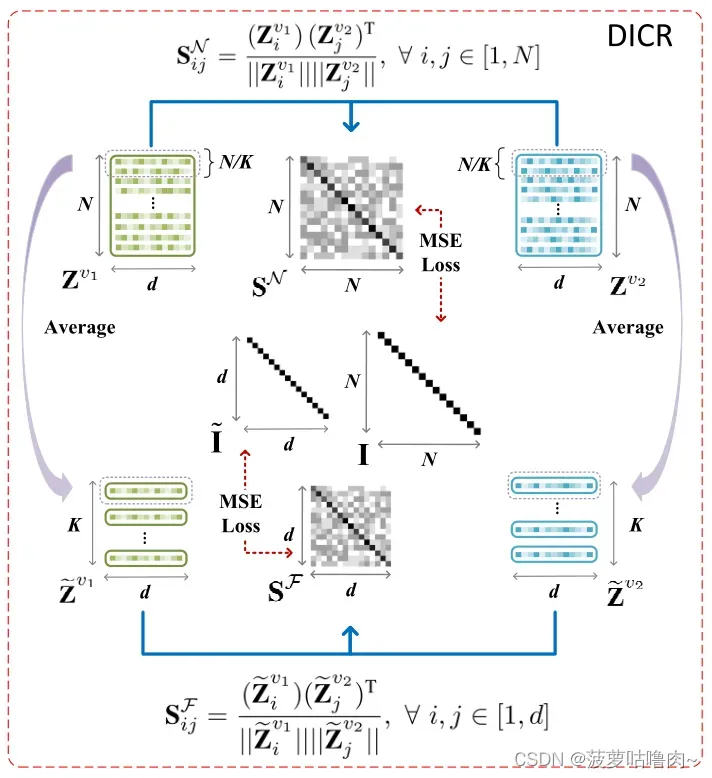

2.Dual Information Correlation Reduction(DICR)

引入了一种双重信息相关约简(DICR)机制,以双重方式过滤潜在嵌入的冗余信息,即样本级相关性降低(SCR) 和特征级相关性降低(FCR),旨在约束我们的网络学习更多有区别的潜在特征,从而缓解表示崩溃。

所提出的DICR机制从样本和特征两个角度考虑了相关性降低。这样,可以过滤冗余特征,同时在潜在空间中保留更多区分性特征,从而使网络能够学习有意义的表示,避免崩溃,从而提高聚类性能。

(1)样本级相关性降低(Sample-level Correlation Reduction,SCR)

SCR的学习过程包括两个步骤。对于给定的由siamese graph encoder(孪生编码器)学习的两视图节点嵌入和

,我们首先计算互视图样本相关矩阵

中的元素:

表示第一视图中嵌入的第i个节点与第二视图中嵌入的第j个节点之间的余弦相似性。

然后,我们使互视图样本相关矩阵逼近单位矩阵

,公式如下:

其中,第一项鼓励中的对角线元素等于1,这表明每个节点在两个不同视图中的嵌入都被强制要求相互一致。第二项使

中的非对角线元素等于0,以最小化两个视图中不同节点的嵌入之间的一致性。这种去相关操作可以帮助我们的网络减少潜在空间中的节点之间的冗余信息,从而使学习到的嵌入更具有辨别力。

(2)特征级相关性降低(Feature-level Correlation Reduction,FCR)

特征级相关性减少设计分三步实现:

第一步,我们使用读出函数将两个视图节点嵌入

和

投影到聚类级嵌入

和

中,公式如下:

第二步,再次计算余弦相似度:

表示一个视图中第i维特征与另一个视图中第j维特征之间的特征相似性。

第三步,我们使互视图特征相关矩阵等于单位矩阵

,公式如下:

其中d是潜在嵌入维数。公式中的这两项意味着在两个增强的视图中,相同维度特征的表示被拉近,而其他的则被推远。

最后,我们将两个视图中的解相关潜在嵌入与线性组合操作相结合,从而得到面向聚类的潜在嵌入

然后可以通过K-均值进行聚类。

(3)传播正则化

为了缓解网络训练期间的过度平滑现象,我们引入了一种传播正则化,公式如下:

其中指的是Jensen-Shannon散度,通过公式网络能够以浅层网络结构捕捉长距离信息,以缓解整个框架内传播的信息深入时的过度平滑。

综上所述,DICR模块的目标可以通过以下方式计算出来:

其中γ是一个平衡超参数。

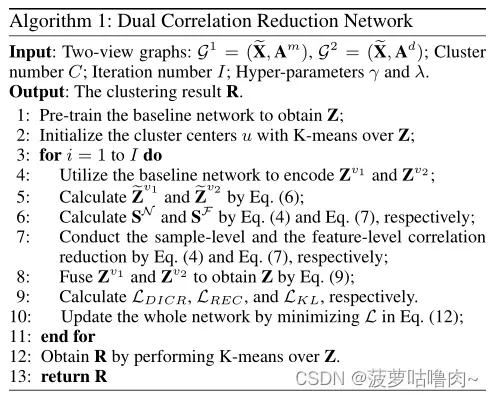

(三)伪代码

三、目标函数

所提方法的总体优化目标包括三部分:所提DICR的损失、重建损失和聚类损失:

文章出处登录后可见!