0、引子:

多分类loss采用的是softmax loss,也可称之为softmax交叉熵loss,这个loss中的q就使用的是模型的softmax输出,它就是用来拟合真正的§编码长度的期望

交叉熵越低,这个策略就越好,最低的交叉熵也就是使用了真实分布所计算出来的信息熵,因为此时 ,交叉熵 = 信息熵。这也是为什么在机器学习中的分类算法中,我们总是最小化交叉熵,因为交叉熵越低,就证明由算法所产生的策略最接近最优策略,也间接证明我们算法所算出的非真实分布越接近真实分布。

参见:https://www.cnblogs.com/smartwhite/p/8601477.html

1、为什么在机器学习中的分类算法中,我们总是最小化交叉熵?

交叉熵,见:https://blog.csdn.net/u010212101/article/details/125040853

softmax如下:

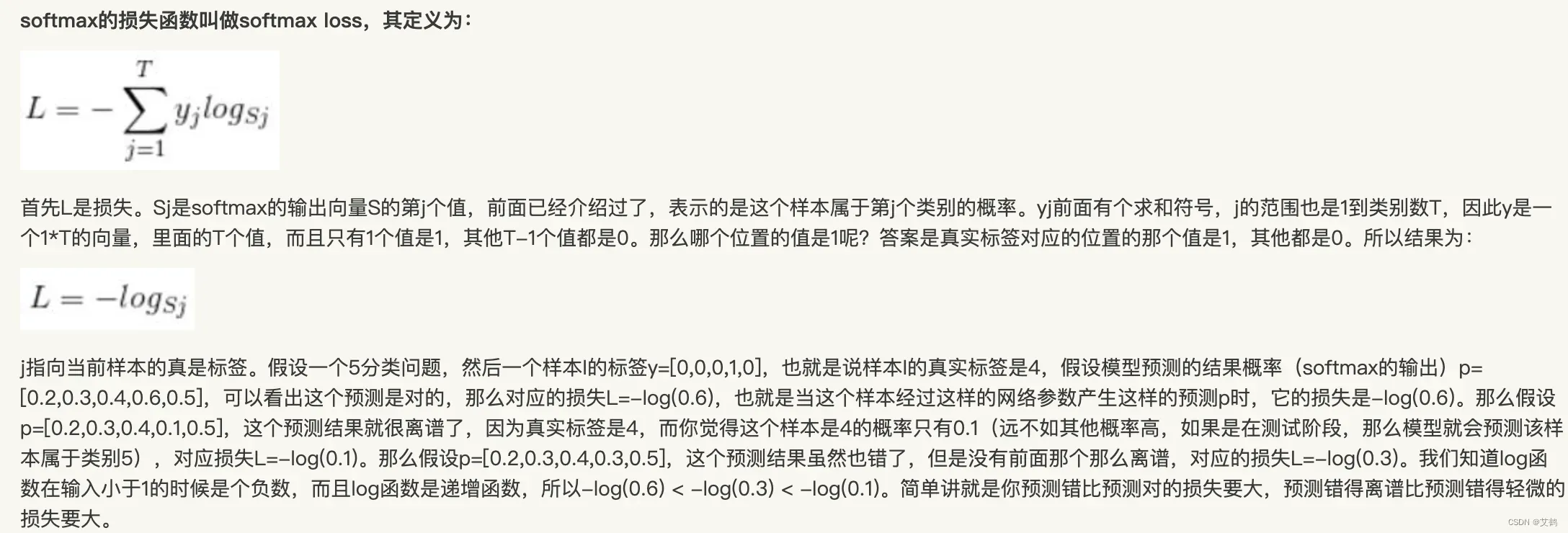

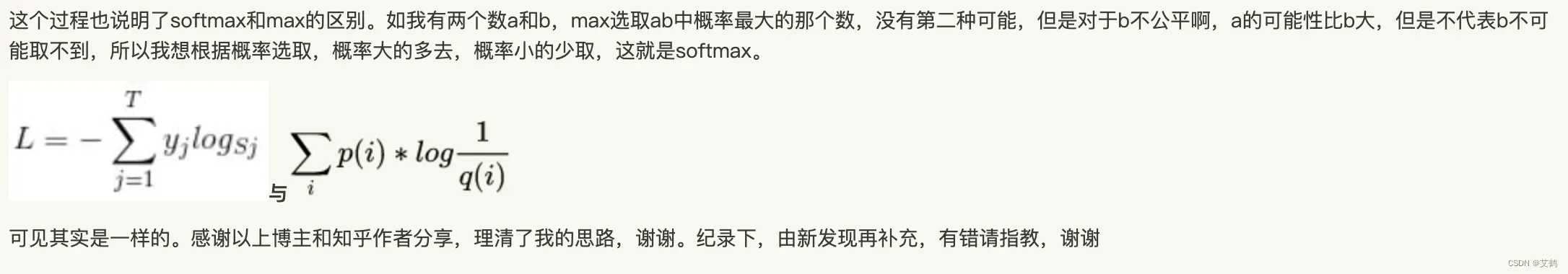

2、softmax loss

3、max vs. softmax

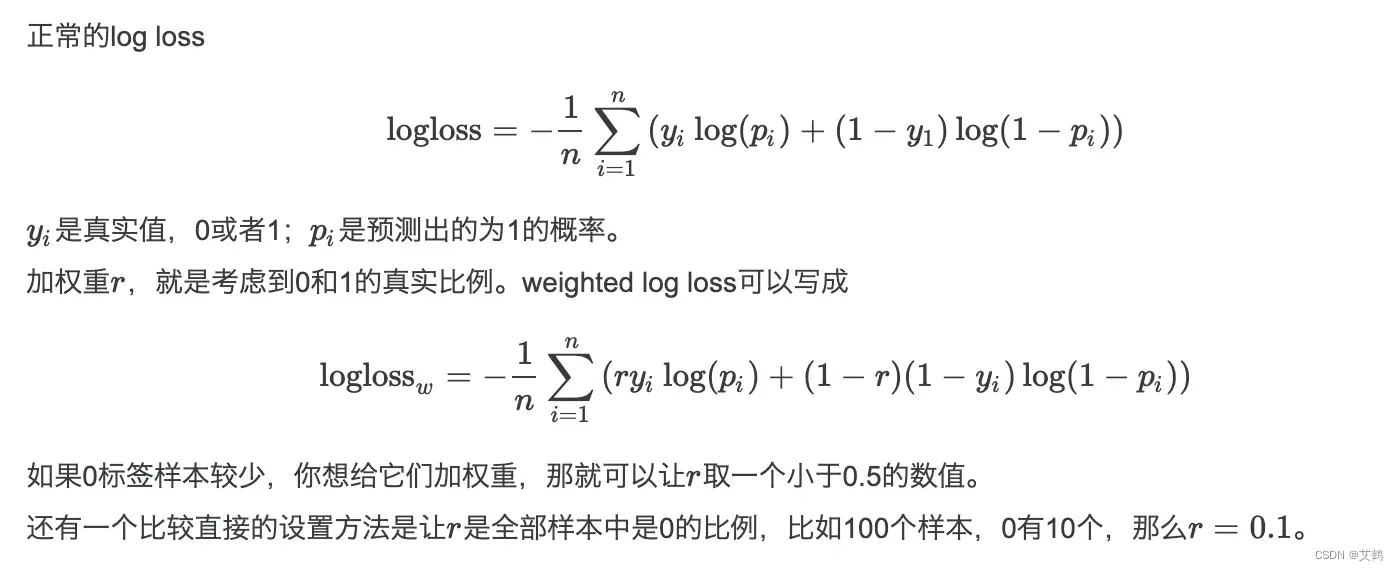

4.weighted loss

参见:http://sofasofa.io/forum_main_post.php?postid=1002038

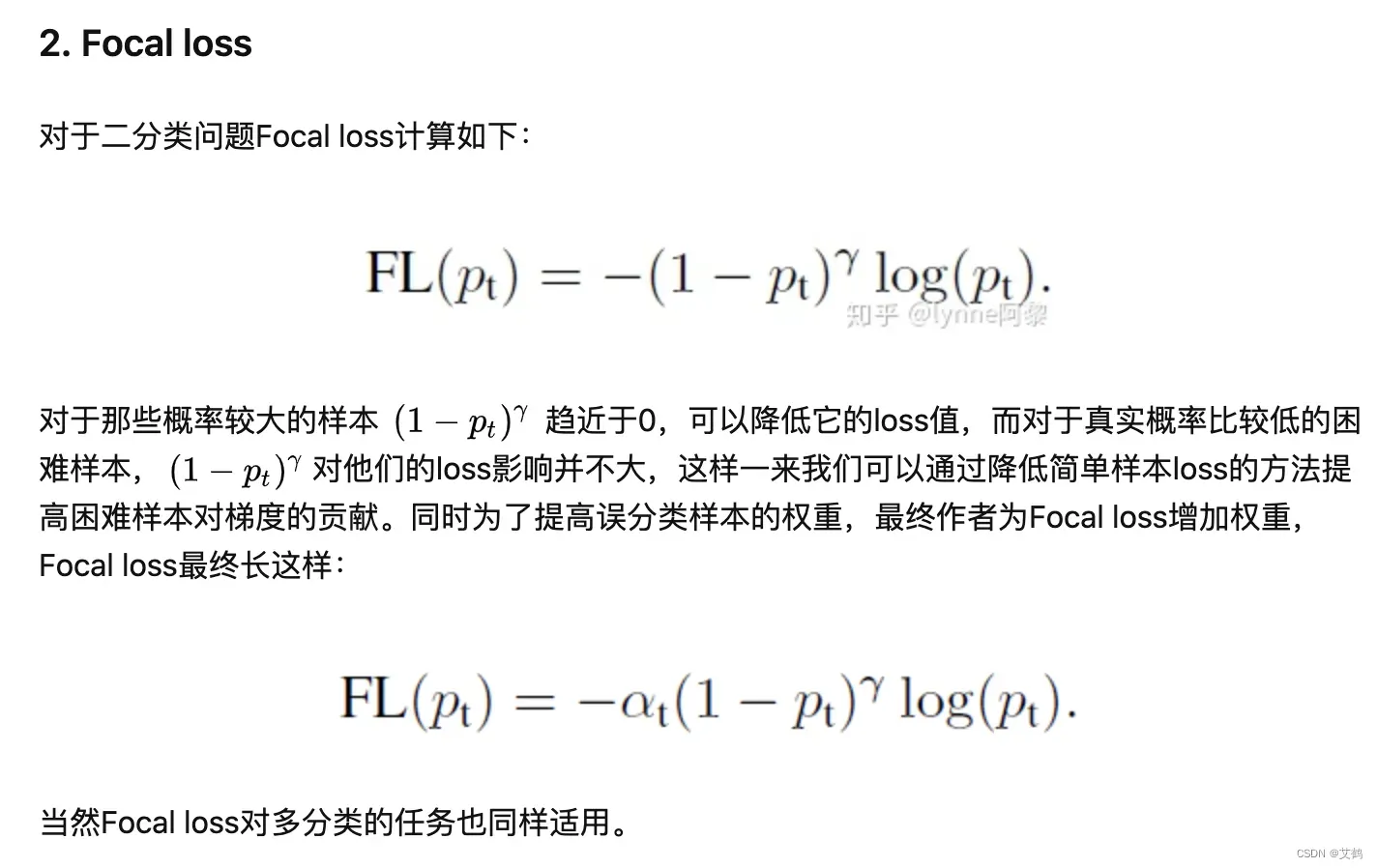

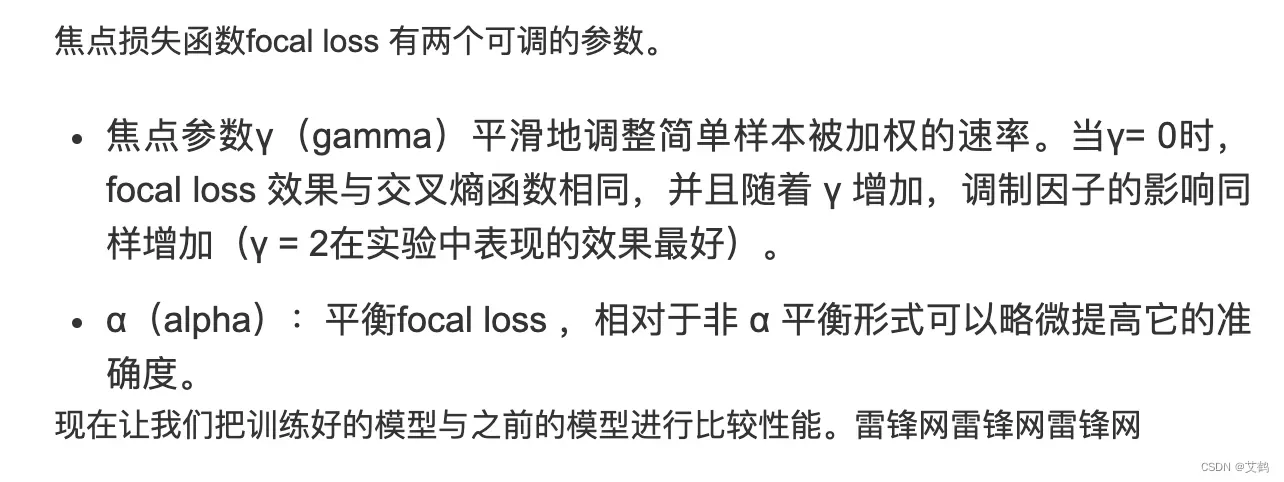

5.focal loss

https://zhuanlan.zhihu.com/p/113716961

r越大,容易分的loss越小

调参技巧:

其他:

https://www.cnblogs.com/ChrisInsistPy/p/9673608.html

文章出处登录后可见!

已经登录?立即刷新