文@555985

0 前言

老大在 MMOCR 的发布稿中说道,MMOCR 作为开源的文字检测识别理解工具箱,拥有着全流程、多模型、模块设计、公平对比、快速入门等诸多优点。之后,还为读者们画下了数个大饼,包括但不限于

MMOCR 不仅仅是研究导向的框架,还是一个可以用于入门,教学,以及工业实际生产的框架。

或是“我们逐步会加入更多的算法以及多语言模型”云云。正所谓画饼一时爽,头发火葬场。老大动嘴皮,小弟惨兮兮。

勇敢牛牛不怕困难!努力了两个月后,MMOCR 的版本从 0.2.0 提升到了 0.2.1,针对性的修复了版本号过低的 bug。此外,我们还捎带作出了一些小更新:

- 增加了对新手友好的应用脚本,便于入门、教学和测试模型的实际表现;

- 支持部分模型导出至 ONNX 和 TensorRT;

- 数据集新增对 TextOCR 和 Total-Text 的支持,完善了一些数据集的处理脚本;

- 开始提供中文文档(在做了但又没有完全做好== dbq);

- 对配置方法依照最新版 MMCV 以及 MMDetection 的要求进行了重构,以支持一些新特性;

之前 MMOCR 发布的时候就有很多社区同学留言评论,说我们没有详细的介绍一下。这== 是的,这就补上。MMOCR 全方位食用指南,拿来吧你!!

在这篇文章里,我们将会重点介绍第一项:通过新增的应用脚本,手把手带领读者尝试使用 MMOCR 已有的模型。在此之前,先列出 MMOCR 支持的模型供读者参考:

| 文字检测(Text Detection) | 文字识别(Text Recognition) | 文字识别(Text Recognition) | 端对端 OCR 模型 |

| – DBNet – DRRG – FCENet – MaskRCNN – PANet – PSENet – TextSnake |

– CRNN – NRTR – SAR – RobustScanner – SegOCR – TPS-CRNN |

– SDMG-R | – 在做了 |

顺便一提, MMOCR 支持的数据集也不少哦:

| 文字检测(Text Detection) | 文字识别(Text Recognition) | 关键信息提取(Key Information Extraction) |

| – CTW1500 – ICDAR2015 – ICDAR2017 – SynthText – TextOCR – Total-Text |

– COCO-Text – ICDAR2011 – ICDAR2013 – ICDAR2015 – IIIT 5k – CT80 – SVT – SVTP – Syn90k (MJSynth) – SynthText – SynthAdd – TextOCR – Total-Text |

– Wildreceipt |

对于这些数据集,我们均已提供转换脚本或处理后的标注文件供大家在 MMOCR 中使用。

1 文字检测与识别 (Text Detection & Recognition)

尽管模型管够,但不同模型在不同场景下的表现会有所差异。俗语有云,是骡子是马,还得拉出来遛遛。社区同学 @samayala22 热心地为我们提供了一个懒人脚本——mmocr/utils/ocr.py,感恩~ 此脚本开箱即用,只需简单的一行命令,万千模型立即组合[1],任君差遣。首先,我们可以试着用它识别一下一张名为magazine.png 的杂志图片:

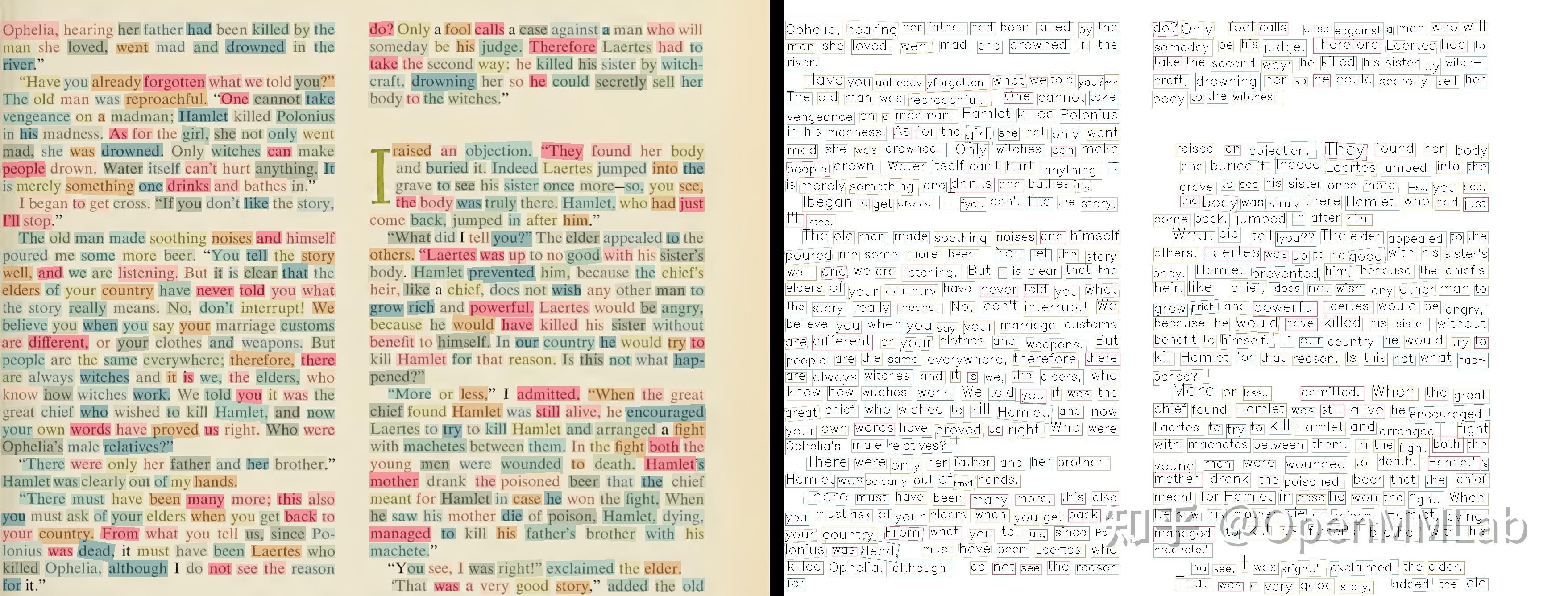

python mmocr/utils/ocr.py demo/magazine.png --det PS_IC15 --recog RobustScanner --imshow --out_img demo/result.jpg 这个命令调用了 PSENet 和 RobustScanner 分别作为文本识别和检测模型,端对端地对图片进行了 OCR 识别。识别结果会显示在弹出窗口中,并被保存至demo/result.jpg中(见下图)。可以见到,这两个模型组合起来的识别效果还是很不错的。然而,受限于训练数据,我们输出的结果往往只会以单词为单位。这在文字分布零散的场景中问题不大,可是如果在书刊杂志的识别上,就显得没有那么赏心悦目了。

显然,要想从根本上解决这个问题,还是得从训练数据集下手,对具体场景做好微调。然而,这种方法耗时耗力,且对于普通用户而言成本太高。于是,在参考了社区成员的意见后,提出了一个快捷(且丑陋)的修复方案——一个名为stitch_boxes_into_lines 的函数。它会在脚本输出最终结果前,自动合并邻近的文字框,从而实现按行输出的效果。要想尝试该方案,读者只需在脚本后加上--merge参数:

python mmocr/utils/ocr.py demo/magazine.png --det PS_IC15 --recog RobustScanner --imshow --out_img demo/result.jpg --merge 然而,“邻近”的定义在不同的场景下是不一致的。为了适应不同的环境,该函数为调参侠们贴心地提供了两个参数:

def stitch_boxes_into_lines(boxes,

max_x_dist=10,

min_y_overlap_ratio=0.8,

has_text=True):

"""合并相邻的检测框。

...

max_x_dist (int): 当两个检测框在x轴上的最短距离大于该值时,不作合并

min_y_overlap_ratio (float): 当两个检测框在y轴上的重合长度与自身在y轴上的长度(高)的比都小于该值时,不作合并

...

""" 在上面的实例中,max_x_dist 跟 min_y_overlap_ratio 就分别被设置为 40 和 0.5 。

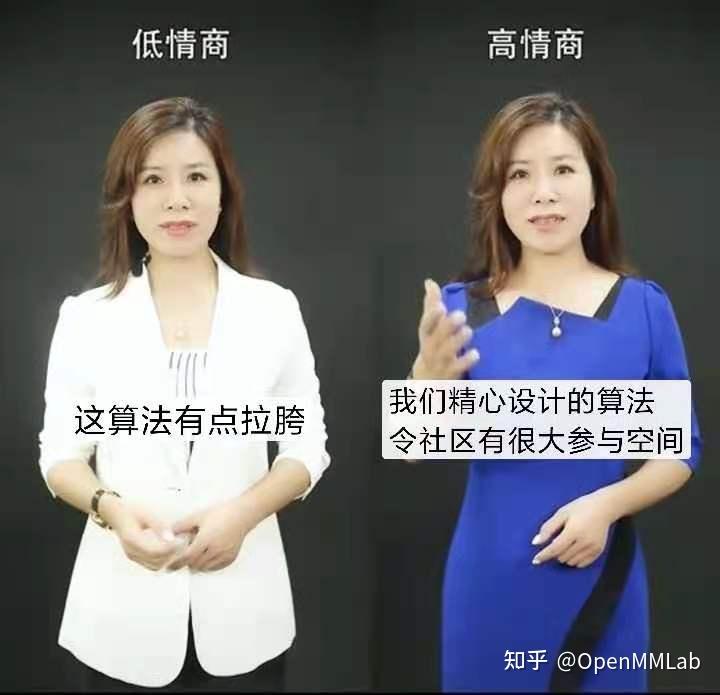

很显然,考虑到调参的麻烦程度,这个辅助函数还有很大的提升空间。同时,它也是一个具有挑战性的工程性问题。我们将会在后续视实际需求随缘优化这个算法;当然,如果读者对此有什么好的想法、建议或实践经验,欢迎在我们的社区交流甚至提出 PR!

另外,我们目前也在开始支持中文的文字识别,现在已经公开了一个在 ChineseOCR 上预训练好的 SAR 文字识别模型(见链接),只不过效果上也比较拉胯有很大的提升空间。作为开发计划的一部分,我们将会逐步提升 MMOCR 在中文上的表现。同样地,如果小伙伴们有任何中文相关的 OCR 的论文,资源甚至 PR,都欢迎在 Github 上与我们随时交流! 重点!多交流好嘛!!

[1]: 这里运用了夸张的修辞手法,实际上只有十四个模型。

2 关键信息提取(Key Information Extraction)

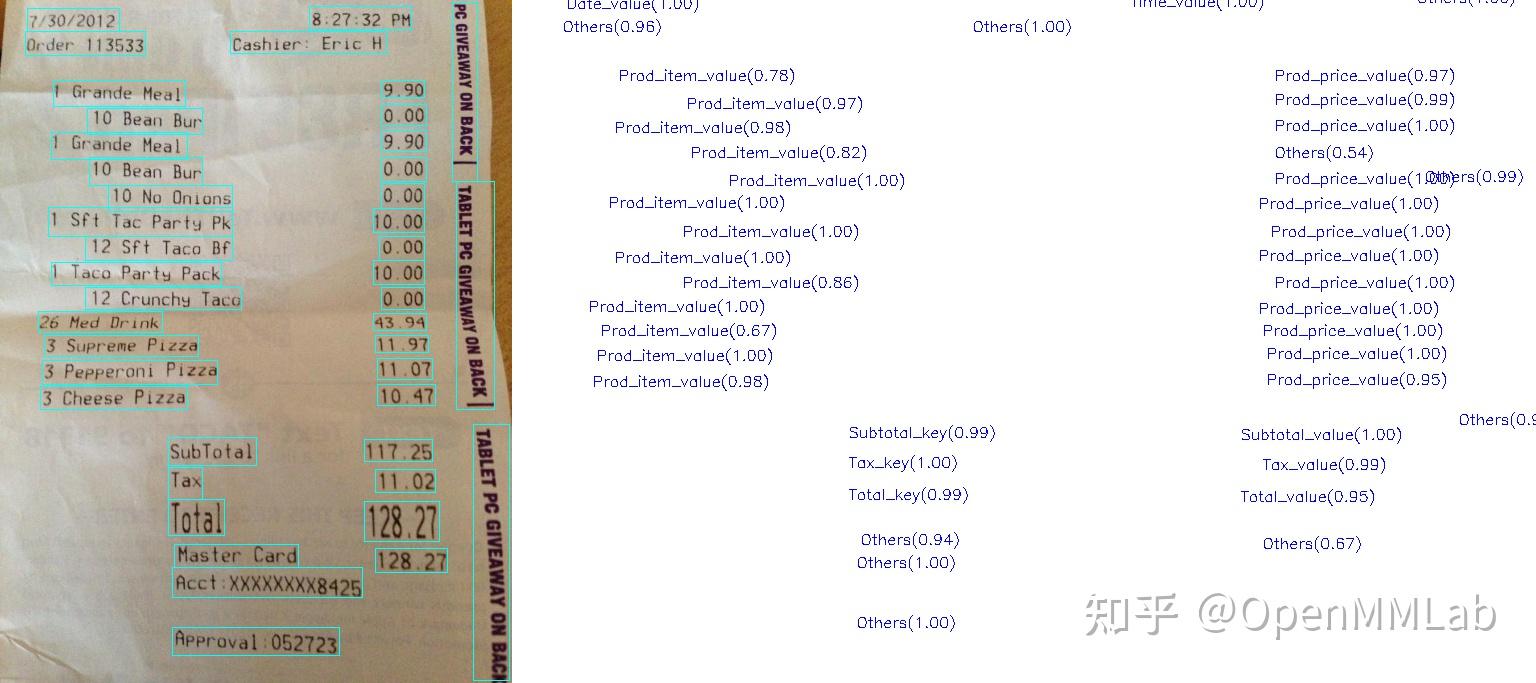

假设我们现在有一批包含信息类似但布局不同的文档(如收据),KIE 模型可以帮助我们自动把文档上的关键信息(物品、价格、商店名称等)作出判断及归类,从而实现自动化的信息提取。有了这种模型的帮助,大家就能更方便地统计自己每个月跟女朋友逛街的花费,可以说是相当实用了。

啥?没女朋友怎么办?

KIE 作为文字识别领域一个常见的下游任务,它常常需要结合图像和文字的识别结果作出综合判断,因此十分依赖于上游文字检测和识别模型的输出。得益于 MMOCR 的通用模块化设计,在mmocr/utils/ocr.py中, SDMGR 被无缝地接入了模型的工作链,端对端地实现对输入图片的推断。(KIE 的片段部分由印度的 @manjrekarom 小哥提出,感谢!)

接下来,我们同样测试一下 SDMGR 的表现。假设我们有一张收据图片放在demo/demo_kie.jpeg下,我们便可以通过以下命令来进行 KIE 推断:

python mmocr/utils/ocr.py demo/demo_kie.jpeg --det PS_CTW --recog SAR --kie SDMGR --print-result --imshow 该命令采用 PSENet 和 SAR 模型进行文本检测和识别,之后 SDMGR 模型被用来对识别结果进行归类。从图中可见,大部分的字段都被成功归类了出来。

3 在项目中使用 MMOCR 模块

在某些工程实践中,我们可能会希望调用 MMOCR 的模型进行文字识别或信息提取。这里 MMOCR 也提供了一个非常方便的类:MMOCR。用户仅需导入该类,并调用MMOCR.readtext(),即可识别任意图片。

我们继续举个例子——比方说,我们要在项目中使用 MMOCR 中的 PSENet 和 SAR 识别demo/demo_text_ocr.jpg,可以这样操作:

import mmcv

from mmocr.utils.ocr import MMOCR

img = mmcv.imread('demo/demo_text_ocr.jpg')

ocr = MMOCR(det='PS_CTW', recog='SAR')

results = ocr.readtext(img) # 也可以直接传入文件路径 以下为部分results内的内容,可见识别框和文字都已经被详细地标注了出来,用户可以在接下来的开发中直接调用这些信息:

[{'filename': '0', 'result': [{'box': [166, 14, 164, 16, 164, 20, 161, 23, 161, 30, 164, 32, 164, 39, 170, 39, 173, 41, 198, 41, 200, 43, 211, 43, 214, 45, 216, 43, 216, 30, 214, 27, 214, 18, 207, 18, 204, 16, 186, 16, 184, 14], 'box_score': 0.9082011580467224, 'text': 'SALE', 'text_score': 0.9999995529651642}, ...]}] 实际上,mmocr/utils/ocr.py 的命令行只是MMOCR的一层包装。因此,所有在命令行里适用的参数在MMOCR里都是通用的,宝宝们再也不用担心MMOCR功能不足了。

总结

相信通过上面的演示,读者已经掌握了这个脚本一些基本的用法。更多关于该脚本参数的介绍和演示,有需要的读者可以参考我们的文档。

作为 MM 家族一个较新的靓仔, MMOCR 目前仍然在不断完善,力图早日烘焙出最初画下的大饼。作为一个开源社区,社区建设和倾听反馈亦是我们工作重要的一环。我们非常期待社区的问题反馈,建议以及想法,欢迎随时跟我们联系。

有条件的朋友,可以麻烦顺手点个 star 支持一下我们嘛!笔者携为数不多的小头发一起谢过大家!

【MMOCR Github地址】:https://github.com/open-mmlab/mmocr

最后的最后欢迎大家加入 OpenMMLab社群:

【 QQ社群】:1群:144762544(即将满员) 2群:920178331

【 微信社群】:微信可扫码关注公众号!添加运营小助手,拉你进群!!

版权声明:本文为博主OpenMMLab原创文章,版权归属原作者,如果侵权,请联系我们删除!