目录

2.11 参数

1. 概述:

梯度下降在机器学习的运用非常的广泛,它的主要目的就是找到目标函数的最小值,有些时候是局部的最小值使得局部能够达到收敛。

本文从下山这个实例出发简述一下梯度下降算法的思想。

2. 梯度下降算法:

2.1 场景假设 :

我们将梯度下降算法想象成我们现在就在山顶上然后选择自己要下山的方向,我们希望我们能够早点下山就是每次沿着最陡的路径往下下山,到达这个点以后使用同样的方法找到下降最多的方向,如图所示:

公式如下:

根据大佬的博客

Θ1=Θ0+α▽J(Θ) 其中▽J(Θ)是梯度,是步长。

2.11  参数

参数

就是学习率和步长,我们通过

2.12 实例:

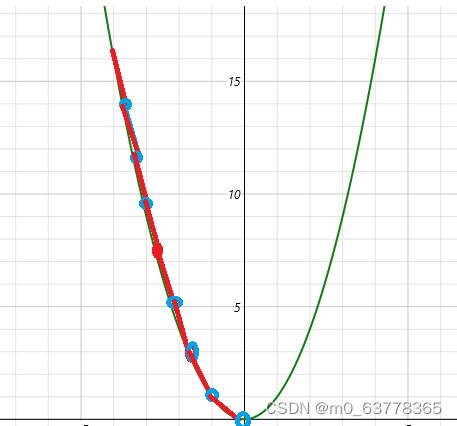

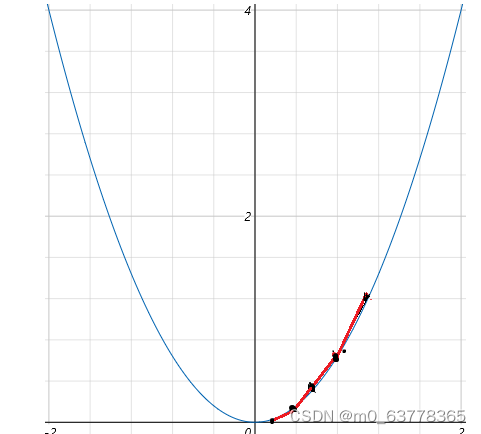

我们使用一个单变量函数进行梯度下降,我们假设有这样一个函数;

然后我们对它求导

我们初始这个函数的值为1。

那么.

在这里我们设置的值为0.4

那么根据我们的梯度下降算法就会有如下的迭代过程:

如图所示:

文章出处登录后可见!

已经登录?立即刷新