注:本次使用的数据集依旧是前两章的Moon1000数据集

from nndl.dataset import make_moons【详细代码见 神经网络与深度学习(五)前馈神经网络(1)——二分类任务中的4.2.1节】

目录

4.3 自动梯度计算和预定义算子

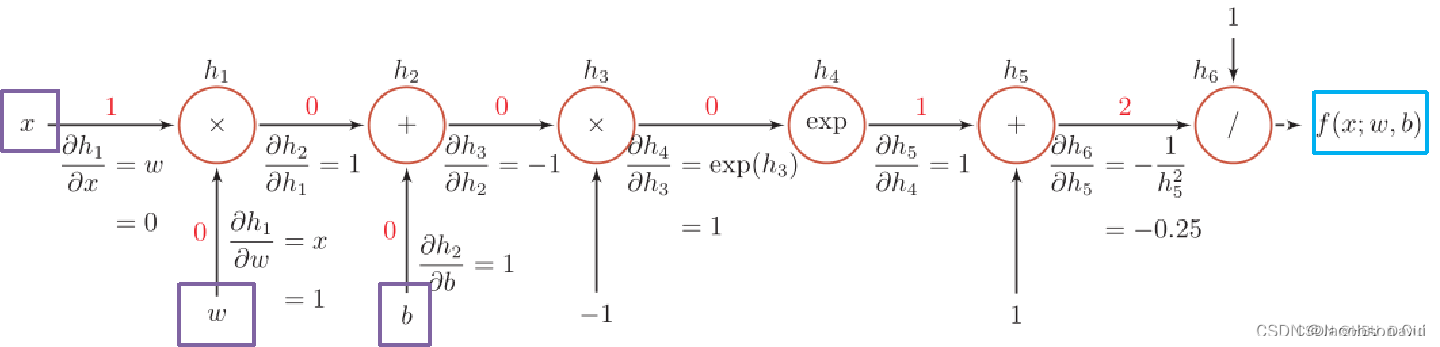

虽然我们能够通过模块化的方式比较好地对神经网络进行组装,但是每个模块的梯度计算过程仍然十分繁琐且容易出错。在深度学习框架中,已经封装了自动梯度计算的功能,我们只需要聚焦模型架构,不再需要耗费精力进行计算梯度。

pytorch提供了nn.Module类,来方便快速的实现自己的层和模型。模型和层都可以基于nn.Module扩充实现,模型只是一种特殊的层。

继承了nn.Module类的算子中,可以在内部直接调用其它继承nn.Module类的算子,pytorch框架会自动识别算子中内嵌的nn.Module类算子,并自动计算它们的梯度,并在优化时更新它们的参数。

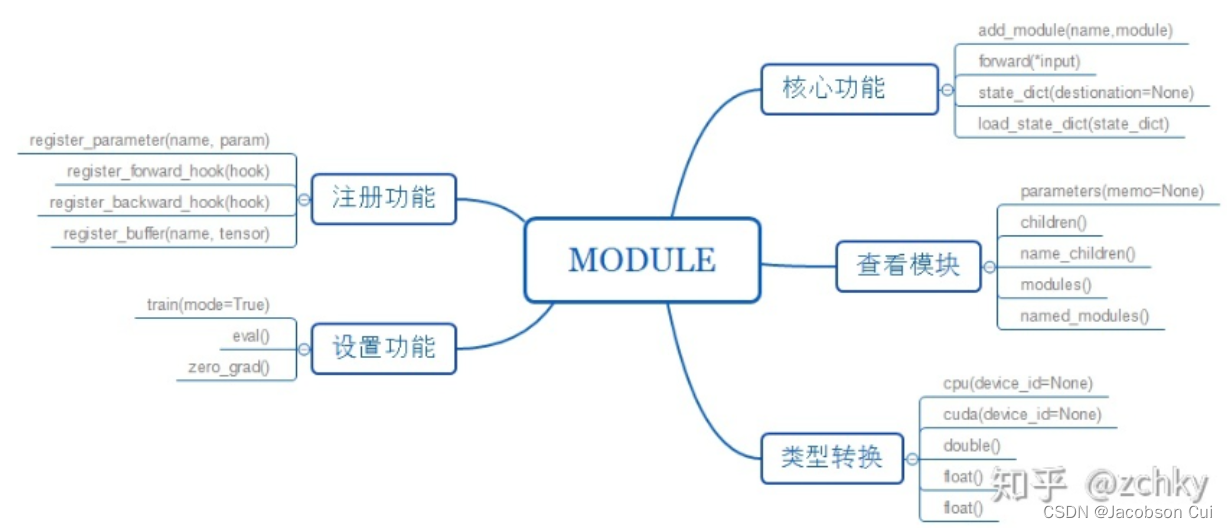

torch.nn.Module在pytorch中的相应内容是什么?请简要介绍。

torch.nn.Module是所有神经网络模块的基类,所有的神经网络模型都应该继承这个基类,即pytorch 里面一切自定义操作基本上都是继承nn.Module类来实现的,并进行重载_init_ (初始化)和 forward(前向传播)函数。即在_init_ 进行模型子模块的构建,在forward进行子模块的拼接。每个类都有一个对应的nn.funcational函数,类定义了所需要的arguments和模块的parameters ,在forward函数中将arguments和parameters传给nn.funcational的对应的函数来实现forward功能。

注意事项:

-

一般把网络中具有可学习参数的层(如全连接层、卷积层等)(模块类的初始化) 放在构造函数

__init__()中 -

forward方法是必须要重写的,它是实现模型的功能,实现各个层之间的连接关系的核心

具体原码解读请参考:

Module — PyTorch 1.12 documentation

4.3.1 利用预定义算子重新实现前馈神经网络

下面我们使用Pytorch的预定义算子来重新实现二分类任务。

主要使用到的预定义算子为torch.nn.Linear

CLASS torch.nn.Linear(in_features, out_features, bias=True, device=None, dtype=None)

torch.nn.Linear算子可以接受一个形状为[,

]的输入张量,其中"

"表示张量中可以有任意的其它额外维度,并计算它与形状为[out_features, in_features]的权重矩阵的乘积,然后生成形状为[

,

]的输出张量。

torch.nn.Linear算子默认有偏置参数,可以通过bias=False设置不带偏置。 代码实现如下:

import torch.nn as nn

import torch.nn.functional as F

from torch.nn.init import constant_, normal_, uniform_

class Model_MLP_L2_V2(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(Model_MLP_L2_V2, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

normal_(self.fc1.weight, mean=0., std=1.)

constant_(self.fc1.bias, val=0.0)

self.fc2 = nn.Linear(hidden_size, output_size)

normal_(self.fc2.weight, mean=0., std=1.)

constant_(self.fc2.bias, val=0.0)

self.act_fn = torch.sigmoid

# 前向计算

def forward(self, inputs):

z1 = self.fc1(inputs)

a1 = self.act_fn(z1)

z2 = self.fc2(a1)

a2 = self.act_fn(z2)

return a24.3.2 完善Runner类

基于上一节实现的 RunnerV2_1 类,本节的 RunnerV2_2类在训练过程中使用自动梯度计算;模型保存时,使用state_dict方法获取模型参数;模型加载时,使用set_state_dict方法加载模型参数.

import torch

class RunnerV2_2(object):

def __init__(self, model, optimizer, metric, loss_fn, **kwargs):

self.model = model

self.optimizer = optimizer

self.loss_fn = loss_fn

self.metric = metric

# 记录训练过程中的评估指标变化情况

self.train_scores = []

self.dev_scores = []

# 记录训练过程中的评价指标变化情况

self.train_loss = []

self.dev_loss = []

def train(self, train_set, dev_set, **kwargs):

# 将模型切换为训练模式

self.model.train()

# 传入训练轮数,如果没有传入值则默认为0

num_epochs = kwargs.get("num_epochs", 0)

# 传入log打印频率,如果没有传入值则默认为100

log_epochs = kwargs.get("log_epochs", 100)

# 传入模型保存路径,如果没有传入值则默认为"best_model.pdparams"

save_path = kwargs.get("save_path", "best_model.pdparams")

# log打印函数,如果没有传入则默认为"None"

custom_print_log = kwargs.get("custom_print_log", None)

# 记录全局最优指标

best_score = 0

# 进行num_epochs轮训练

for epoch in range(num_epochs):

X, y = train_set

# 获取模型预测

logits = self.model(X)

# 计算交叉熵损失

trn_loss = self.loss_fn(logits, y)

self.train_loss.append(trn_loss.item())

# 计算评估指标

trn_score = self.metric(logits, y).item()

self.train_scores.append(trn_score)

# 自动计算参数梯度

trn_loss.backward()

if custom_print_log is not None:

# 打印每一层的梯度

custom_print_log(self)

# 参数更新

self.optimizer.step()

# 清空梯度

self.optimizer.zero_grad()

dev_score, dev_loss = self.evaluate(dev_set)

# 如果当前指标为最优指标,保存该模型

if dev_score > best_score:

self.save_model(save_path)

print(f"[Evaluate] best accuracy performence has been updated: {best_score:.5f} --> {dev_score:.5f}")

best_score = dev_score

if log_epochs and epoch % log_epochs == 0:

print(f"[Train] epoch: {epoch}/{num_epochs}, loss: {trn_loss.item()}")

# 模型评估阶段,使用'torch.no_grad()'控制不计算和存储梯度

@torch.no_grad()

def evaluate(self, data_set):

# 将模型切换为评估模式

self.model.eval()

X, y = data_set

# 计算模型输出

logits = self.model(X)

# 计算损失函数

loss = self.loss_fn(logits, y).item()

self.dev_loss.append(loss)

# 计算评估指标

score = self.metric(logits, y).item()

self.dev_scores.append(score)

return score, loss

def predict(self, X):

# 将模型切换为评估模式

self.model.eval()

return self.model(X)

# 使用'model.state_dict()'获取模型参数,并进行保存

def save_model(self, saved_path):

torch.save(self.model.state_dict(), saved_path)

# 使用'model.set_state_dict'加载模型参数

def load_model(self, model_path):

state_dict = torch.load(model_path)

self.model.set_state_dict(state_dict)4.3.3 模型训练

实例化RunnerV2类,并传入训练配置,代码实现如下:

from nndl.metric import accuracy

# 设置模型

input_size = 2

hidden_size = 5

output_size = 1

model = Model_MLP_L2_V2(input_size=input_size, hidden_size=hidden_size, output_size=output_size)

# 设置损失函数

loss_fn = F.binary_cross_entropy

# 设置优化器

learning_rate = 0.2

optimizer = torch.optim.SGD(model.parameters(), learning_rate)

# 设置评价指标

metric = accuracy

# 其他参数

epoch_num = 1000

saved_path = 'best_model.pdparams'

# 实例化RunnerV2类,并传入训练配置

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=epoch_num, log_epochs=50, save_path="best_model.pdparams")运行结果:

[Evaluate] best accuracy performence has been updated: 0.00000 --> 0.50625

[Train] epoch: 0/1000, loss: 0.7748638391494751

[Evaluate] best accuracy performence has been updated: 0.50625 --> 0.51250

[Evaluate] best accuracy performence has been updated: 0.51250 --> 0.53125

[Evaluate] best accuracy performence has been updated: 0.53125 --> 0.55000

[Evaluate] best accuracy performence has been updated: 0.55000 --> 0.59375

[Evaluate] best accuracy performence has been updated: 0.59375 --> 0.63125

[Evaluate] best accuracy performence has been updated: 0.63125 --> 0.64375

[Evaluate] best accuracy performence has been updated: 0.64375 --> 0.65000

[Evaluate] best accuracy performence has been updated: 0.65000 --> 0.66250

[Evaluate] best accuracy performence has been updated: 0.66250 --> 0.66875

[Evaluate] best accuracy performence has been updated: 0.66875 --> 0.67500

[Evaluate] best accuracy performence has been updated: 0.67500 --> 0.68750

[Evaluate] best accuracy performence has been updated: 0.68750 --> 0.70000

[Evaluate] best accuracy performence has been updated: 0.70000 --> 0.70625

[Evaluate] best accuracy performence has been updated: 0.70625 --> 0.71250

[Evaluate] best accuracy performence has been updated: 0.71250 --> 0.72500

[Evaluate] best accuracy performence has been updated: 0.72500 --> 0.73750

[Evaluate] best accuracy performence has been updated: 0.73750 --> 0.74375

[Evaluate] best accuracy performence has been updated: 0.74375 --> 0.75625

[Evaluate] best accuracy performence has been updated: 0.75625 --> 0.76250

[Train] epoch: 50/1000, loss: 0.5065249800682068

[Evaluate] best accuracy performence has been updated: 0.76250 --> 0.76875

[Evaluate] best accuracy performence has been updated: 0.76875 --> 0.77500

[Evaluate] best accuracy performence has been updated: 0.77500 --> 0.78125

[Evaluate] best accuracy performence has been updated: 0.78125 --> 0.78750

[Evaluate] best accuracy performence has been updated: 0.78750 --> 0.79375

[Train] epoch: 100/1000, loss: 0.4653768539428711

[Evaluate] best accuracy performence has been updated: 0.79375 --> 0.80000

[Train] epoch: 150/1000, loss: 0.450691282749176

[Train] epoch: 200/1000, loss: 0.44423261284828186

[Train] epoch: 250/1000, loss: 0.44101113080978394

[Evaluate] best accuracy performence has been updated: 0.80000 --> 0.80625

[Train] epoch: 300/1000, loss: 0.43923836946487427

[Train] epoch: 350/1000, loss: 0.4381652772426605

[Train] epoch: 400/1000, loss: 0.43744945526123047

[Train] epoch: 450/1000, loss: 0.4369260370731354

[Train] epoch: 500/1000, loss: 0.4365127682685852

[Train] epoch: 550/1000, loss: 0.43616747856140137

[Train] epoch: 600/1000, loss: 0.43586739897727966

[Train] epoch: 650/1000, loss: 0.4355992376804352

[Train] epoch: 700/1000, loss: 0.43535494804382324

[Train] epoch: 750/1000, loss: 0.43512874841690063

[Train] epoch: 800/1000, loss: 0.4349164366722107

[Train] epoch: 850/1000, loss: 0.4347147047519684

[Train] epoch: 900/1000, loss: 0.4345203936100006

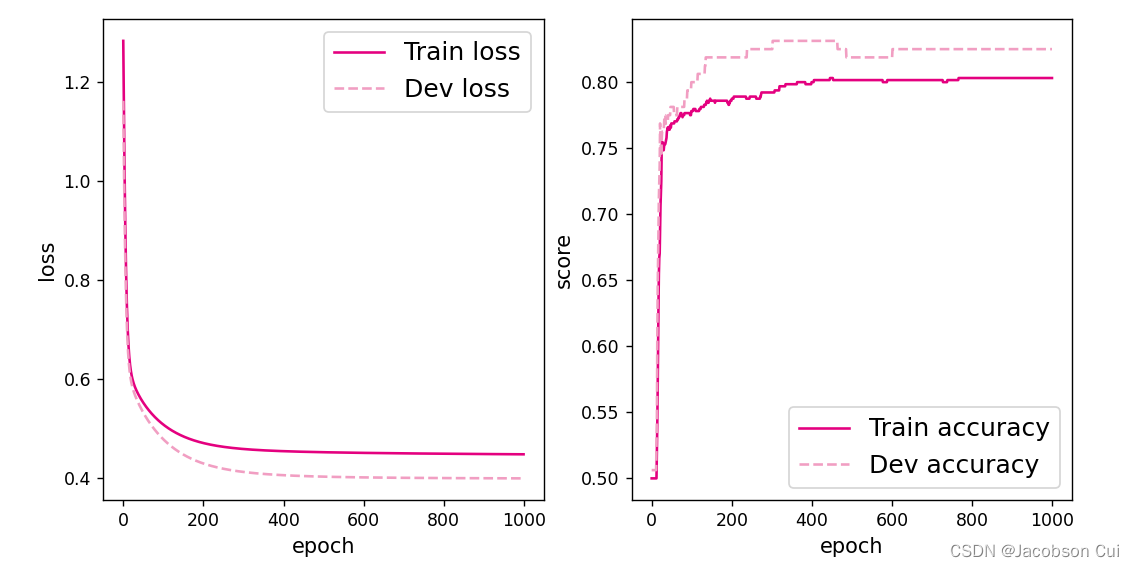

[Train] epoch: 950/1000, loss: 0.4343307912349701将训练过程中训练集与验证集的准确率变化情况进行可视化。

import matplotlib.pyplot as plt

# 可视化观察训练集与验证集的指标变化情况

def plot(runner, fig_name):

plt.figure(figsize=(10, 5))

epochs = [i for i in range(len(runner.train_scores))]

plt.subplot(1, 2, 1)

plt.plot(epochs, runner.train_loss, color='#e4007f', label="Train loss")

plt.plot(epochs, runner.dev_loss, color='#f19ec2', linestyle='--', label="Dev loss")

# 绘制坐标轴和图例

plt.ylabel("loss", fontsize='large')

plt.xlabel("epoch", fontsize='large')

plt.legend(loc='upper right', fontsize='x-large')

plt.subplot(1, 2, 2)

plt.plot(epochs, runner.train_scores, color='#e4007f', label="Train accuracy")

plt.plot(epochs, runner.dev_scores, color='#f19ec2', linestyle='--', label="Dev accuracy")

# 绘制坐标轴和图例

plt.ylabel("score", fontsize='large')

plt.xlabel("epoch", fontsize='large')

plt.legend(loc='lower right', fontsize='x-large')

plt.savefig(fig_name)

plt.show()

plot(runner, 'fw-acc.pdf')运行结果:

4.3.4 性能评价

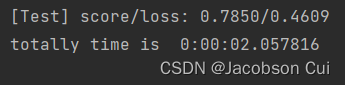

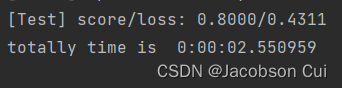

使用测试数据对训练完成后的最优模型进行评价,观察模型在测试集上的准确率以及loss情况。代码如下:

# 模型评价

torch.load("best_model.pdparams")

score, loss = runner.evaluate([X_test, y_test])

print("[Test] score/loss: {:.4f}/{:.4f}".format(score, loss))运行结果:

从结果来看,模型在测试集上取得了较高的准确率。

在上述问题的基础上:增加一个3个神经元的隐藏层,再次实现二分类,并与其做对比。

import torch.nn as nn

import torch.nn.functional as F

from torch.nn.init import constant_, normal_, uniform_

import torch

from nndl.metric import accuracy

import matplotlib.pyplot as plt

from nndl.dataset import make_moons

# 采样1000个样本

n_samples = 1000

X, y = make_moons(n_samples=n_samples, shuffle=True, noise=0.5)

num_train = 640

num_dev = 160

num_test = 200

X_train, y_train = X[:num_train], y[:num_train]

X_dev, y_dev = X[num_train:num_train + num_dev], y[num_train:num_train + num_dev]

X_test, y_test = X[num_train + num_dev:], y[num_train + num_dev:]

y_train = y_train.reshape([-1, 1])

y_dev = y_dev.reshape([-1, 1])

y_test = y_test.reshape([-1, 1])

class Model_MLP_L2_V4(nn.Module):

def __init__(self, input_size, hidden_size, hidden_size_3, output_size):

super(Model_MLP_L2_V4, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

normal_(self.fc1.weight, mean=0., std=1.)

constant_(self.fc1.bias, val=0.0)

self.fc2 = nn.Linear(hidden_size, hidden_size_3)

normal_(self.fc2.weight, mean=0., std=1.)

constant_(self.fc2.bias, val=0.0)

self.fc3 = nn.Linear(hidden_size_3, output_size)

normal_(self.fc3.weight, mean=0., std=1.)

constant_(self.fc3.bias, val=0.0)

self.act_fn = torch.sigmoid

# 前向计算

def forward(self, inputs):

z1 = self.fc1(inputs.to(torch.float32))

a1 = self.act_fn(z1)

z2 = self.fc2(a1)

a2 = self.act_fn(z2)

z3 = self.fc3(a2)

a3 = self.act_fn(z3)

return a3

class RunnerV2_2(object):

def __init__(self, model, optimizer, metric, loss_fn, **kwargs):

self.model = model

self.optimizer = optimizer

self.loss_fn = loss_fn

self.metric = metric

# 记录训练过程中的评估指标变化情况

self.train_scores = []

self.dev_scores = []

# 记录训练过程中的评价指标变化情况

self.train_loss = []

self.dev_loss = []

def train(self, train_set, dev_set, **kwargs):

# 将模型切换为训练模式

self.model.train()

# 传入训练轮数,如果没有传入值则默认为0

num_epochs = kwargs.get("num_epochs", 0)

# 传入log打印频率,如果没有传入值则默认为100

log_epochs = kwargs.get("log_epochs", 100)

# 传入模型保存路径,如果没有传入值则默认为"best_model.pdparams"

save_path = kwargs.get("save_path", "best_model.pdparams")

# log打印函数,如果没有传入则默认为"None"

custom_print_log = kwargs.get("custom_print_log", None)

# 记录全局最优指标

best_score = 0

# 进行num_epochs轮训练

for epoch in range(num_epochs):

X, y = train_set

# 获取模型预测

logits = self.model(X)

# 计算交叉熵损失

trn_loss = self.loss_fn(logits, y)

self.train_loss.append(trn_loss.item())

# 计算评估指标

trn_score = self.metric(logits, y).item()

self.train_scores.append(trn_score)

# 自动计算参数梯度

trn_loss.backward()

if custom_print_log is not None:

# 打印每一层的梯度

custom_print_log(self)

# 参数更新

self.optimizer.step()

# 清空梯度

self.optimizer.zero_grad()

dev_score, dev_loss = self.evaluate(dev_set)

# 如果当前指标为最优指标,保存该模型

if dev_score > best_score:

self.save_model(save_path)

print(f"[Evaluate] best accuracy performence has been updated: {best_score:.5f} --> {dev_score:.5f}")

best_score = dev_score

if log_epochs and epoch % log_epochs == 0:

print(f"[Train] epoch: {epoch}/{num_epochs}, loss: {trn_loss.item()}")

# 模型评估阶段,使用'torch.no_grad()'控制不计算和存储梯度

@torch.no_grad()

def evaluate(self, data_set):

# 将模型切换为评估模式

self.model.eval()

X, y = data_set

# 计算模型输出

logits = self.model(X)

# 计算损失函数

loss = self.loss_fn(logits, y).item()

self.dev_loss.append(loss)

# 计算评估指标

score = self.metric(logits, y).item()

self.dev_scores.append(score)

return score, loss

def predict(self, X):

# 将模型切换为评估模式

self.model.eval()

return self.model(X)

# 使用'model.state_dict()'获取模型参数,并进行保存

def save_model(self, saved_path):

torch.save(self.model.state_dict(), saved_path)

# 使用'model.set_state_dict'加载模型参数

def load_model(self, model_path):

state_dict = torch.load(model_path)

self.model.set_state_dict(state_dict)

# 设置模型

input_size = 2

hidden_size = 5

hidden_size_3 = 3

output_size = 1

model = Model_MLP_L2_V4(input_size=input_size, hidden_size=hidden_size, hidden_size_3=3, output_size=output_size)

# 设置损失函数

loss_fn = F.binary_cross_entropy

# 设置优化器

learning_rate = 0.2

optimizer = torch.optim.SGD(model.parameters(), learning_rate)

# 设置评价指标

metric = accuracy

# 其他参数

epoch_num = 1000

saved_path = 'best_model.pdparams'

# 实例化RunnerV2类,并传入训练配置

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=epoch_num, log_epochs=50, save_path="best_model.pdparams")

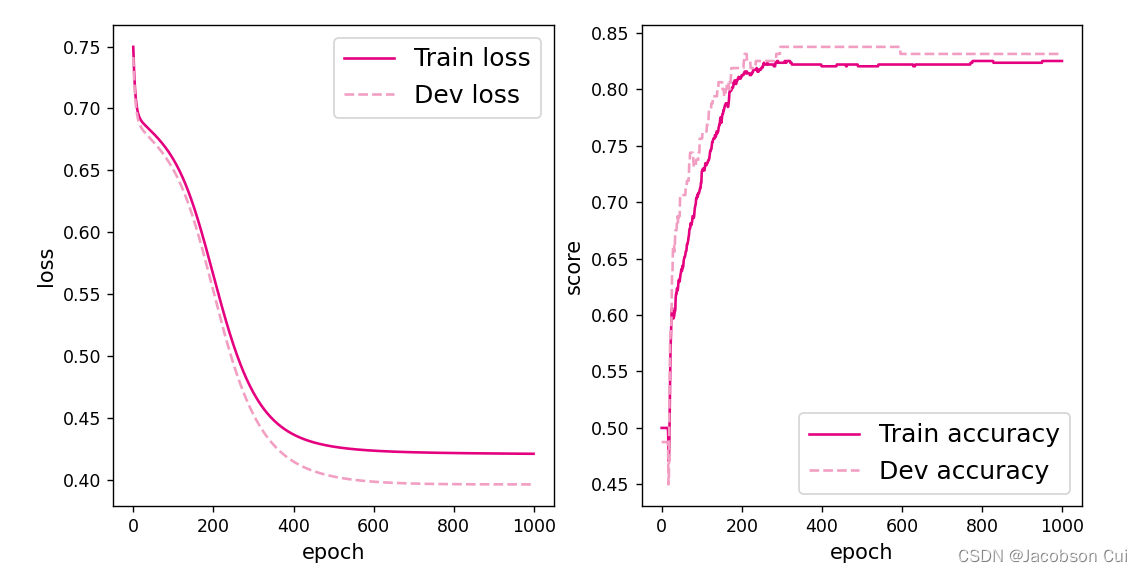

# 可视化观察训练集与验证集的指标变化情况

def plot(runner, fig_name):

plt.figure(figsize=(10, 5))

epochs = [i for i in range(len(runner.train_scores))]

plt.subplot(1, 2, 1)

plt.plot(epochs, runner.train_loss, color='#e4007f', label="Train loss")

plt.plot(epochs, runner.dev_loss, color='#f19ec2', linestyle='--', label="Dev loss")

# 绘制坐标轴和图例

plt.ylabel("loss", fontsize='large')

plt.xlabel("epoch", fontsize='large')

plt.legend(loc='upper right', fontsize='x-large')

plt.subplot(1, 2, 2)

plt.plot(epochs, runner.train_scores, color='#e4007f', label="Train accuracy")

plt.plot(epochs, runner.dev_scores, color='#f19ec2', linestyle='--', label="Dev accuracy")

# 绘制坐标轴和图例

plt.ylabel("score", fontsize='large')

plt.xlabel("epoch", fontsize='large')

plt.legend(loc='lower right', fontsize='x-large')

plt.savefig(fig_name)

plt.show()

plot(runner, 'fw-acc.pdf')

# 模型评价

torch.load("best_model.pdparams")

score, loss = runner.evaluate([X_test, y_test])

print("[Test] score/loss: {:.4f}/{:.4f}".format(score, loss))运行结果:

![]()

与之前的结果相比可知,模型在测试集上的准确率得到了进一步的提升。

【思考题】自定义梯度计算和自动梯度计算:从计算性能、计算结果等多方面比较,谈谈自己的看法。

自动梯度计算:在训练神经网络时,最常用的算法是反向传播。 在该算法中,参数(模型权重)根据损失函数相对于给定参数的梯度进行调整。为了计算这些梯度,PyTorch 有一个名为 torch.autograd 的内置微分引擎。 它支持任何计算图的自动梯度计算。

自定义梯度计算结果以及运行时间

对Model_MLP_L2_V2进行下列更改:

class Model_MLP_L2_V2(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(Model_MLP_L2_V2, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

normal_(self.fc1.weight, mean=0., std=1.)

constant_(self.fc1.bias, val=0.0)

self.fc2 = nn.Linear(hidden_size, output_size)

normal_(self.fc2.weight, mean=0., std=1.)

constant_(self.fc2.bias, val=0.0)

self.act_fn = torch.sigmoid

# 前向计算

def forward(self, inputs):

z1 = self.fc1(inputs)

a1 = self.act_fn(z1)

z2 = self.fc2(a1)

a2 = self.act_fn(z2)

return a2

def zidingback(self, grads):

grad_input = torch.multiply(self.outputs, (1.0 - self.outputs))

return torch.multiply((grads, grad_input))

def zidingback(self):

loss = -1.0 * (self.labels / self.predicts - (1 - self.labels) / (1 - self.predicts)) / self.num

self.model.zidingback(loss)运行结果:

自动梯度计算结果以及运行时间

由结果对比可知,自定义梯度计算的准确率要比自动梯度计算低,而自定义梯度计算所花费的时间却比自动梯度计算要小。

4.4 优化问题

在本节中,我们通过实践来发现神经网络模型的优化问题,并思考如何改进。

4.4.1 参数初始化

实现一个神经网络前,需要先初始化模型参数。如果对每一层的权重和偏置都用0初始化,那么通过第一遍前向计算,所有隐藏层神经元的激活值都相同;在反向传播时,所有权重的更新也都相同,这样会导致隐藏层神经元没有差异性,出现对称权重现象。

接下来,将模型参数全都初始化为0,看实验结果。这里重新定义了一个类,两个线性层的参数全都初始化为0。

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch.nn.init import constant_, normal_, uniform_

class Model_MLP_L2_V4(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(Model_MLP_L2_V4, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

constant_(self.fc1.weight, val=0.0)

constant_(self.fc1.bias, val=0.0)

self.fc2 = nn.Linear(hidden_size, output_size)

constant_(self.fc2.weight, val=0.0)

constant_(self.fc2.bias, val=0.0)

self.act_fn = torch.sigmoid

# 前向计算

def forward(self, inputs):

z1 = self.fc1(inputs)

a1 = self.act_fn(z1)

z2 = self.fc2(a1)

a2 = self.act_fn(z2)

return a2

def print_weights(runner):

print('The weights of the Layers:')

for item in runner.model.named_parameters():

print(item)利用Runner类训练模型:

# 设置模型

input_size = 2

hidden_size = 5

output_size = 1

model = Model_MLP_L2_V4(input_size=input_size, hidden_size=hidden_size, output_size=output_size)

# 设置损失函数

loss_fn = F.binary_cross_entropy

# 设置优化器

learning_rate = 0.2 # 5e-2

optimizer = torch.optim.SGD(model.parameters(), learning_rate)

# 设置评价指标

metric = accuracy

# 其他参数

epoch = 2000

saved_path = 'best_model.pdparams'

# 实例化RunnerV2类,并传入训练配置

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=5, log_epochs=50, save_path="best_model.pdparams", custom_print_log=print_weights)运行结果:

The weights of the Layers:

('fc1.weight', Parameter containing:

tensor([[0., 0.],

[0., 0.],

[0., 0.],

[0., 0.],

[0., 0.]], requires_grad=True))

('fc1.bias', Parameter containing:

tensor([0., 0., 0., 0., 0.], requires_grad=True))

('fc2.weight', Parameter containing:

tensor([[0., 0., 0., 0., 0.]], requires_grad=True))

('fc2.bias', Parameter containing:

tensor([0.], requires_grad=True))

[Evaluate] best accuracy performence has been updated: 0.00000 --> 0.47500

[Train] epoch: 0/5, loss: 0.6931473016738892

The weights of the Layers:

('fc1.weight', Parameter containing:

tensor([[0., 0.],

[0., 0.],

[0., 0.],

[0., 0.],

[0., 0.]], requires_grad=True))

('fc1.bias', Parameter containing:

tensor([0., 0., 0., 0., 0.], requires_grad=True))

('fc2.weight', Parameter containing:

tensor([[-1.1642e-11, -1.1642e-11, -1.1642e-11, -1.1642e-11, -1.1642e-11]],

requires_grad=True))

('fc2.bias', Parameter containing:

tensor([-1.8626e-10], requires_grad=True))

The weights of the Layers:

('fc1.weight', Parameter containing:

tensor([[-1.4122e-13, 1.0458e-13],

[-1.4122e-13, 1.0458e-13],

[-1.4122e-13, 1.0458e-13],

[-1.4122e-13, 1.0458e-13],

[-1.4122e-13, 1.0458e-13]], requires_grad=True))

('fc1.bias', Parameter containing:

tensor([5.0822e-22, 5.0822e-22, 5.0822e-22, 5.0822e-22, 0.0000e+00],

requires_grad=True))

('fc2.weight', Parameter containing:

tensor([[-2.3283e-11, -2.3283e-11, -2.3283e-11, -2.3283e-11, -2.3283e-11]],

requires_grad=True))

('fc2.bias', Parameter containing:

tensor([-3.7253e-10], requires_grad=True))

The weights of the Layers:

('fc1.weight', Parameter containing:

tensor([[-4.2366e-13, 3.1373e-13],

[-4.2366e-13, 3.1373e-13],

[-4.2366e-13, 3.1373e-13],

[-4.2366e-13, 3.1373e-13],

[-4.2366e-13, 3.1373e-13]], requires_grad=True))

('fc1.bias', Parameter containing:

tensor([1.5247e-21, 1.5247e-21, 1.5247e-21, 1.5247e-21, 0.0000e+00],

requires_grad=True))

('fc2.weight', Parameter containing:

tensor([[-3.4925e-11, -3.4925e-11, -3.4925e-11, -3.4925e-11, -3.4925e-11]],

requires_grad=True))

('fc2.bias', Parameter containing:

tensor([-5.5879e-10], requires_grad=True))

The weights of the Layers:

('fc1.weight', Parameter containing:

tensor([[-8.4732e-13, 6.2746e-13],

[-8.4732e-13, 6.2746e-13],

[-8.4732e-13, 6.2746e-13],

[-8.4732e-13, 6.2746e-13],

[-8.4732e-13, 6.2746e-13]], requires_grad=True))

('fc1.bias', Parameter containing:

tensor([1.5247e-21, 1.5247e-21, 1.5247e-21, 1.5247e-21, 0.0000e+00],

requires_grad=True))

('fc2.weight', Parameter containing:

tensor([[-4.6566e-11, -4.6566e-11, -4.6566e-11, -4.6566e-11, -4.6566e-11]],

requires_grad=True))

('fc2.bias', Parameter containing:

tensor([-7.4506e-10], requires_grad=True))

Process finished with exit code 0

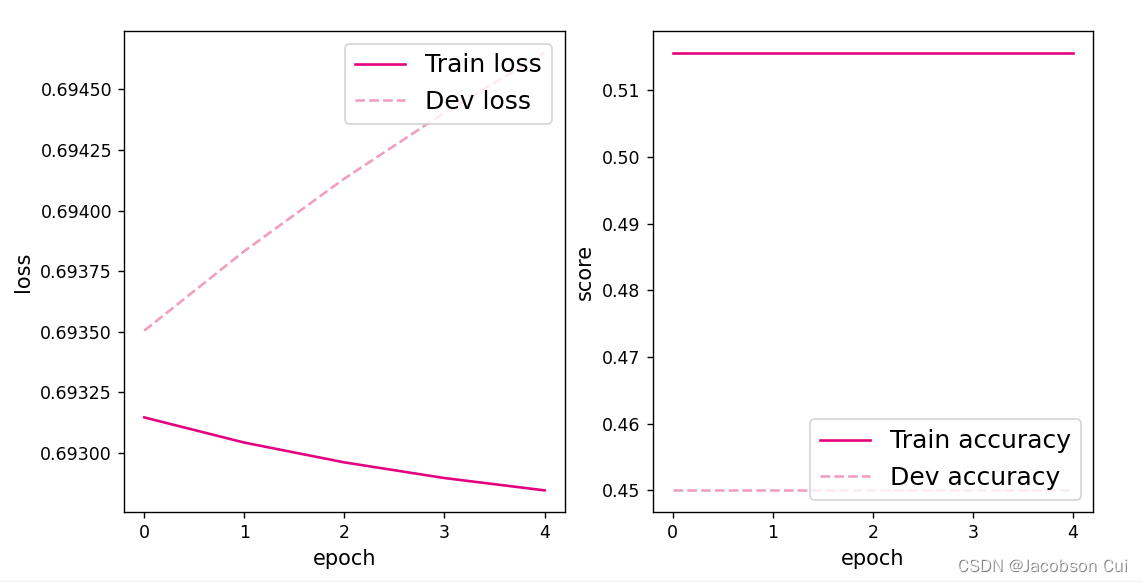

可视化训练和验证集上的主准确率和loss变化:

def plot(runner, fig_name):

plt.figure(figsize=(10, 5))

epochs = [i for i in range(len(runner.train_scores))]

plt.subplot(1, 2, 1)

plt.plot(epochs, runner.train_loss, color='#e4007f', label="Train loss")

plt.plot(epochs, runner.dev_loss, color='#f19ec2', linestyle='--', label="Dev loss")

# 绘制坐标轴和图例

plt.ylabel("loss", fontsize='large')

plt.xlabel("epoch", fontsize='large')

plt.legend(loc='upper right', fontsize='x-large')

plt.subplot(1, 2, 2)

plt.plot(epochs, runner.train_scores, color='#e4007f', label="Train accuracy")

plt.plot(epochs, runner.dev_scores, color='#f19ec2', linestyle='--', label="Dev accuracy")

# 绘制坐标轴和图例

plt.ylabel("score", fontsize='large')

plt.xlabel("epoch", fontsize='large')

plt.legend(loc='lower right', fontsize='x-large')

plt.savefig(fig_name)

plt.show()

plot(runner, "fw-zero.pdf")运行结果:

从输出结果看,二分类准确率为50%左右,说明模型没有学到任何内容。训练和验证loss几乎没有怎么下降。

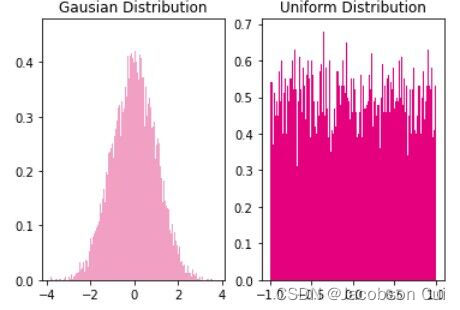

为了避免对称权重现象,可以使用高斯分布或均匀分布初始化神经网络的参数。

高斯分布和均匀分布采样的实现和可视化代码如下:

gausian_weights = torch.normal(mean=0.0, std=1.0, size=[10000])

uniform_weights = torch.Tensor(10000)

uniform_weights.uniform_(-1, 1)

# 绘制两种参数分布

plt.figure()

plt.subplot(1, 2, 1)

plt.title('Gausian Distribution')

plt.hist(gausian_weights, bins=200, density=True, color='#f19ec2')

plt.subplot(1, 2, 2)

plt.title('Uniform Distribution')

plt.hist(uniform_weights, bins=200, density=True, color='#e4007f')

plt.savefig('fw-gausian-uniform.pdf')

plt.show()运行结果:

4.4.2 梯度消失问题

在神经网络的构建过程中,随着网络层数的增加,理论上网络的拟合能力也应该是越来越好的。但是随着网络变深,参数学习更加困难,容易出现梯度消失问题。

由于Sigmoid型函数的饱和性,饱和区的导数更接近于0,误差经过每一层传递都会不断衰减。当网络层数很深时,梯度就会不停衰减,甚至消失,使得整个网络很难训练,这就是所谓的梯度消失问题。

在深度神经网络中,减轻梯度消失问题的方法有很多种,一种简单有效的方式就是使用导数比较大的激活函数,如:ReLU。

下面通过一个简单的实验观察前馈神经网络的梯度消失现象和改进方法。

4.4.2.1 模型构建

定义一个前馈神经网络,包含4个隐藏层和1个输出层,通过传入的参数指定激活函数。代码实现如下:

a = torch.Tensor(10000)

class Model_MLP_L5(nn.Module):

def __init__(self, input_size, output_size, act='sigmoid', w_init=normal_(a, mean=0.0, std=0.01), b_init=constant_(a, val=1.0)):

super(Model_MLP_L5, self).__init__()

self.fc1 = torch.nn.Linear(input_size, 3)

self.fc2 = torch.nn.Linear(3, 3)

self.fc3 = torch.nn.Linear(3, 3)

self.fc4 = torch.nn.Linear(3, 3)

self.fc5 = torch.nn.Linear(3, output_size)

# 定义网络使用的激活函数

if act == 'sigmoid':

self.act = torch.sigmoid

elif act == 'relu':

self.act = F.relu

elif act == 'lrelu':

self.act = F.leaky_relu

else:

raise ValueError("Please enter sigmoid relu or lrelu!")

# 初始化线性层权重和偏置参数

self.init_weights(w_init, b_init)

# 初始化线性层权重和偏置参数

def init_weights(self, w_init, b_init):

# 使用'named_sublayers'遍历所有网络层

for n, m in self.named_parameters():

# 如果是线性层,则使用指定方式进行参数初始化

if isinstance(m, nn.Linear):

w_init(m.weight)

b_init(m.bias)

def forward(self, inputs):

outputs = self.fc1(inputs)

outputs = self.act(outputs)

outputs = self.fc2(outputs)

outputs = self.act(outputs)

outputs = self.fc3(outputs)

outputs = self.act(outputs)

outputs = self.fc4(outputs)

outputs = self.act(outputs)

outputs = self.fc5(outputs)

outputs = torch.sigmoid(outputs)

return outputs4.4.2.2 使用Sigmoid型函数进行训练

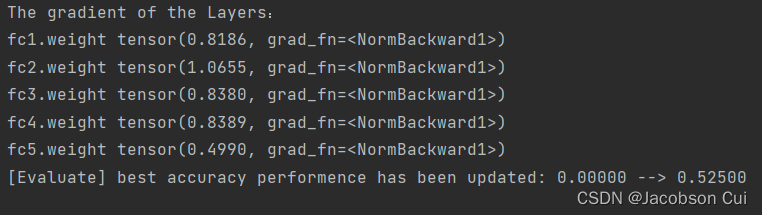

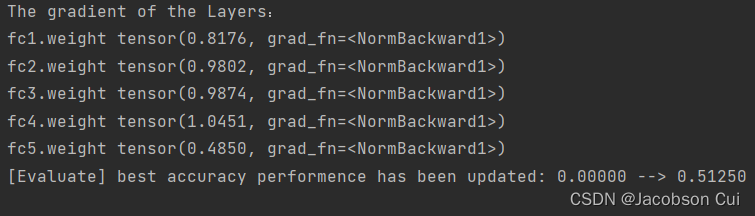

使用Sigmoid型函数作为激活函数,为了便于观察梯度消失现象,只进行一轮网络优化。代码实现如下:

定义梯度打印函数

def print_grads(runner):

# 打印每一层的权重的模

print('The gradient of the Layers:')

for name, item in runner.model.named_parameters():

if len(item.size()) == 2:

print(name, torch.norm(input=item, p=2))

# 学习率大小

lr = 0.01

# 定义网络,激活函数使用sigmoid

model = Model_MLP_L5(input_size=2, output_size=1, act='sigmoid')

# 定义优化器

optimizer = torch.optim.SGD(lr=lr, params=model.parameters())

# 定义损失函数,使用交叉熵损失函数

loss_fn = F.binary_cross_entropy

# 定义评价指标

metric = accuracy

# 指定梯度打印函数

custom_print_log=print_grads

# 实例化Runner类

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

# 启动训练

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=1, log_epochs=None, save_path="best_model.pdparams", custom_print_log=custom_print_log)实例化RunnerV2_2类,并传入训练配置。代码实现如下:

# 实例化Runner类

runner = RunnerV2_2(model, optimizer, metric, loss_fn)模型训练,打印网络每层梯度值的ℓ2范数。代码实现如下:

# 启动训练

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=1, log_epochs=None, save_path="best_model.pdparams", custom_print_log=custom_print_log)运行结果:

观察实验结果可以发现,梯度经过每一个神经层的传递都会不断衰减,最终传递到第一个神经层时,梯度几乎完全消失。

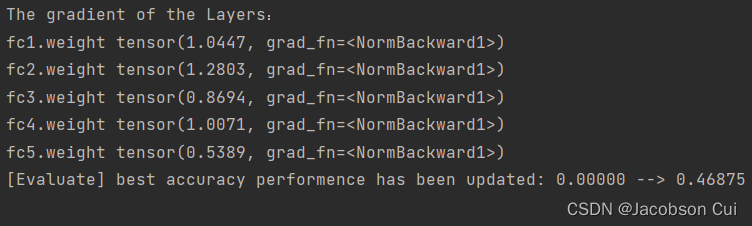

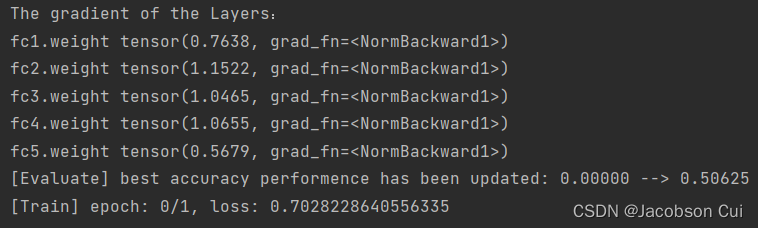

4.4.2.3 使用ReLU函数进行模型训练

torch.manual_seed(102)

lr = 0.01 # 学习率大小

# 定义网络,激活函数使用relu

model = Model_MLP_L5(input_size=2, output_size=1, act='relu')

# 定义优化器

optimizer = torch.optim.SGD(lr=lr, params=model.parameters())

# 定义损失函数

# 定义损失函数,这里使用交叉熵损失函数

loss_fn = F.binary_cross_entropy

# 定义评估指标

metric = accuracy

# 实例化Runner

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

# 启动训练

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=1, log_epochs=None, save_path="best_model.pdparams", custom_print_log=custom_print_log)运行结果:

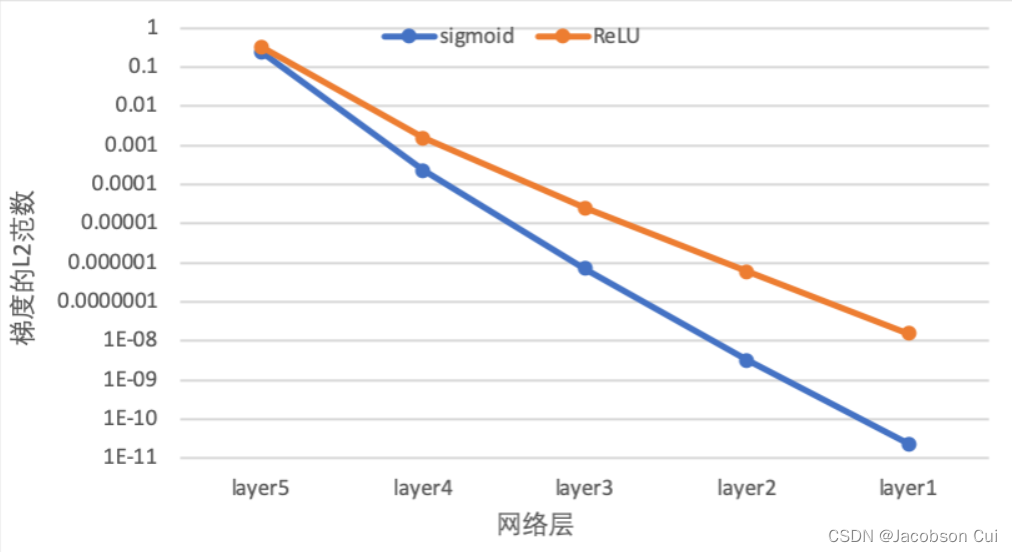

下图展示了使用不同激活函数时,网络每层梯度值的ℓ2范数情况。从结果可以看到,5层的全连接前馈神经网络使用Sigmoid型函数作为激活函数时,梯度经过每一个神经层的传递都会不断衰减,最终传递到第一个神经层时,梯度几乎完全消失。改为ReLU激活函数后,梯度消失现象得到了缓解,每一层的参数都具有梯度值。

4.4.3 死亡 ReLU 问题

ReLU激活函数可以一定程度上改善梯度消失问题,但是ReLU函数在某些情况下容易出现死亡 ReLU问题,使得网络难以训练。这是由于当x<0时,ReLU函数的输出恒为0。在训练过程中,如果参数在一次不恰当的更新后,某个ReLU神经元在所有训练数据上都不能被激活(即输出为0),那么这个神经元自身参数的梯度永远都会是0,在以后的训练过程中永远都不能被激活。而一种简单有效的优化方式就是将激活函数更换为Leaky ReLU、ELU等ReLU的变种。

4.4.3.1 使用ReLU进行模型训练

使用第4.4.2节中定义的多层全连接前馈网络进行实验,使用ReLU作为激活函数,观察死亡ReLU现象和优化方法。当神经层的偏置被初始化为一个相对于权重较大的负值时,可以想像,输入经过神经层的处理,最终的输出会为负值,从而导致死亡ReLU现象。

# 定义网络,并使用较大的负值来初始化偏置

model = Model_MLP_L5(input_size=2, output_size=1, act='relu', b_init=constant_(a, val=-8.0))实例化RunnerV2类,启动模型训练,打印网络每层梯度值的ℓ2ℓ2范数。代码实现如下:

# 实例化Runner类

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

# 启动训练

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=1, log_epochs=0, save_path="best_model.pdparams", custom_print_log=custom_print_log)运行结果:

从输出结果可以发现,使用 ReLU 作为激活函数,当满足条件时,会发生死亡ReLU问题,网络训练过程中 ReLU 神经元的梯度始终为0,参数无法更新。

针对死亡ReLU问题,一种简单有效的优化方式就是将激活函数更换为Leaky ReLU、ELU等ReLU 的变种。接下来,观察将激活函数更换为 Leaky ReLU时的梯度情况。

4.4.3.2 使用Leaky ReLU进行模型训练

将激活函数更换为Leaky ReLU进行模型训练,观察梯度情况。代码实现如下:

# 重新定义网络,使用Leaky ReLU激活函数

model = Model_MLP_L5(input_size=2, output_size=1, act='lrelu', b_init=constant_(a, val=-8.0))

# 实例化Runner类

runner = RunnerV2_2(model, optimizer, metric, loss_fn)

# 启动训练

runner.train([X_train, y_train], [X_dev, y_dev], num_epochs=1, log_epochps=None, save_path="best_model.pdparams", custom_print_log=custom_print_log)运行结果:

从输出结果可以看到,将激活函数更换为Leaky ReLU后,死亡ReLU问题得到了改善,梯度恢复正常,参数也可以正常更新。但是由于 Leaky ReLU 中,x<0时的斜率默认只有0.01,所以反向传播时,随着网络层数的加深,梯度值越来越小。如果想要改善这一现象,将 Leaky ReLU 中,x<0时的斜率调大即可。

总结

通过本次实验的内容,详细学习了torch.nn.Module的使用,以及自定义梯度计算和自动梯度计算之间的区别。通过神经网络模型的优化问题,学到了其改进的方法。

参考资料

1、【细聊】torch.nn.init 初始化_ViatorSun的博客-CSDN博客

2、NNDL 实验4(上) – HBU_DAVID – 博客园 (cnblogs.com)

文章出处登录后可见!