一、概述

1. 事件抽取是信息抽取中的关键任务;

2. 事件知识是一种非常重要的知识形式,是行业智能应用的重要基础;

3. 现有知识图谱要以实体为核心,边是实体间的关系,缺少事件知识的内容;

4. 事件抽取是信息抽取的难点问题

事件抽取依赖实体抽取和关系抽取;

相较于实体抽取和关系抽取,事件抽取的难度更大;

目前对事件还没有统一的定义,在不同领域针对不同应用不同人对事件有不同的描述;

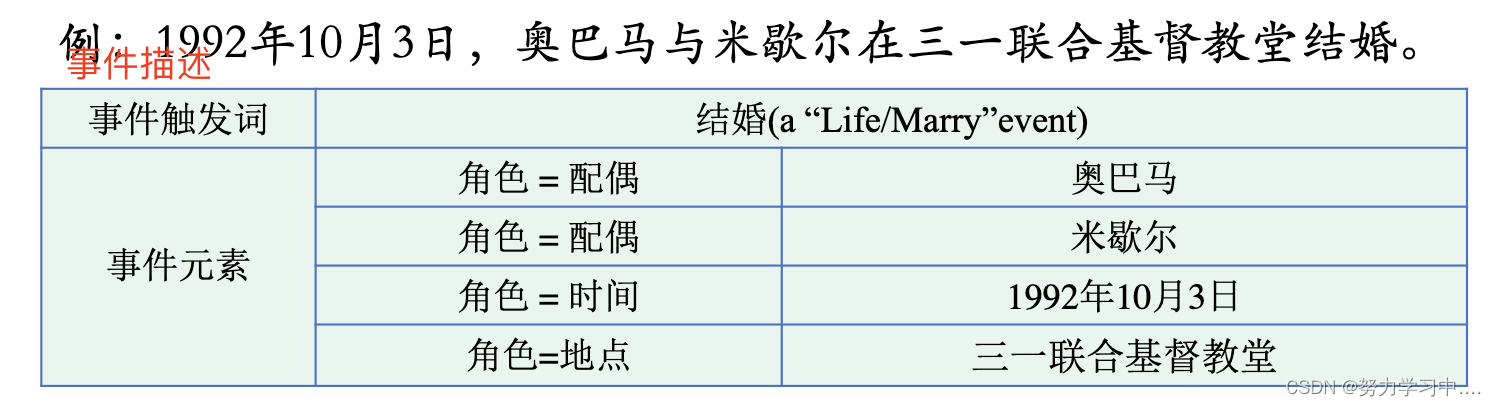

5. 信息抽取中事件的定义

事件是发生在某个特定的时间段、某个特定的地域范围内,由一个或者多个角色参与的一个或者多个动作组成的事件或者状态的改变。

事件类型: 不同动作或者状态的改变代表不同类型的事件;

事件元素: 同一类型的事件中不同的时间、地点、元素代表了不同的时间实例;

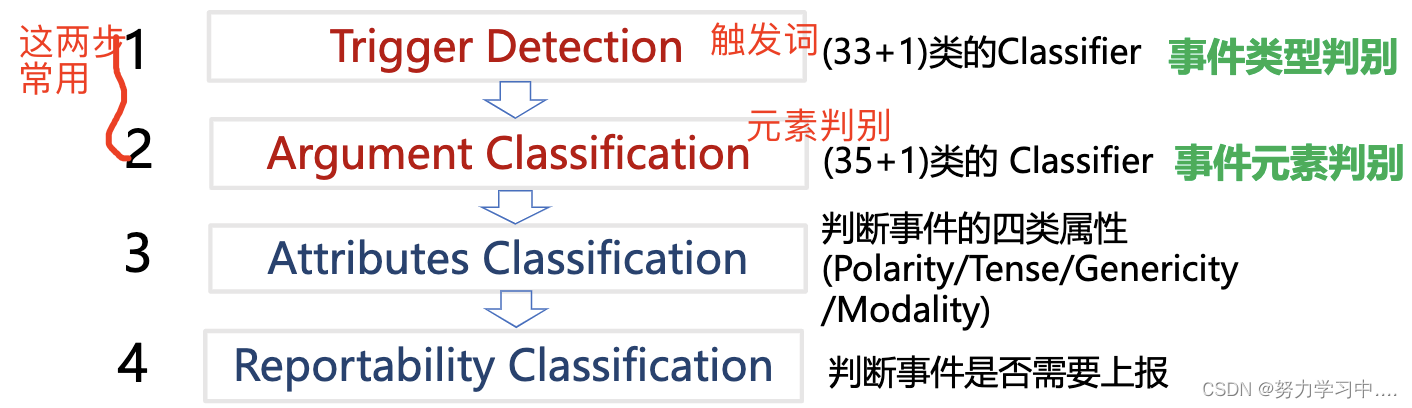

6. 事件抽取任务

从自然语言文本中抽取事件信息并以结构化的形式呈现出来;

相关术语: 事件描述(event mention), 事件触发词(event trigger), 事件元素(event argument), 元素角色(Aggument role)

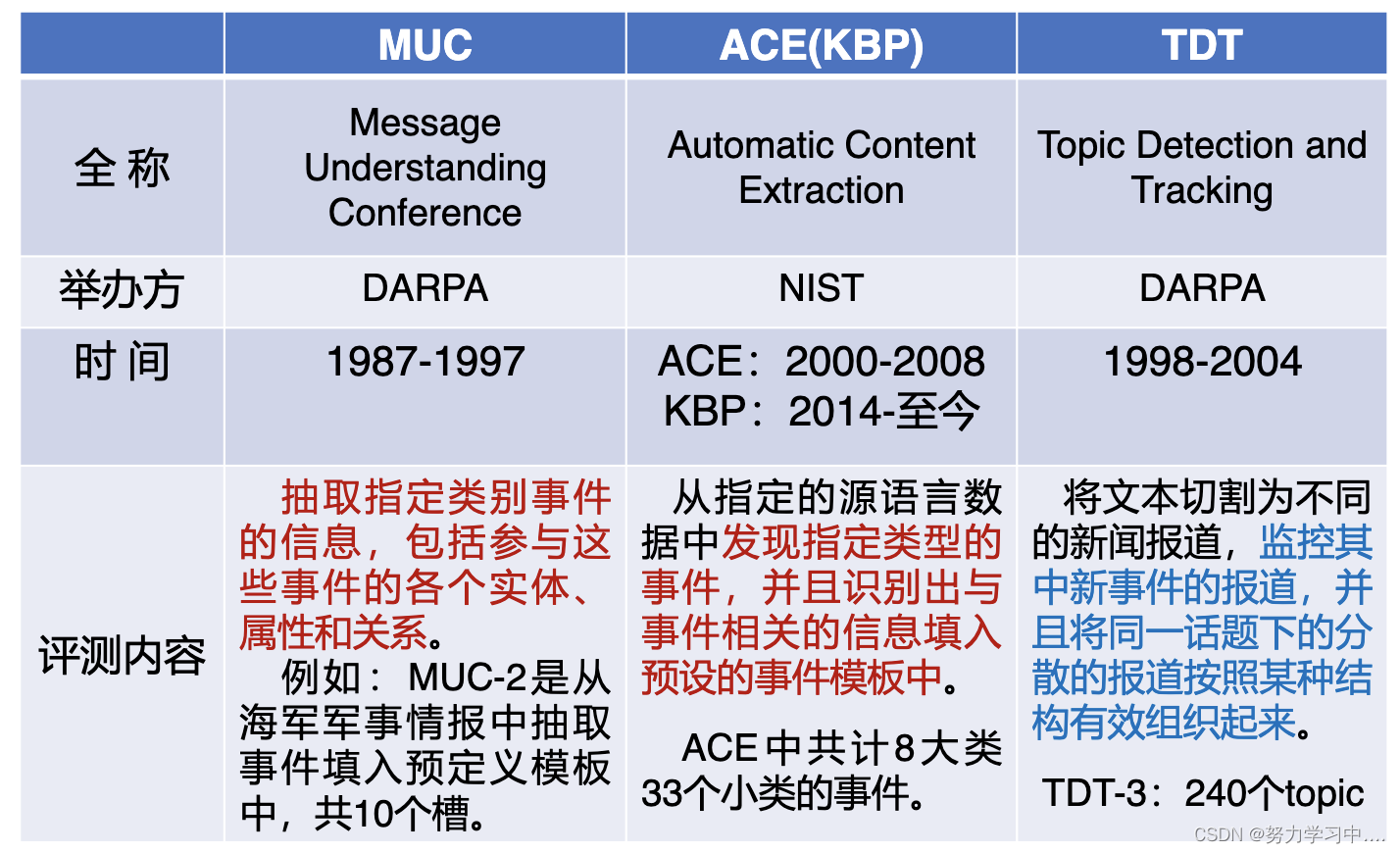

7. 事件抽取评测及语料

8. 事件抽取研究的维度

事件类别是否预定义

限定类别事件抽取

开放式事件抽取

抽取的方法

基于模式匹配的事件抽取

基于机器学习的事件抽取

文本粒度

句子级事件抽取

篇章级事件抽取

文本类型

新闻、微博、论坛

二、限定类别事件抽取

1 基于机器学习的方法

1. 基于神经网络的方法

主要问题: 如何设计合理的网络结构,从而捕捉到更多的信息,进而准确地进行事件抽取;

网络结构: 不同的网络结构捕捉文本中不同的信息;

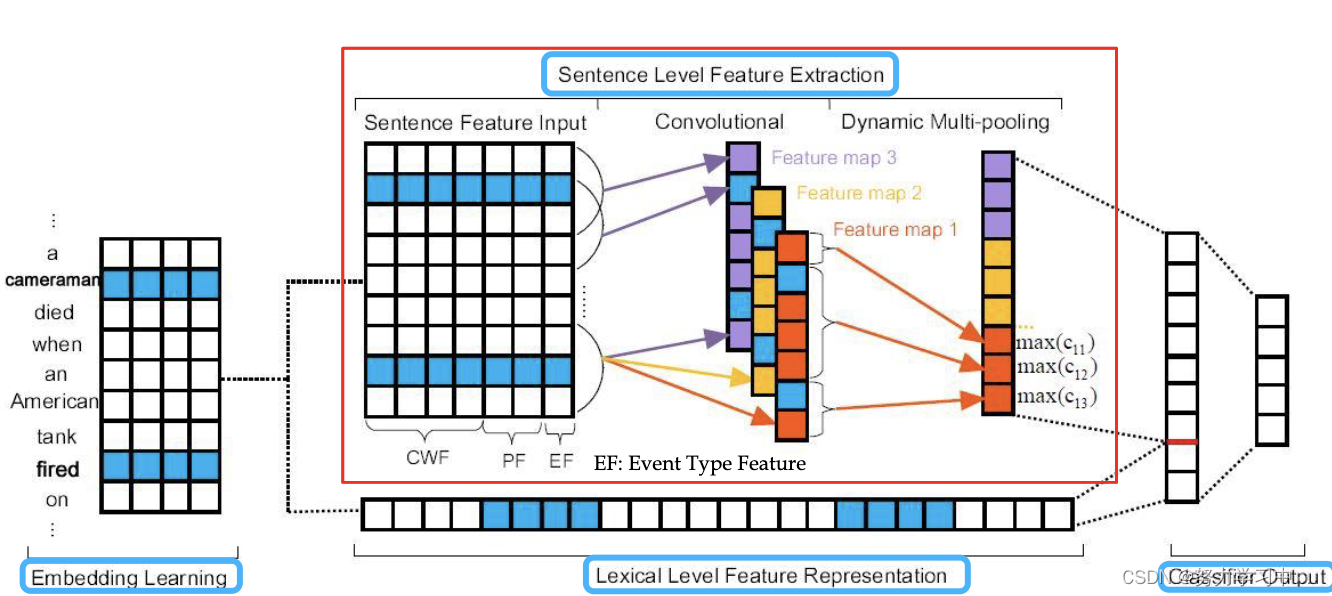

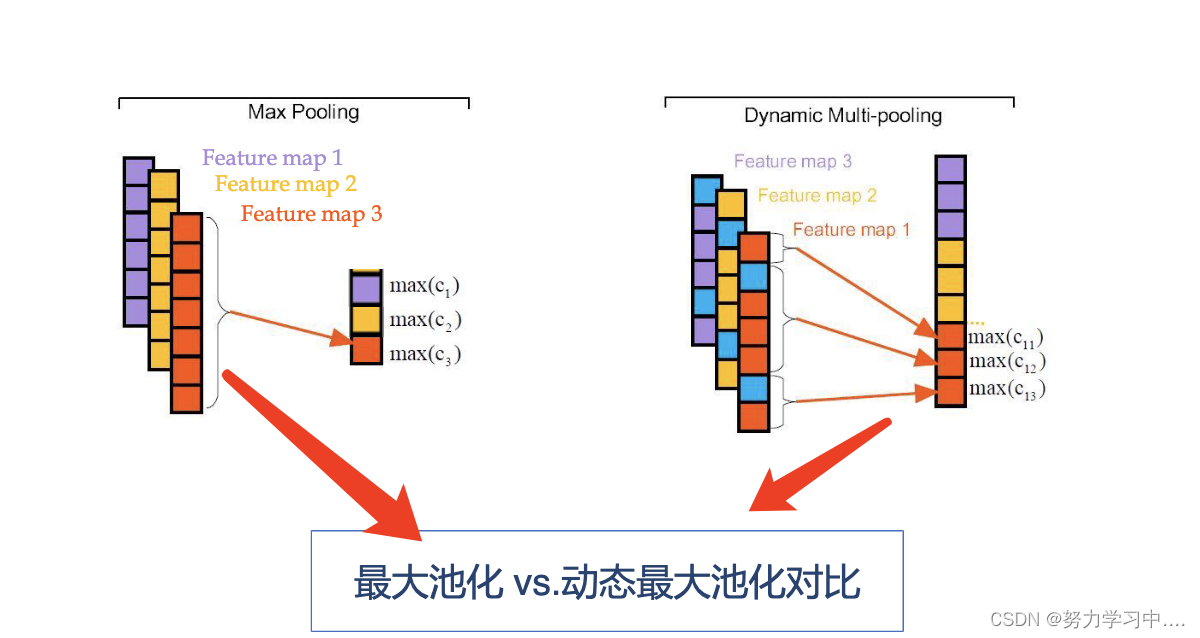

2. 基于动态最大池化技术的卷积神经网络

任务: Trigger识别(事件分类)+ Argument识别(要素填充)

动机: 传统方法主要提取两类特征: 词汇特征和句子特征

词汇特征:过于依赖人工,是一种独热表示,缺乏语义;

句子特征: 用到复杂的NLP工具,引起错误传递;

方法: 将事件抽取看成两个阶段的多分类问题

触发词分类:根据句中的事件触发词进行事件分类;

事件元素分类: 为每个事件触发词寻找事件元素,并判断元素在事件中扮演的角色。

以下以事件元素分类为例说明基于动态卷积神经网络(因为同一个句子可能有多个触发词候选及其事件元素候选,分段的位置点是动态变化的,所以是动态分段最大池化)的事件抽取过程:

用于事件元素分类的网络结构:由四部分组成

word-embedding learning;

lexical-level feature representation;

sentence-level feature extraction;

argument classifier output;

三个卷积核

论文:Yubo Chen , et al. " Event Extraction via Dynamic Multi-Pooling Convolutional Neural Network" . ACL 2015

3. 事件语料自动生成

现有方法的问题:有监督的事件抽取方法:依赖人工标注数据;

ACE2005的英文数据中,事件类型总共8大类33个小类,人工标注的事件抽取训练集共599篇文档;

60%的类别对应标注数据不足100个,甚至其中3个事件类型标注数据不到10个。

无监督的事件抽取方法:抽取的结果没有规范的语义标签,很难直接映射到现有知识库。

动机: 自动生成标注语料;开放域环境;大规模自动抽取;

远距离监督方法在关系抽取中取得成功

难点:

现有事件知识库中缺少触发词信息;

事件元素并不都是必须出现(知识库中只有60%的事件实例包含所有的事件元素);

一个事件的多个元素可以出现在多个句子中(只有0.02%的事件实例能在一句话中找到所有的事件元素);

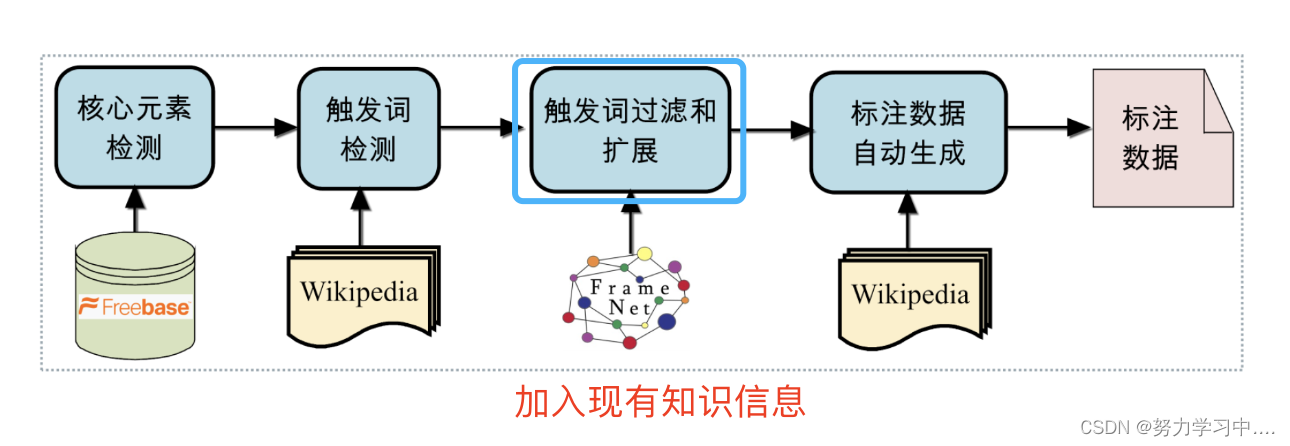

方法:

利用世界知识和语言学知识;自动生成大规模事件语料

论文:Yubo Chen , et al. " Automatically Labeled Data Generation for Large Scale Event Extraction" . ACL 2017

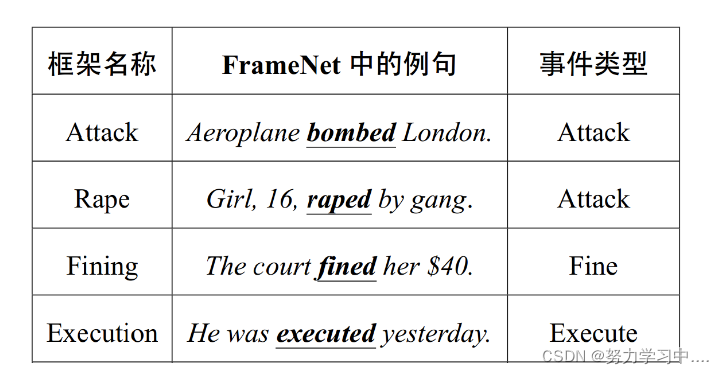

4. 基于FrameNet事件语料自动生成

动机:基于利用FrameNet中的框架及其标注例句扩充事件抽取训练集;

FrameNet: 语言学家定义及标注的语义框架资源;层级的组织结构;

FrameNet规模:1000+ 框架;10000+ 词法单元;150000+ 标注例句。

事件语料与框架知识库

结构相似性: 一个词法单元的若干框架元素;

事件:一个触发词和若干事件角色;

含义相似性:

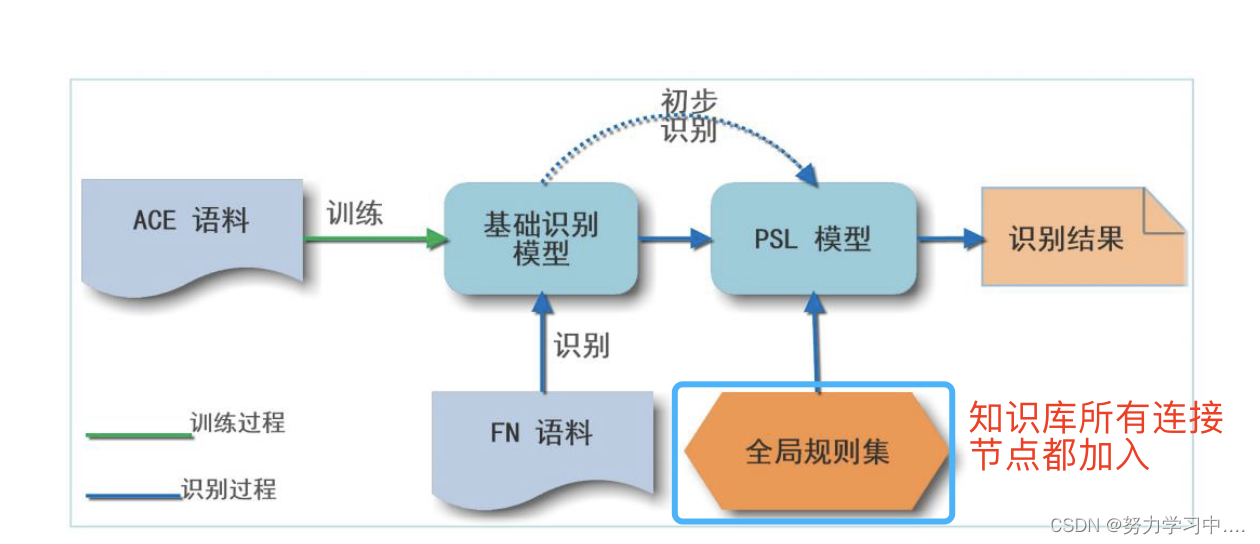

系统框架图:

第一步:利用ACE语料进行训练,得到基础的事件识别模型;

第二步:利用基础模型在framenet数据上进行事件识别;

第三步:基于逻辑软概率,利用全局规则对第二步的识别结果进行校正,得到最终扩充的语料。

论文:Shulin Liu, et al. " Leveraging FrameNet to Improve Automatic Event Detection" . ACL 2016

5. 基于篇章级金融事件抽取

标注数据的确实:现有事件抽取系统性能都高度依赖人工标注数据;

人工标注数据耗时费力,成本高昂,金融领域缺乏大规模高质量的标注数据;

篇章级事件抽取:目前大多数事件抽取系统都是针对一个句子进行抽取;

通常由多个句子描述一个事件,一个事件的多个元素分布在不同的句子中;

句子级事件抽取:用双向LSTM+CRF标注全句中的事件触发词和元素。

篇章级事件抽取:寻找篇章中的事件描述主句,并从周围的事件描述句子中补齐缺少的事件元素。

论文:Hang Yang, et al. " DCFEE: A Document-level Chinese Financial Event Extraction System based on Automatically Labeled Training Data" . EMNLP 2018

三、 开放域事件抽取

1. 特点:不预先定义事件类别和事件结构;

2. 代表性方法:

基于内容特征的事件抽取方法;

基于异常检测的事件抽取方法;

四、事件关系抽取

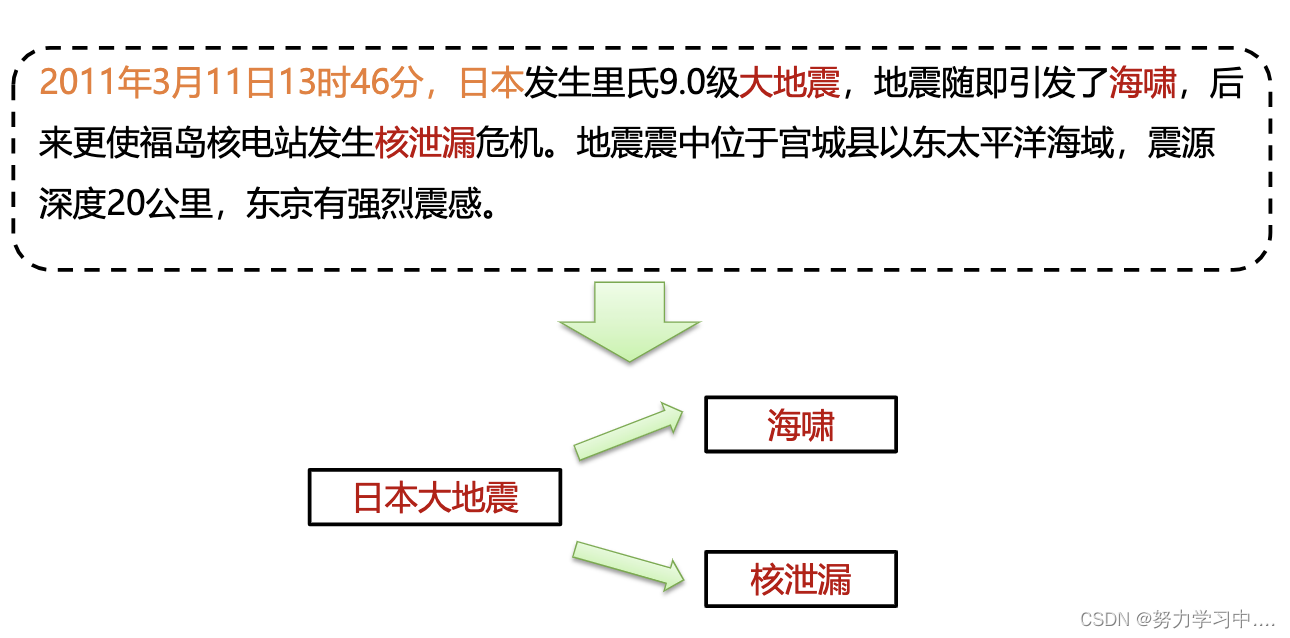

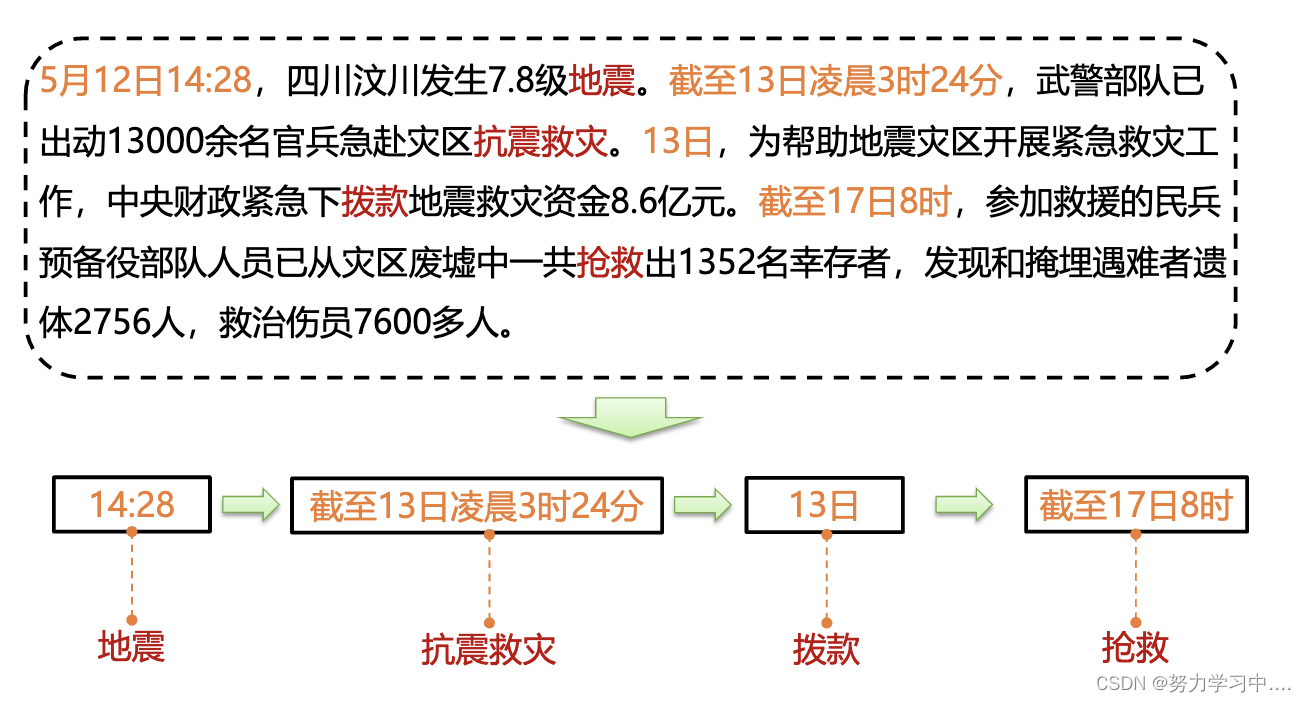

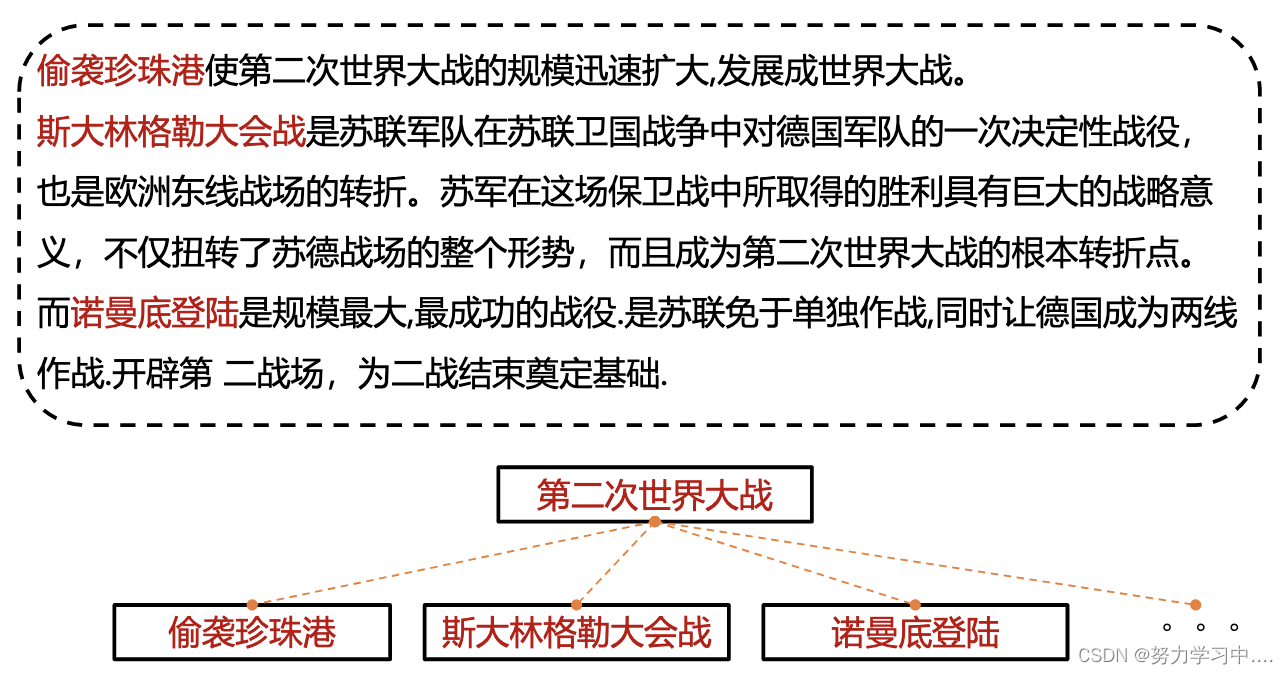

1. 因果关系、时序关系、子事件关系;

因果关系:

时序关系:

子事件关系:

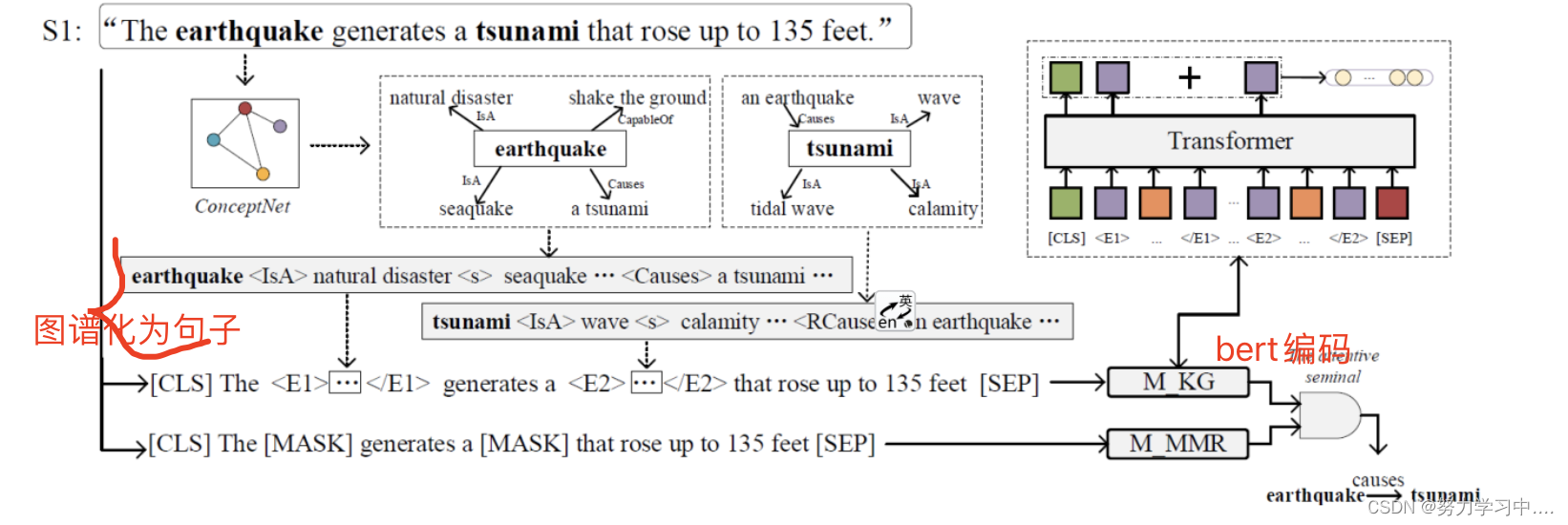

2. 融入外部知识的事件因果关系识别

因果关系识别:判定给定的事件对之间是否存在因果关系;

动机:现有方法仅依靠标注数据训练模型,忽略了背景知识,而背景知识有助于因果关系推理;现有的数据集规模较小,模型容易存在过拟合问题,泛化性能较差。

方法:主要有两个模块:知识感知推理器和事件屏蔽推理器;

事件感知推理器(Knowledge-Aware Reasoner): 首先从Concept Net中获取背景知识,一跳子图形式,将子图序列化然后使用BERT进行编码得到事件的知识表示;

事件屏蔽处理器(Mention Masking Reasoner): 将事件对用[MASK]替换,然后使用BERT进行编码,得到事件对的上下文表示;

将事件的知识表示和上下文表示拼接在一起进行预测;

论文:Jian Liu, et al. , Knowledge Enhanced Event Causality Identification with Mention Masking Generalizations, IJCAI 2020

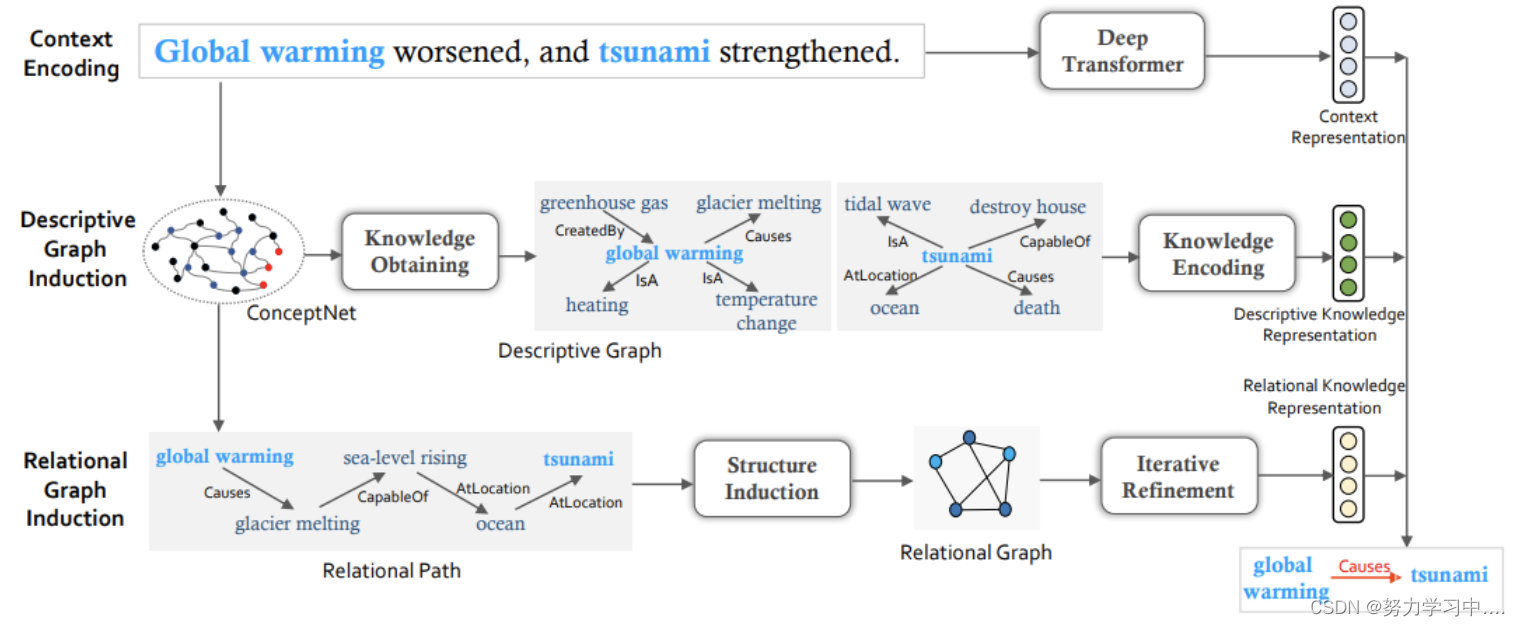

3. 基于隐式结构归纳网络的事件因果关系识别

动机:现有数据集规模较小,不足以充分训练神经网络模型。受人类认知的启发,利用背景知识(描述性知识和关联性知识)来增强事件因果关系识别模型;

描述性知识:关于事件的描述性或者解释性信息,这类知识可以告诉模型提及的事件是什么。在知识库中由事件的一跳邻居所构成;

关联性知识:在知识库中两个事件之间的联系,这类知识可以提供因果推理线索。在知识库中由事件之间的多跳路径所表示。

方法:

上下文编码模块:使用BERT编码句子,得到事件的上下文表示;

描述图归纳模块:先从ConceptNet中获取描述性知识,使用图神经网络进行编码,得到事件的描述性知识表示;

关联图归纳模块:先ConceptNet获取事件之间的多跳路径,然后将多跳路径转成关联图进行编码,得到事件的关联性知识表示;

将三种表示拼接在一起进行预测。

论文:Pengfei Cao, et al. , Knowledge-Enriched Event Causality Identification via Latent Structure Induction Networks, ACL 2021

五、多模态事件抽取

1. 图像事件抽取:给定图像识别出图像中的事件(情景)并且生成涉及的元素;

动机:现有的图像识别任务不够精细,不应该只关注图像中发生了什么更应该考虑涉及的元素有哪些,以及这些元素是如何组织在一起的,该工作提出了一个数据集situnet,推动相关研究。包含了500个动词框架,超过12万张标注图像。

论文:Mark Yatskar, et al. , Situation Recognition: Visual Semantic Role Labeling for Image Understanding, CVPR 2016

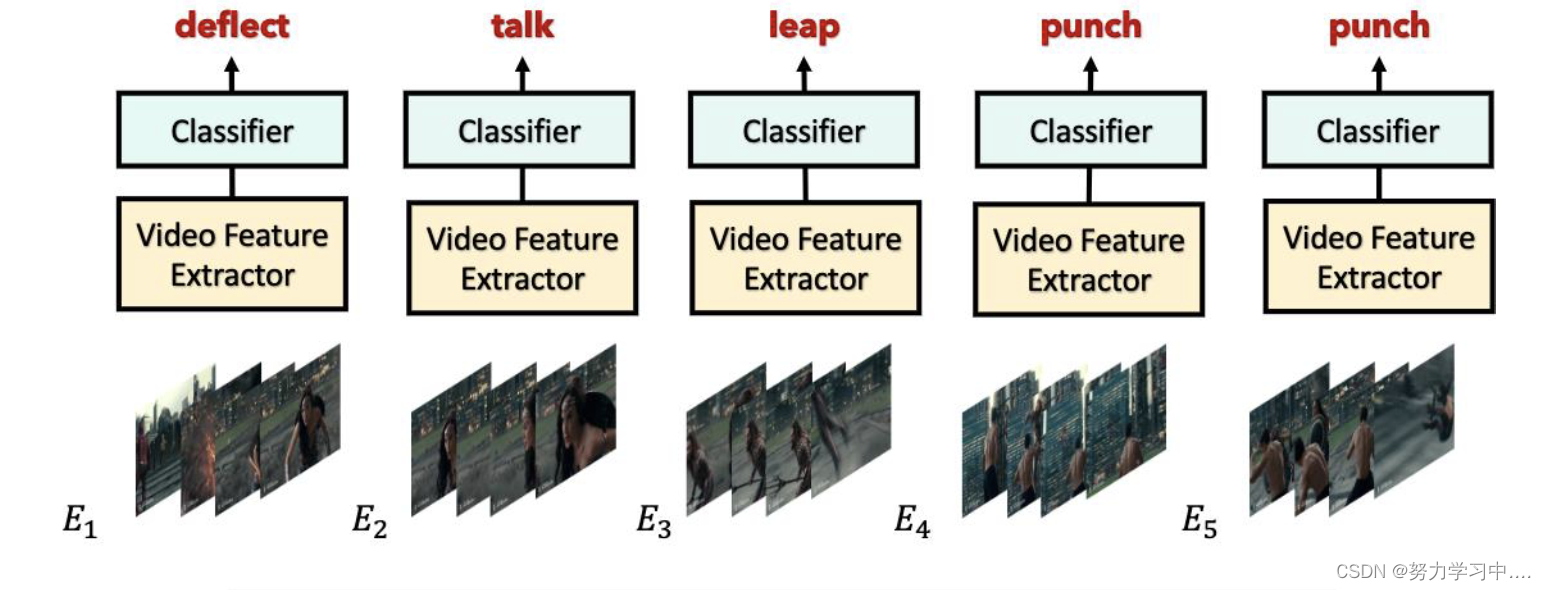

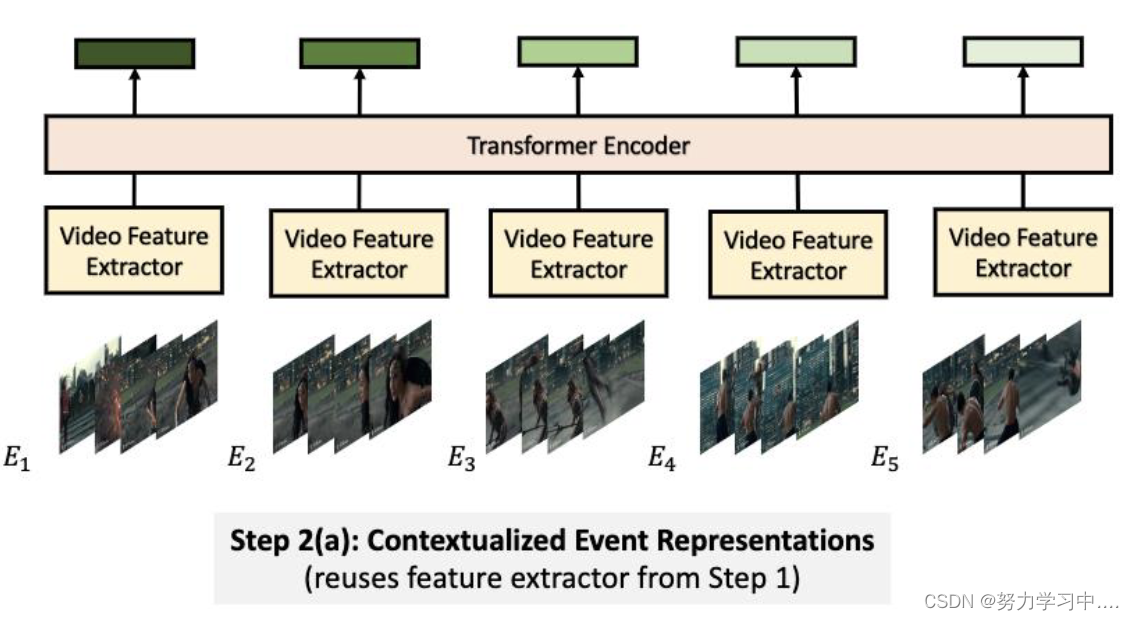

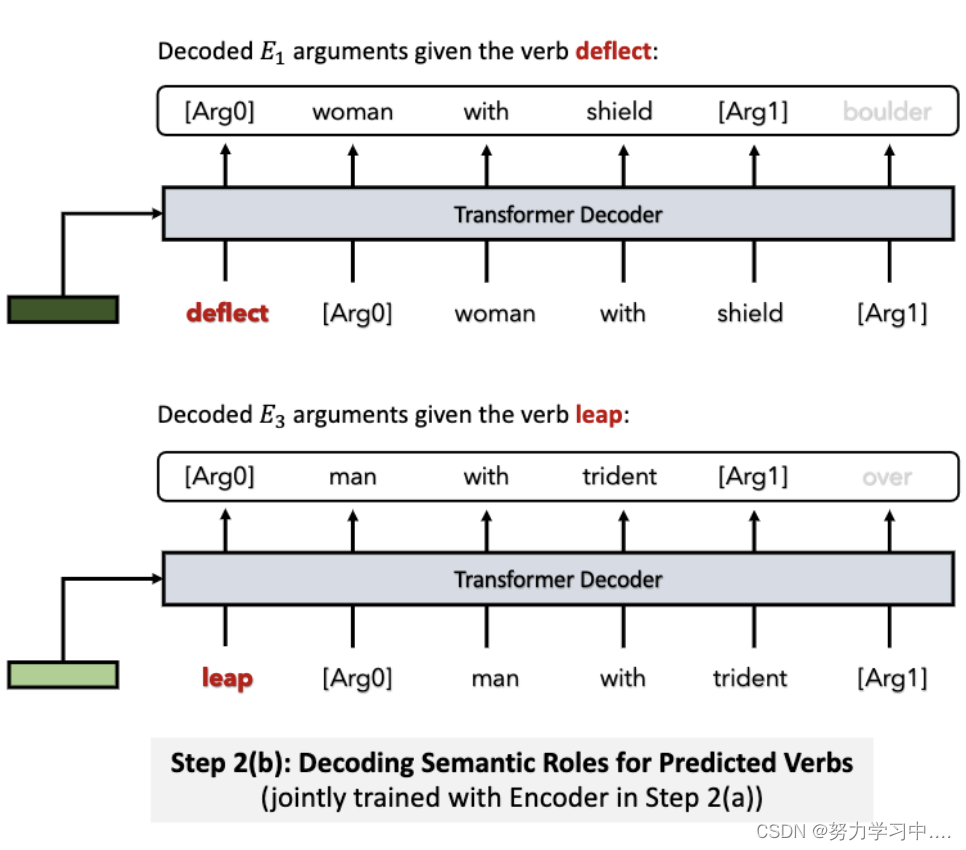

2. 视频事件抽取:给定一段视频,从视频中抽取出事件相关的信息;

动机:视频内容解析是非常重要的方向,已有的任务缺乏详细的框架定义;

已有的数据集缺少对视频中事件(动作)之间的共指消解,事件之间相互影响的标注;

该工作提出了一个全新的关于视频事件抽取的大规模数据集。

方法:视频动作类;(对于视频动作提取,该工作提出使用视频物体检测分类SOTA网络SlowFast作为特征提取器,拼接简单的分类器,对短视频中每2秒的视频进行动作(事件)分类)

视频动作元素提取;(根据视频动作分类的结果,和动作对应的框架,采用基于Transformer结构的EncoderDecoder网络,利用框架中的每个角色作为提示生成对应角色的元素)

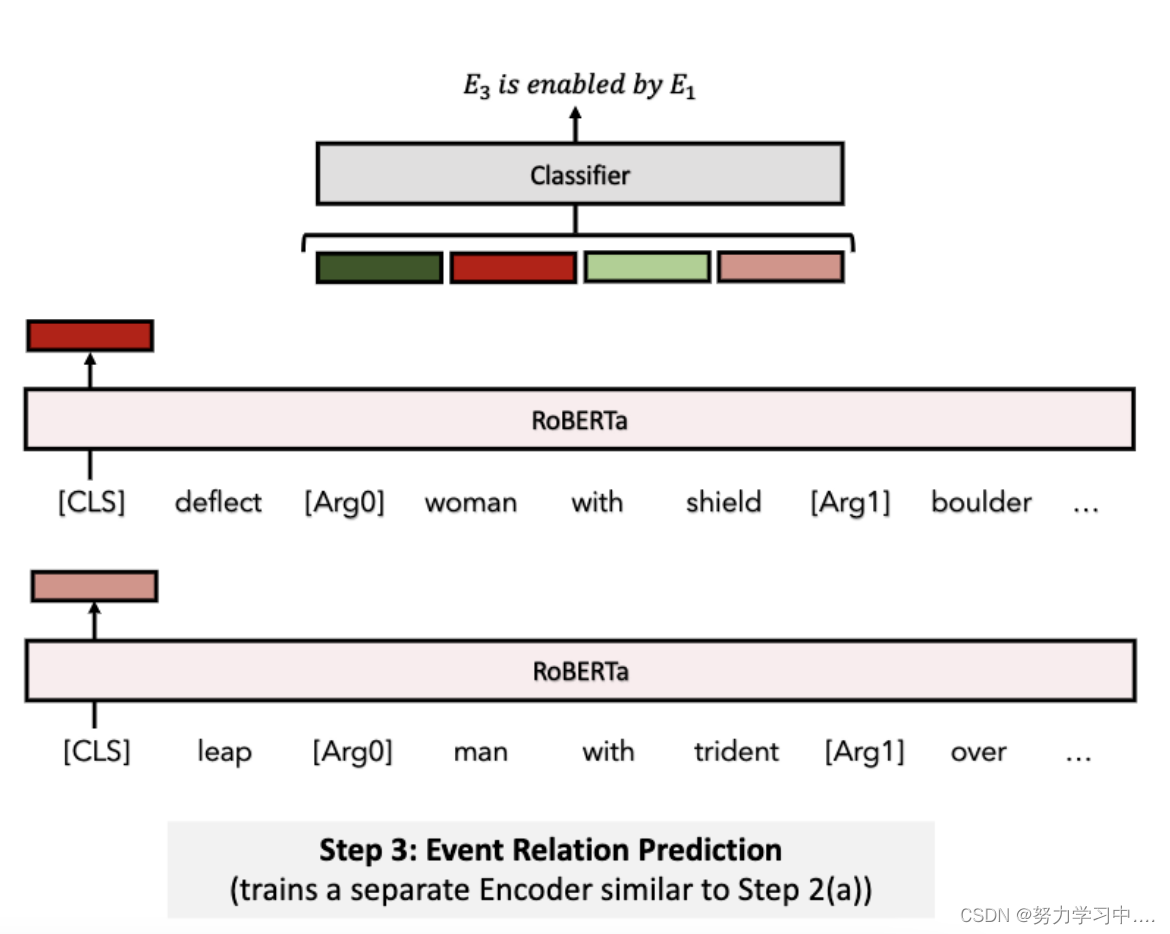

视频事件关系预测;(拼接文本和视频表示,得到事件对的表示,然后用分类器判断事件对的关系)

论文:Arka Sadhu, et al. ,Visual Semantic Role Labeling for Video Understanding, CVPR 2021

3. 图像+文本:给定包含图像和文本的文档,从图像和文本中抽取出尽量完整的事件;

动机:传统的事件抽取目标为单模态,如文本、图像或视频,缺乏同时处理多模态信息的数据和方法;从其他模态中可以补充单模态中抽取事件的不足。

工作:提出第一个多模事件抽取数据集M2E2,从VOA网站上爬取文档进行标注。

论文:Manling Li, et al. , Cross-media Structured Common Space for Multimedia Event Extraction, ACL 2020

4. 视频+文本:给定包含视频和文本的文档,从视频和文本中抽取出尽量完整的事件;

动机:已有的方法都无法处理多模文档中包含视频的情况;

图像中更多包含的是事件的一个状态快照,很难包含事件的所有元素,而视频会包含更全面的信息;

视频包含文本描述的事件元素以外的额外信息,根据他们的统计,有45%的视频文本多模态新闻文档符合这种情况;

方法:

该工作提出了VM2E2多模态(视频+文本)事件抽取数据集;

首先,将视频中的物体与文本中的实体通过自监督的方式连接,实现视频片段与句子文本的连接;

然后,将经过对齐的句子视频片段输入编码器-解码器网络,得到事件的触发词以及元素。

论文:Brian Chen, et al. , Joint Multimedia Event Extraction from Video and Article, EMNLP Findings 2021

参考:国科大-知识图谱课件

文章出处登录后可见!