本期将给大家介绍22个与手部检测、手势识别、手部图像分割等任务相关的公开数据集,包含第一人称、第三人称视角,可用于人机交互、手语翻译、3D建模等场景。

手部数据集清单一览:

1. NVGesture

● 发布方:英伟达

● 发布时间:2016

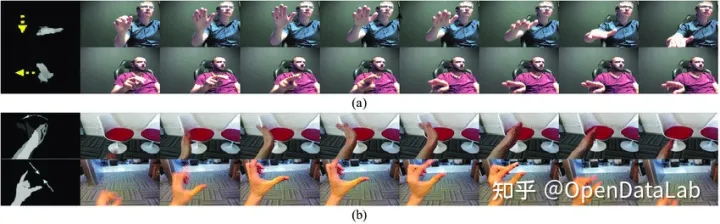

● 简介:NVGesture 数据集专注于非接触式驾驶员控制。它包含 1532 个动态手势,分为 25 个类别。它包括 1050 个用于训练的样本和 482 个用于测试的样本。视频以三种模式(RGB、深度和红外)录制。主要为第三人称视角。

● 下载地址:

https://opendatalab.org.cn/NVGesture

● 论文地址:

https://dl.acm.org/doi/abs/10.1145/1869790.1869829

2. HaGRID

● 发布方:SberDevices

● 发布时间:2022

●简介:

HaGRID (Hand Gesture Recognition Image Dataset)是一个大型图像数据集。可用于图像分类或图像检测任务,适用于视频会议、智能家居、智慧驾驶等场景。

HaGRID 大小为716GB,数据集包含552,992 个FullHD (1920 × 1080) RGB 图像,分为18类手势。数据分为 92% 的训练集和 8% 的测试集user_id,其中 509,323 幅图像用于训练,43,669 幅图像用于测试。

该数据集包含34,730个独特的人以及至少这个数量的独特场景。受试者为 18 至 65 岁的人。该数据集主要是在室内收集的,光照变化很大,包括人造光和自然光。该数据集还包括在极端条件下拍摄的图像,例如面对和背靠窗户。此外,受试者必须在距相机 0.5 到 4 米的距离处显示手势。

● 下载地址:

https://github.com/hukenovs/hagrid

● 论文地址:

https://arxiv.org/pdf/2206.08219v1.pdf

3. Chalearn IsoGD 、Chalearn ConGD

● 发布方:中国科学院自动化研究所

● 发布时间:2016

● 简介:

这两个数据集都是从CGD 2011 数据集创建的。

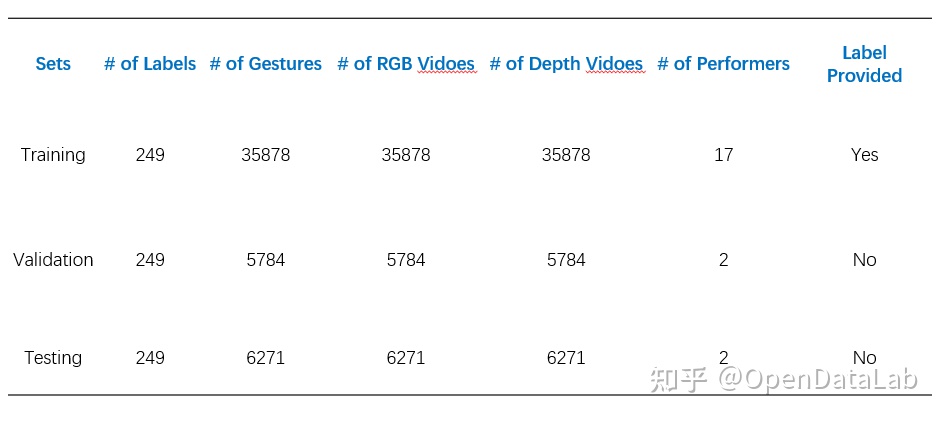

ChalearnIsoGD(Chalearn LAP RGB-D Isolated Gesture Dataset)是一个大规模的独立手势数据集。每类手势是 200 多个 RGB 和深度视频,并且来自同一个人的训练样本不会出现在验证和测试集中。

该数据集包括 47933 个 RGB-D 手势视频(约 9G)。每个 RGB-D 视频仅代表一个手势,共有 21 个不同的人执行的 249 个手势标签。

为了使用方便,被分成了三个子数据集,这三个子集是互斥的。

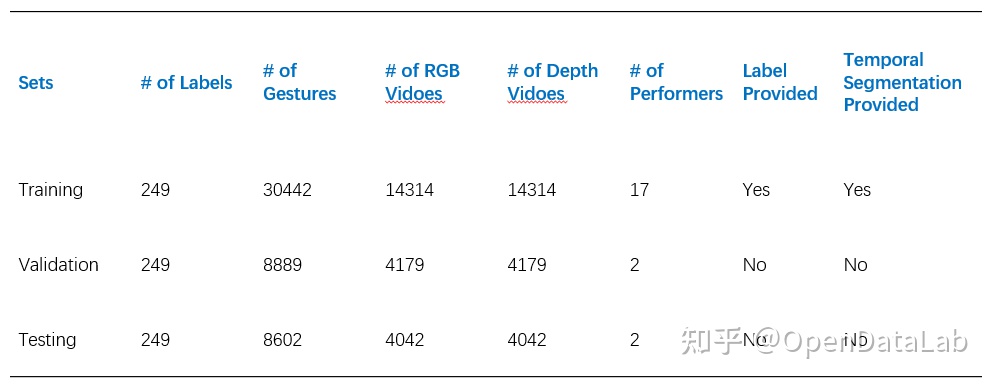

Chalearn ConGD(the Continuous Gesture Dataset)是一个大规模的连续手势识别数据集。该数据库包含 22535 个 RGB-D 手势视频(约 4G)中的 47933 个 RGB-D 手势。每个 RGB-D 视频可能代表一个或多个手势,共有 249 个手势标签,由 21 个不同的人执行。

为了使用方便,数据库被分成了三个子数据集,这三个子集是互斥的。

● 下载地址:

https://gesture.chalearn.org/2016-looking-at-people-cvpr-challenge/isogd-and-congd-datasets

● 论文地址:

http://www.cbsr.ia.ac.cn/users/jwan/papers/CVPRW2016_JunWan.pdf

4 HandNet

● 发布方:以色列理工学院计算机科学学院GIP实验室

● 发布时间:2015

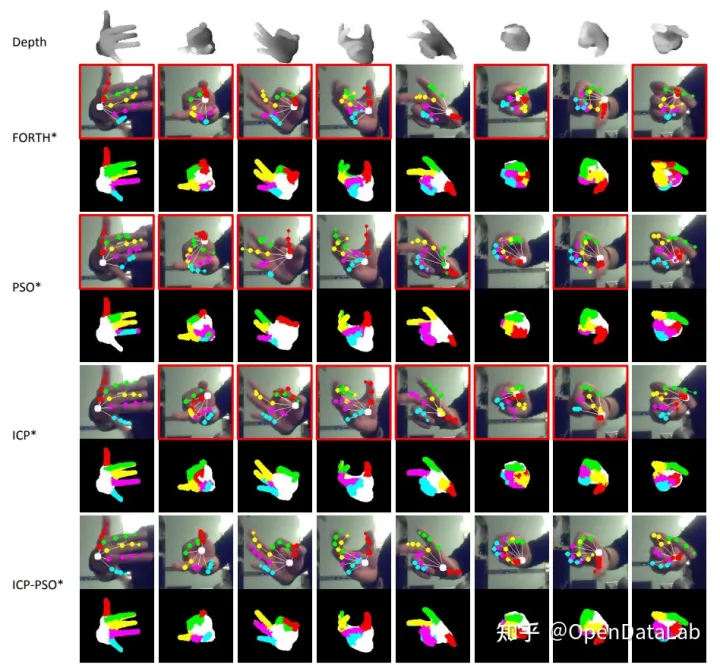

● 简介:HandNet 数据集,包含了 10 名参与者在RealSense RGB-D 相机前拍摄的非刚性变形的手部深度图像。其中还包含了 6D 数据,用于描述手的中心及指尖的位置方向信息。

此数据集包含训练集:202198;测试集:10000;验证集:2773。

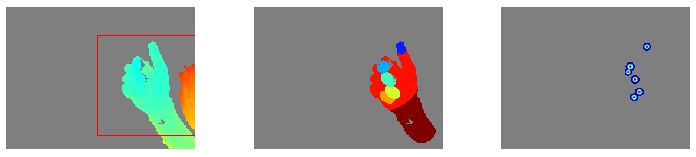

HandNet 测试集检测示例。颜色代表正确定位和识别的指尖。白框表示错误检测,错误阈值选择为 1cm

● 下载地址:

https://opendatalab.org.cn/HandNet

● 论文地址:

https://arxiv.org/pdf/1507.05726v1.pdf

5. RHD (Rendered Hand Pose)

● 发布方:弗莱堡大学

● 发布时间:2017

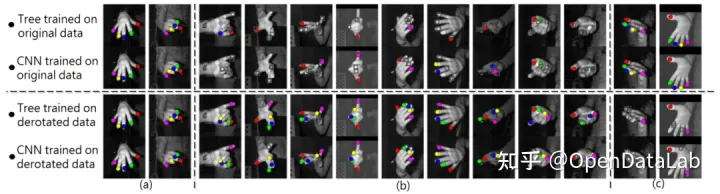

● 简介:Rendered Handpose Dataset 包含 41258 个训练样本和 2728 个测试样本。

每个样本提供:

- RGB 图像(320×320 像素);

- 深度图(320×320 像素) ;

- 类别的分割掩码(320×320 像素):背景、人物、每个手指三个类别和每个手掌一个类别;

- 每只手的21个关键点,其uv 坐标位于图像框架、世界框架中的 xyz 坐标和可见性指示器;

- 相机内参矩阵 K。

● 下载地址:

https://opendatalab.org.cn/Rendered_Handpose_Dataset

● 论文地址:

https://arxiv.org/pdf/1705.01389v3.pdf

6. FreiHAND

● 发布方:弗莱堡大学、Adobe 研究院

● 发布时间:2019

● 简介:FreiHand是一个3D手部姿态数据集,记录了32个人进行的不同手部动作。对于每个手图像,提供基于Mano的3D手姿态标注。它目前包含32560个不同训练样本和3960个用于评估的不同样本。训练样本被记录在允许背景移除的绿屏背景下。

此外,它还采用了三种不同的后处理策略对训练样本进行数据增强。但这些后处理策略并没有应用于评估样本。

数据集示例,显示图像(顶行)和手形注释(底行)。这个训练集包含来自绿屏记录的合成图像,而评价数据集包含记录的室内和室外图像

● 下载地址:

https://opendatalab.org.cn/FreiHAND

● 论文地址:

https://arxiv.org/pdf/1909.04349v3.pdf

7. MSRA Hand

● 发布方:微软研究院、香港中文大学

● 发布时间:2014

● 简介:MSRA Hands 是用于手部跟踪的数据集。使用英特尔的创意交互式手势相机总共捕获了 6 个受试者的右手。每个受试者被要求在 400 帧的视频序列中做出各种快速手势。

为了考虑不同的手尺寸,为每个主题指定了全局手模型比例:主题 1~6 分别为 1.1、1.0、0.9、0.95、1.1、1.0。相机内在参数为:主点=图像中心(160,120),焦距=241.42。深度图像为 320×240,每个 .bin 文件按行扫描顺序存储深度像素值,即 320240 个浮点数。单位是毫米。

bin 文件是二进制文件,需要使用 std::ios::binary 标志打开。joint.txt 文件存储 400 帧 x 每帧 21 个手关节。每条线有 3 * 21 = 63 个浮点数,用于 (x, y, z) 坐标中的 21 个 3D 点。

21 个手关节是:手腕、index_mcp、index_pip、index_dip、index_tip、middle_mcp、middle_pip、middle_dip、middle_tip、ring_mcp、ring_pip、ring_dip、ring_tip、little_mcp、little_pip、little_dip、little_tip、thumb_mcp、thumb_pip、thumb_dip、thumb_tip。对应的 *.jpg 文件仅用于深度和地面实况关节的可视化。

第一个对象的示例跟踪结果。带有红框的那些包含明显的错误。颜色编码为了更好地可视化,还显示了每个结果的对应图

● 下载地址:

https://opendatalab.org.cn/MSRA_Hand

● 论文地址:

No.8

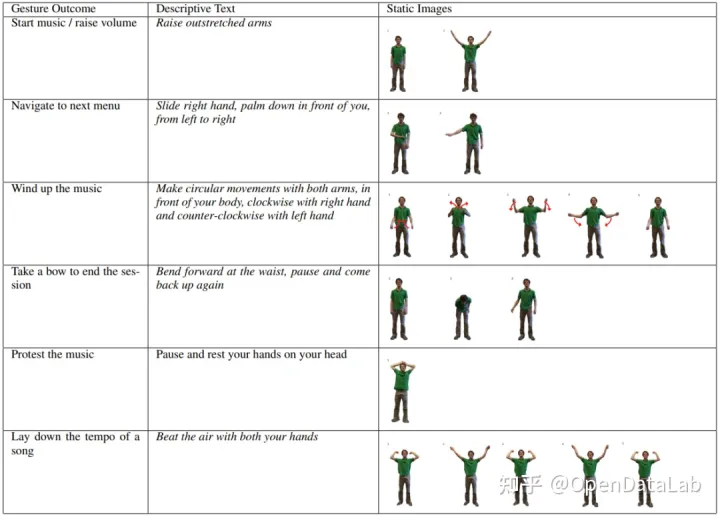

MSRC-12 (MSRC-12 Kinect Gesture Dataset)

● 发布方:亚历山大大学、微软

● 发布时间:2012

● 简介:Microsoft Research Cambridge-12 Kinect 手势数据集由人体运动序列组成,表示为身体部位位置,以及系统识别的相关手势。该数据集包括 594 个序列和 719,359 帧 – 大约 6 小时 40 分钟 – 从 30 个人执行 12 个手势收集。总共有 6,244 个手势实例。运动文件包含使用 Kinect 姿势估计管道估计的 20 个关节的轨迹。身体姿势以 30Hz 的采样率捕获,关节位置的精度约为 2 厘米。

● 下载地址:

https://opendatalab.org.cn/MSRC-12

● 论文地址:

http://www.nowozin.net/sebastian/papers/fothergill2012gestures.pdf

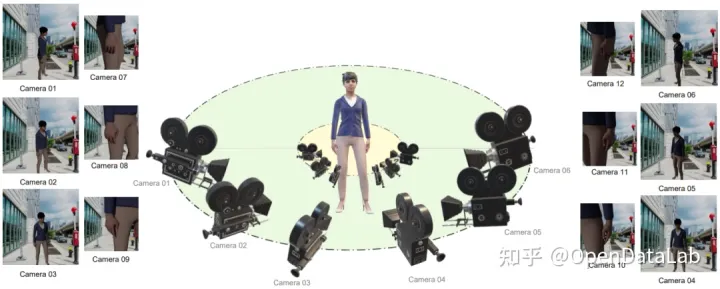

9. MuViHand

● 发布方:皇后大学

● 发布时间:2021

● 简介:MuViHand是在 Mixamo 的帮助下创建的合成手部姿势数据集,由手的多视图视频和真实 3D 姿势标签组成。

包括 4,560 个视频中提供的超过 402,000 张合成手部图像。这些视频是从六个不同角度同时拍摄的,具有复杂的背景和随机的动态照明水平。数据是从 10 个不同的动画对象中捕获的,使用 12 个摄像头在半圆形拓扑中,其中六个跟踪摄像头只聚焦在手上,其他六个固定摄像头捕获整个身体。

MuViHand 数据集的多视图相机取景示意

● 下载地址:

https://opendatalab.org.cn/MuViHand

● 论文地址:

https://arxiv.org/pdf/2109.11747v1.pdf

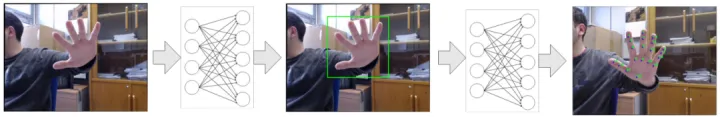

10. 3D Hand Pose

● 发布方:阿利坎特大学

● 发布时间:2017

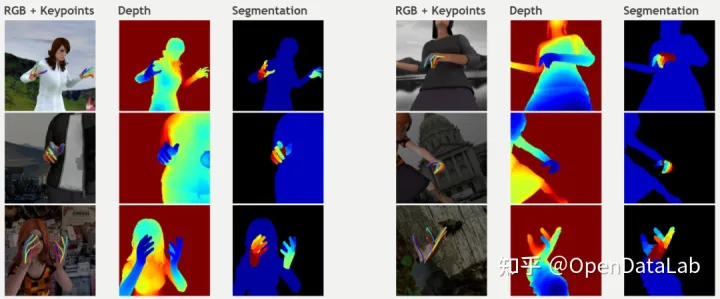

● 简介:3D Hand Pose 是一个多视图手部姿势数据集,由手部的彩色图像和不同类型的注释组成:边界框以及手部关节上的 2D 和 3D 位置。

相关模型检测流程

样例示意

● 下载地址:

https://opendatalab.org.cn/3D_Hand_Pose

● 论文地址:

https://arxiv.org/pdf/1707.03742v3.pdf

11. Jester

● 发布方:高通

● 发布时间:2019

● 简介:

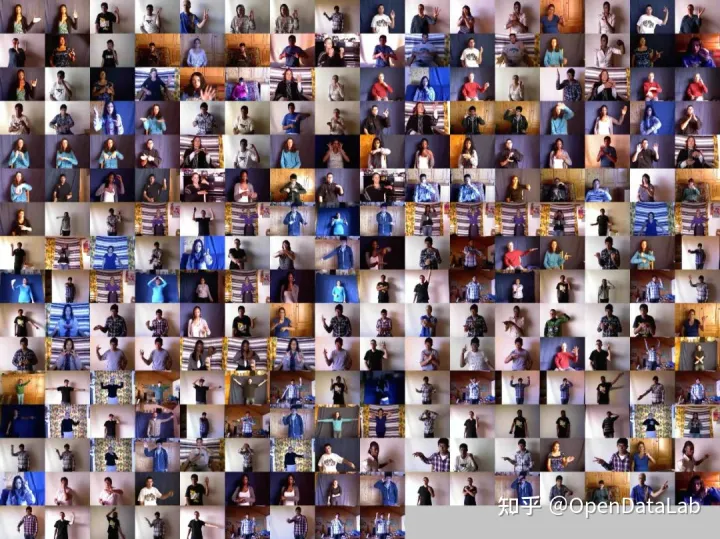

Jester 手势识别数据集包括 148,092 个带标签的人类在笔记本电脑摄像头或网络摄像头前执行基本的、预定义的手势的视频剪辑。它旨在训练机器学习模型以识别人类手势,例如向下滑动两根手指、向左或向右滑动以及敲击手指。

这些剪辑涵盖了 27 种不同类别的人类手势,按照 8:1:1 的比例进行了训练、开发和测试。该数据集还包括两个“无手势”类,以帮助网络区分特定手势和未知手部动作。

数据集样例示意

● 下载地址:

https://developer.qualcomm.com/software/ai-datasets/jester

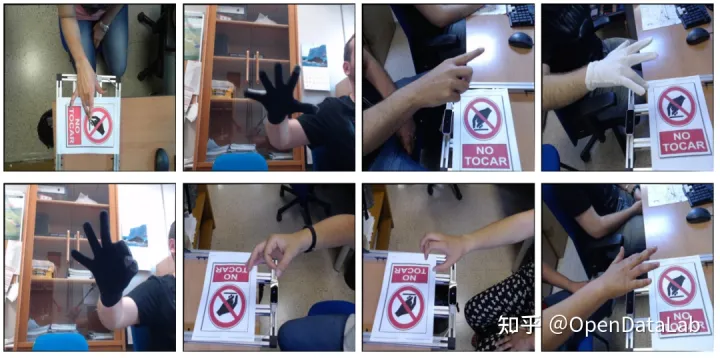

12. IPN Hand

● 发布方:电气通信大学

● 发布时间:2020

● 简介:

IPN Hand 数据集包含来自50 个主题的4,000 多个手势实例和 800,000 个帧。包含13 种静态和动态手势,用于与非触摸屏交互。与其他公开可用的手势数据集相比,IPN Hand 包含每个视频最多的连续手势,以及最大的类内变化速度。除了RGB 帧外,还提供实时光流和手部分割结果。

数据收集的设计考虑了连续 HGR 的现实世界问题,包括在没有过渡状态的情况下执行的连续手势、作为非手势片段的自然运动、包括杂乱背景、极端光照条件以及静态和动态环境的场景。

没有过渡状态的连续手势示例:

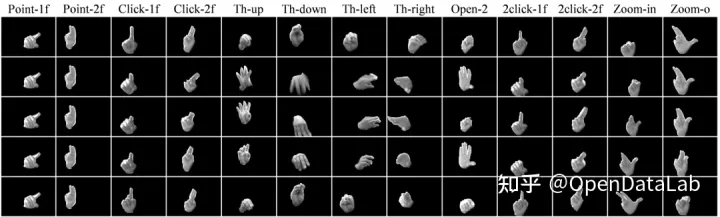

数据集中包含的 13 个手势类别的示例。语义分割掩码被混合到 RGB 图像中便于可视化

● 下载地址:

https://gibranbenitez.github.io/IPN_Hand/

● 论文地址:

https://gibranbenitez.github.io/2021_ICPR_IpnHand.pdf

13. EgoGesture

● 发布方:中国科学院自动化研究所

● 发布时间:2017

● 简介:EgoGesture 是一个第一人称视角的手势识别的多模态大规模数据集,包含来自 50 个不同主题的 2,081 个 RGB-D 视频、24,161 个手势样本和 2,953,224 帧。包含了83 类静态或动态手势,专注于与可穿戴设备的交互,

这些视频是从 6 个不同的室内和室外场景中收集的。还考虑了人们在走路时做手势的场景。

4 个室内场景:

● 对象处于静止状态,具有静态杂波背景;

● 主体处于动态背景的静止状态;

● 对象处于静止状态,面对阳光剧烈变化的窗户;

● 处于行走状态的主体;

2个户外场景:

● 主体处于动态背景的静止状态;

● 动态背景下处于行走状态的主体。

6类场景示意

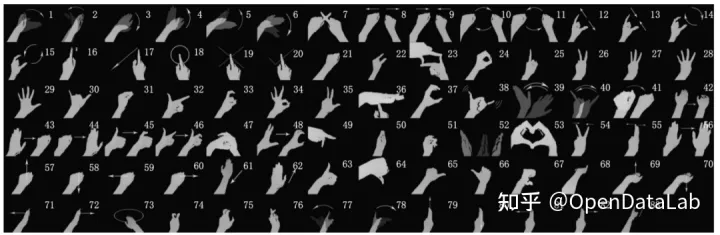

数据集中包含的 83 种手势类别的示例

● 下载地址:

http://www.nlpr.ia.ac.cn/iva/yfzhang/datasets/egogesture.html

● 论文地址:

http://www.nlpr.ia.ac.cn/iva/yfzhang/datasets/EgoGesture.pdf

14. FPHA

● 发布方:伦敦帝国理工学院

● 发布时间:2018

● 简介:First-Person Hand Action Benchmark是 RGB-D 视频序列的集合,由 45 个日常手部动作类别的 100K 帧组成,涉及多种手部配置中的 26 个不同对象。可用于 3D 手势估计、6D 物体姿势、机器人以及动作识别等任务。第一人称视角。

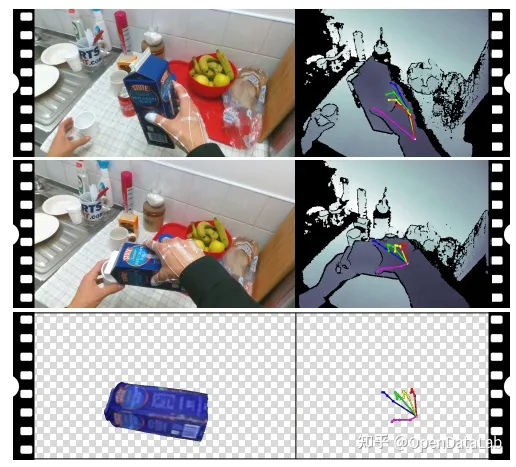

第一人称“倒果汁”动作示意。使用了磁性传感器和逆运动学模型来捕捉手的姿势。在右侧是深度图像和手部姿势。也为手部动作的子集捕获 6D 姿态

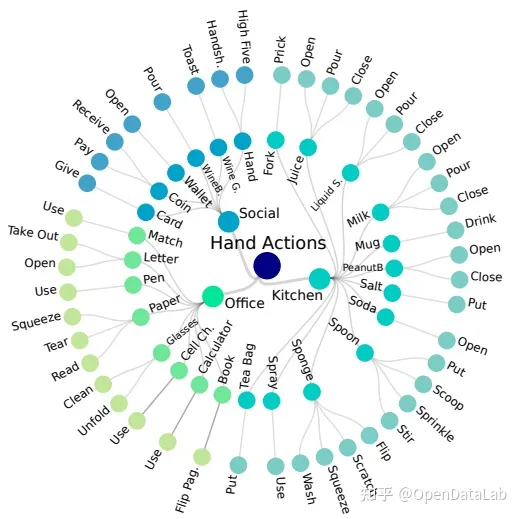

涉及物体的手部动作分类。一些对象与多个动作相关联(例如,勺子、海绵、液体肥皂),而其他一些有只有一个链接动作(例如,计算器、笔、电池充电器)

● 下载地址:

https://guiggh.github.io/publications/first-person-hands/

● 论文地址:

https://arxiv.org/pdf/1704.02463.pdf

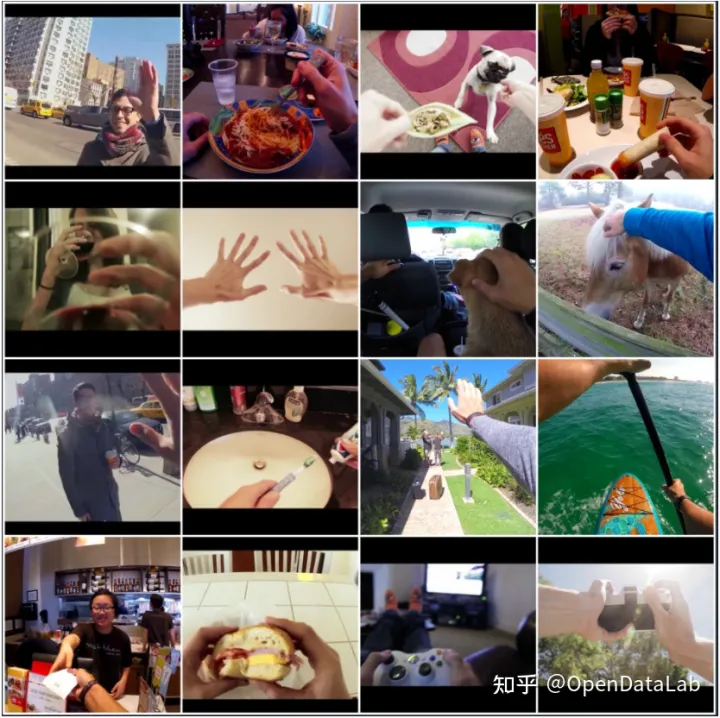

15. EYTH (EgoYouTubeHands)

● 发布方:中佛罗里达大学

● 发布时间:2018

● 简介:

EYTH是一个以自我为中心的手分割数据集,由1290个来自YouTube视频的注释帧组成,这些视频记录在无约束的现实世界中。这些视频在环境、参与者数量和动作方面都有所不同。该数据集有助于研究无约束环境下的手分割问题。

● 下载地址:

https://opendatalab.org.cn/EYTH

● 论文地址:

https://arxiv.org/pdf/1803.03317v2.pdf

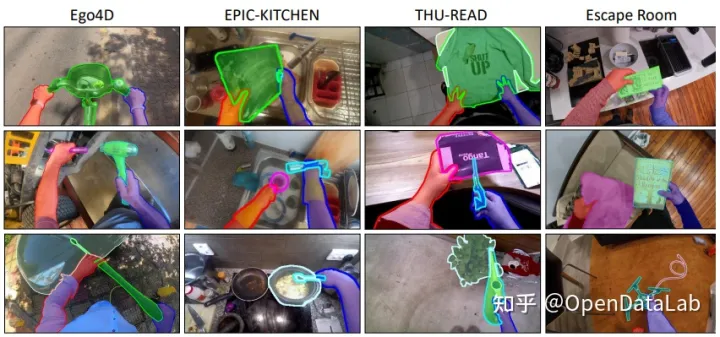

16. EgoHOS

● 发布方:宾夕法尼亚大学 · 丰田研究所(TRI)

● 发布时间:2022

● 简介:EgoHOS(Egocentric Hand-Object Segmentation)是一个由 11,243 个以自我为中心的图像组成的标记数据集,其中包含在各种日常活动中交互的手和物体的每像素分割标签。是目前最早的标记详细的手对象接触边界的数据集。

作者引入了一种上下文感知的组合数据增强技术,以适应分发外的 YouTube 以自我为中心的视频。展示其手部对象分割模型和数据集可以作为基础工具来增强或启用多种下游视觉应用,包括手部状态分类、视频活动识别、手对象交互的 3D 网格重建,以及以自我为中心的视频中手对象前景的视频修复。

标记示意

● 下载地址:

https://github.com/owenzlz/EgoHOS

● 论文地址:

https://arxiv.org/pdf/2208.03826.pdf

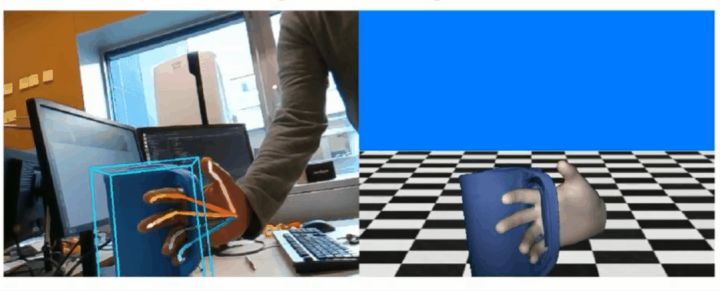

17. HO-3D

● 发布方:格拉茨技术大学、古斯塔夫·埃菲尔大学

● 发布时间:2020

● 简介:HO-3D是一个具有手和对象的3D 姿势注释的手对象交互数据集。该数据集包含来自总共 68 个序列的 66,034 个训练图像和 11,524 个测试图像。这些序列在多摄像头和单摄像头设置中捕获,包含 10 个不同的主体,从 YCB 数据集中操纵 10 个不同的对象。

注释是使用优化算法自动获得的。测试集的手势注释被保留,测试集上算法的准确性可以使用 CodaLab 挑战提交通过标准指标进行评估。测试集和训练集的对象姿态注释与数据集一起提供。

● 下载地址:

https://opendatalab.org.cn/HO-3D

● 论文地址:

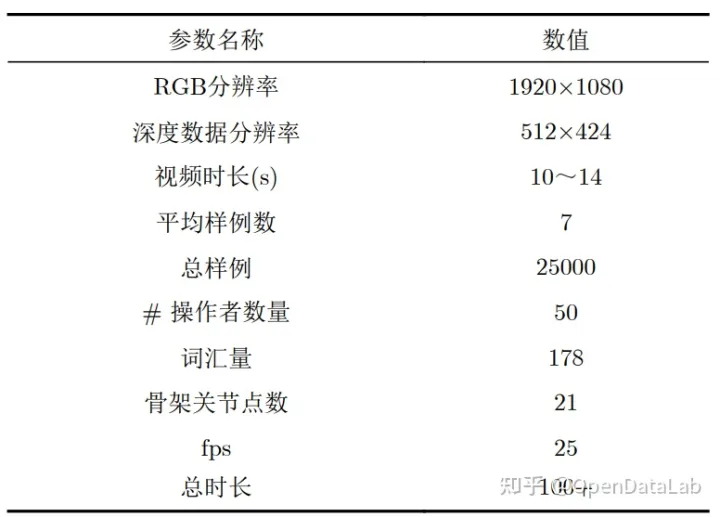

18. CSL

● 发布方:中国科学技术大学

● 发布时间:2015

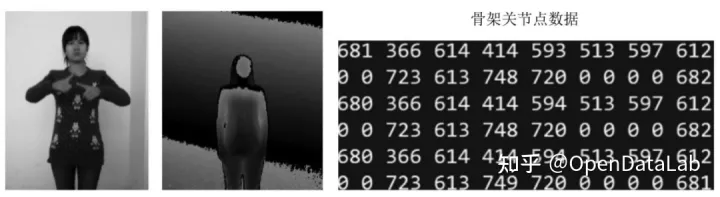

● 简介:中国手语数据集(CSL)是由中国科学技术大学自2015年起利用Kinect采集的中国手语数据集,包含25K标记的视频实例,共有超过100个时长的视频,50个操作者拍摄,每个操作者重复5次,包含RGB、深度以及骨架关节点数据,分为孤立词和连续语句,其中单词有500类,每类含250个样例, 包含21个骨架关节点坐标序列;句子有100个,共 有5000个视频,每一个句子平均包含4~8个单词。

每一个视频实例都由专业的中国手语老师进行标注。

CSL数据集参数

CSL中国手语数据样例

● 下载地址:

http://home.ustc.edu.cn/~pjh/openresources/cslr-dataset-2015/index.html

● 论文地址:

Isolated SLR:

http://home.ustc.edu.cn/~pjh/publications/ICME2016Chinese/paper.pdf

Continuous SLR:

https://ieeexplore.ieee.org/document/8954236

19. MFH

● 发布方:Willogy、AIOZ · Blood Transfusion Hematology Hospital

● 发布时间:2021

● 简介:MFH 数据集是一个多视点细粒度的手部卫生数据集。它总共包含 73,1147 个样本,这些样本由 6 个不同位置的 6 个摄像机视图收集。所有样本总共分为 7 个类别。MFH 数据集与现有数据集的区别在于三个方面:大的类内差异、细微的类间差异以及训练阶段和推理阶段之间的数据分布不匹配。因此,该数据集提供了更现实的基准。

MFH数据集中7个手部卫生步骤的6个不同视角的样例总览

数据集样例

● 下载地址:

https://opendatalab.org.cn/MFH

● 论文地址:

https://arxiv.org/pdf/2109.02917.pdf

20. 11k Hands

● 发布方:约克大学、阿斯尤特大学

● 发布时间:2019

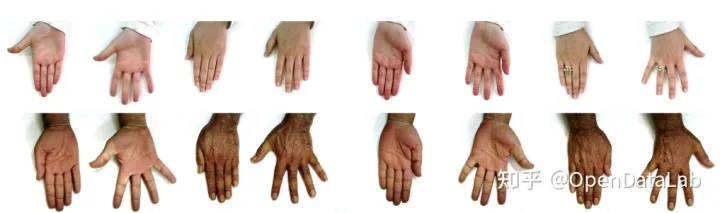

● 简介:11k Hands是一个用于性别识别和生物特征识别的详细真实信息的人类手部图像(背侧和手掌侧)的大型数据集。包含 190 位参与者的人手图片数据集,年龄在 18-75 岁之间。所有背景色均为白色,且拍照距离一致。

对应的元数据包含:● 主题 ID● 性别● 年龄● 肤色● 手的信息,即右手或左手,手侧(背侧或手掌)和逻辑指示符,用于指示手部图像是否包含附件,指甲油或不规则物。

数据集样例示意,每行显示的是同一对象的8个手部图像

● 下载地址:

https://opendatalab.org.cn/11k_Hands

● 论文地址:

https://arxiv.org/pdf/1711.04322v9.pdf

21. LD-ConGR

● 发布方:中国科学院软件研究所

● 发布时间:2022

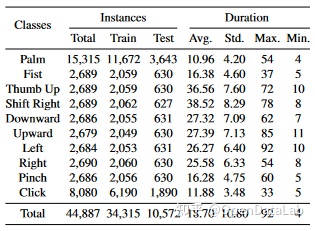

● 简介:LD ConGR中总共收集了542个视频和44887个手势实例。视频从5个不同场景中的30名受试者收集,并用Kinect V4以第三视角拍摄。每个视频包含一个颜色流和一个深度流。这两个流以30fps同步记录,分辨率分别为1280 x 720和640 x 576。

数据集按受试者随机分为训练集和测试集(23名受试者用于训练,7名受试人用于测试)。手势实例的数量和手势持续时间的统计(以帧为单位测量)如下:

手势实例数和手势持续时间统计

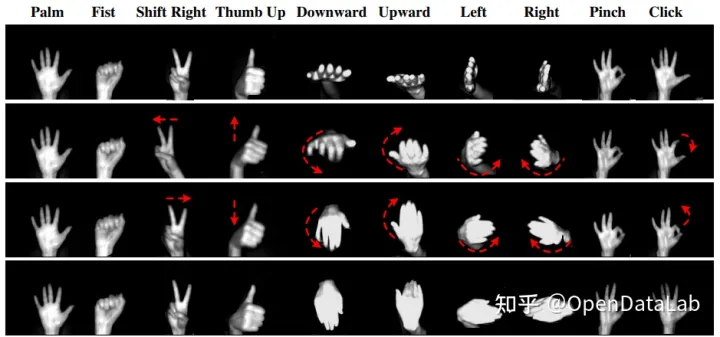

LD ConGR数据集的十类手势,包括三个静态手势和七个动态手势手势。每列显示了同一类。红色箭头指示手的动作

会议场景手势识别示意

● 下载地址:

https://github.com/Diananini/LD-ConGR-CVPR2022

● 论文地址:

22. InterHand2.6M

● 发布方:Facebook Reality Lab

● 发布时间:2020

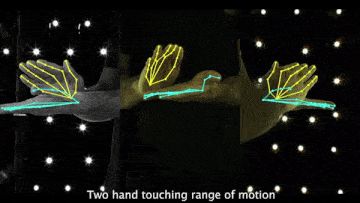

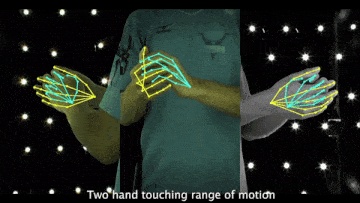

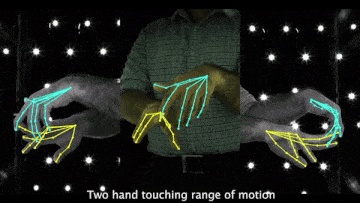

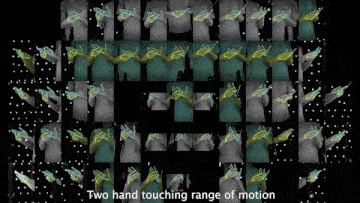

● 简介:第一个具有准确 GT 3D 交互手部姿势的大规模实拍数据集。

InterHand2.6M 数据集是一个大规模实拍数据集,具有准确的 GT 3D 交互手部姿势,用于 3D 手部姿势估计该数据集包含 2.6M 标记的单个和交互手部框架。InterHand2.6M 最初是在 4096×2668 分辨率下拍摄的,但为了保护指纹隐私,发布的数据集分辨率为512×334。

● 下载地址:

https://mks0601.github.io/InterHand2.6M/

● 论文地址:

https://arxiv.org/pdf/2008.09309.pdf

以上就是本次分享,获取海量数据集资源,请访问OpenDataLab官网;获取更多开源工具及项目,请访问OpenDataLab Github空间。另外还有哪些想看的内容,快来告诉小助手吧。更多数据集上架动态、更全面的数据集内容解读、最牛大佬在线答疑、最活跃的同行圈子……欢迎添加微信opendatalab_yunying加入OpenDataLab官方交流群。

文章出处登录后可见!