课程链接PyTorch深度学习实践第七节课程。

go go go~!

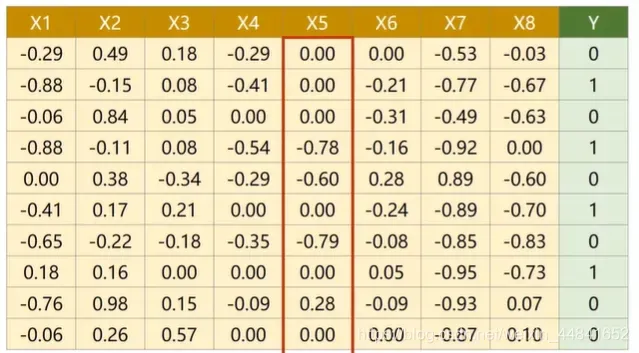

通过前几期视频的学习,我们知道了关于一维特征的输入的二分类(也就是x只有一个列向量)应该如何处理了。但事情往往并不那么简单。比如下图这个预测一个人在一年之后得糖尿病的概率的例子,这个时候我们的输入将会有很多的指标。你可以把它看成是我们体检的各种值。最后一排的y代表了他是否会得糖尿病。

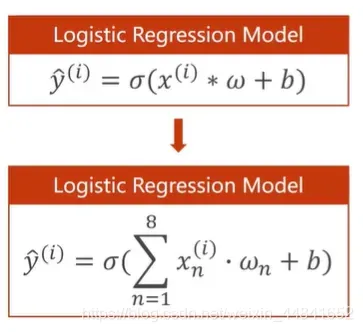

那么多维的特征输入应该怎么办呢?我们就需要把每一个特征x给以相应的权重。在进行逻辑回归时,把每一个维度的x乘相应的权值的和加上一个偏置量,送入sigmoid函数进行二分类,就像这样:

i 是指样本,把一个维度Xn的所有样本值加在一起

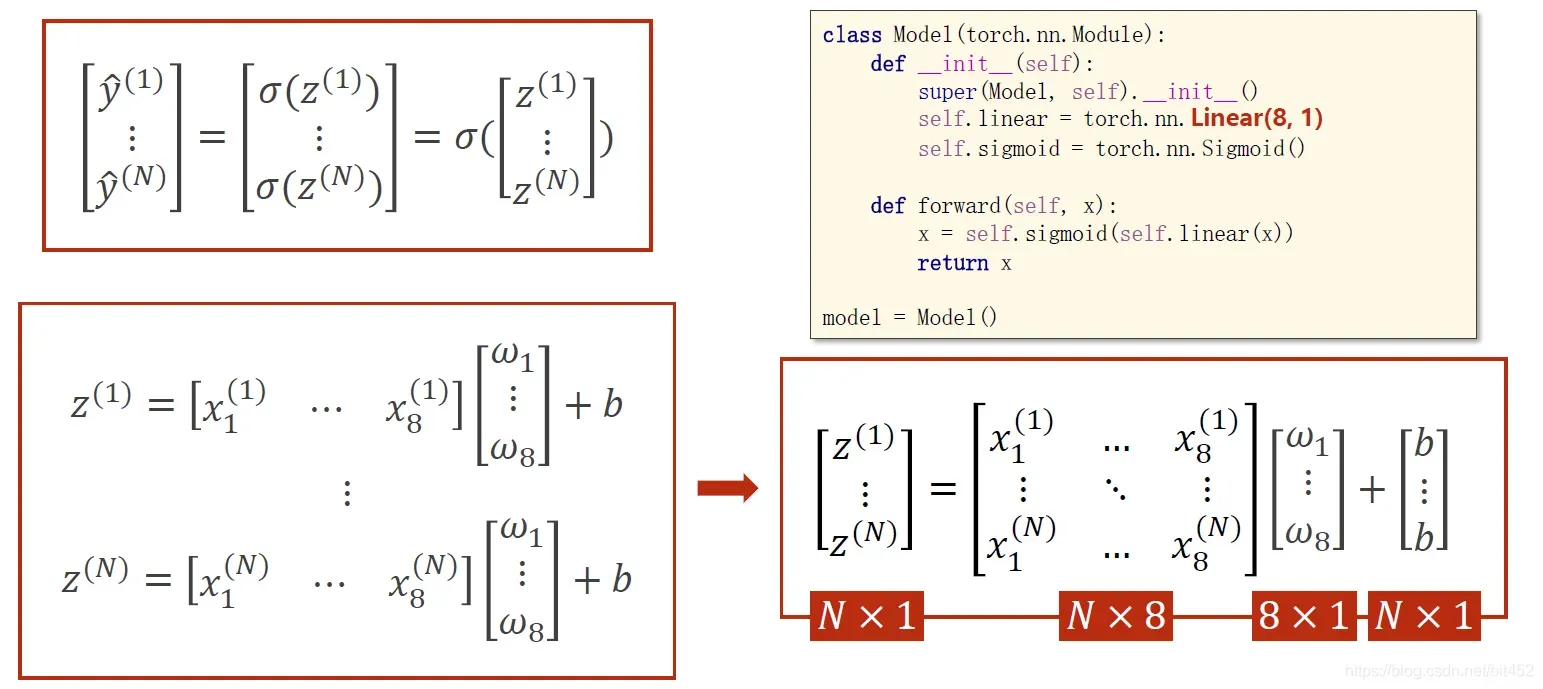

1、第五讲介绍过Linear这个函数,

torch.nn.Linear(m,n)

其中m和n是输入和输出数据的维度,Linear里面能根据input和output的维度构造Linear Unit单元模块,其中 W 和 B 是矩阵,可以通过广播机制将W和B转换成Nw 和Nb的矩阵。

2、学习能力越强,有可能会把输入样本中噪声的规律也学到。我们要学习数据本身真实数据的规律,学习能力要有泛化能力。

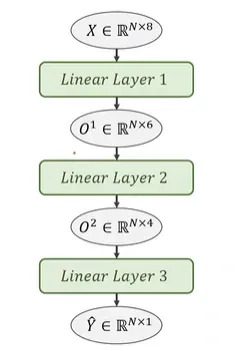

3、该神经网络共3层;第一层是8维到6维的非线性空间变换,第二层是6维到4维的非线性空间变换,第三层是4维到1维的非线性空间变换。

4、本算法中torch.nn.Sigmoid() # 将其看作是网络的一层,而不是简单的函数使用 。

程序如下图

import numpy as np

import torch

import matplotlib.pyplot as plt

# 1、 prepare dataset

xy = np.loadtxt('diabetes.csv', delimiter=',', dtype=np.float32) #加载文本数据集

x_data = torch.from_numpy(xy[ : , :-1]) # 切片 第一个‘:’是指读取所有行,第二个‘:’是指从第一列开始,最后一列不要

y_data = torch.from_numpy(xy[ : , [-1]]) # [-1] 最后得到的是个矩阵

# 2、 design model using class

class Model(torch.nn.Module):

def __init__(self):

super(Model, self).__init__()

self.linear1 = torch.nn.Linear(8, 6) # 输入数据x的特征是8维,x有8个特征

self.linear2 = torch.nn.Linear(6, 4)

self.linear3 = torch.nn.Linear(4, 1)

self.sigmoid = torch.nn.Sigmoid() # 将其看作是网络的一层,而不是简单的函数使用

def forward(self, x):

x = self.sigmoid(self.linear1(x))

x = self.sigmoid(self.linear2(x))

x = self.sigmoid(self.linear3(x)) # y hat

return x

model = Model()

# 3、 construct loss and optimizer

# criterion = torch.nn.BCELoss(size_average = True)

criterion = torch.nn.BCELoss(reduction='mean')

optimizer = torch.optim.SGD(model.parameters(), lr=0.1)

epoch_list = []

loss_list = []

# 4、 training cycle forward, backward, update

for epoch in range(100):

y_pred = model(x_data)

loss = criterion(y_pred, y_data)

print(epoch, loss.item())

epoch_list.append(epoch)

loss_list.append(loss.item())

optimizer.zero_grad()

loss.backward()

optimizer.step()

#测试 取最后一个样本做测试集,可以再交叉验证

x_test = torch.from_numpy(xy[[-1], :-1])

y_test = model(x_test)

print('y_pred = ', y_test.data) #打印出预测的最后一组样本

print('y_real=', torch.from_numpy(xy[[-1], [-1]]) ) #打印出实际的样本

结果:

y_pred = tensor([[0.6533]])

y_real= tensor([1.])

如果要查看某些层的参数,以神经网络第一层的参数为例,可以通过以下方式进行。

# 参数说明

# 第一层的参数:

layer1_weight = model.linear1.weight.data

layer1_bias = model.linear1.bias.data

print("layer1_weight", layer1_weight)

print("layer1_weight.shape", layer1_weight.shape)

print("layer1_bias", layer1_bias)

print("layer1_bias.shape", layer1_bias.shape)

by 小李

如果你坚持到这里,请不要停下来,山顶的景色更迷人!好戏还在后面。来吧!

欢迎交流学习,批评指正,您的点赞和评论将是我更新的动力!谢谢😃

版权声明:本文为博主咯吱咯吱咕嘟咕嘟原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/weixin_41469023/article/details/122966291