上一篇:04 自动调整学习率(Learning Rate)-学习笔记-李宏毅深度学习2021年度

下一篇:06 卷积神经网络CNN-学习笔记-李宏毅深度学习2021年度

本节内容及相关链接

处理分类问题的注意事项

- 视频链接

- PPT链接

- 作业PPT链接

课程笔记

可以将分类(Classification)任务看做回归(Regression)任务,只需将类别变成这样的数字即可。但通常并不这么做。除非有特殊情况,比如要预测这个学生是几年级的,这种的可以,因为 Class1 和 Class2 等有递进关系

多分类任务通常使用 one-hot 编码,例如:

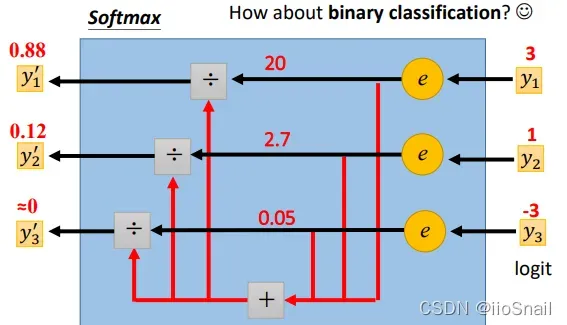

分类任务最后的输出要经过softmax函数进行归一化,最大的那个就是预测的类别

Softmax公式如下:

对于二分类问题,使用 softmax 和 sigmoid 是等价的(数学上可以证明出来)

对于多分类任务,通常采用Cross-Entropy作为损失函数

Cross-Entropy的公式如下:

为Batch Size

指

类

最小化Cross-Entropy和最大化可能性(Likelihood)只是说法不一样,但实际是等价的

版权声明:本文为博主iioSnail原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/zhaohongfei_358/article/details/123186462