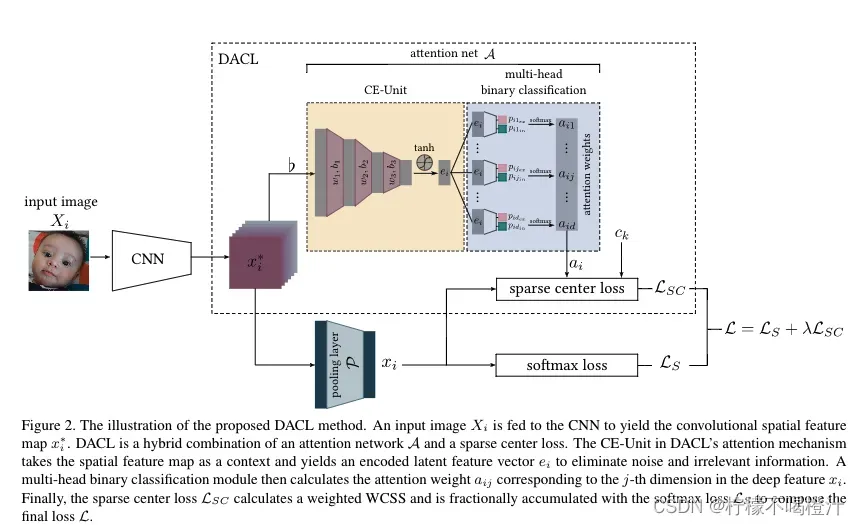

这篇文章的重点是“深度注意力中心损失”。

下面简要描述一下网络中下面分支的pipeline:

难点在于上面分支的理解,也就是sparse center loss如何计算。在介绍上面分支的pipeline之前,需要介绍一下什么叫中心损失。

中心损失的目标是:最小化 “ 深层特征 ” 与其 “ 对应的类中心” 之间的距离。举个例子,有一批batch size为m的样本

我们认为,并非特征向量中的所有元素都与区分表情有关。我们的目标是在深层特征向量中只选择一个子集的元素来进行表情区分。因此,为了在判别过程中滤除不相关的特征,我们在上述公式中的维度d上对计算出的欧式距离进行加权。也就是下式:

好了,补充完中心损失的知识点,下面来说上面分支的pipeline。

上面分支存在的目的是:为了计算Eq.4(也就是上式)中的

那么怎么用

最后

有了

通篇读下来,其实这篇文章的创新点主要在于 sparse center loss的生成,我刚开始读的时候一直不明白

最后的loss如下式:

版权声明:本文为博主柠檬不喝橙汁原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/qq_42785704/article/details/123258913