最近在使用单机多卡进行分布式(DDP)训练时遇到一个错误:ERROR: torch.distributed.elastic.multiprocessing.api:failed。

而实际报错的内容是:ValueError: sampler option is mutually exclusive with shuffle.

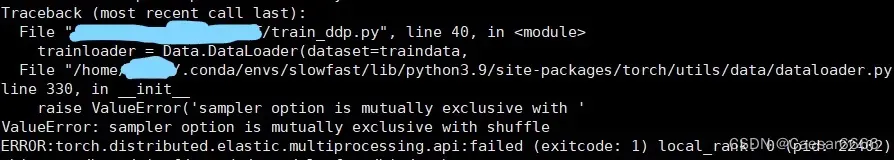

报错的详细内容如下截图所士:

出现这种错误的原因是,在分布式训练时使用了sampler,并且dataloader时参数shuffle设置成True。由于sampler在分配数据给gpu时已经自动打乱了数据,所以dataloader无需重复打乱数据,二者是相冲的。

因此,使用分布式训练时,会使用sampler,在dataloader时参数shuffle默认False即可。

文章出处登录后可见!

已经登录?立即刷新