目前基于目标检测方面,近些年基于深度学习的人神经网络产生了很多经典且高效的网络结构。其中不乏有凯明大神的Fast-RCNN、Faster-RCNN家族系列检测网络结构;还有号称you only look once的YOLO系列。

本次分享的就是最近刚刚发布的基于企业开发需要而产生的yolov5(因为相关论文还没有发表,所以本文不过分讲解其中原理,可自行了解;只对具体的实现操作和部署进行分享)。以下会详细介绍yolov5的下载安装和使用技巧以及如何使用自己的数据集进行小目标的检测工作。具体yolov5的一些细节问题包括网络结构的讲解、大家可以看我下面这个链接的博客,其中也添加了一些小目标检测的相关知识,有兴趣可以了解一下。

(219条消息) 清晰、幽默、轻松地深入理解YOLOv5网络结构和一些细节(查阅无数资料文献总结)_Hack Hui的博客-CSDN博客

一、YOLOv5的下载

github 链接 https://github.com/ultralytics/yolov5

下载之后按照其中的README.md文件进行配置和设置。

二、YOLOv5数据集的设置

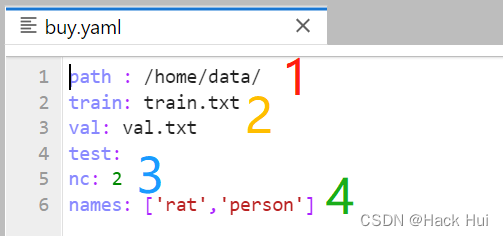

对yolov5/data/buy.yaml文件进行配置

其中 1:yours数据集的根目录

其中 1:yours数据集的根目录

2:代表生成yolo要求的txt文件

3: 你需要识别的类别数

4: 你识别类别的名称

三、小目标检测的难点

当前的检测算法对于小物体并不友好,体现在以下4个方面:

- 过大的下采样率:假设当前小物体尺寸为15×15,一般的物体检测中卷积下采样率为16,这样在特征图上,过大的下采样率使得小物体连一个像素点都占据不到。

- 过大的感受野:在卷积网络中,特征图上特征点的感受野比下采样率大很多,导致在特征图上的一个点中,小物体占据的特征更少,会包含大量周围区域的特征,从而影响其检测结果。

- 语义与空间的矛盾:当前检测算法,如Faster RCNN,其Backbone大都是自上到下的方式,深层与浅层特征图在语义性与空间性上没有做到更好的均衡。

- SSD一阶算法缺乏特征融合:SSD虽然使用了多层特征图,但浅层的特征图语义信息不足,没有进行特征的融合,致使小物体检测的结果较差。

四、提高小目标检测的基本思想

1、数据加强 2、滑动窗口检测:将图片分割为n个小区域分别检测,最后在concat成正常图像大小。本文也是主要介绍这种思想。

五、相关代码

# parameters

nc: 2 # number of classes

depth_multiple: 1.0 # model depth multiple

width_multiple: 1.0 # layer channel multiple

# anchors

anchors:

- [5,6, 8,14, 15,11] #4

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Focus, [64, 3]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, BottleneckCSP, [128]], #160*160

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 9, BottleneckCSP, [256]], #80*80

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, BottleneckCSP, [512]], #40*40

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 1, SPP, [1024, [5, 9, 13]]],

[-1, 3, BottleneckCSP, [1024, False]], # 9 20*20

]

# YOLOv5 head

head:

[[-1, 1, Conv, [512, 1, 1]], #20*20

[-1, 1, nn.Upsample, [None, 2, 'nearest']], #40*40

[[-1, 6], 1, Concat, [1]], # cat backbone P4 40*40

[-1, 3, BottleneckCSP, [512, False]], # 13 40*40

[-1, 1, Conv, [512, 1, 1]], #40*40

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3 80*80

[-1, 3, BottleneckCSP, [512, False]], # 17 (P3/8-small) 80*80

[-1, 1, Conv, [256, 1, 1]], #18 80*80

[-1, 1, nn.Upsample, [None, 2, 'nearest']], #19 160*160

[[-1, 2], 1, Concat, [1]], #20 cat backbone p2 160*160

[-1, 3, BottleneckCSP, [256, False]], #21 160*160

[-1, 1, Conv, [256, 3, 2]], #22 80*80

[[-1, 18], 1, Concat, [1]], #23 80*80

[-1, 3, BottleneckCSP, [256, False]], #24 80*80

[-1, 1, Conv, [256, 3, 2]], #25 40*40

[[-1, 14], 1, Concat, [1]], # 26 cat head P4 40*40

[-1, 3, BottleneckCSP, [512, False]], # 27 (P4/16-medium) 40*40

[-1, 1, Conv, [512, 3, 2]], #28 20*20

[[-1, 10], 1, Concat, [1]], #29 cat head P5 #20*20

[-1, 3, BottleneckCSP, [1024, False]], # 30 (P5/32-large) 20*20

[[21, 24, 27, 30], 1, Detect, [nc, anchors]], # Detect(p2, P3, P4, P5)

]只需要对yolo下的yaml文件进行如上的配置,就可以大大地提高小目标监测的精度,但是处理时间可能会有所上升。好了,本文介绍到此结束,感兴趣的小伙伴给个点赞关注再走吧,欢迎下方评论区咨询各种问题!!!

文章出处登录后可见!