DocTamper: https://github.com/qcf-568/DocTamper

Introduction

文件图像是现代社会最重要的信息传播媒介之一,它包含了大量的敏感和隐私信息,如电话号码。随着图像编辑技术的快速发展,这种敏感的文本信息更容易被恶意篡改,构成欺诈等,造成严重的信息安全风险[33,42,48,50]。因此,检测文档图像中的篡改已成为近年来重要的研究课题[18,47]。开发有效的方法来检查文档图像是否被修改,同时确定篡改文本的确切位置是至关重要的。

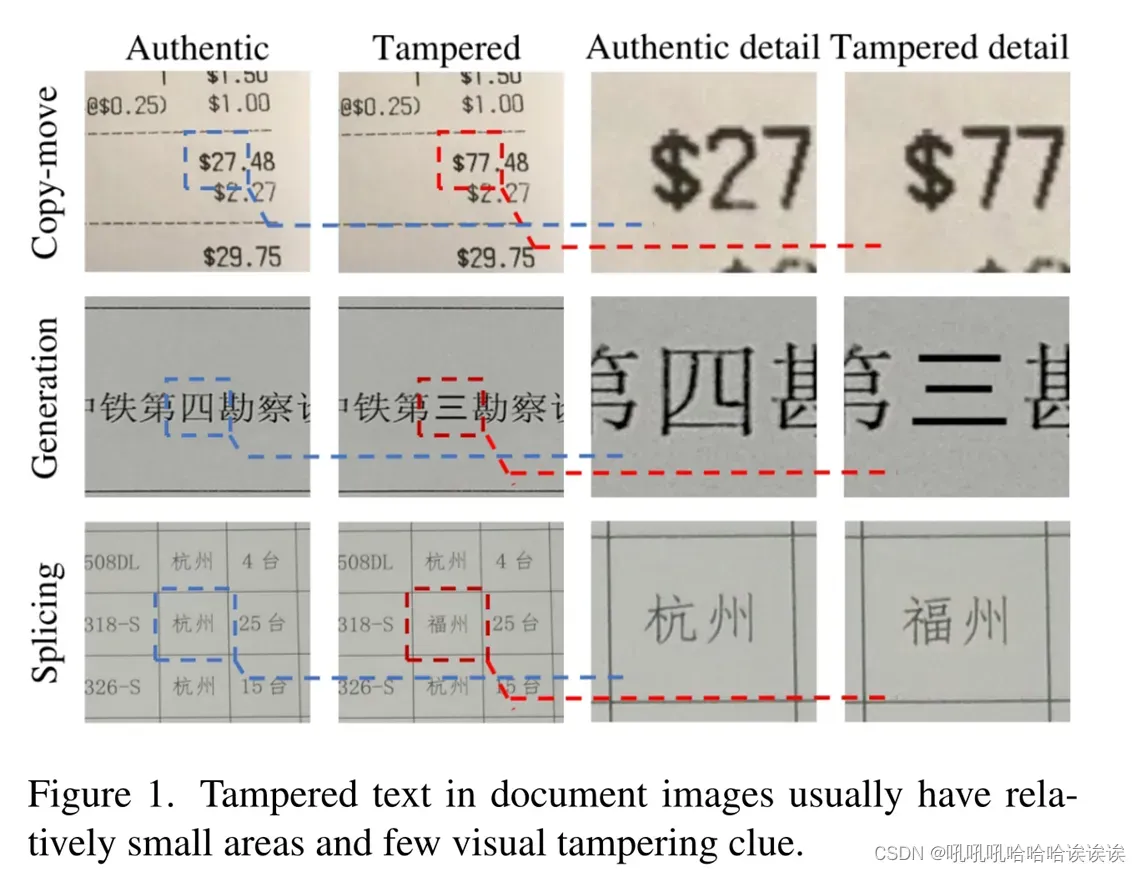

大多数文档图像中的文本篡改方法大致可以分为三种类型:(1)拼接,将一个图像中的区域复制并粘贴到其他图像中;(2) Copy-move,即移动图像内物体的空间位置;(3)生成,用视觉上似是而非的内容替换图像区域,如图1所示。虽然对自然图像的篡改检测研究已有多年[14,49],但它与文档图像的篡改检测有很大的不同。对于自然图像,篡改检测主要依赖于物体边缘或表面相对明显的视觉篡改线索,这些线索在文档中几乎不存在,尤其是复制移动和拼接[1,47]。这是因为文档图像大多具有相同的背景颜色,集群中的文本通常具有相同的字体和大小。因此,仅凭视觉线索无法有效检测出篡改文本区域。为此,本文提出结合视觉线索和频率线索来提高识别文档中篡改文本区域的能力。

最近,通过分析扫描文档上文本的外观,提出了一些很有前途的篡改文本检测方法[8,18,47]。尽管在简单和整洁的文档上取得了重大进展,但在各种照片文档中检测精心篡改的文本区域仍然是一个公开的挑战。

本文提出了一种基于多模态变换的文档图像篡改检测方法,称为文档篡改检测器(DTD)。

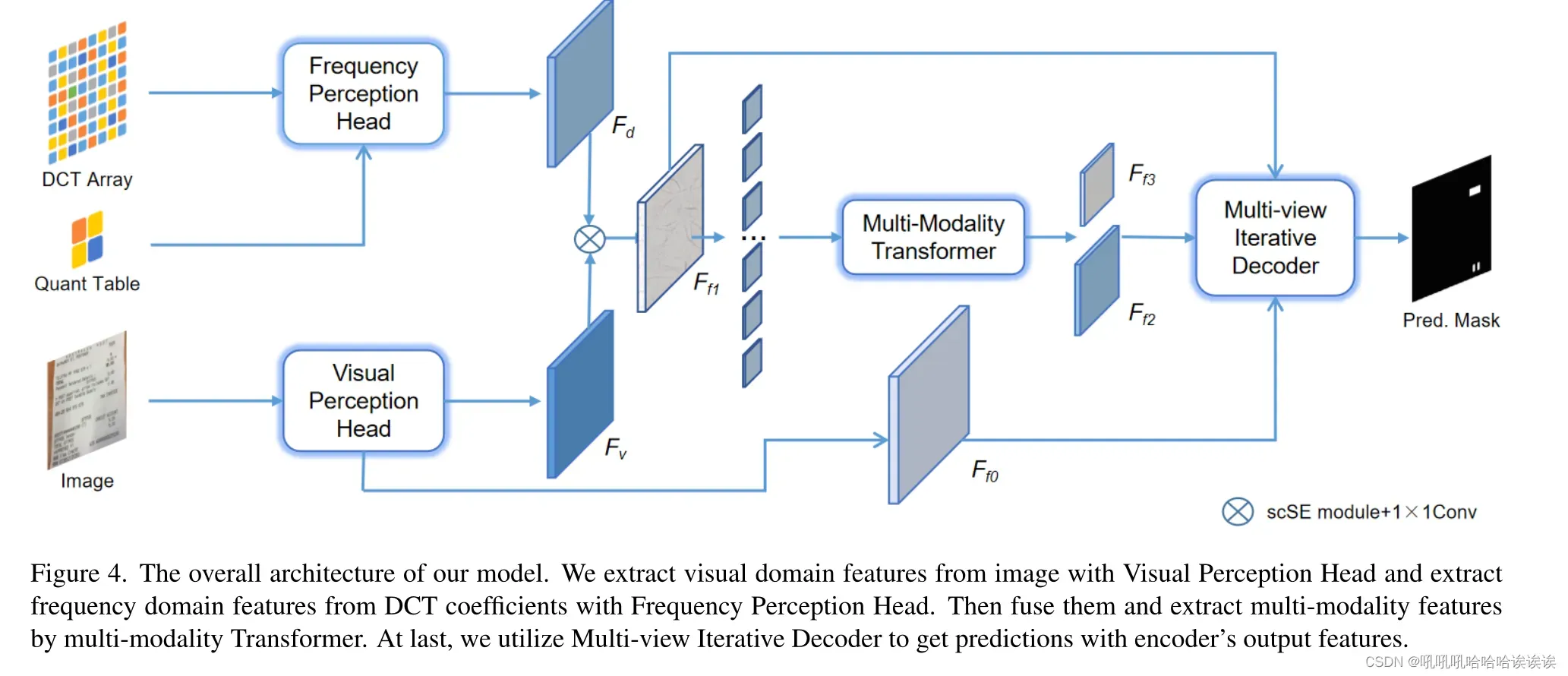

该模型同时利用了视觉域和频域的特征。前者以原始图像为输入,从视觉感知头中提取特征。对于后者,不同于之前的工作[43]利用RGB图像的高通滤波结果,我们利用DCT系数作为我们模型的频率感知头的输入来获得相应的嵌入。通过一个具有串联操作的融合模块和一个注意模块,将这两个模块的特征有效地结合在一起,然后馈送到基于swing – transformer[27]的编码器中。最后,我们引入了一种新的多视图迭代解码器来逐步感知被篡改的文本区域。

通过实验,我们发现图像压缩可以掩盖一些篡改线索,并且模型在开始时通常对其缺乏鲁棒性。在随机压缩的图像中训练会给模型带来混乱,并且它们不能很好地处理具有挑战性的DITD任务。因此,我们进一步提出了一种新的训练范式,称为课程学习的篡改检测(CLTD),以一种从易到难的方式训练模型。这样,模型首先可以学习如何准确地发现篡改线索,然后逐渐获得对图像压缩的鲁棒性。

针对目前缺乏大规模篡改文档数据集的问题,本文提出了一种新的方法来创建真实的篡改文本数据,并构建了一个包含170k不同类型篡改文档图像的大规模数据集DocTamper。

我们对我们提出的DocTamper和T-SROIE数据集[47]进行了充分的实验。定性和定量结果都表明,我们的DTD可以显著优于以前的最先进的方法。

总之,我们的主要贡献如下:

•我们引入了DTD,这是一种用于文档图像中篡改文本检测的强大的多模态模型。

•我们提出了一种新的训练范式CLTD,以增强所提出的篡改检测模型的泛化能力和鲁棒性

•我们提出了一种新的数据合成方法,仅使用未标记的文档图像有效地生成真实的篡改文档。

•我们构建了一个包含多种场景和篡改方法的全面的大规模数据集,进一步促进了篡改文本检测任务的研究

Related Works

Natural Image Manipulation Detection(自然图像处理检测):早期对自然图像操纵检测的研究主要集中在检测特定类型的操纵[12,13]。逐渐地,神经网络的快速发展极大地推动了通用操纵检测的研究[4,17,49]。Zhou等[51]介绍了在Faster-RCNN[31]中加入SRM内核[15],并使用边界框定位伪造。Bappy等[4]提出只要约束卷积[6]在特征提取和像素化检测操作中使用SRM内核[15]。Kwon等[19]利用HRNet[39]在RGB域和频域对篡改区域进行了定位。Dong等[14]利用两流CNN和约束卷积[6]提取特征,引入边缘监督分支(Edge-Supervised Branch)增强特征映射,并使用Dual Attention Module对两流CNN的输出进行融合。Liu等人引入了一种新的注意力机制来提高性能。Wang等人[43]使用图像及其高通滤波结果作为两流CNN的输入,并引入了一组查询来帮助模型在对象级定位操作。虽然上述方法取得了显著的进步,但由于篡改后的文本区域通常与真实区域具有更大的视觉一致性,因此在文档图像篡改检测中可能效果不佳。

Document Image Tampering Detection(文档图像篡改检测):早期文档图像篡改检测主要通过打印机分类[20,30,36]或模板匹配[2]来实现。一些工作[5,8,53]使用字体特征来区分真实文本和篡改文本。Beusekom等[41]通过分析文档图像中文本行位置是否与其他文本行对齐来判断文本行是否被篡改。James等[18]利用图神经网络(graph neural network, GNN)借助图注意机制检测文档图像中的篡改区域。上述方法仅适用于非常清晰和整洁的文档,例如扫描文档。Abramova等[1]基于双量化工件检测文档图像中的复制-移动篡改,当篡改后的文档图像被压缩多次时,这种方法效果不佳。Wang等人[47]使用两流Faster-RCNN[31]网络捕捉SRNet[48]留下的高频线索。然而,这类篡改线索大多存在于生成式篡改中,而在仔细的复制-粘贴篡改中很难找到。上述方法取得了令人鼓舞的进展,但它们大多是针对某些特定场景而设计的。因此,在面对各种照片文档的复杂场景时,它们缺乏足够的鲁棒性和跨域泛化能力。

DocTamper Dataset

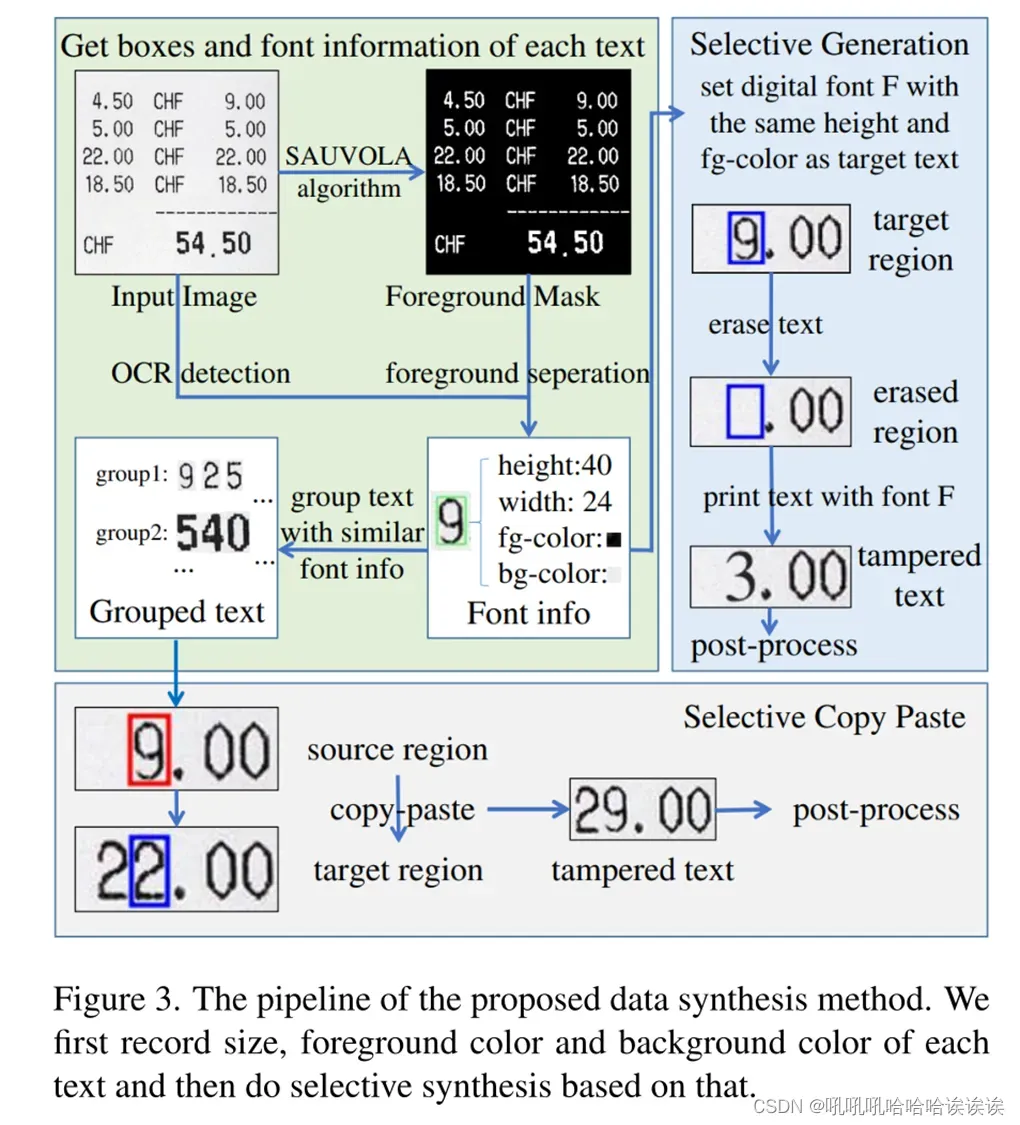

Proposed data synthesis method:在传统的图像处理检测任务中,复制-移动和拼接数据是通过从图像中复制物体并将其粘贴到随机目标区域来合成的[29,43,51]。然而在文档图像篡改文本检测领域,随机复制粘贴会产生明显的视觉不一致,这将导致合成数据与真实文本篡改之间的巨大差距。因此,我们提出选择性篡改合成来生成真实的篡改文档图像。它包含选择性复制粘贴和选择性生成。前者获取样式相似的文本组,并在分组的文本实例中进行复制粘贴,以生成篡改的文本。后者首先用OpenCV[9]或G ‘MIC[40]擦除其原始文本内容,然后用预先设置的类似样式和字体打印新文本。由于我们无法直接访问各种场景下文档图像的确切文本字体,我们建议使用这些文本的大小(包括高度和宽度)、前景色和背景色来表示它们。

Overall Pipeline:如图3所示,本文提出的文本篡改数据合成管道描述如下:(1)我们使用强大的开源OCR工具,如Paddle-OCR[21]和TesseractOCR[37],获得单词和字符的边界框。(2)我们使用SAUVOLA算法[35]将文档图像的前景从背景中分离出来,并记录每个文本的前景色和背景色。(3)采用选择性复制粘贴和选择性生成两种方法获得篡改后的文档图像。(4)最后,通过后期处理提高视觉一致性。

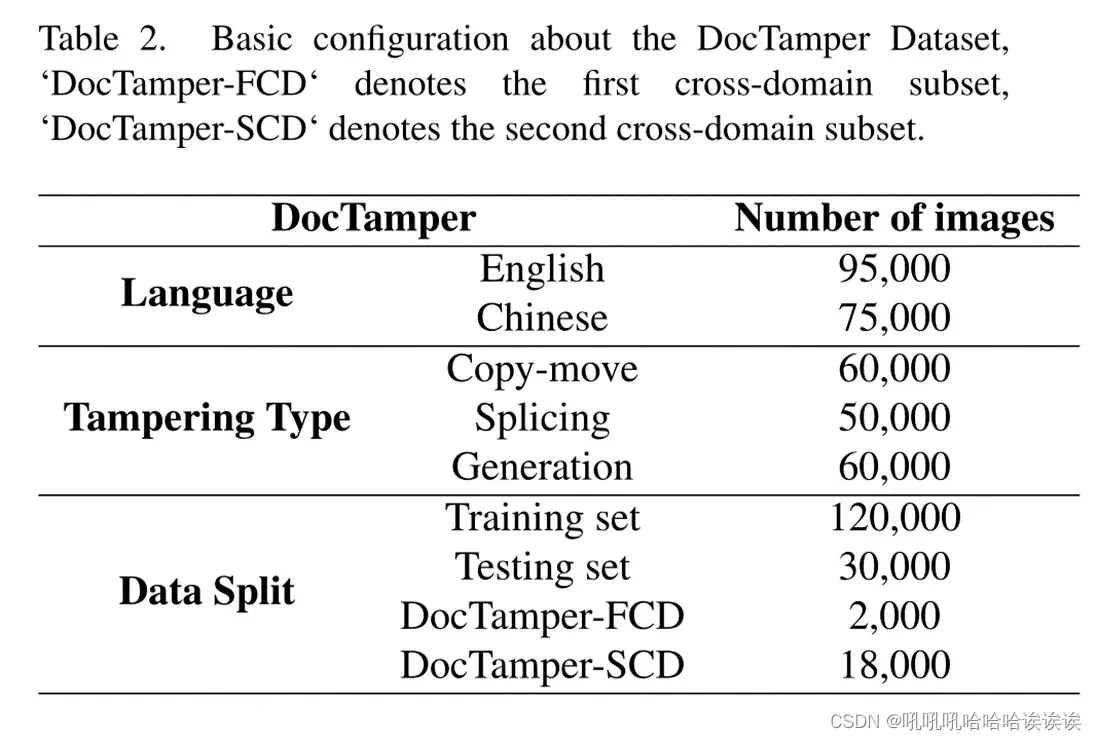

Proposed Dataset:考虑到现有数据集的小规模[46,47],我们构建了一个用于篡改文本检测任务的大规模数据集,称为DocTamper。

Dataset Description :如表2所示,DocTamper总共有170k张被篡改的文档图像,包括中文和英文。复制-移动,拼接和生成都包含在我们的数据集中,并近似均匀地应用。此外,我们将数据集分成四个子集:一个包含120k个样本的训练集;一个30k个样本的通用测试集,以及两个分别为2k和18k个样本的跨域测试集。所有被篡改的图像都不进行压缩存储,因此可以使用定制的压缩配置对它们进行训练或测试。对于所有图像,我们提供像素级注释来表示篡改的文本区域。

Cross-domain Testing Sets:以往的工作[14,19,26,49]大多采用跨域的方式对模型进行测试,测试集的图像来源和风格与训练集不同。这种跨域评价可以进一步评估方法的泛化能力。这促使我们引入两个跨域测试集。我们的第一个跨域(FCD)测试集的图像源来自Noisy Office Dataset[10],而第二个跨域(SCD)测试集的图像源来自HUAWEI Cloud[11]。与普通测试集相比,跨域测试集的图像在纹理和文档样式方面与训练集有很大的不同。提出的DocTamper数据集的主要特征可以概括如下:

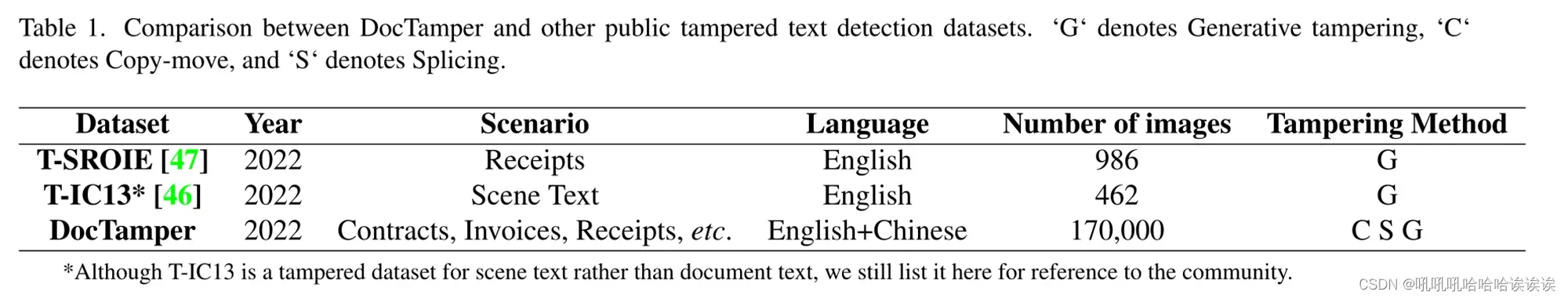

•Large Scale。如表1所示,以往作品中的公共数据集只有不到1k张图片,而DocTamper总共有170k张图片。如此大规模的数据集更有可能成为DITD任务的更好基准。

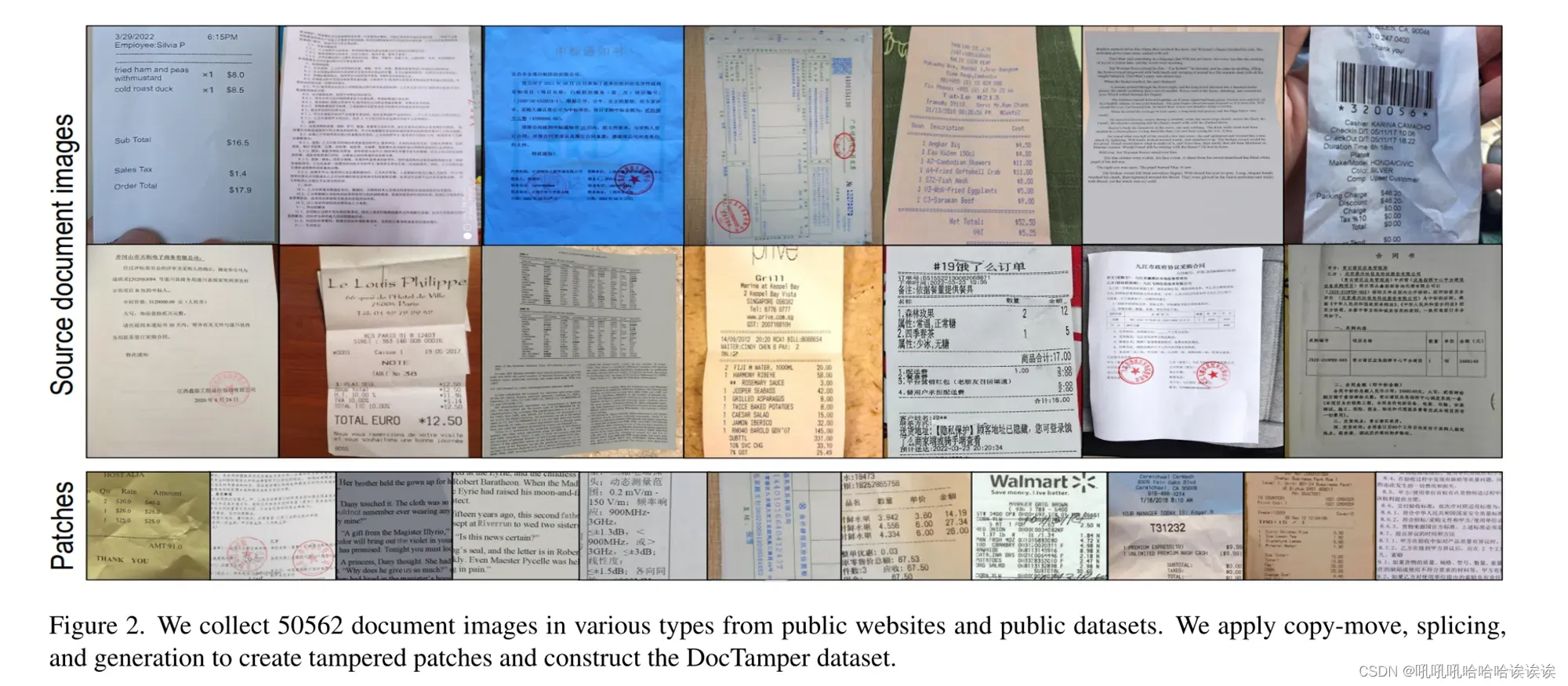

•Board Diversity。如图2所示,为了构建DocTamper数据集,我们从各种公开的网站和文档图像数据集中收集了50,562张文档图像[10,16,23,38]。我们的数据集的源图像中包含了各种双语的现实世界文档图像,包括合同、发票、收据等(DocTamper的一些代表性源图像见附录)。值得一提的是,前面的数据集分别只包含一个场景,如表1所示。

•Comprehensiveness。所有三种常用的文本篡改方法都包含在我们的数据集中,以模拟现实世界的应用程序。此外,我们引入了两个跨域测试子集,以充分评估不同方法的泛化能力。

Proposed Model

在本节中,我们提出了文档篡改检测器(DTD),这是一种用于文档图像篡改检测的新模型。总体架构如图4所示。它由四个模块组成:(1)视觉感知头,从原始图像中提取视觉特征;(2)频率感知头,将图像的离散余弦变换(DCT)系数转换为频域特征嵌入;(3)多模态编码器;(4)用于最终预测的多视图迭代解码器。

Visual Perception Head(视觉感知头):

我们使用七个堆叠的卷积块作为视觉感知头(VPH)来提取视觉特征。给定输入图像I∈,我们首先通过VPH提取I的两个视觉特征嵌入,其中

Frequency Perception Head(频率感知头):

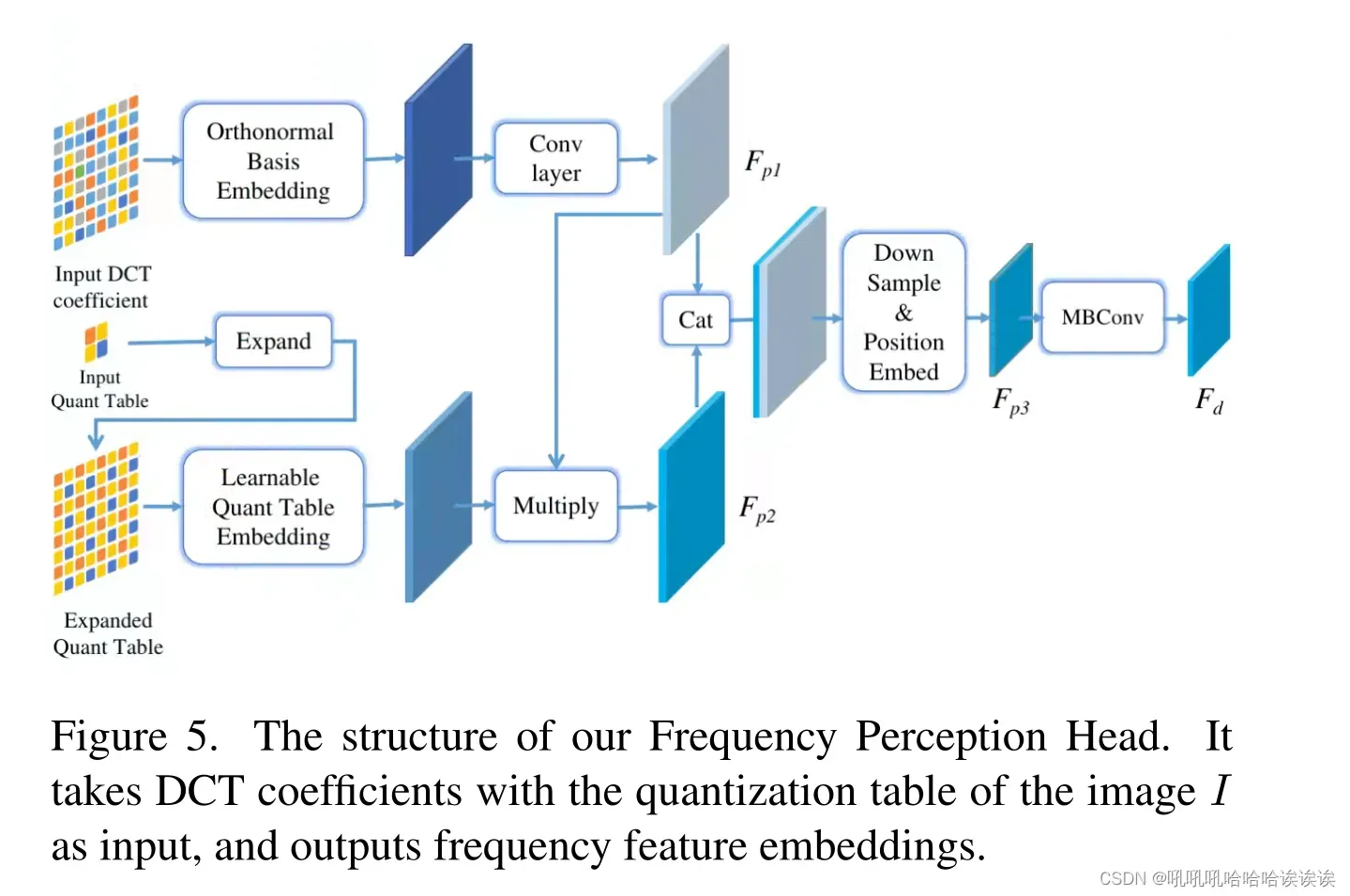

在如相机和智能手机等数字设备采集图像的过程中,通过对图像的DCT系数进行量化,对图像进行修补和压缩,从而产生块伪影网格(BAG)。对图像的篡改主要会干扰图像DCT系数的原始分布,造成篡改区域与真实区域之间的BAG不连续。因此,DCT系数的特征很好地捕捉了BAG的不连续点,可以作为定位篡改区域的另一个重要线索,弥补了视觉特征不明显所带来的不足。因此,我们设计了频率感知头(FPH)来捕捉频域的篡改线索。我们的DTD通过提出的FPH在识别几乎没有可视化篡改痕迹的篡改文本方面有很大的好处。

如图5所示,所提出的FPH结构采用双头部设计。给定输入图像I∈,我们首先将其转换为YCrCb颜色空间,并计算其大小为H×W的Y通道DCT系数图。然后第一个头部使用一组标准正交基嵌入DCT系数图,通过两个堆叠的卷积层得到特征

∈

。对于第二个头部,我们首先从图像I中提取Y通道量化表,然后我们扩展量化表以匹配DCT系数,然后使用一组可学习的参数嵌入它们。然后将量化表嵌入与

相乘,得到

∈

。对于

和

,我们直接将它们连接在一起,并使用步长为8的卷积层对它们进行下采样到

∈

。这样,

的每个像素可以表示原始DCT系数中的每个8×8块,与I的BAG匹配。此外,我们利用CoordConv[25]在

上进行位置嵌入,增强它们的位置信息,使它们更好地与视觉特征对齐。然后在

上应用三个有效扩大感受野和增强特征的MobileConv层[34],得到频率特征嵌入

;

Multi-Modality Modeling(多模建模):

我们提出用多模态编码器融合频域和视觉域的特征。如图4所示,给定视觉感知头的输出和频率感知头的输出

,我们通过scSE模块[32]将它们连接并合并在一起。然后应用1 × 1的卷积层进行降维,得到

∈

。通过多个Swin Transformer[27]块,为解码器提取两个更高层次的多模态特征

∈

和

∈

。

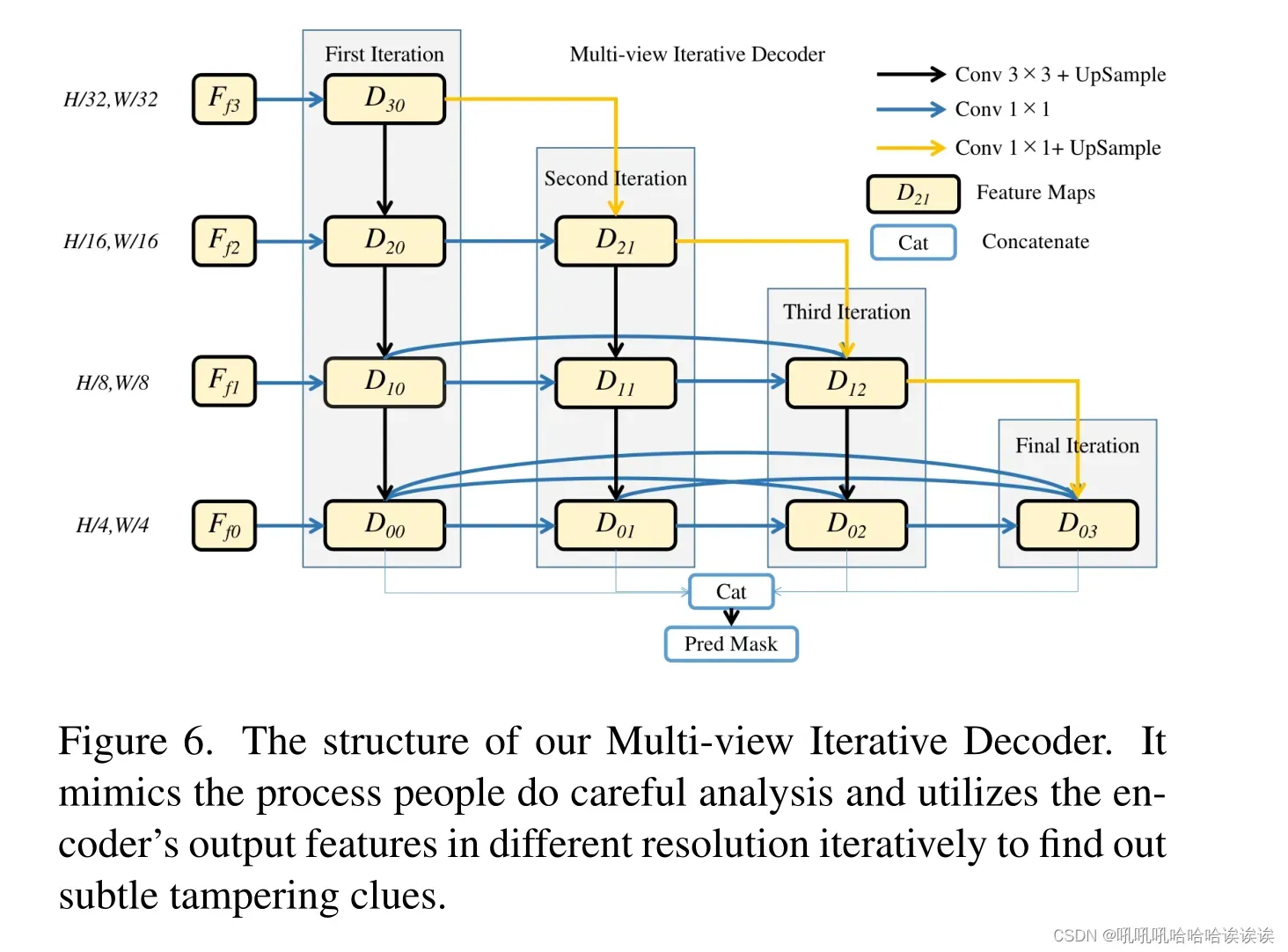

Multi-view Iterative Decoder(多视图迭代解码器):

人们在分析图像上的一个小区域是否异常时,往往是反复放大缩小,将多视图信息迭代结合,得出最终结论。为了模拟人类的感知方式,我们提出了一种新的解码器框架,称为多视图迭代解码器(MID),以充分利用不同尺寸的特征,从而预测更准确的结果。我们的MID结构如图6所示。给定编码器的输出特征,

,

,

,我们通过四次级联迭代操作计算n = 0,1,2,3的解码器特征

。最后,将n = 0,1,2,3时的

串联在一起,预测最终结果

。这个过程可以用公式(1)和(2)来表示:其中Cat(.)表示连接操作,Project(.)表示得到最终预测的卷积层。

Loss Function:

给定输入图像I的预测掩码,其真值掩码为

。我们用以下损失函数训练我们的模型:

,其中

表示交叉熵损失,

表示Lovasz损失[7]。

Curriculum Learning for Tampering Detection(篡改检测课程学习):

课程学习(CL)是一种模仿人类课程中有意义的学习顺序,从简单的数据向困难的数据训练机器学习模型的训练策略。在本节中,我们设计了一个新的训练范例,称为篡改检测的课程学习(CLTD),通过动态控制图像压缩增强的质量,以一种从易到难的方式训练篡改文本检测模型。我们发现它可以显著提高模型对不同图像压缩的鲁棒性和跨域泛化能力。在具体实现中,我们从范围(B1, 100)中动态选择随机JPEG压缩质量因子,其中B1随机动态地从(100-S/T, 100)中选择,S为当前训练步数,T为手动预设的常数。与在整个训练过程中均匀选择随机质量因子相比,具有CLTD的模型在一开始更有可能遇到未压缩的图像。

Experiments

Evaluation Metric(评价指标): 根据之前在图像处理检测方面的工作[14,19,26,49],我们将篡改检测任务建模为二值语义分割,并采用IoU、Precision、Recall和F-score作为DocTamper数据集的评价指标。对于T-SROIE数据集,我们按照之前的工作[47]使用Precision, Recall和F-score。 Implementation Details: 我们将模型的输入大小设置为512×512,并利用Swin -small[27]的最后三个阶段进行多模态建模。我们使用AdamW[28]进行优化,初始学习率为3e-4。我们训练我们的模型100k次迭代,批大小为12,学习率以余弦曲线的方式单调衰减到1e-5。对于CLTD, T设置为8192。所有模型都使用动态JPEG压缩进行训练,以匹配测试集的配置。JPEG压缩的质量因子在75 ~ 100之间随机选择,压缩次数在1 ~ 3之间随机选择。预测以0.5的阈值进行二值化。在T-SROIE数据集[47]上的实验中,由于图像的尺寸较大,我们采用滑动窗口的方式获得推理结果。

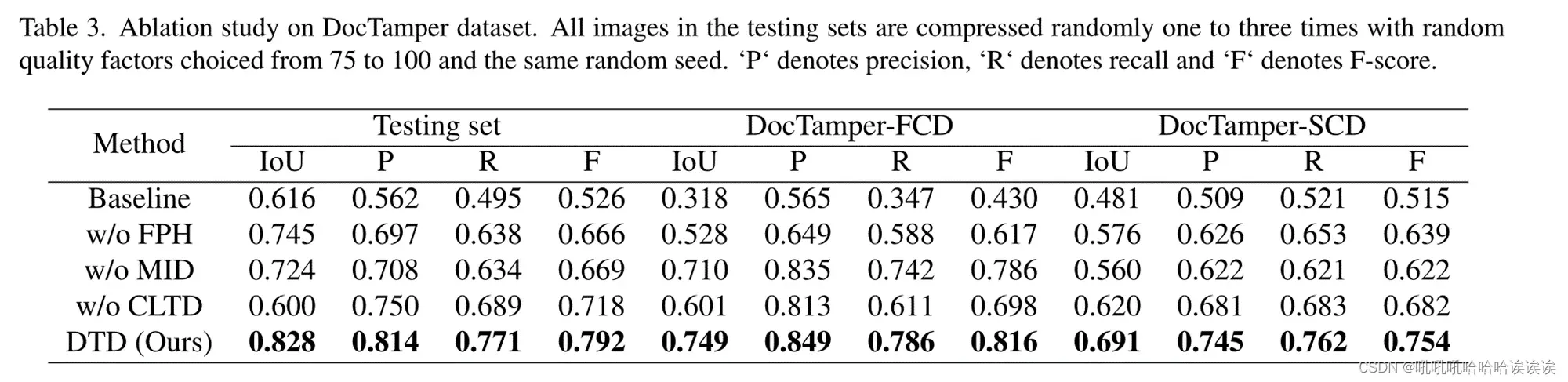

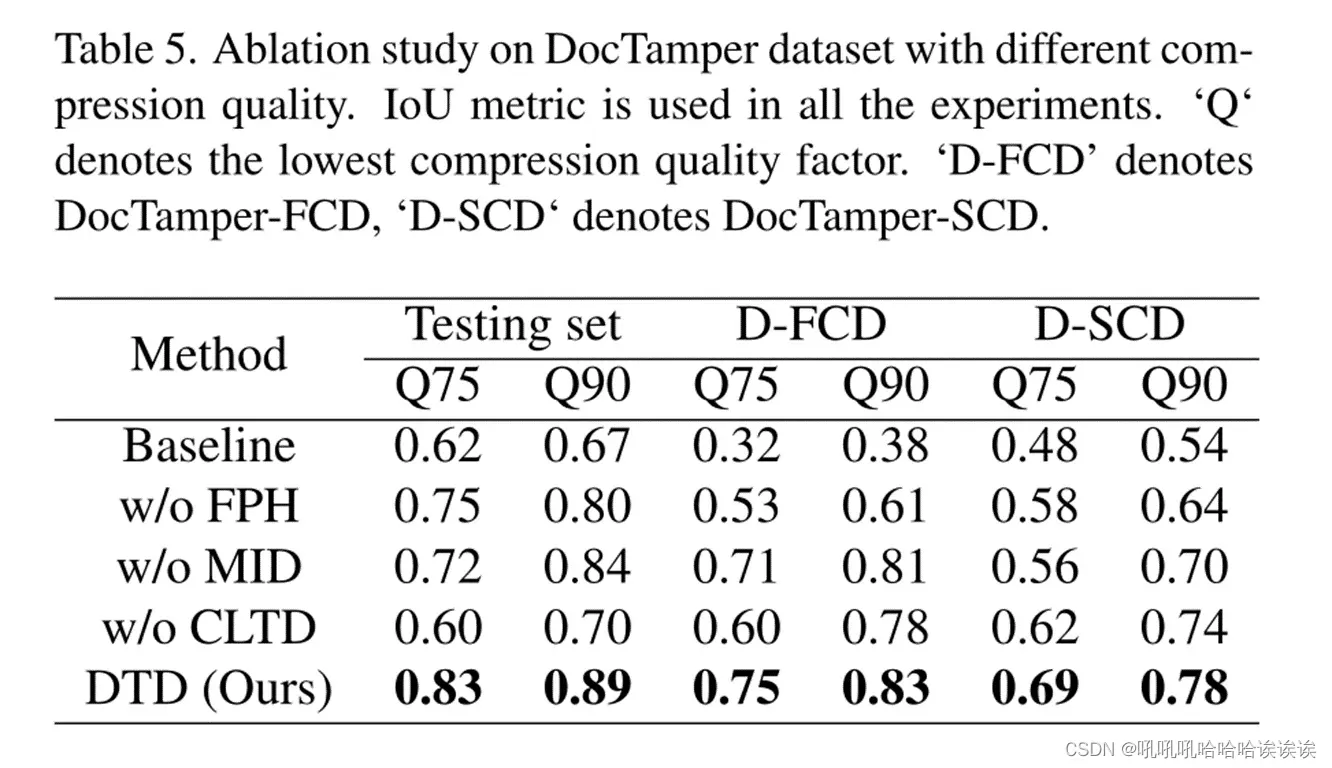

Ablation Analysis:频率感知头(FPH)利用DCT系数在频域发现篡改线索,而多视图迭代解码器(MID)则充分利用编码器的输出特性,捕捉细微篡改线索。提出的篡改检测课程学习(CLTD)是为了帮助模型获得更好的鲁棒性和泛化能力。为了评估FPH、MID和CLTD的有效性,我们将它们分别从DTD中移除,并在DocTamper数据集上评估篡改文本检测性能。没有FPH, MID和CLTD的DTD作为消融研究的基线模型。定量结果如表3所示。我们还对不同图像压缩设置的测试集进行了消融实验,结果如表5所示。

我们可以观察到,在没有FPH的情况下,模型的性能在所有实验中都有明显的下降。这表明FPH提取的频域特征可以极大地帮助我们的模型捕获文档图像中不可见的篡改痕迹。此外,模型的跨域泛化能力在没有提出FPH的情况下会有更大的下降。这解释了所提出的FPH可以帮助模型学习篡改的基本特征,而不是过度拟合与篡改操作无关的特定视觉模式。

在对所提出的MID模块的消融研究中,我们将其替换为具有可比参数的普通FPN[24]结构解码器。在所有的实验中,该模型的性能也有明显的下降。结果表明,该模型通过对多视图特征进行全面有效的交互,可以帮助模型捕捉细微的篡改痕迹,并从不相关的视觉模式中区分出篡改特征。

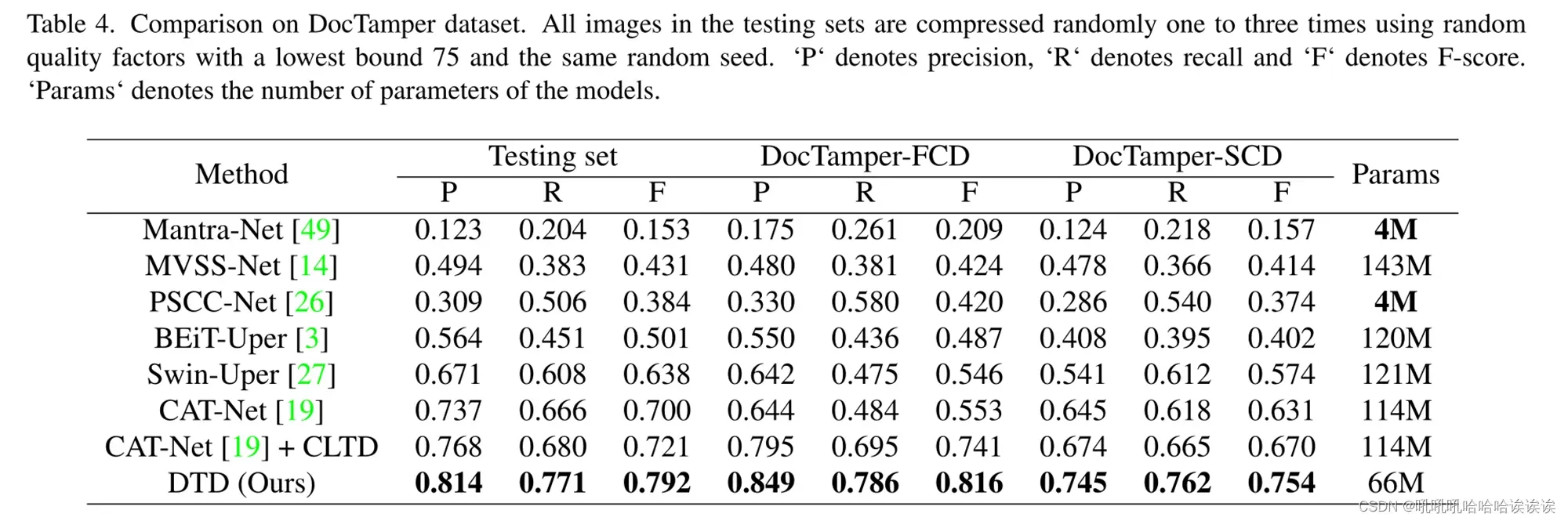

当动态图像压缩质量因子在随机范围内均匀选择时,不使用所提出的CLTD,模型在所有测试数据集上的性能和泛化能力都有明显的下降。这是因为模型太混乱,无法很好地学习提取特征。值得注意的是,该数据集中之前最先进的模型CAT-Net[19]也可以从CLTD中获益良多,如表4所示,这显示了CLTD先进的泛化能力。

Comparison with state-of-the-art methods:

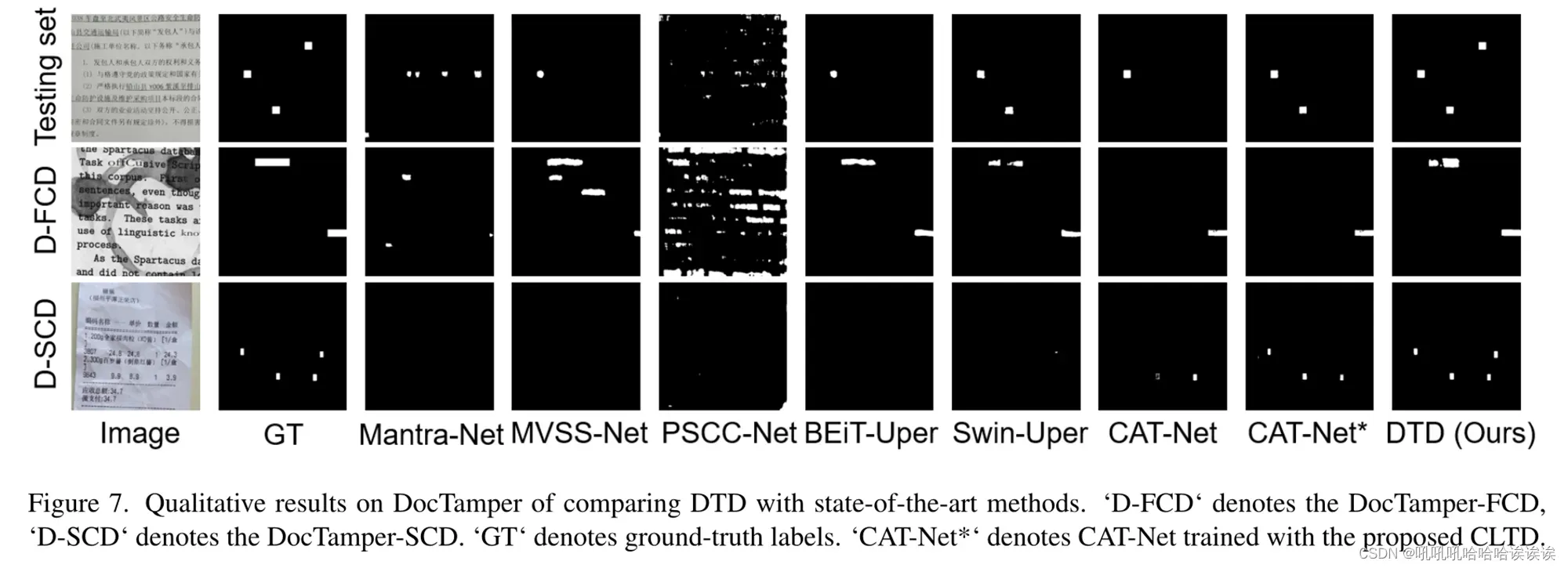

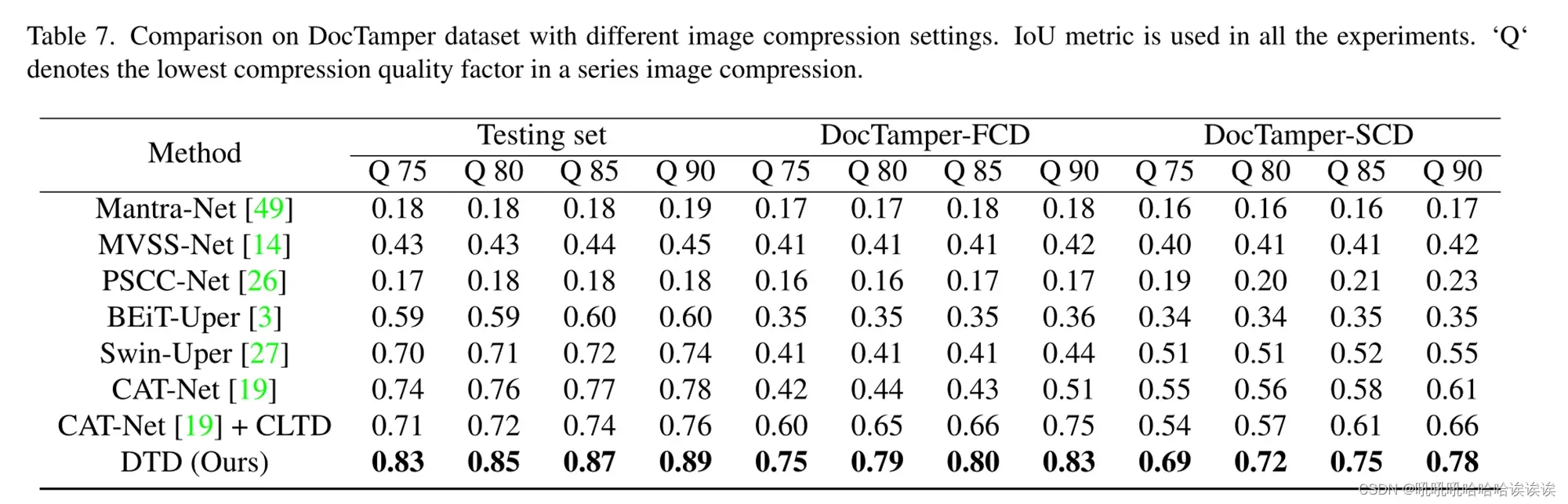

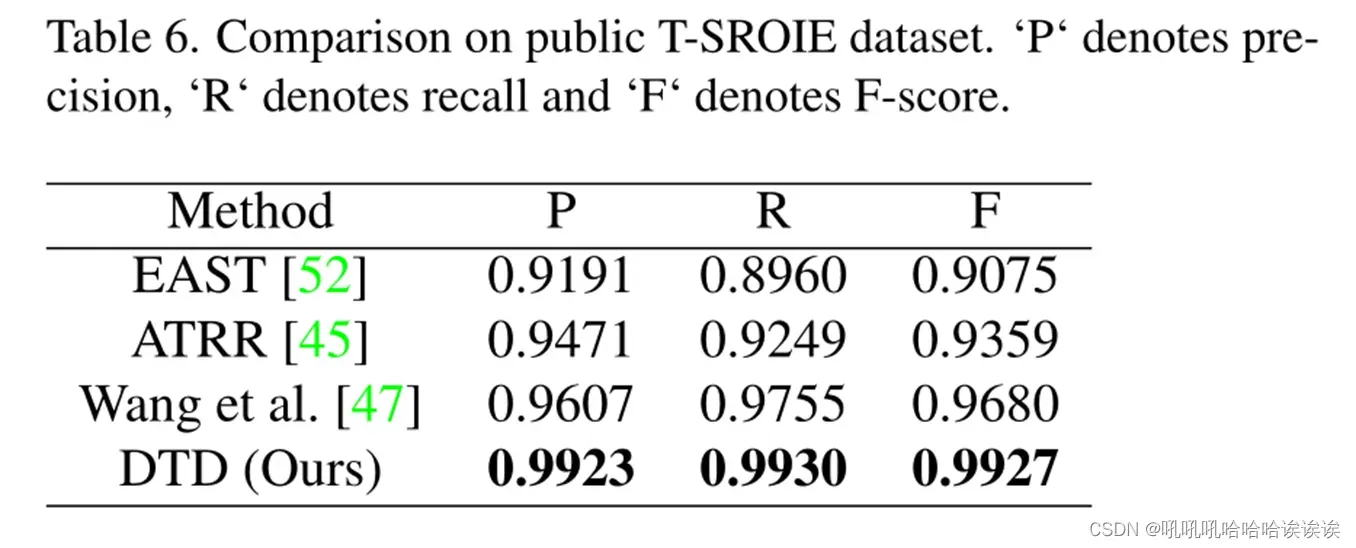

我们将我们的方法与一些最先进的图像处理检测方法[14,19,26,49]和语义分割方法[3,27]及其官方发布的代码进行比较,如表4所示。我们也使用与我们相同的训练配置来实现它们,并选择较好的结果作为最终结果。结果表明,我们的DTD在文档图像篡改检测能力和跨域泛化能力方面都明显优于其他方法。我们还观察到,其他模型,特别是那些纯视觉模型,更容易过度拟合训练数据中的某些特定视觉模式,而不是学习发现篡改线索的能力。因此,在两个跨域子集上,它们表现出较差的跨域泛化能力,这在实际文档图像篡改检测应用中至关重要。目测比较的定性结果如图7所示。此外,我们使用不同压缩配置的测试集进行了实验,如表7所示。结果表明,该方法在各种场景下均表现出优异的性能、鲁棒性和出色的泛化能力。如表6所示,我们的模型在公共T-SROIE数据集上也明显优于其他方法。

Conclusion

在本文中,我们提出了一种新的篡改文本检测框架,称为文档篡改检测器(DTD)。具体来说,DTD设计了一个频率感知头来弥补由于视觉特征不明显而造成的缺陷。DTD结合视觉特征和频率特征,采用多视图迭代解码器逐步感知被篡改的文本区域,以预测更准确的结果。此外,为了提高算法的鲁棒性和泛化能力,在DTD的优化过程中引入了篡改检测的课程学习,以解决图像压缩带来的混乱问题。为了方便文档中的篡改文本检测,我们进一步提出了一种新的选择性篡改合成方法来生成足够的真实数据,并构建了一个包含170k不同类型文档图像的大规模数据集DocTamper。大量的实验证明了我们的模型的优越性能,它可以在DocTamper和T-SROIE基准测试中实现最先进的结果。

文章出处登录后可见!