🦉 AI新闻

🚀 开源MoE大模型震惊开源社区

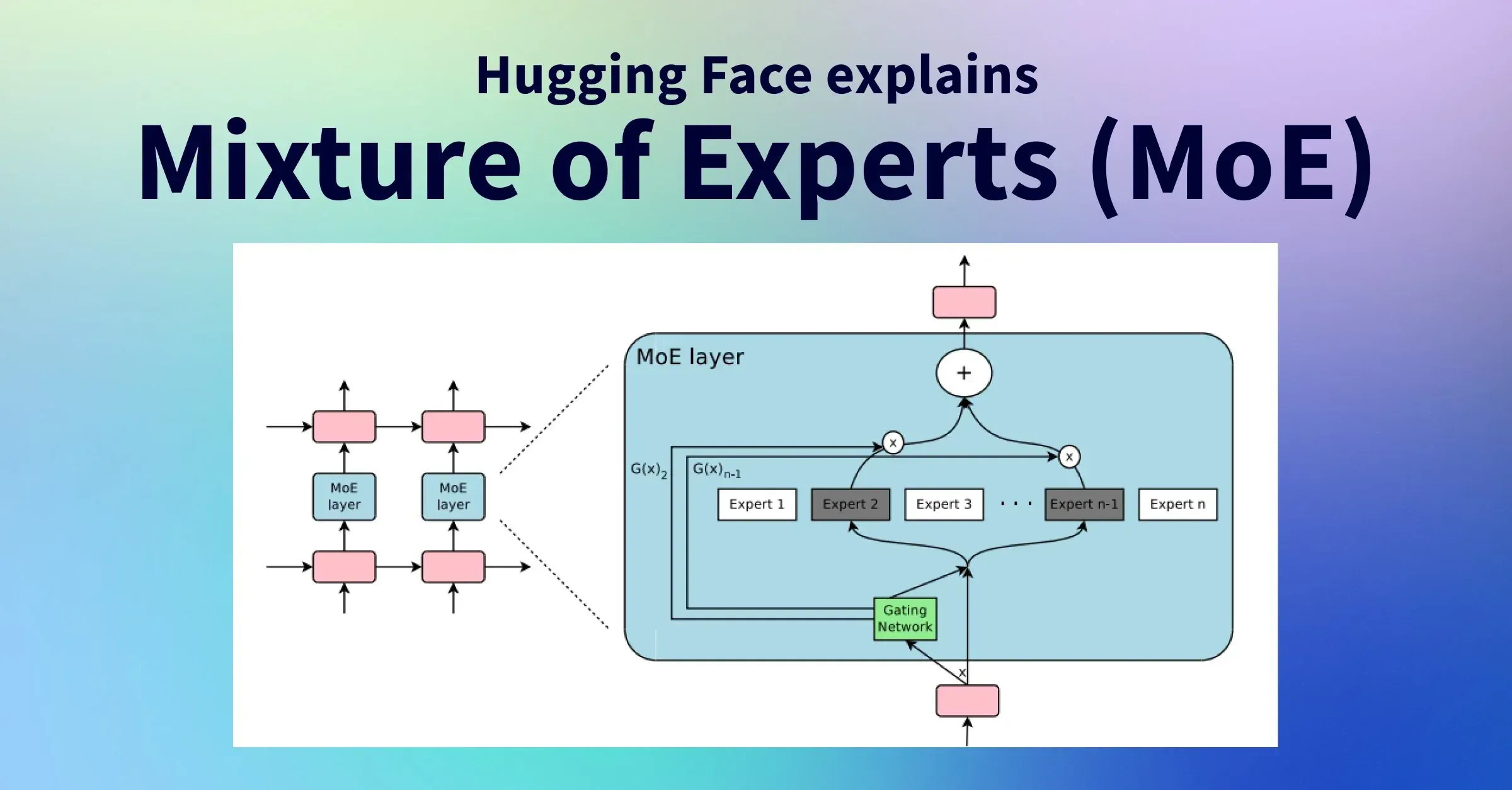

摘要:上周末,Mistral开源了一款震惊开源社区的MoE大模型。MoE是一种神经网络架构设计,能够提升大语言模型的性能。通过使用MoE,每个输入token都可以动态路由到专家子模型进行处理,实现更高效的计算和更好的结果。MoE的关键组件包括专家和路由器,专家可以专门处理不同任务或数据的不同部分,而路由器用于确定将哪些输入token分配给哪些专家。MoE在Transformer等大语言模型中发挥重要作用,能够添加可学习参数、利用稀疏矩阵高效计算以及并行计算专家层等。Mistral的7B×8E的开源模型性能已经接近GPT-4,对开源社区产生了巨大影响。

🚀 大模型在窗口测试中面临的问题得到解决

摘要:最近的一个极限测试发现,大模型在窗口测试中的使用方式存在问题,导致无法发挥出AI的实力。然而,通过在回答开头添加一句特定语句,可以显著提高大模型的回答准确率,这一方法已经在测试中得到验证。此外,月之暗面大模型团队也提出了不同的解决方案,并取得了好的成绩。虽然该实验存在一定的局限性,但为大模型的改进提供了有价值的指导。这一研究引起了广泛的关注和讨论。

总分数: 85

🚀 ChatGPT在获取医疗信息上准确率低

摘要:根据长岛大学的研究,ChatGPT并不适合用来获取医疗信息。该研究对ChatGPT询问了39个与药物相关的问题,并将其回答与经过培训的药剂师编写的答案进行比较。结果显示,ChatGPT只有约四分之一的回答准确,对其他问题的回答要么不完整,要么不准确,要么没有解决问题。研究发现,不准确甚至危险的答案可能会给使用者带来风险。由于其在公众中的普及率,研究人员建议消费者在寻找医疗信息时使用可靠的政府网站。

总分数:70

🚀 OpenAI承认ChatGPT和GPT-4 API存在问题并将彻底修复

摘要:OpenAI近期遭到部分用户投诉,称使用ChatGPT和GPT-4 API时会出现回应速度慢、敷衍回答、拒绝回答、中断会话等问题。OpenAI承认了问题的存在,并表示将彻底修复。该公司解释称,GPT-4变懒惰是因为该模型自11月11日起停止更新,而GPT模型的不可预测性导致了用户的不满。OpenAI正在修复这些问题,并鼓励用户积极反馈模型表现。此外,人事动荡和CEO离职也导致了OpenAI日常事务呈现混乱局面。GPT-4模型停更导致GPT Store的上线也被延期到2024年初。

总分数:80

🚀 剑桥大学研究:AI模型与人脑神经结构相似或成为未来AI设计关键

摘要:剑桥大学的最新研究表明,AI模型与人脑神经结构有许多相似之处,这可能成为未来AI模型设计的关键。研究团队通过模拟简化的大脑模型,施加物理限制,让AI系统自我组织并生成类似人脑的关键特征和发展策略。这项研究对于理解人脑差异以及认知和心理健康方面的困难具有重要意义。AI界也对该研究表现出了兴趣,因为它有助于开发更高效的AI系统,尤其在存在物理限制的情况下。研究给设计未来人工智能系统提供了启示,并指出问题类型将影响选择架构的强大性。

🗼 AI知识

🔥 混合专家:训练和推理中的权衡与挑战

本文介绍了混合专家(Mixture of Experts,MoEs)模型的基本概念和训练方法。MoEs模型使用稀疏的专家层替代了传统的密集前馈神经网络层,同时通过一个路由器网络将输入数据分配给不同的专家。MoEs模型在预训练和推理过程中都具有较高的效率,但也面临着训练困难和内存需求高的挑战。MoEs模型的发展源于对条件计算和专家组件的研究,可以在相同计算资源下训练更大的模型。文章还介绍了MoEs模型的历史发展和一些应用领域,以及解决MoEs模型中的稀疏性和负载平衡问题的方法。

🔥 Mistral AI发布开放权重的高质量SMoE模型Mixtral 8x7B

Mistral AI发布了Mixtral 8x7B模型,它是一种高质量的稀疏专家混合模型,具有开放权重。该模型在大多数基准测试中优于Llama 2 70B,并具有6倍的更快推理速度。它是一种开放权重模型中最强大的模型,具有宽松的许可证,并在成本/性能权衡方面是最佳模型。Mixtral是一种稀疏的专家混合网络,它可以优雅地处理32k个标记的上下文,并在英语、法语、意大利语、德语和西班牙语处理方面表现出色。它还可以进行微调,成为一个达到8.3分的指令跟随模型。

更多AI工具,参考国内AiBard123,Github-AiBard123

文章出处登录后可见!