期末复习题一

一、选择题

1.【多选题】在卷积神经网络中,常用的池化方法有 (ABC)

A. 最大池化法

B. 平均池化法

C. 概率池化法

D. 最小池化法

2.【单选题】本原问题所对应的节点称为 (B)

A. 端节点

B. 终叶节点

C. 子节点

D. 父节点

3.【单选题】支持向量机算法属于 (B)

A. 决策树学习

B. 统计学习

C. 集成学习

D.记忆学习

4.【单选题】Teacher(father(Zhan))的个体是 (C)

A. 常量

B. 变量

C. 函数

D.谓词

5.【多选题】BP网络的优点是 (ABC)

A. 很好的逼近特性

B. 具有较强的泛化能力

C. 具有较好的容错性

D.收敛效率高

6.【单选题】当P为F,Q为F,R为T时,(P ∨ Q) ↔ R的真值是 (B)

A. T

B. F

C. 不确定

7.【单选题】

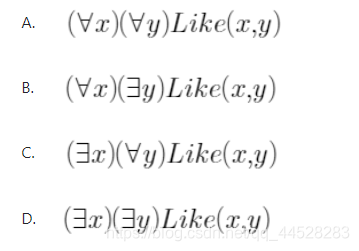

是(B)

A. 结合律

B. 连接词化归律

C. 分配律

D. 德•摩根律

8.【多选题】思维方式有 (ACD)

A. 抽象思维

B. 逆向思维

C. 形象思维

D.灵感思维

9.【单选题】在有序搜索中,如果节点x在希望树中,若x是 (C),则其所有子节点都在希望树中。

A. 终叶节点

B. 端节点

C. 与节点

D.或节点

10.【单选题】基于状态空间的搜索算法是 (A)

A. A*算法

B. 与或树搜索

C. 极大极小分析法

D. α-β剪枝技术

11.【单选题】神经网络是 (B)学派的成果

A. 符号学派

B. 联接学派

C. 行为学派

D. 统计学派

12.【多选题】2006年,深度学习元年,深度学习之父Hinton提出了哪些观点:(ABCD)

A. 多层人工神经网络模型可以有很强的特征学习能力。

B. 深度学习模型对原始数据有更本质的表达。

C. 深度神经网络可以采用逐层训练方法进行优化。

D. 训练时可以将上层训练好的结果作为下层训练过程中的初始化参数。

13.【多选题】机器学习包括 (ABC)

A. 监督学习

B. 强化学习

C. 非监督学习

D. 群体学习

14.【单选题】极大极小分析法中,用于极大极小分析法中计算各节点分数的是 (A)

A. 估价函数

B. 代价函数

C. 启发式函数

D.价值函数

15.【单选题】如果问题存在最优解,则下面几种搜索算法中,( D)可以认为是“智能程度相对比较高”的算法。

A. 深度优先搜索

B. 宽度优先搜索

C. 有界深度优先搜索

D.启发式搜索

16.【单选题】置换是一个形如{ t1/x1, t2/x2, …, tn/xn }的有限集合:xi可以是(B)

A. 常量

B. 变元

C. 函数

D.谓词

17.【单选题】消去存在量词时,当 (B)时,用skolem函数

A. 存在量词未出现在全称量词的辖域内时

B. 存在量词出现在全称量词的辖域内时

C. 以上情况都需要

D. 以上情况都不需要

18.【单选题】产生式规则的形式化描述遵循 (A)

A. 巴科斯范式

B. 前置范式

C. 斯科林范式

D. 合取范式

19.【多选题】不确定性推理,包括(ABCD)

A. 主观Bayes推理

B. 证据理论

C. 模糊推理

D.概率推理

20.【多选题】槽值可以是 (ABCD)

A. 数值、字符串

B. 布尔值或是动作

C. 过程

D.框架名

二、填空题

1.框架A的某个槽值是另一个框架B时,则称框架A与框架B之间具有 横向联系

2.

P(y)

3.产生式系统的推理方式有正向推理,反向推理与 混合推理

4.当P与Q为F,R为T时,(P ∨ Q)→ R的真值是 T

5.人工智能的终极目标是 探讨智能形成的基本机理,研究利用自动机模拟人的思维过程

6.中文屋子实验是为了证明 即使通过图灵测试也不能说明计算机能思维

7.卷积核与特征图之间是 一一对应 关系,即一个输入图如果有六个卷积核心,就应该产生 六 个特征图

8.从问题的初始状态集,经过一系统列的算符运算,到达目标状态,所经过算符的序列叫 问题的解

9.设有如图4-26的与/或/树,请分别按和代价法及最大代价法求解树的代价

和代价是 21

最大代价是 10

10.从Open表的所有节点中选择一个估价函数值最小的进行扩展的A算法叫 全局择优

三、判断题

1.(F)将一个复杂的问题分解为几个子问题的过程称为分解。可用或树表示,将一个复杂的问题变换成若干个等价的问题的过程称为等价变换。可用与树表示

2.(T)Boosting方法和Bagging方法都属于集成方法,但是产生训练样本的方式不同

3.(F)任何文字的合取式称为子句。

4.(T)语义网的聚类关系与实例、分类、成员关系的主要区别是聚类关系一般不具备属性的继承性

5.(T)一定存在一个BP神经网络能够逼近给定的样本或者函数

6.(T)自然演绎推理与归结演绎推理属于确定性推理

7.(F)卷积神经网络中,对不同位置的特征进行聚合统计,称为池化 (pooling)。池化不会丢失图像的信息,也不会降低其空间分辨率。

8.(F)“与\或”树始终是站在双方的立场上得出来的

9.(T)如果已确定某个节点为可解节点,则其不可解的后继节点可以从搜索树中删除,如果确定某个节点是不可解节点,则其全部后继节点都可以从搜索树中删除。

10.(F)两个A*启发策略的h1和h2中,如果对搜索空间中的任一状态n都有h1(n) ≤ h2(n),就称策略h1比h2具有更多的信息性

四、简答题

1.卷积神经网络设有如下特征图,给定池化窗口为2*2,请分别用最大池化法和平均池化法求出池化后的输出特征图。

2.

S={P(x, f(x))∨¬Q(x, f(x))∨R(x, f(x))}

3.对下列各题分别证明G是否为F1,F2,…,Fn的逻辑结论

4.有一农夫带一条狼,一只羊和一框青菜与从河的左岸乘船倒右岸,但受到下列条件的限制:

(1) 船太小,农夫每次只能带一样东西过河;

(2) 如果没有农夫看管,则狼要吃羊,羊要吃菜。

请设计一个过河方案,使得农夫、浪、羊都能不受损失的过河,画出相应的状态空间图

5.请简要解释BP学习算法的正向传播与反向传播的含义?

正向传播:输入信息由输入层传至隐层,最终在输出层输出。

反向传播:修改各层神经元的权值,使误差信号最小。

期末复习题二

一、选择题

1.【多选题】博弈树算法包括(CD)

A. A*算法

B. 与或树搜索

C. 极大极小分析法

D. α-β剪枝技术

2.【单选题】一阶谓词的个体不能是 (D)

A. 常量

B. 变量

C. 函数

D.谓词

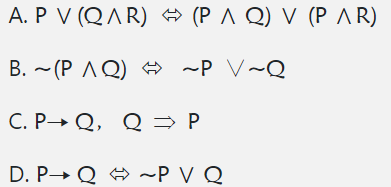

3.【单选题】

描述的是(B)

A. 事实性知识

B. 规则性知识

C. 控制性知识

D.元知识

4.【单选题】Teacher(father(Zhan))的个体是 (C)

A. 常量

B. 变量

C. 函数

D.谓词

5.【单选题】设P和Q是两个谓词公式,D是它们共同的个体域,若对于D上的任何一个解释P和Q都有相同的真值,则称P和Q在D上 (D)

A. 永真

B. 永假

C. 不可满足

D. 等价

6.【单选题】视觉、听觉、触觉、嗅觉属于智能的什么能力 (A)

A. 感知能力

B. 记忆与思维能力

C. 学习能力

D.行为能力

7.【单选题】认为智能取决于知识的积累量及一般化程度的理论是(B)

A. 思维理论

B. 知识阈值理论

C. 进化理论

D.控制理论

8.【单选题】研究机器人的“说”、“写”、 “画画”属于人工智能的什么研究内容(D)

A. 知识表示

B. 机器感知

C. 机器学习

D.机器行为

9.【单选题】人工智能的目的是让机器能够 (D),以实现某些脑力劳动的机械化。

A. 具有智能

B. 和人一样工作

C. 完全代替人的大脑

D.模拟、延伸和扩展人的智能

10.【单选题】人工智能中通常把 (B)作为衡量机器智能的准则

A. 图灵机

B. 图灵测试

C. 中文屋思想实验

D.人类智能

11.【多选题】启发信息的作用可以分为 (ABC)

A. 用于确定某些应该从搜索树中抛弃或修剪的节点

B. 用于决定要生成哪一个或哪几个后继节点

C. 用于决定应先扩展哪一个节点

D. 用于决定节点的类型

12.【单选题】专家系统是 (A)学派的成果

A. 符号学派

B. 联接学派

C. 行为学派

D. 统计学派

13.【单选题】对于谓词公式 ,以下说法错误的是(C)

,以下说法错误的是(C)

A. 上述公式中的所有 y 是自由变元。

B. P(x, y) 中的 x 是约束变元。

C. R(x, y) 中的 x 是约束变元。

D.Q(x, y) 中的 x 是约束变元。

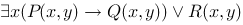

14.【单选题】(B)表示“每个人都有喜欢的人”。

15.【单选题】以下等价式错误的是(C)

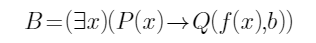

16.【单选题】设个体域D={1,2},求公式 ,设对个体常量b,函数f(x)指派的值分别为: b=1, f(1)=2, f(2)=1, 对谓词P,Q:P(1)=F, P(2)=T, Q(1,1)=T, Q(2,1)=F,谓词的真值是 (A)

,设对个体常量b,函数f(x)指派的值分别为: b=1, f(1)=2, f(2)=1, 对谓词P,Q:P(1)=F, P(2)=T, Q(1,1)=T, Q(2,1)=F,谓词的真值是 (A)

A. T

B. F

C. 不能确定

D. 都不是

17.【单选题】决定人工神经网络性能的三大要素中没有(B)

A. 神经元的特性

B. 神经元个数

C. 神经元之间的连接形式,即拓扑结构

D.学习规则

18.【单选题】卷积神经网中,如果特征图是32×32矩阵,池化窗口是4×4的矩阵,那么池化后的特征图是 (C)的的矩阵

A. 2×2

B. 4×4

C. 8×8

D. 16×16

19.【单选题】卷积神经网中,如果输入图像是32×32矩阵,卷积核心是5×5的矩阵,步长为1,那么卷积操作后的特征图是 (D)的矩阵

A. 34×34

B. 32×32

C. 30×30

D. 28×28

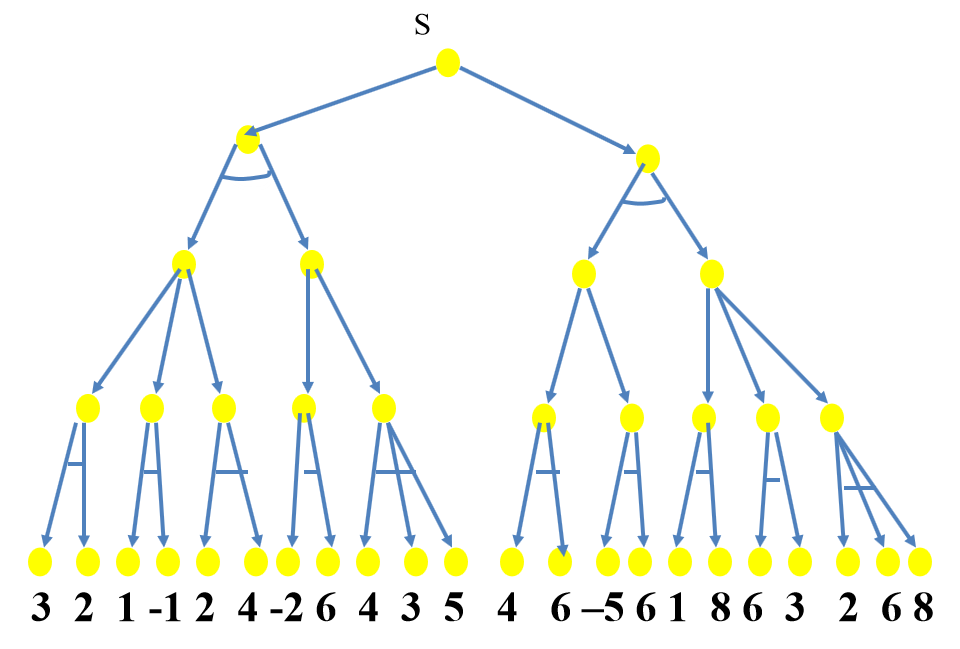

20.【单选题】用极大极小分析法计算博弈树的倒推值,根点s的倒推值是多少 (B)

A. 2

B. 3

C. 4

D. 6

二、填空题

1.按拓扑结构分,人工神经网络可以分为 前馈网络 和 反馈网络

2.第一次提出“人工智能”,标志着人工智能学科诞生的会议是 达特茅斯会议

3.当P与Q为F,R为T时,(P ∨ Q)→ R的真值是 T

4.在博弈树中,“或”节点和“与”节点逐层交替出现。自己一方扩展的节点为 或 节点,对方扩展的节点为 与 节点

5.连接词﹁,→, ↔,∨,∧, 的优先级别从低到高排列是 ↔,→,∨,∧, ﹁

6.若P是原子谓词公式,则称P和~P为 互补文字

7. ,需要用g(y,z,v)替换的约束变元是 w

,需要用g(y,z,v)替换的约束变元是 w

8.卷积神经网络是 BP 神经网络的延伸与拓展

9.求与或树中解树的代价,如果是与节点,则求解方法有 和代价法 与最大代价法

10.博弈树是一棵 与或 树

三、判断题

1.(F)知识具有不确定性与相对正确性,所以它不一定可以被表达与利用。

2.(T)希尔勒中文屋实验证明即使通过图灵测试也不能说明计算机能思维。

3.(T)产生式系统求解问题的过程是一个反复进行“匹配–冲突消解–执行”的过程

4.(T)一定存在一个BP神经网络能够逼近给定的样本或者函数

5.(F)“与\或”树始终是站在双方的立场上得出来的

6.(T)因为归结式C12是其亲本子句C1与C2的逻辑结论,所以将归结式C12加入原子句集S,得到的S1与S的真值相同

7.(F)演绎推理是由个别事物或现象推出一般性知识的过程,归纳推理是由一般性知识推理出个别事实的过程

8.(T)卷积主要用于得到图片的局部特征感知, 池化主要用于特征降维,压缩数据和参数的数量

9.(F)将一个复杂的问题分解为几个子问题的过程称为分解,可用或树表示。将一个复杂的问题变换成若干个等价的问题的过程称为等价变换,可用与树表示

10.(T)本原问题所对应的节点称为终叶节点。终叶节点一定是端节点,但端节点不一定是终止节点

四、简答题

1.BP学习算法的基本思想是什么?

BP学习算法的基本思想是调整权值,使得神经网络的实际输出能够逼近样本与函数的实际输出。

2.2016年ALphaGo挑战韩国职业九段选手李世石获胜,2017年与当时世界排名第一的中国棋手柯洁对战获胜,ALphaGo ZERO已经从观摩人类棋局进化到自己与自己下棋,你觉得这属于强人工智能还是弱人工智能,并结合此事件分析什么是强人工智能,什么是弱人工智能,以及它们的区别。

我觉得属于弱人工智能,ALphaGo虽然战胜了人类冠军,可它没有自我意识,更没有胜利的喜悦,因为弱人工智能是对人类某项智能的模拟与扩展,ALphaGo仍然属于这个范畴,而强人工智能是指机器真正能思维,具有自我意识,我觉得ALphaGo的计算依然只是特征的抽取与模型的建立,还谈不上真正的思维,所以属于弱人工智能。(参考)

3.

4.设有子句集:

S={~ A(x,y)∨ ~ B(y) ∨ C(f(x)), ~ A(x,y) ∨ ~ B(y) ∨ D(x,f(x)), ~C(z)∨ ~B(y), A(a,b), ~A(x,b)∨ B(b) },请用归结原理证明这个子句集是否不可满足。并结合证明过程来讨论为什么归结原理会出现组合爆炸的问题,你觉得会导致推理程序出现什么问题?

(1)~ A(x,y)∨ ~ B(y) ∨ C(f(x))

(2)~ A(x,y) ∨ ~ B(y) ∨ D(x,f(x))

(3)~C(z)∨ ~B(y)

(4)A(a,b)

(5)~A(x,b)∨ B(b)

(6) B(b) {a/x}(4)(5)

(7) ~C(z) {b/y} (3)(6)

(8) ~ A(x,y)∨ ~ B(y) {f(x)/z} (1)(7)

(9) ~ B(b) {a/x,b/y} (4)(8)

(10) nil (6)(9)

盲目归结会产生大量的不必要的归结式,这种不必要的归结式在下一轮归结时,会以幂次方的增长速度增长,从而产生组合爆炸。这会造成智能程序无法在人可以接受的时间内完成归结。

5.设训练例子集如表所示,请用ID3算法计算出其决策树选择的第一个属性?

(注1:不需要计算出全部的决策树

注2:计算到小数点后3位。

注3:log2(1/2)= -1,log2(2/3)= -0.5850,log2(1/3) =- 1.5850 )

表 训练例子集

初始化样本集S={S1,S2,…,S6}和属性集X={x1,x2}。

生成仅含根节点(S,X)的初始决策树。计算根节点(S,X)关于每一个属性的信息增益,并选择具有最大信息增益的属性对根节点进行扩展。

首先,计算根节点的信息熵:

E(S,X)= -PS(+)log PS(+) – PS(-)log PS(-)

式中

PS(+)=3/6,PS(-)=3/6,log 2(3/6)= -1

即有

E(S,X)= -(3/6)*log 2(3/6) – (3/6)*log 2(3/6)

= 0.5+0.5 = 1

按照ID3算法,再计算根节点(S, X)关于每个属性的加权信息熵。

先考虑属性x1,对x1的不同取值:

当x1=T时,有ST={1,2,3}

当x1=F时,有SF={4,5,6}

其中,ST 和SF中的数字均为例子集S中的各个例子的序号,|S|、| ST|和|SF|分别为例子集S、ST和SF 的大小且有|S|=6,| ST |=| SF |=3。

由ST可知:

PST(+)=2/3,PST(-)=1/3,log2(2/3)= -0.5850,log2(1/3) =- 1.5850

则有:

E(ST, X)= – PST(+)log2 PST(+) – PST(-)log2 PST(- )

= – (2/3)(-0.5850)- (1/3)(-1.5850)

=0.9183

再由SF可知:

PSF(+)=1/3,PSF(-)=2/3

则有:

E(SF,X)= -PSF(+)log2 PST(+)-PSF(-)log2 PSF(- )

= – (1/3)(-1.5850)- (2/3)(-0.5850)

=0.9183

E(S,X), xi)= ( |ST| / |S|)* E(ST, X) + ( |SF| / |S|)* H(SF, X)

= (3/6)*0.9183+(3/6)*0.9183

= 0.9183

再考虑属性x2,对x2的不同取值:

当x2=T时,有S’T={1,2,5,6}

当x2=F时,有S’F={3,4}

其中,S’T 和S’F中的数字均为例子集S中的各个例子的序号,|S|、| S’T|和|S’F|分别为例子集S、S’T和S’F 的大小且有|S|=6,| S’T |=4 ,| S’F |=2。

由S’T可知:

P’ST(+)=2/4,P’ST(-)=2/4,log2(2/4)= -1

则有:

E(S’T, X)= – P’ST(+)log2 P’ST(+) – P’ST(-)log2 P’ST(- )

= – (2/4)(-1) – (2/4)(-1)

=1

再由S’F可知:

P’SF(+)=1/2,P’SF(-)=1/2,log2(1/2)= -1

则有:

E(S’F,X)= – (P’SF(+)log2 P’ST(+)-P’SF(-)log2 P’SF(- ))

= – (1/2)(-1)- (1/2)(-1)

= 1

E(S,X), x2)= ( |S’T| / |S|)* E(S’T, X) + ( |S’F| / |S|)* H(S’F, X)

= (4/6)*1+(2/6)*1 = 1

据此,可得到各属性的信息增益分别为

G((S,X) x1)= E(S, X) – E(S, X), xi) = 1- 0.9183=0.0817

G((S,X) x2)= E(S, X) – E(S, X), x2) = 1-1=0

显然,x1的信息增益更大,因此应该选择对x1进行扩展。

上一篇>>人工智能导论练习题(上)

上一篇>>人工智能导论练习题(下)

文章出处登录后可见!