内容

Convolutional Neural Nets 卷积神经网络

Tree Recursive Neural Networks 树形递归神经网络

Convolutional Neural Nets 卷积神经网络

RNN的弊端:捕获了过多关于靠后输入的信息,且只能捕获连续的信息,难以精准定位某些特定信息(通过LSTM的遗忘门可以做到,但这需要许多层模型)

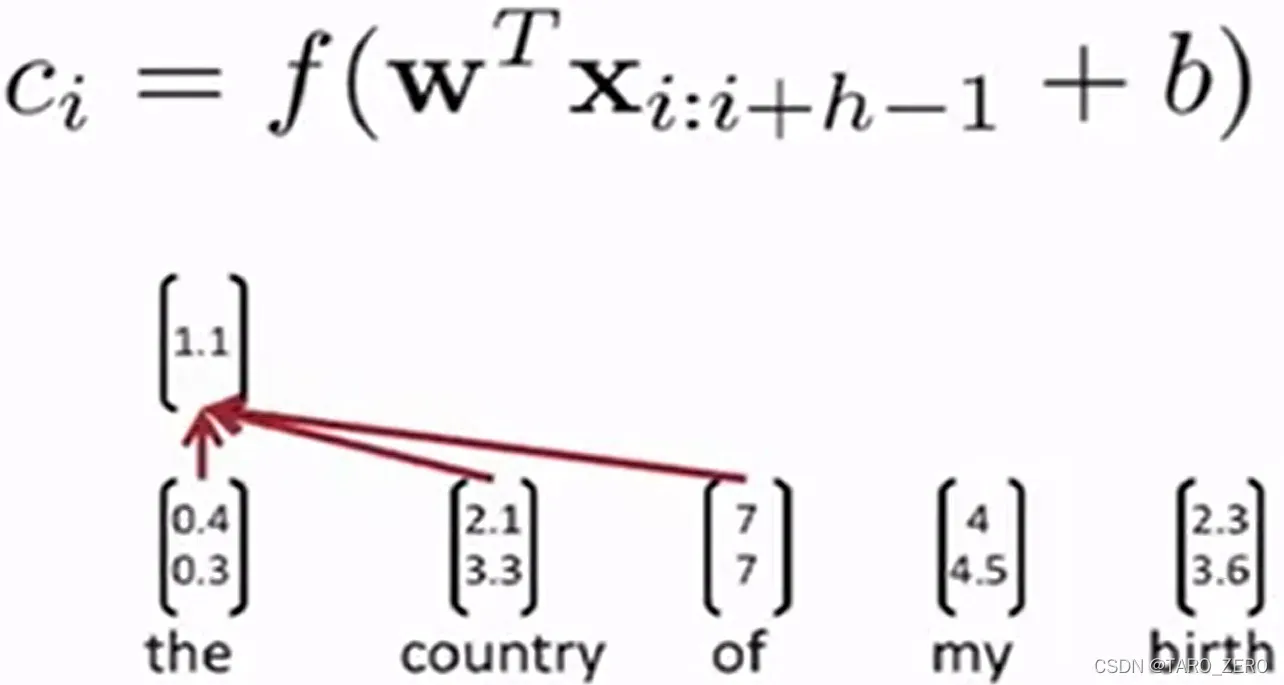

卷积神经网络CNN:遍历较短的单词窗口,使用 filter 过滤器对窗口进行加权求和,以提取每个小短句的信息特征

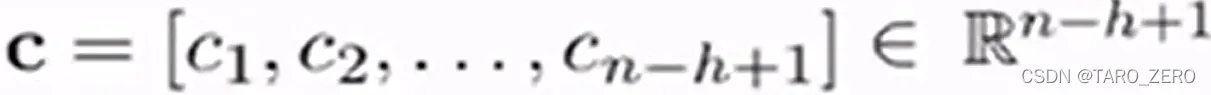

遍历所有长度为的卷积窗口后,我们得到一个特征图

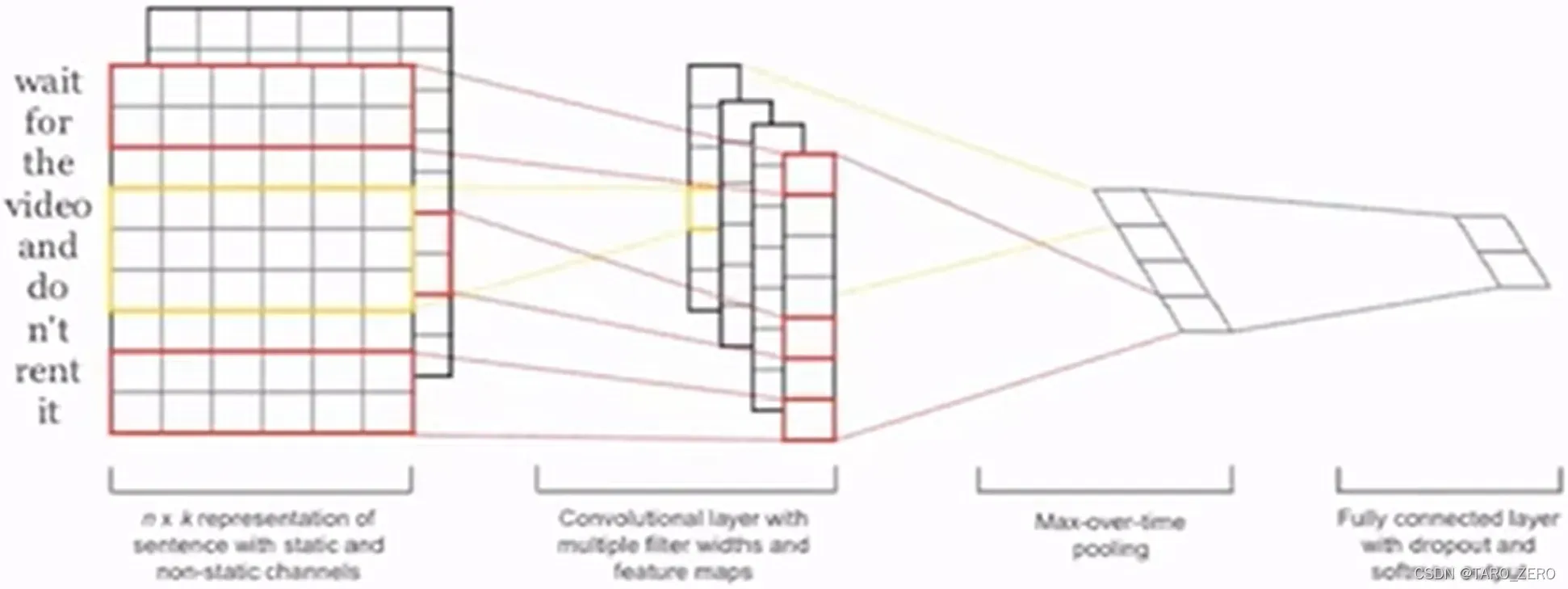

由于的维度不确定,引入 pooling layer 池化层,例如最大池化,然后再对不同大小的窗口训练不同的过滤器,将得到的

连接成向量接入softmax分类器

dropout:随机掩盖或丢弃一些权重,以防止不同类型的特征之间相互适应

Tree Recursive Neural Networks 树形递归神经网络

语义合成模型:语义理解,即对于一个句子生成一个向量,我们希望新的向量和词向量在同一个空间,便于理解词义和语义的关系

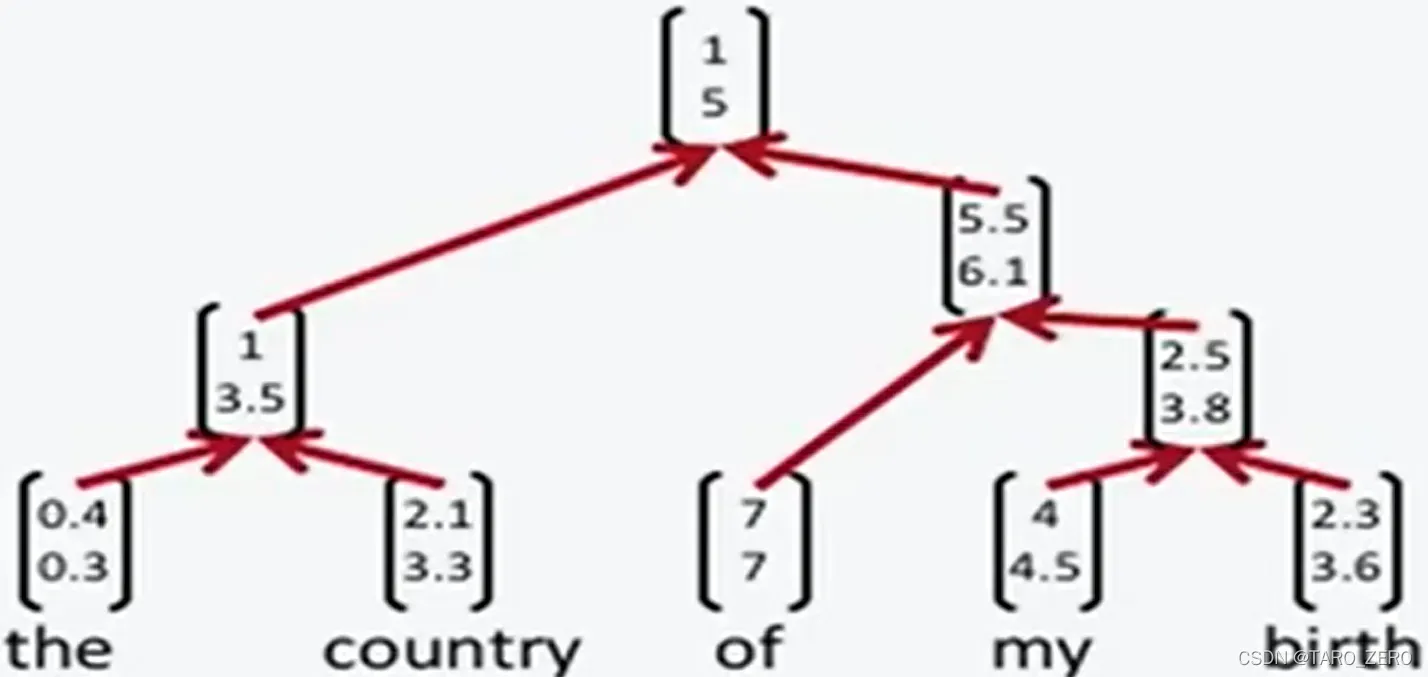

因为句子往往有嵌套结构,所以引入了递归的思想,需要注意的是不同句子的递归结构是不一样的

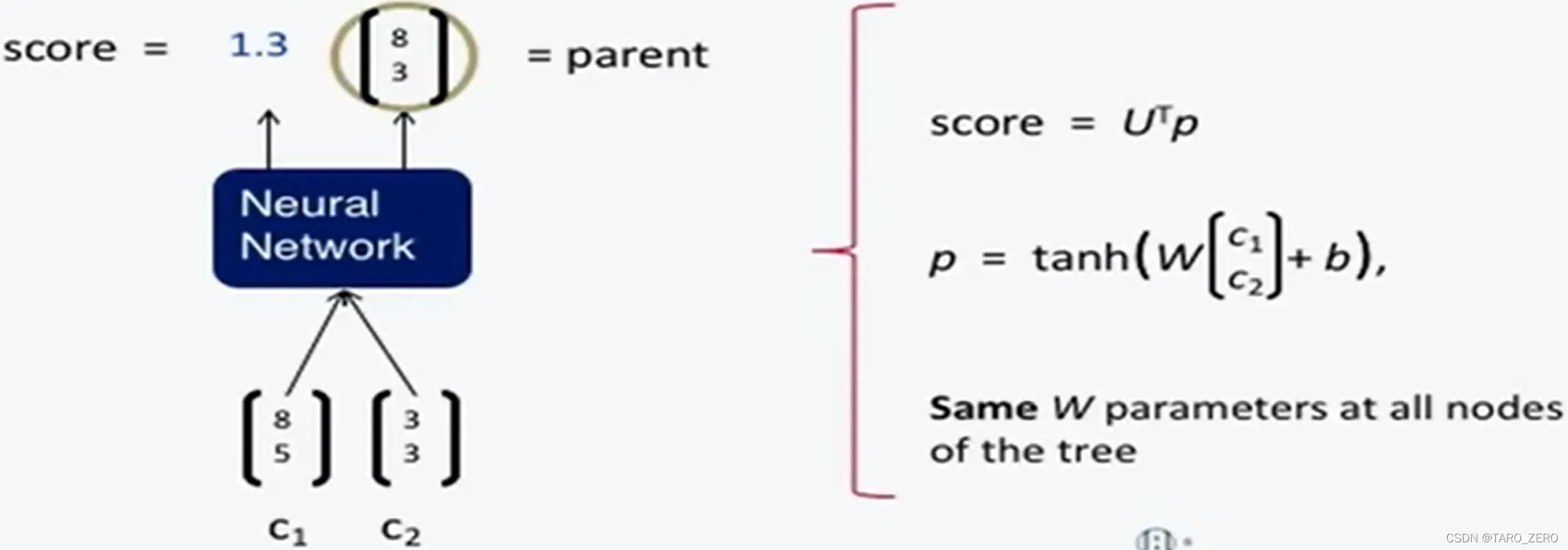

基本实现:对于每个相邻的词对,训练得到它的合并词组向量和词组的合并分数,表示是否应该选择这两个词作为底部子树,然后逐步得到解析树。结构体

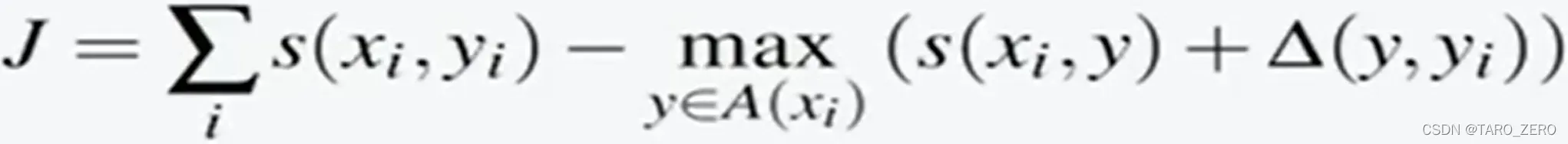

使用最大间距损失函数

反向传播计算:从所有节点求和W的导数、在每个节点处拆分导数(对于树分支)、从父节点和节点本身添加错误消息

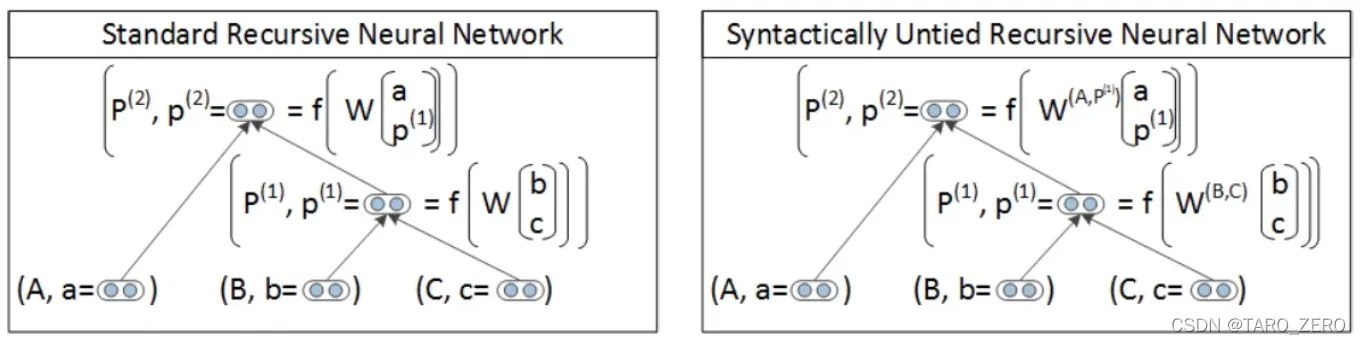

模型改进:Syntactically-Utied RNN 语义解绑树形递归神经网络

以前,模型中的所有短语都使用相同的合并函数,但对于不同语法的短语,可以使用不同的函数。我们想让合成功能更灵活

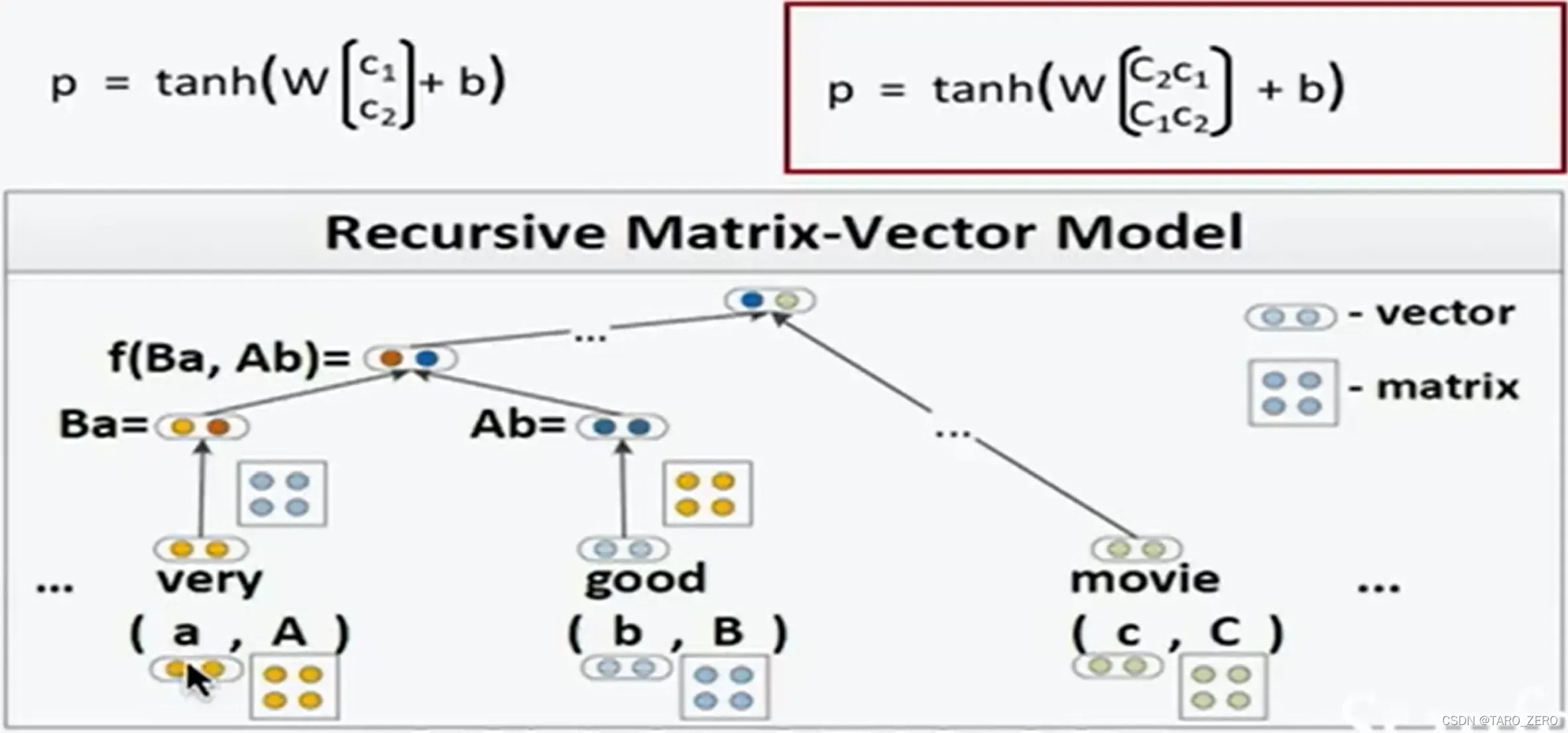

模型改进:Matrix-vector RNNs

之前的merge函数只是简单地将两个词向量乘以一部分权重矩阵,使得词组中的两个词没有很好的交互。合并功能得到了改进。每个词都有一个向量和一个矩阵来表示信息

版权声明:本文为博主TARO_ZERO原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/TARO_ZERO/article/details/123175551