前言

我们上一篇介绍了,如何采集王者最低战力,本文就来给大家介绍如何采集王者皮肤,买不起皮肤,当个桌面壁纸挺好的。下面,我和大家介绍如何获取数据。

环境使用

- python 3.9

- pycharm

模块使用

- requests

模块介绍

- requests

requests是一个很实用的Python HTTP客户端库,爬虫和测试服务器响应数据时经常会用到,requests是Python语言的第三方的库,专门用于发送HTTP请求,使用起来比urllib简洁很多。

- parsel

parsel是一个python的第三方库,相当于css选择器+xpath+re。

parsel由scrapy团队开发,是将scrapy中的parsel独立抽取出来的,可以轻松解析html,xml内容,获取需要的数据。

相比于BeautifulSoup,xpath,parsel效率更高,使用更简单。

- re

re模块是python独有的匹配字符串的模块,该模块中提供的很多功能是基于正则表达式实现的,而正则表达式是对字符串进行模糊匹配,提取自己需要的字符串部分,他对所有的语言都通用。

- os

os 就是 “operating system” 的缩写,顾名思义,os模块提供的就是各种 Python 程序与操作系统进行交互的接口。通过使用 os 模块,一方面可以方便地与操作系统进行交互,另一方面也可以极大增强代码的可移植性。

- csv

它是一种文件格式,一般也被叫做逗号分隔值文件,可以使用 Excel 软件或者文本文档打开 。其中数据字段用半角逗号间隔(也可以使用其它字符),使用 Excel 打开时,逗号会被转换为分隔符。csv 文件是以纯文本形式存储了表格数据,并且在兼容各个操作系统。

模块安装问题:

- 如果安装python第三方模块:

win + R 输入 cmd 点击确定, 输入安装命令 pip install 模块名 (pip install requests) 回车

在pycharm中点击Terminal(终端) 输入安装命令

- 安装失败原因:

- 失败一: pip 不是内部命令

解决方法: 设置环境变量

- 失败二: 出现大量报红 (read time out)

解决方法: 因为是网络链接超时, 需要切换镜像源

清华:https://pypi.tuna.tsinghua.edu.cn/simple 阿里云:https://mirrors.aliyun.com/pypi/simple/ 中国科技大学 https://pypi.mirrors.ustc.edu.cn/simple/ 华中理工大学:https://pypi.hustunique.com/ 山东理工大学:https://pypi.sdutlinux.org/ 豆瓣:https://pypi.douban.com/simple/ 例如:pip3 install -i https://pypi.doubanio.com/simple/ 模块名

- 失败三: cmd里面显示已经安装过了, 或者安装成功了, 但是在pycharm里面还是无法导入

解决方法: 可能安装了多个python版本 (anaconda 或者 python 安装一个即可) 卸载一个就好,或者你pycharm里面python解释器没有设置好。

代码实现

我们上一篇介绍了,如何采集王者最低战力,本文就来给大家介绍如何采集王者皮肤,买不起皮肤,当个桌面壁纸挺好的。下面,我和大家介绍如何获取数据。

确定网址

我们在对王者英雄的主页,进行了分析,我们发现,其网页地址相似,就差一个数字。

https://pvp.qq.com/web201605/herodetail/{ename}.shtml

我们可以把它当作为每个英雄的编号,我们可以从英雄列表获取编号,不过,这里我们直接请求第三方接口数据。

获取英雄编号

html_url ='https://www.sapi.run/hero/getHeroList.php'

datas = requests.get(html_url).json()['data']

for data in datas:

ename = data['ename']

cname = data['cname']

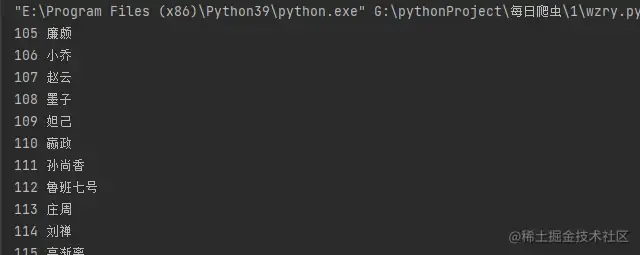

print(ename,cname)

这段代码中,html_url 是一个 URL,指向一个 SAPI 的 Hero 列表页面。requests.get(html_url).json()['data'] 返回一个 JSON 对象,其中包含了 Hero 列表页面的数据。ename 和 cname 是 JSON 对象中的两个键值对,分别表示 Hero 的编号和名字。

在这段代码中,我们使用了一个 for 循环来遍历 JSON 对象中的每一个键值对,并打印出它们的值。这样就可以得到 Hero 列表页面中所有 Hero 的编号和名字。

获取皮肤名称

我们拿到每一个英雄的编号之后,我们就可以访问每一个英雄的主页,我们在其主页可以看到他们的英雄名称和他们的英雄皮肤的地址。我们先获取英雄皮肤的名称。

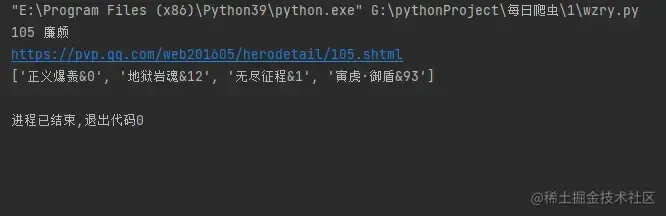

herodetail_url = f'https://pvp.qq.com/web201605/herodetail/{ename}.shtml'

print(herodetail_url)

res = requests.get(herodetail_url,headers=headers)

res.encoding = 'gbk'

# print(res.text)

pfs = re.findall('data-imgname="(.*?)"',res.text)[0]

pfs=pfs.split('|')

print(pfs)

这段代码中,herodetail_url 是一个 URL,指向一个 Hero 详细页面。requests.get(herodetail_url,headers=headers) 返回一个 JSON 对象,其中包含了 Hero 详细页面的数据。res.encoding = 'gbk' 设置了 JSON 对象的编码方式为 GBK。re.findall('data-imgname="(.*?)"',res.text)[0] 使用正则表达式匹配 Hero 详细页面中的英雄名称,并返回第一个匹配项。pfs 是匹配项的值,它是一个包含英雄名称的列表。

接下来,我们对字段进行处理。

for pf in pfs:

pf = pf.split('&')[0]

# print(pf)

pf_list.append(pf)

print(len(pf_list))

print(pf_list)

我们得到了这样的数据。['正义爆轰', '地狱岩魂', '无尽征程', '寅虎·御盾'],到了这里,我们皮肤名字就获取下来了。

获取皮肤

pages = len(pfs)

for page in range(1,pages+1):

pf_url = f'http://game.gtimg.cn/images/yxzj/img201606/skin/hero-info/{ename}/{ename}-bigskin-{page}.jpg'

pf_url_list.append(pf_url)

这段代码中,我们首先计算出 Hero 详细页面中图片的数量,然后使用 range 函数生成从 1 到 pages 的整数序列。接下来,我们使用一个循环来遍历这个序列,并将每个图片的 URL 添加到 pf_url_list 列表中。

最后,我们将 pf_url_list 列表中的所有 URL 连接起来,并将它们作为参数传递给 requests.get() 函数,以获取 Hero 详细页面的数据。

到这里,我们把所有皮肤的地址获取了下来。

保存数据

for name,url in zip(pf_list,pf_url_list):

path = f'.//皮肤//{cname}//'

# print(path)

if not os.path.exists(path):

os.mkdir(path)

# print(cname,name,url)

pf_save = requests.get(url,headers=headers)

print(f"path + '{name}.jpg'")

with open(path + f'{name}.jpg', 'wb') as f:

f.write(pf_save.content)

这段代码中,我们首先将 pf_list 和 pf_url_list 两个列表进行了 zip 操作,并将结果存储在 pf_list 和 pf_url_list 两个变量中。然后,我们使用 os.path.exists() 函数来检查 path 目录是否存在,如果不存在,则使用 os.mkdir() 函数创建该目录。接下来,我们使用 requests.get() 函数来获取 pf_url_list 列表中的每个 URL,并将它们作为参数传递给 requests.get() 函数,以获取 pf_list 列表中的每个 URL。

最后,我们使用 with open() 语句打开 path + '{name}.jpg' 文件,并将 pf_save.content 写入该文件中。这样就可以将 pf_list 和 pf_url_list 中的每个 URL 保存到 path + '{name}.jpg' 文件中。

全部源码

import re

import os

import requests

f = '皮肤\\'

if not os.path.exists(f):

os.mkdir(f)

pf_list = []

pf_url_list = []

html_url ='https://www.sapi.run/hero/getHeroList.php'

datas = requests.get(html_url).json()['data']

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36'

}

for data in datas:

ename = data['ename']

cname = data['cname']

print(ename,cname)

herodetail_url = f'https://pvp.qq.com/web201605/herodetail/{ename}.shtml'

# print(herodetail_url)

res = requests.get(herodetail_url,headers=headers)

res.encoding = 'gbk'

pfs = re.findall('data-imgname="(.*?)"',res.text)[0]

pfs=pfs.split('|')

# 获取英雄皮肤名称。

pages = len(pfs)

for pf in pfs:

pf = pf.split('&')[0]

# print(pf)

pf_list.append(pf)

for page in range(1,pages+1):

pf_url = f'http://game.gtimg.cn/images/yxzj/img201606/skin/hero-info/{ename}/{ename}-bigskin-{page}.jpg'

pf_url_list.append(pf_url)

for name,url in zip(pf_list,pf_url_list):

pf_save = requests.get(url,headers=headers)

with open(f'皮肤\\{name}.jpg', 'wb') as f:

f.write(pf_save.content)

总结

这是一篇关于如何采集王者皮肤的文章,介绍了如何从英雄列表获取编号,并使用正则表达式从网页地址中提取英雄编号和名字。此外,还介绍了如何使用 requests.get() 函数从网页中获取数据,以及如何将数据保存到文件中。

文章出处登录后可见!