很多人以为学会了urlib模块和xpath等几个解析库,学了Selenium就会算精通爬虫了,但到外面想靠爬虫技术接点私活,才发现寸步难行。

龙叔我做了近20年的程序员,今天就告诉你,真正的爬虫高手应该学哪些东西,就算你毫无基础,你也能知道应该怎么去学习。

话不多说,我们直接进入正题。

1.语言基础Python

能做爬虫的工具有很多,但业内公认的最方便做爬虫的语言还得是Python,那么如果是为了学爬虫才去学的Python,应该学到什么程度呢?

这里给大家列举了一些必备的python的知识点,不用多学也不能少学,基本上一两周就能搞定。

2.爬虫基础和常用模块

语言基础打好之后,我们就可以正式进入爬虫的学习了。

首先应该学的就是一些爬虫的基础知识,比如说:

- 爬虫的概念和原理

- HTTP的请求原理

- GET请求和POST请求

- User_Agent和Cookie

有了对爬虫的大致了解之后,就可以从常用的模块开始学起来了,urllib和request是爬虫必学的两个模块,比如说refer和状态码,你得清楚你的程序请求返回的是个什么状态,是成功了还是失败了。

等于说这一部分,你应该学会如何让你的程序模拟用户的操作自动给网站或者其他对象发送请求,这是比较基础的。

为什么是很基础的?因为很多网站都是有验证的,所以肯定要学Selenium,一个非常常用的模拟人为的浏览器行为的工具,在验证方面有奇效。

3.解析库

学会了模拟用户行为给爬虫对象发送请求之后,我们肯定得学会把拿到的东西解析出来,不然拿到一堆乱码,耶稣看了也一脸懵逼。

那么解析库要掌握哪些东西,这几个很重要:

- CSV(文件读写操作)

- Xpath

- BS4(Beatiful Soup)

- PyQuery

4.Scrapy框架

何为框架?就相当于一个封装了很多功能的结构体,它帮我们把主要的结构给搭建好了,我们只需往骨架里添加内容就行。

Scrapy框架是一个为了爬取网站数据,提取数据的框架,我们熟知爬虫总共有四大部分,请求、响应、解析、存储,scrapy框架都已经搭建好了。

那么Scrapy要学哪些东西?

- 基本工作流程

- 管道文件、items文件和settings文件

- 翻页和详情页

- scrapy-shell的使用

- scrapy-redis

学会使用框架之后的爬虫能够节省很多时间,不用自己手写全部功能,何乐而不为呢?

5.数据库

对于爬虫高手而言,数据库也是必须掌握的,如果是企业爬虫的话,你爬下来的数据你自己是清楚,但如果还要给其他人去调用,那么多半是整理好之后存放在数据库中,便于大家去调用了。

那么数据库要学什么?不管是SQL还是NOSQL数据库,起码你得会一个,可以是MySQL,也可以是MongoDB,看自己的情况来把。

6.移动端爬虫

很多小伙伴都止步于只会爬爬网页的数据,对于移动端的数据无可奈何,这其实就是典型的爬虫技术还没到家。

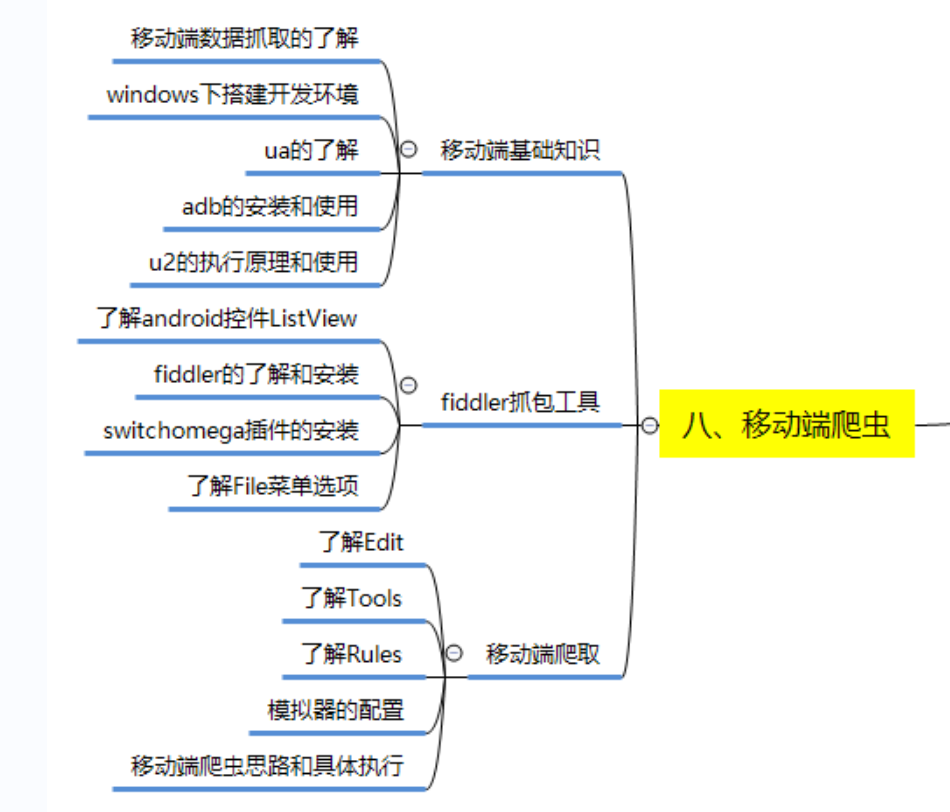

那么移动端爬虫要学什么东西?我给大家也列举一下:

7.爬虫技术提升

如果前面的技术你都会了,起码可以应付60%的爬虫对象,但随着反扒机制的不断提升,现在很多爬虫对象都给自己多道城墙,那么普通爬虫师和爬虫高手的区别就在于高端技术。

如果想成为爬虫高手,你还需要学习以下几个方面:

- IP代理和打码平台

同一个IP频繁去爬指定对象,多半会被检测出来是爬虫程序,所以IP代理和打码平台肯定是要会的。

- 复杂验证码的处理

现在的验证码是越来越考验智商了,所以这一块咱们也得掌握,比如说速度算法、OpenCV和行为验证等技术。

- 字体反爬

什么是字体反爬?

简单的说,字体反爬指的就是浏览器页面上的字符和调试窗口或者源码中的内容,显示的不一样,这就是字体反爬。

复杂点来说就是,网页开发者自己创造一种字体,因为在字体中每个文字都有其代号,那么以后在网页中不会直接显示这个文字的最终的效果,而是显示他的代号,因此即使获取到了网页中的文本内容,也只是获取到文字的代号,而不是文字本身。

所以这个技术也可以作为提升的方向。

- JS逆向

出于对数据安全的考虑,现代化的网站/APP通常会对数据接口做加密处理。而分析这些接口的加密算法并实现模拟调用的过程就叫做逆向。

逆向对于爬虫工程师来说是一个永远绕不开的话题,也逐渐成为各企业招聘时,JD 中的一个必备技能要求。

结语

最后给大家总结一下文章中提到的所有技术,都在下方的爬虫学习路线图了:

如果你能学会上面所提的90%以上的技术栈,那么你就能成为一个爬虫高手。

技术无罪,但行为却是可以判刑的,希望大家掌握真正的技术后,用在正途之上。

文章出处登录后可见!