如何才能自学好python?

对于想要自学Python的小伙伴,这里整理了一份系统全面的学习路线,按照这份大纲来安排学习可以少走弯路,事半功倍。

第一阶段:专业核心基础阶段目标:1.熟练掌握Python的开发环境与编程核心知识2.熟练运用Python面向对象知识进行程序开发3.对Python的核心库和组件有深入理解4.熟练应用SQL语句进行数据库常用操作5.熟练运用Linux操作系统命令及环境配置6.熟练使用MySQL,掌握数据库高级操作7.能综合运用所学知识完成项目知识点:Python编程基础、Python面向对象、Python高级进阶、MySQL数据库、Linux操作系统。

1、Python编程基础,语法规则,函数与参数,数据类型,模块与包,文件IO,培养扎实的Python编程基本功,同时对Python核心对象和库的编程有熟练的运用。

2、Python面向对象,核心对象,异常处理,多线程,网络编程,深入理解面向对象编程,异常处理机制,多线程原理,网络协议知识,并熟练运用于项目中。

3、类的原理,MetaClass,下划线的特殊方法,递归,魔术方法,反射,迭代器,装饰器,UnitTest,Mock。深入理解面向对象底层原理,掌握Python开发高级进阶技术,理解单元测试技术。

4、数据库知识,范式,MySQL配置,命令,建库建表,数据的增删改查,约束,视图,存储过程,函数,触发器,事务,游标,PDBC,深入理解数据库管理系统通用知识及MySQL数据库的使用与管理。

为Python后台开发打下坚实基础。

5、Linux安装配置,文件目录操作,VI命令,管理,用户与权限,环境配置,Docker,Shell编程Linux作为一个主流的服务器操作系统,是每一个开发工程师必须掌握的重点技术,并且能够熟练运用。

第二阶段:PythonWEB开发阶段目标:1.熟练掌握Web前端开发技术,HTML,CSS,JavaScript及前端框架2.深入理解Web系统中的前后端交互过程与通信协议3.熟练运用Web前端和Django和Flask等主流框架完成Web系统开发4.深入理解网络协议,分布式,PDBC,AJAX,JSON等知识5.能够运用所学知识开发一个MiniWeb框架,掌握框架实现原理6.使用Web开发框架实现贯穿项目知识点:Web前端编程、Web前端高级、Django开发框架、Flask开发框架、Web开发项目实战。

1、Web页面元素,布局,CSS样式,盒模型,JavaScript,JQuery与Bootstrap掌握前端开发技术,掌握JQuery与BootStrap前端开发框架,完成页面布局与美化。

2、前端开发框架Vue,JSON数据,网络通信协议,Web服务器与前端交互熟练使用Vue框架,深入理解HTTP网络协议,熟练使用Swagger,AJAX技术实现前后端交互。

3、自定义Web开发框架,Django框架的基本使用,Model属性及后端配置,Cookie与Session,模板Templates,ORM数据模型,Redis二级缓存,RESTful,MVC模型掌握Django框架常用API,整合前端技术,开发完整的WEB系统和框架。

4、Flask安装配置,App对象的初始化和配置,视图函数的路由,Request对象,Abort函数,自定义错误,视图函数的返回值,Flask上下文和请求钩子,模板,数据库扩展包Flask-Sqlalchemy,数据库迁移扩展包Flask-Migrate,邮件扩展包Flask-Mail。

掌握Flask框架的常用API,与Django框架的异同,并能独立开发完整的WEB系统开发。

第三阶段:爬虫与数据分析阶段目标:1.熟练掌握爬虫运行原理及常见网络抓包工具使用,能够对HTTP及HTTPS协议进行抓包分析2.熟练掌握各种常见的网页结构解析库对抓取结果进行解析和提取3.熟练掌握各种常见反爬机制及应对策略,能够针对常见的反爬措施进行处理4.熟练使用商业爬虫框架Scrapy编写大型网络爬虫进行分布式内容爬取5.熟练掌握数据分析相关概念及工作流程6.熟练掌握主流数据分析工具Numpy、Pandas和Matplotlib的使用7.熟练掌握数据清洗、整理、格式转换、数据分析报告编写8.能够综合利用爬虫爬取豆瓣网电影评论数据并完成数据分析全流程项目实战知识点:网络爬虫开发、数据分析之Numpy、数据分析之Pandas。

1、爬虫页面爬取原理、爬取流程、页面解析工具LXML,Beautifulfoup,正则表达式,代理池编写和架构、常见反爬措施及解决方案、爬虫框架结构、商业爬虫框架Scrapy,基于对爬虫爬取原理、网站数据爬取流程及网络协议的分析和了解,掌握网页解析工具的使用,能够灵活应对大部分网站的反爬策略,具备独立完成爬虫框架的编写能力和熟练应用大型商业爬虫框架编写分布式爬虫的能力。

2、Numpy中的ndarray数据结构特点、numpy所支持的数据类型、自带的数组创建方法、算术运算符、矩阵积、自增和自减、通用函数和聚合函数、切片索引、ndarray的向量化和广播机制,熟悉数据分析三大利器之一Numpy的常见使用,熟悉ndarray数据结构的特点和常见操作,掌握针对不同维度的ndarray数组的分片、索引、矩阵运算等操作。

3、Pandas里面的三大数据结构,包括Dataframe、Series和Index对象的基本概念和使用,索引对象的更换及删除索引、算术和数据对齐方法,数据清洗和数据规整、结构转换,熟悉数据分析三大利器之一Pandas的常见使用,熟悉Pandas中三大数据对象的使用方法,能够使用Pandas完成数据分析中最重要的数据清洗、格式转换和数据规整工作、Pandas对文件的读取和操作方法。

4、matplotlib三层结构体系、各种常见图表类型折线图、柱状图、堆积柱状图、饼图的绘制、图例、文本、标线的添加、可视化文件的保存,熟悉数据分析三大利器之一Matplotlib的常见使用,熟悉Matplotlib的三层结构,能够熟练使用Matplotlib绘制各种常见的数据分析图表。

能够综合利用课程中所讲的各种数据分析和可视化工具完成股票市场数据分析和预测、共享单车用户群里数据分析、全球幸福指数数据分析等项目的全程实战。

第四阶段:机器学习与人工智能阶段目标:1.理解机器学习相关的基本概念及系统处理流程2.能够熟练应用各种常见的机器学习模型解决监督学习和非监督学习训练和测试问题,解决回归、分类问题3.熟练掌握常见的分类算法和回归算法模型,如KNN、决策树、随机森林、K-Means等4.掌握卷积神经网络对图像识别、自然语言识别问题的处理方式,熟悉深度学习框架TF里面的张量、会话、梯度优化模型等5.掌握深度学习卷积神经网络运行机制,能够自定义卷积层、池化层、FC层完成图像识别、手写字体识别、验证码识别等常规深度学习实战项目知识点:1、机器学习常见算法、sklearn数据集的使用、字典特征抽取、文本特征抽取、归一化、标准化、数据主成分分析PCA、KNN算法、决策树模型、随机森林、线性回归及逻辑回归模型和算法。

熟悉机器学习相关基础概念,熟练掌握机器学习基本工作流程,熟悉特征工程、能够使用各种常见机器学习算法模型解决分类、回归、聚类等问题。

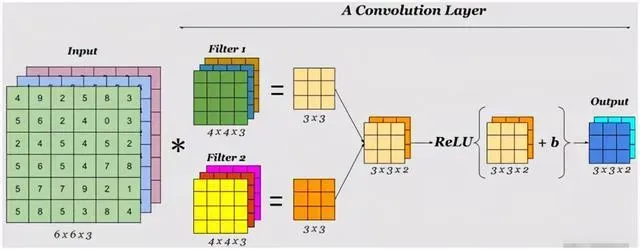

2、Tensorflow相关的基本概念,TF数据流图、会话、张量、tensorboard可视化、张量修改、TF文件读取、tensorflowplayround使用、神经网络结构、卷积计算、激活函数计算、池化层设计,掌握机器学习和深度学习之前的区别和练习,熟练掌握深度学习基本工作流程,熟练掌握神经网络的结构层次及特点,掌握张量、图结构、OP对象等的使用,熟悉输入层、卷积层、池化层和全连接层的设计,完成验证码识别、图像识别、手写输入识别等常见深度学习项目全程实战。

深度学习 python怎么入门 知乎

自学深度学习是一个漫长而艰巨的过程爱发猫 www.aifamao.com。您需要有很强的线性代数和微积分背景,良好的Python编程技能,并扎实掌握数据科学、机器学习和数据工程。

即便如此,在你开始将深度学习应用于现实世界的问题,并有可能找到一份深度学习工程师的工作之前,你可能需要一年多的学习和实践。然而,知道从哪里开始,对软化学习曲线有很大帮助。

如果我必须重新学习Python的深度学习,我会从AndrewTrask写的Grokkingdeeplearning开始。大多数关于深度学习的书籍都要求具备机器学习概念和算法的基本知识。

除了基本的数学和编程技能之外,Trask的书不需要任何先决条件就能教你深度学习的基础知识。

这本书不会让你成为一个深度学习的向导(它也没有做这样的声明),但它会让你走上一条道路,让你更容易从更高级的书和课程中学习。

用Python构建人工神经元大多数深度学习书籍都是基于一些流行的Python库,如TensorFlow、PyTorch或Keras。

相比之下,《运用深度学习》(GrokkingDeepLearning)通过从零开始、一行一行地构建内容来教你进行深度学习。《运用深度学习》你首先要开发一个人工神经元,这是深度学习的最基本元素。

查斯克将带领您了解线性变换的基本知识,这是由人工神经元完成的主要计算。然后用普通的Python代码实现人工神经元,无需使用任何特殊的库。

这不是进行深度学习的最有效方式,因为Python有许多库,它们利用计算机的图形卡和CPU的并行处理能力来加速计算。但是用普通的Python编写一切对于学习深度学习的来龙去是非常好的。

在Grokking深度学习中,你的第一个人工神经元只接受一个输入,将其乘以一个随机权重,然后做出预测。然后测量预测误差,并应用梯度下降法在正确的方向上调整神经元的权重。

有了单个神经元、单个输入和单个输出,理解和实现这个概念变得非常容易。您将逐渐增加模型的复杂性,使用多个输入维度、预测多个输出、应用批处理学习、调整学习速率等等。

您将通过逐步添加和修改前面章节中编写的Python代码来实现每个新概念,逐步创建用于进行预测、计算错误、应用纠正等的函数列表。

当您从标量计算转移到向量计算时,您将从普通的Python操作转移到Numpy,这是一个特别擅长并行计算的库,在机器学习和深度学习社区中非常流行。

Python的深度神经网络有了这些人造神经元的基本构造块,你就可以开始创建深层神经网络,这基本上就是你将几层人造神经元叠放在一起时得到的结果。

当您创建深度神经网络时,您将了解激活函数,并应用它们打破堆叠层的线性并创建分类输出。同样,您将在Numpy函数的帮助下自己实现所有功能。您还将学习计算梯度和传播错误通过层传播校正跨不同的神经元。

随着您越来越熟悉深度学习的基础知识,您将学习并实现更高级的概念。这本书的特点是一些流行的正规化技术,如早期停止和退出。您还将获得自己版本的卷积神经网络(CNN)和循环神经网络(RNN)。

在本书结束时,您将把所有内容打包到一个完整的Python深度学习库中,创建自己的层次结构类、激活函数和神经网络体系结构(在这一部分,您将需要面向对象的编程技能)。

如果您已经使用过Keras和PyTorch等其他Python库,那么您会发现最终的体系结构非常熟悉。如果您没有,您将在将来更容易地适应这些库。

在整本书中,查斯克提醒你熟能生巧;他鼓励你用心编写自己的神经网络,而不是复制粘贴任何东西。代码库有点麻烦并不是所有关于Grokking深度学习的东西都是完美的。

在之前的一篇文章中,我说过定义一本好书的主要内容之一就是代码库。在这方面,查斯克本可以做得更好。在GitHub的Grokking深度学习库中,每一章都有丰富的jupiterNotebook文件。

jupiterNotebook是一个学习Python机器学习和深度学习的优秀工具。然而,jupiter的优势在于将代码分解为几个可以独立执行和测试的小单元。

Grokking深度学习的一些笔记本是由非常大的单元格组成的,其中包含大量未注释的代码。这在后面的章节中会变得尤其困难,因为代码会变得更长更复杂,在笔记本中寻找自己的方法会变得非常乏味。

作为一个原则问题,教育材料的代码应该被分解成小单元格,并在关键区域包含注释。此外,Trask在Python2.7中编写了这些代码。

虽然他已经确保了代码在Python3中也能顺畅地工作,但它包含了已经被Python开发人员弃用的旧编码技术(例如使用“foriinrange(len(array))”范式在数组上迭代)。

更广阔的人工智能图景Trask已经完成了一项伟大的工作,它汇集了一本书,既可以为初学者,也可以为有经验的Python深度学习开发人员填补他们的知识空白。

但正如泰温·兰尼斯特(TywinLannister)所说(每个工程师都会同意),“每个任务都有一个工具,每个工具都有一个任务。”深度学习并不是一根可以解决所有人工智能问题的魔杖。

事实上,对于许多问题,更简单的机器学习算法,如线性回归和决策树,将表现得和深度学习一样好,而对于其他问题,基于规则的技术,如正则表达式和几个if-else子句,将优于两者。

关键是,你需要一整套工具和技术来解决AI问题。希望Grokking深度学习能够帮助你开始获取这些工具。

你要去哪里?我当然建议选择一本关于Python深度学习的深度书籍,比如PyTorch的深度学习或Python的深度学习。你还应该加深你对其他机器学习算法和技术的了解。

我最喜欢的两本书是《动手机器学习》和《Python机器学习》。

你也可以通过浏览机器学习和深度学习论坛,如r/MachineLearning和r/deeplearningsubreddits,人工智能和深度学习Facebook组,或通过在Twitter上关注人工智能研究人员来获取大量知识。

AI的世界是巨大的,并且在快速扩张,还有很多东西需要学习。如果这是你关于深度学习的第一本书,那么这是一个神奇旅程的开始。

怎样用python构建一个卷积神经网络

用keras框架较为方便首先安装anaconda,然后通过pip安装keras以下转自wphh的博客。

#coding:utf-8”’ GPU run command: THEANO_FLAGS=mode=FAST_RUN,device=gpu,floatX=float32 python CPU run command: python 2016.06.06更新:这份代码是keras开发初期写的,当时keras还没有现在这么流行,文档也还没那么丰富,所以我当时写了一些简单的教程。

现在keras的API也发生了一些的变化,建议及推荐直接上看更加详细的教程。

”’#导入各种用到的模块组件from __future__ import absolute_importfrom __future__ import print_functionfrom keras.preprocessing.image import ImageDataGeneratorfrom keras.models import Sequentialfrom import Dense, Dropout, Activation, Flattenfrom keras.layers.advanced_activations import PReLUfrom keras.layers.convolutional import Convolution2D, MaxPooling2Dfrom keras.optimizers import SGD, Adadelta, Adagradfrom keras.utils import np_utils, generic_utilsfrom six.moves import rangefrom data import load_dataimport randomimport numpy as np(1024) # for reproducibility#加载数据data, label = load_data()#打乱数据index = [i for i in range(len(data))]random.shuffle(index)data = data[index]label = label[index]print(data.shape[0], ‘ samples’)#label为0~9共10个类别,keras要求格式为binary class matrices,转化一下,直接调用keras提供的这个函数label = np_utils.to_categorical(label, 10)################开始建立CNN模型################生成一个modelmodel = Sequential()#第一个卷积层,4个卷积核,每个卷积核大小5*5。

1表示输入的图片的通道,灰度图为1通道。

#border_mode可以是valid或者full,具体看这里说明:.conv2d#激活函数用tanh#你还可以在(Activation(‘tanh’))后加上dropout的技巧: (Dropout(0.5))(Convolution2D(4, 5, 5, border_mode=’valid’,input_shape=(1,28,28))) (Activation(‘tanh’))#第二个卷积层,8个卷积核,每个卷积核大小3*3。

4表示输入的特征图个数,等于上一层的卷积核个数#激活函数用tanh#采用maxpooling,poolsize为(2,2)(Convolution2D(8, 3, 3, border_mode=’valid’))(Activation(‘tanh’))(MaxPooling2D(pool_size=(2, 2)))#第三个卷积层,16个卷积核,每个卷积核大小3*3#激活函数用tanh#采用maxpooling,poolsize为(2,2)(Convolution2D(16, 3, 3, border_mode=’valid’)) (Activation(‘relu’))(MaxPooling2D(pool_size=(2, 2)))#全连接层,先将前一层输出的二维特征图flatten为一维的。

#Dense就是隐藏层。16就是上一层输出的特征图个数。

4是根据每个卷积层计算出来的:(28-5+1)得到24,(24-3+1)/2得到11,(11-3+1)/2得到4#全连接有128个神经元节点,初始化方式为normal(Flatten())(Dense(128, init=’normal’))(Activation(‘tanh’))#Softmax分类,输出是10类别(Dense(10, init=’normal’))(Activation(‘softmax’))##############开始训练模型###############使用SGD + momentum#model.compile里的参数loss就是损失函数(目标函数)sgd = SGD(lr=0.05, decay=1e-6, momentum=0.9, nesterov=True)model.compile(loss=’categorical_crossentropy’, optimizer=sgd,metrics=[“accuracy”])#调用fit方法,就是一个训练过程. 训练的epoch数设为10,batch_size为100.#数据经过随机打乱shuffle=True。

verbose=1,训练过程中输出的信息,0、1、2三种方式都可以,无关紧要。show_accuracy=True,训练时每一个epoch都输出accuracy。

#validation_split=0.2,将20%的数据作为验证集。

(data, label, batch_size=100, nb_epoch=10,shuffle=True,verbose=1,validation_split=0.2)”””#使用data augmentation的方法#一些参数和调用的方法,请看文档datagen = ImageDataGenerator( featurewise_center=True, # set input mean to 0 over the dataset samplewise_center=False, # set each sample mean to 0 featurewise_std_normalization=True, # divide inputs by std of the dataset samplewise_std_normalization=False, # divide each input by its std zca_whitening=False, # apply ZCA whitening rotation_range=20, # randomly rotate images in the range (degrees, 0 to 180) width_shift_range=0.2, # randomly shift images horizontally (fraction of total width) height_shift_range=0.2, # randomly shift images vertically (fraction of total height) horizontal_flip=True, # randomly flip images vertical_flip=False) # randomly flip images# compute quantities required for featurewise normalization # (std, mean, and principal components if ZCA whitening is applied)(data)for e in range(nb_epoch): print(‘-‘*40) print(‘Epoch’, e) print(‘-‘*40) print(“Training…”) # batch train with realtime data augmentation progbar = generic_utils.Progbar(data.shape[0]) for X_batch, Y_batch in (data, label): loss,accuracy = model.train(X_batch, Y_batch,accuracy=True) (X_batch.shape[0], values=[(“train loss”, loss),(“accuracy:”, accuracy)] )”””。

学习Python应该掌握哪些知识点

阶段一:Python开发基础Python全栈开发与人工智能之Python开发基础知识学习内容包括:Python基础语法、数据类型、字符编码、文件操作、函数、装饰器、迭代器、内置方法、常用模块等。

阶段二:Python高级编程和数据库开发Python全栈开发与人工智能之Python高级编程和数据库开发知识学习内容包括:面向对象开发、Socket网络编程、线程、进程、队列、IO多路模型、Mysql数据库开发等。

阶段三:前端开发Python全栈开发与人工智能之前端开发知识学习内容包括:Html、CSS、JavaScript开发、Jquery&bootstrap开发、前端框架VUE开发等。

阶段四:WEB框架开发Python全栈开发与人工智能之WEB框架开发学习内容包括:Django框架基础、Django框架进阶、BBS+Blog实战项目开发、缓存和队列中间件、Flask框架学习、Tornado框架学习、RestfulAPI等。

阶段五:爬虫开发Python全栈开发与人工智能之爬虫开发学习内容包括:爬虫开发实战。

阶段六:全栈项目实战Python全栈开发与人工智能之全栈项目实战学习内容包括:企业应用工具学习、CRM客户关系管理系统开发、路飞学城在线教育平台开发等。

阶段七:算法&设计模式阶段八:数据分析Python全栈开发与人工智能之数据分析学习内容包括:金融量化分析。

阶段九:机器学习、图像识别、NLP自然语言处理Python全栈开发与人工智能之人工智能学习内容包括:机器学习、图形识别、人工智能玩具开发等。

阶段十:Linux系统&百万级并发架构解决方案阶段十一:高并发语言GO开发Python全栈开发与人工智能之高并发语言GO开发学习内容包括:GO语言基础、数据类型与文件IO操作、函数和面向对象、并发编程等。

如何系统地自学 Python

是否非常想学好Python,一方面被琐事纠缠,一直没能动手,另一方面,担心学习成本太高,心里默默敲着退堂鼓?

幸运的是,Python是一门初学者友好的编程语言,想要完全掌握它,你不必花上太多的时间和精力。

Python的设计哲学之一就是简单易学,体现在两个方面:语法简洁明了:相对Ruby和Perl,它的语法特性不多不少,大多数都很简单直接,不玩儿玄学。

切入点很多:Python可以让你可以做很多事情,科学计算和数据分析、爬虫、Web网站、游戏、命令行实用工具等等等等,总有一个是你感兴趣并且愿意投入时间的。

废话不多说,学会一门语言的捷径只有一个:GettingStarted¶起步阶段任何一种编程语言都包含两个部分:硬知识和软知识,起步阶段的主要任务是掌握硬知识。

硬知识“硬知识”指的是编程语言的语法、算法和数据结构、编程范式等,例如:变量和类型、循环语句、分支、函数、类。这部分知识也是具有普适性的,看上去是掌握了一种语法,实际是建立了一种思维。

例如:让一个Java程序员去学习Python,他可以很快的将Java中的学到的面向对象的知识map到Python中来,因此能够快速掌握Python中面向对象的特性。

如果你是刚开始学习编程的新手,一本可靠的语法书是非常重要的。它看上去可能非常枯燥乏味,但对于建立稳固的编程思维是必不可少。

下面列出了一些适合初学者入门的教学材料:廖雪峰的Python教程 Python中文教程的翘楚,专为刚刚步入程序世界的小白打造。

笨方法学Python 这本书在讲解Python的语法成分时,还附带大量可实践的例子,非常适合快速起步。

TheHitchhiker’sGuidetoPython! 这本指南着重于Python的最佳实践,不管你是Python专家还是新手,都能获得极大的帮助。

Python的哲学:用一种方法,最好是只有一种方法来做一件事。学习也是一样,虽然推荐了多种学习资料,但实际学习的时候,最好只选择其中的一个,坚持看完。

必要的时候,可能需要阅读讲解数据结构和算法的书,这些知识对于理解和使用Python中的对象模型有着很大的帮助。软知识“软知识”则是特定语言环境下的语法技巧、类库的使用、IDE的选择等等。

这一部分,即使完全不了解不会使用,也不会妨碍你去编程,只不过写出的程序,看上去显得“傻”了些。对这些知识的学习,取决于你尝试解决的问题的领域和深度。

对初学者而言,起步阶段极易走火,或者在选择Python版本时徘徊不决,一会儿看2.7一会儿又转到3.0,或者徜徉在类库的大海中无法自拔,Scrapy,Numpy,Django什么都要试试,或者参与编辑器圣战、大括号缩进探究、操作系统辩论赛等无意义活动,或者整天跪舔语法糖,老想着怎么一行代码把所有的事情做完,或者去构想圣洁的性能安全通用性健壮性全部满分的解决方案。

很多“大牛”都会告诫初学者,用这个用那个,少走弯路,这样反而把初学者推向了真正的弯路。还不如告诉初学者,学习本来就是个需要你去走弯路出Bug,只能脚踏实地,没有奇迹只有狗屎的过程。

选择一个方向先走下去,哪怕脏丑差,走不动了再看看有没有更好的解决途径。

自己走了弯路,你才知道这么做的好处,才能理解为什么人们可以手写状态机去匹配却偏要发明正则表达式,为什么面向过程可以解决却偏要面向对象,为什么我可以操纵每一根指针却偏要自动管理内存,为什么我可以嵌套回调却偏要用Promise…更重要的是,你会明白,高层次的解决方法都是对低层次的封装,并不是任何情况下都是最有效最合适的。

技术涌进就像波浪一样,那些陈旧的封存已久的技术,消退了迟早还会涌回的。就像现在移动端应用、手游和HTML5的火热,某些方面不正在重演过去PC的那些历史么?

因此,不要担心自己走错路误了终身,坚持并保持进步才是正道。起步阶段的核心任务是掌握硬知识,软知识做适当了解,有了稳固的根,粗壮的枝干,才能长出浓密的叶子,结出甜美的果实。

¶发展阶段完成了基础知识的学习,必定会感到一阵空虚,怀疑这些语法知识是不是真的有用。没错,你的怀疑是非常正确的。要让Python发挥出它的价值,当然不能停留在语法层面。

发展阶段的核心任务,就是“跳出Python,拥抱世界”。

在你面前会有多个分支:科学计算和数据分析、爬虫、Web网站、游戏、命令行实用工具等等等等,这些都不是仅仅知道Python语法就能解决的问题。

拿爬虫举例,如果你对计算机网络,HTTP协议,HTML,文本编码,JSON一无所知,你能做好这部分的工作么?

而你在起步阶段的基础知识也同样重要,如果你连循环递归怎么写都还要查文档,连BFS都不知道怎么实现,这就像工匠做石凳每次起锤都要思考锤子怎么使用一样,非常低效。

在这个阶段,不可避免要接触大量类库,阅读大量书籍的。

类库方面「AwesomePython项目」:vinta/awesome-python·GitHub这里列出了你在尝试解决各种实际问题时,Python社区已有的工具型类库,如下图所示:请点击输入图片描述vinta/awesome-python你可以按照实际需求,寻找你需要的类库。

至于相关类库如何使用,必须掌握的技能便是阅读文档。由于开源社区大多数文档都是英文写成的,所以,英语不好的同学,需要恶补下。

书籍方面这里我只列出一些我觉得比较有一些帮助的书籍,详细的请看豆瓣的书评:科学和数据分析:❖「集体智慧编程」:集体智慧编程(豆瓣)❖「数学之美」:数学之美(豆瓣)❖「统计学习方法」:统计学习方法(豆瓣)❖「PatternRecognitionAndMachineLearning」:PatternRecognitionAndMachineLearning(豆瓣)❖「数据科学实战」:数据科学实战(豆瓣)❖「数据检索导论」:信息检索导论(豆瓣)爬虫:❖「HTTP权威指南」:HTTP权威指南(豆瓣)Web网站:❖「HTML&CSS设计与构建网站」:HTML&CSS设计与构建网站(豆瓣)…列到这里已经不需要继续了。

聪明的你一定会发现上面的大部分书籍,并不是讲Python的书,而更多的是专业知识。

事实上,这里所谓“跳出Python,拥抱世界”,其实是发现Python和专业知识相结合,能够解决很多实际问题。这个阶段能走到什么程度,更多的取决于自己的专业知识。

¶深入阶段这个阶段的你,对Python几乎了如指掌,那么你一定知道Python是用C语言实现的。

可是Python对象的“动态特征”是怎么用相对底层,连自动内存管理都没有的C语言实现的呢?

这时候就不能停留在表面了,勇敢的拆开Python的黑盒子,深入到语言的内部,去看它的历史,读它的源码,才能真正理解它的设计思路。

这里推荐一本书:「Python源码剖析」:Python源码剖析(豆瓣)这本书把Python源码中最核心的部分,给出了详细的阐释,不过阅读此书需要对C语言内存模型和指针有着很好的理解。

另外,Python本身是一门杂糅多种范式的动态语言,也就是说,相对于C的过程式、Haskell等的函数式、Java基于类的面向对象而言,它都不够纯粹。

换而言之,编程语言的“道学”,在Python中只能有限的体悟。学习某种编程范式时,从那些面向这种范式更加纯粹的语言出发,才能有更深刻的理解,也能了解到Python语言的根源。

这里推荐一门公开课「编程范式」:斯坦福大学公开课:编程范式讲师高屋建瓴,从各种编程范式的代表语言出发,给出了每种编程范式最核心的思想。

值得一提的是,这门课程对C语言有非常深入的讲解,例如C语言的范型和内存管理。这些知识,对阅读Python源码也有大有帮助。

Python的许多最佳实践都隐藏在那些众所周知的框架和类库中,例如Django、Tornado等等。在它们的源代码中淘金,也是个不错的选择。

¶ 最后的话每个人学编程的道路都是不一样的,其实大都殊途同归,没有迷路的人只有不能坚持的人!

希望想学Python想学编程的同学,不要犹豫了,看完这篇文章,JustGettingStarted !!!

深度学习需要有python基础吗?

首先,深度学习需要Python基础,如果你会Java也是可以的,计算机专业同样可以学习。

深度学习是一类模式分析方法的统称,就具体研究内容而言,主要涉及三类方法:(1)基于卷积运算的神经网络系统,即卷积神经网络(CNN)。

(2)基于多层神经元的自编码神经网络,包括自编码(Autoencoder)以及近年来受到广泛关注的稀疏编码两类(SparseCoding)。

(3)以多层自编码神经网络的方式进行预训练,进而结合鉴别信息进一步优化神经网络权值的深度置信网络(DBN)。

深度学习作为实现机器学习的技术,拓展了人工智能领域范畴,主要应用于图像识别、语音识别、自然语言处理。

推动市场从无人驾驶和机器人技术行业扩展到金融、医疗保健、零售和农业等非技术行业,因此掌握深度学习的AI工程师成为了各类型企业的招聘热门岗位。了解更多查看深度学习。

怎样用python构建一个卷积神经网络模型

上周末利用python简单实现了一个卷积神经网络,只包含一个卷积层和一个maxpooling层,pooling层后面的多层神经网络采用了softmax形式的输出。

实验输入仍然采用MNIST图像使用10个featuremap时,卷积和pooling的结果分别如下所示。

部分源码如下:[python] viewplain copy#coding=utf-8””’Created on 2014年11月30日@author: Wangliaofan”’import numpyimport structimport matplotlib.pyplot as pltimport mathimport randomimport copy#testfrom BasicMultilayerNeuralNetwork import BMNN2def sigmoid(inX):if (-inX)== 0.0:return 999999999.999999999return 1.0/((-inX))def difsigmoid(inX):return sigmoid(inX)*(1.0-sigmoid(inX))def tangenth(inX):return (1.0*(inX)-1.0*(-inX))/(1.0*(inX)+1.0*(-inX))def cnn_conv(in_image, filter_map,B,type_func=’sigmoid’):#in_image[num,feature map,row,col]=>in_image[Irow,Icol]#features map[k filter,row,col]#type_func[‘sigmoid’,’tangenth’]#out_feature[k filter,Irow-row+1,Icol-col+1]shape_image=numpy.shape(in_image)#[row,col]#print “shape_image”,shape_imageshape_filter=numpy.shape(filter_map)#[k filter,row,col]if shape_filter[1]>shape_image[0] or shape_filter[2]>shape_image[1]:raise Exceptionshape_out=(shape_filter[0],shape_image[0]-shape_filter[1]+1,shape_image[1]-shape_filter[2]+1)out_feature=numpy.zeros(shape_out)k,m,n=numpy.shape(out_feature)for k_idx in range(0,k):#rotate 180 to calculate convc_filter=numpy.rot90(filter_map[k_idx,:,:], 2)for r_idx in range(0,m):for c_idx in range(0,n):#conv_temp=numpy.zeros((shape_filter[1],shape_filter[2]))(in_image[r_idx:r_idx+shape_filter[1],c_idx:c_idx+shape_filter[2]],c_filter)(conv_temp)if type_func==’sigmoid’:out_feature[k_idx,r_idx,c_idx]=sigmoid(sum_temp+B[k_idx])elif type_func==’tangenth’:out_feature[k_idx,r_idx,c_idx]=tangenth(sum_temp+B[k_idx])else:raise Exceptionreturn out_featuredef cnn_maxpooling(out_feature,pooling_size=2,type_pooling=”max”):k,row,col=numpy.shape(out_feature)max_index_Matirx=numpy.zeros((k,row,col))out_row=int(numpy.floor(row/pooling_size))out_col=int(numpy.floor(col/pooling_size))out_pooling=numpy.zeros((k,out_row,out_col))for k_idx in range(0,k):for r_idx in range(0,out_row):for c_idx in range(0,out_col):temp_matrix=out_feature[k_idx,pooling_size*r_idx:pooling_size*r_idx+pooling_size,pooling_size*c_idx:pooling_size*c_idx+pooling_size]out_pooling[k_idx,r_idx,c_idx](temp_matrix)max_index=numpy.argmax(temp_matrix)#print max_index#print max_index/pooling_size,max_index%pooling_sizemax_index_Matirx[k_idx,pooling_size*r_idx+max_index/pooling_size,pooling_size*c_idx+max_index%pooling_size]=1return out_pooling,max_index_Matirxdef poolwithfunc(in_pooling,W,B,type_func=’sigmoid’):k,row,col=numpy.shape(in_pooling)out_pooling=numpy.zeros((k,row,col))for k_idx in range(0,k):for r_idx in range(0,row):for c_idx in range(0,col):out_pooling[k_idx,r_idx,c_idx]=sigmoid(W[k_idx]*in_pooling[k_idx,r_idx,c_idx]+B[k_idx])return out_pooling#out_feature is the out put of convdef backErrorfromPoolToConv(theta,max_index_Matirx,out_feature,pooling_size=2):k1,row,col=numpy.shape(out_feature)error_conv=numpy.zeros((k1,row,col))k2,theta_row,theta_col=numpy.shape(theta)if k1!=k2:raise Exceptionfor idx_k in range(0,k1):for idx_row in range( 0, row):for idx_col in range( 0, col):error_conv[idx_k,idx_row,idx_col]=\max_index_Matirx[idx_k,idx_row,idx_col]*\float(theta[idx_k,idx_row/pooling_size,idx_col/pooling_size])*\difsigmoid(out_feature[idx_k,idx_row,idx_col])return error_convdef backErrorfromConvToInput(theta,inputImage):k1,row,col=numpy.shape(theta)#print “theta”,k1,row,coli_row,i_col=numpy.shape(inputImage)if row>i_row or col> i_col:raise Exceptionfilter_row=i_row-row+1filter_col=i_col-col+1detaW=numpy.zeros((k1,filter_row,filter_col))#the same with conv valid in matlabfor k_idx in range(0,k1):for idx_row in range(0,filter_row):for idx_col in range(0,filter_col):subInputMatrix=inputImage[idx_row:idx_row+row,idx_col:idx_col+col]#print “subInputMatrix”,numpy.shape(subInputMatrix)#rotate theta 180#print numpy.shape(theta)theta_rotate=numpy.rot90(theta[k_idx,:,:], 2)#print “theta_rotate”,theta_rotate(subInputMatrix,theta_rotate)detaW[k_idx,idx_row,idx_col](dotMatrix)detaB=numpy.zeros((k1,1))for k_idx in range(0,k1):detaB[k_idx](theta[k_idx,:,:])return detaW,detaBdef loadMNISTimage(absFilePathandName,datanum=60000):images=open(absFilePathandName,’rb’)()index=0magic, numImages , numRows , numColumns = struct.unpack_from(‘>IIII’ , buf , index)print magic, numImages , numRows , numColumnsindex += struct.calcsize(‘>IIII’)if magic != 2051:raise Exceptiondatasize=int(784*datanum)datablock=”>”+str(datasize)+”B”#nextmatrix=struct.unpack_from(‘>47040000B’ ,buf, index)nextmatrix=struct.unpack_from(datablock ,buf, index)nextmatrix=numpy.array(nextmatrix)/255.0#nextmatrix=nextmatrix.reshape(numImages,numRows,numColumns)#nextmatrix=nextmatrix.reshape(datanum,1,numRows*numColumns)nextmatrix=nextmatrix.reshape(datanum,1,numRows,numColumns)return nextmatrix, numImagesdef loadMNISTlabels(absFilePathandName,datanum=60000):labels=open(absFilePathandName,’rb’)()index=0magic, numLabels = struct.unpack_from(‘>II’ , buf , index)print magic, numLabelsindex += struct.calcsize(‘>II’)if magic != 2049:raise Exceptiondatablock=”>”+str(datanum)+”B”#nextmatrix=struct.unpack_from(‘>60000B’ ,buf, index)nextmatrix=struct.unpack_from(datablock ,buf, index)nextmatrix=numpy.array(nextmatrix)return nextmatrix, numLabelsdef simpleCNN(numofFilter,filter_size,pooling_size=2,maxIter=1000,imageNum=500):decayRate=0.01MNISTimage,num1=loadMNISTimage(“F:\Machine Learning\UFLDL\data\common\\train-images-idx3-ubyte”,imageNum)print num1row,col=numpy.shape(MNISTimage[0,0,:,:])out_Di=numofFilter*((row-filter_size+1)/pooling_size)*((col-filter_size+1)/pooling_size)MLP=BMNN2.MuiltilayerANN(1,[128],out_Di,10,maxIter)MLP.setTrainDataNum(imageNum)MLP.loadtrainlabel(“F:\Machine Learning\UFLDL\data\common\\train-labels-idx1-ubyte”)MLP.initialweights()#MLP.printWeightMatrix()rng = numpy.random.RandomState(23455)W_shp = (numofFilter, filter_size, filter_size)W_bound = (numofFilter * filter_size * filter_size)W_k=rng.uniform(low=-1.0 / W_bound,high=1.0 / W_bound,size=W_shp)B_shp = (numofFilter,)B= numpy.asarray(rng.uniform(low=-.5, high=.5, size=B_shp))cIter=0while cIter。

以就业为目的自学python,要学习哪些内容?

。

优就业的Python课程一共设置了5大阶段,主要学习内容如下第一阶段:Python核心编程——Python语言基本介绍、面向对象编程、Linux操作系统、文件系统与用户管理、进程管理与服务配置、Shell编程与bash,源文件编译、版本控制、MySQL使用、MySQL进阶等。

第二阶段:全栈开发——HTML、CSS、JavaScript、jQuery、BootStrap、Vue、Web开发基础、数据库操作、FLask配置、Django认识、Models、Templates、Views、Tornado框架进阶、ElasticSearch等。

第三阶段:网络爬虫——爬虫与数据、Scrapy框架、Scrapy框架与信息实时抓取、定时爬取与邮件监控、NoSQL数据库、Scrapy-Redis框架、百万量数据采集等。

第四阶段:人工智能——数据分析、pyechart模块动态可视化、词云、分类算法、聚类算法、回归类算法、关联算法、卷积神经网络、TensorFlow+PaddlePaddle、图像识别等。

第五阶段:就业指导——最后就业指导分为面试就业指导、专业技术指导两方面。因为优就业Python课程内容会不定期更新,课程时长也会对应有所调整,就目前来看Python的学习时间是在5个月左右。

Python课程设置时长是和学习内容紧密相关的,相对而言,课程内容涉及越广、内容越多,学习时间也会长。

请问一下,无基础学习卷积神经网络需要多久?

。

卷积神经网络有以下几种应用可供研究:1、基于卷积网络的形状识别物体的形状是人的视觉系统分析和识别物体的基础,几何形状是物体的本质特征的表现,并具有平移、缩放和旋转不变等特点,所以在模式识别领域,对于形状的分析和识别具有十分重要的意义,而二维图像作为三维图像的特例以及组成部分,因此二维图像的识别是三维图像识别的基础。

2、基于卷积网络的人脸检测卷积神经网络与传统的人脸检测方法不同,它是通过直接作用于输入样本,用样本来训练网络并最终实现检测任务的。

它是非参数型的人脸检测方法,可以省去传统方法中建模、参数估计以及参数检验、重建模型等的一系列复杂过程。本文针对图像中任意大小、位置、姿势、方向、肤色、面部表情和光照条件的人脸。

3、文字识别系统在经典的模式识别中,一般是事先提取特征。提取诸多特征后,要对这些特征进行相关性分析,找到最能代表字符的特征,去掉对分类无关和自相关的特征。

然而,这些特征的提取太过依赖人的经验和主观意识,提取到的特征的不同对分类性能影响很大,甚至提取的特征的顺序也会影响最后的分类性能。同时,图像预处理的好坏也会影响到提取的特征。

文章出处登录后可见!