如何通过用户研究评估交互式系统

简要总结各种研究人员如何设计用户研究来评估从机器学习到数据提取的不同交互系统的有效性

近年来,交互系统的开发蓬勃发展,例如应用程序、网站和端到端工具。交互式系统旨在帮助用户完成某些任务,例如清除大型数据集中的错误或从数千个文档中快速提取表格。公司在这些项目上花费数千美元,而工程师则花费数百小时来构建这些系统。然而,当他们将这些系统展示给用户或客户使用时,用户的反应可能会有所不同,从“这个系统非常难以使用”到“这个系统太棒了!”。

虽然很难预测您的用户会说什么,但重要的是通过量化您的交互式系统的有效性和有用性来缓解用户体验的任何问题。通读技术文献描述了其他人如何进行用户研究以评估其系统的有效性。

如何使用用户研究评估交互式系统的有效性?具体来说,系统在帮助用户完成目标任务方面有多大用处?

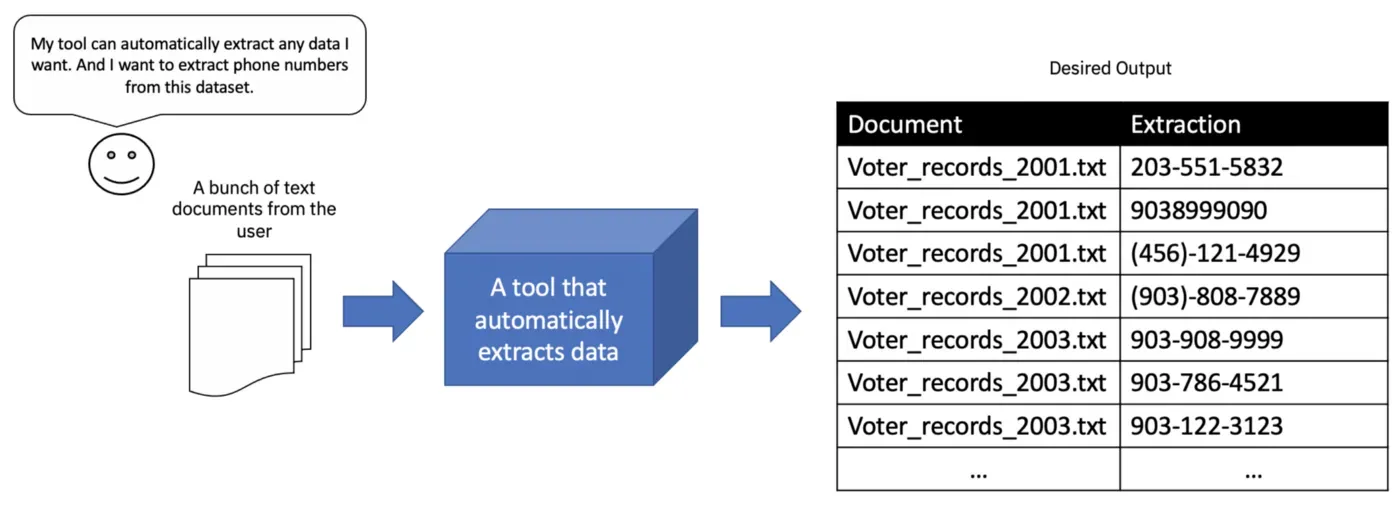

例如,假设您已经构建了一个系统,该系统可以学习从用户给定的文本示例中自动提取数据。当用户提供电话号码示例时,您的系统会学习从数百个其他文档中提取电话号码。

您如何评估这样的系统是否真的可以帮助用户快速准确地提取文本?

大多数系统评估都是基于算法或基于用户的。当您基于算法实现进行评估时,指标和方法与使用用户进行评估时不同,后者需要招募和观察使用您的系统的人。

本文的重点是我所说的比较用户评估。这些评估将您的系统与基线系统进行比较。目标是根据某些选定指标证明您的系统优于某些基线系统。招募人员,要求他们完成系统上的某些任务,并观察用户执行任务的情况。

我将简要参考十篇对调试系统、机器学习系统以及数据转换和数据提取系统进行比较评估的论文。我将描述这些论文的比较用户评价的一些异同。希望这篇简短的评论能够大致说明如何进行比较用户评估。

选择一个基线系统来比较你的系统

运行比较用户评估涉及将用户在系统上的性能与基线系统进行比较。

- 基线系统可以是实际系统的“基本”版本,其核心功能 — 帮助用户完成任务的功能 — 被剥离。

- 或者,基线系统可以具有实际系统的某些功能子集。

- 或者,基线系统可能是一个完全不同的系统,可能没有您的系统所具有的有用功能。

这样的系统,无论是具有不同配置的系统还是完全不同的系统,也被称为实验条件。

与系统的基本版本进行比较

例如,WhyFlow 是一个交互式可视化调试系统,其基线是 WhyFlow 的基本版本,其自动生成的错误解释功能被禁用。此基线旨在模拟不存在此类自动生成的解释功能的手动调试。[0]

对比不同版本的系统

另一种类型的基线可以是系统本身的不同版本,具有启用或禁用某些功能的组合。这方面的一个例子是在称为 DataPlay 的系统上进行的评估。 DataPlay 是一个交互式数据库查询系统,支持试错查询规范。在其评估中,要求用户修复 SQL 查询中的错误。 DataPlay 与 Dataplay 本身的两个不同版本进行了比较:[0]

- 一个版本的 DataPlay,仅启用了一项称为直接操作的功能。

- DataPlay 的另一个版本,仅启用了一项称为自动查询更正的功能。

与完全不同的系统进行比较

另一种选择是将您的系统与完成相同任务的完全不同的系统进行比较。这个系统应该被认为是最先进的,你的目标是证明你的系统比最先进的系统更好。使用系统 RxFiddle 完成了此类实验的一个示例。[0]

RxFiddle 的用户必须使用 RxFiddle 专门为调试反应式程序而设计的可视化来调试反应式程序中的错误。由于响应式程序的非线性执行和事件驱动的性质,调试反应式程序比在其他编程范例中调试更具挑战性。当输出异步发生时,这使得用户很难识别错误的来源。由于用户传统上使用 Chrome 的开发工具来调试此类程序,因此 RxFiddle 的比较用户评估是针对 Chrome 的开发工具进行的。

WhyFlow 和 RxFiddle 彼此相似,因为它们与不具备某些关键功能的传统调试系统进行了比较,例如可视化,自动生成的错误解释。

实验类型:受试者内和受试者间用户研究

虽然有很多种用户研究设计,但我将特别关注主题内或主题间用户研究的论文:

- 主题内用户研究:您招募的每个用户都将作为他们自己的基线。换句话说,同一个人测试系统的所有条件。

- 主题间用户研究:与主题内用户研究不同,您招募的每个用户都不会测试每个条件。换句话说,不同的用户测试每个条件。

例如,WhyFlow 进行了主题内用户研究。所有 10 名被招募的用户都接触了 WhyFlow 的所有条件。另一方面,RxFiddle 进行了主题间用户研究。他们的一些用户被指示使用 RxFiddle 来完成调试任务。他们招募的其余用户被指示使用传统的调试工具(Chrome Dev Tools)来完成调试任务。

主题内用户研究往往是首选。然而,由于每个招募的用户都必须接触系统的每个条件,大多数主题内用户研究通常会占用大量时间。例如,在 WhyFlow 的案例中,每个用户平均需要 2 个小时,因为每个用户需要大约一个小时来处理系统的每个条件。主题内用户研究通常不会招募很多用户(少于 20 个,具体取决于系统条件的数量)。

对每个用户而言,主题间用户研究占用的时间更少,因为他们只接触到系统的一个条件。在实验条件下,RxFiddle 用户平均总共花费 40 分钟来完成任务。主题间用户研究通常会招募许多用户。 RxFiddle 的用户研究共招募了 111 名用户。

然而,主题内用户研究具有学习效果的潜力,其中将用户暴露于一种条件的效果可能会溢出到用户在以下条件下的表现。在所审查的主题内用户研究中,他们通过随机化条件的顺序来降低潜在的学习效果:“工具顺序被随机化以分布可转移知识的影响”。此外,用户的任务在每种情况下都不同。

十项比较用户评价总结

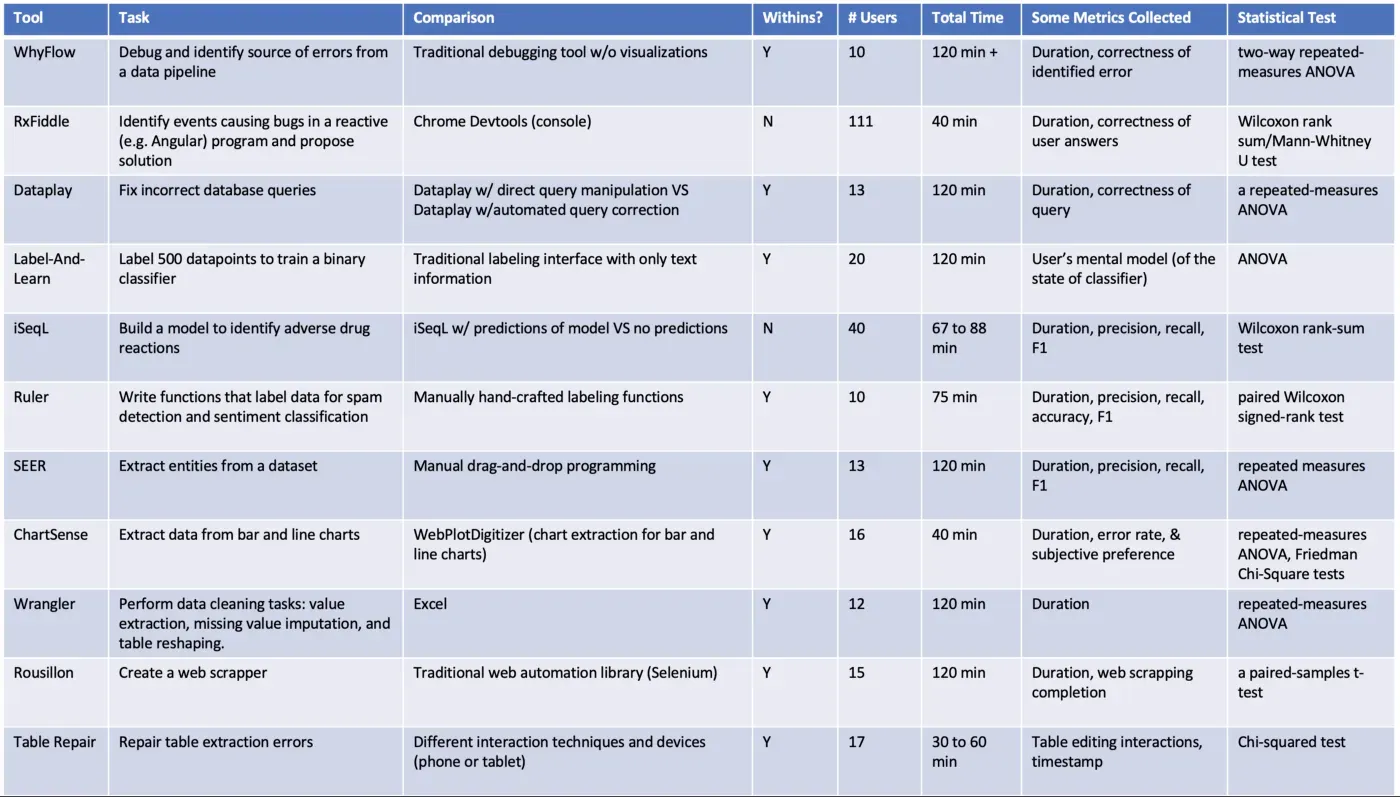

在本节中,我们简要总结了对调试、机器学习和数据提取系统进行的十个比较用户评估。请参阅下表,对于每个系统的比较用户评估,我们列出了以下内容:

- 任务:分配给用户的任务,例如调试、标记机器学习模型、完成提取任务等。

- 比较:进行比较的系统或功能。

- 受试者内:Y 表示该研究是受试者内实验,否则 N 表示受试者间实验。

- 用户数:招募的用户总数。

- 总时间:一个用户学习会话的总持续时间。其中一些持续时间考虑了用户阅读和签署同意书所需的时间、培训用户理解任务和系统所需的时间以及用户回答任何初步和/或研究后问卷调查所需的时间.

- 收集的指标:作者在实验期间记录的一些指标。流行的指标包括用户完成分配任务的持续时间以及任务完成的正确性、准确性或百分比。

- 统计检验:我简要记录了用于比较样本的统计检验,这是一个单独的主题。

Observations

Label-And-Learn、iSeqL 和 Ruler 是帮助构建机器学习产品的系统。 SEER、ChartSense、Wrangler、Rousillon 和 Table Repair 是提取数据的系统。稍后我们将详细描述这些系统。[0][1][2][3][4][5][6][7]

请注意,大多数用户评估都是主题内实验。一个用户会话的持续时间最长为 2 小时。招募的用户数量一般在10到20人左右。

大多数研究收集了用户完成任务所需的持续时间。通常,此指标用于证明用户使用目标系统比使用基线系统更快地完成分配的任务。大多数研究还收集有关用户表现的准确度指标。此处的准确性指标是指用户对分配任务的回答的正确性。

对于输出某些模型的系统,无论是机器学习模型还是数据提取模型(从文档中提取文本、表格、图像等的程序),它们都会记录传统指标,例如精度、召回率和 F1 分数。

机器学习系统的比较用户评估

我们审查的机器学习 (ML) 系统侧重于帮助用户理解 ML 模型或训练 ML 模型所需的标签数据:

- Label-and-learn:一种可视化工具,可帮助开发人员在标记数据集和训练 ML 分类器时深入了解他们的数据集。在给定训练数据的某个子集及其在测试集上的表现的情况下,它可视化分类器的预测。

- iSeqL:一种交互式工具,用于快速定制 ML 模型以提取特定领域的概念,例如药物评论数据集中包含药物不良反应的短语。用户迭代地标记数据并训练模型,直到它可以提取特定领域的概念。

- Ruler:自动生成标注规则的交互系统。标记规则可快速标记数千个数据点,提供手动标记的替代方法。传统上,标签规则是由人类手动编写的。 Ruler 通过从观察用户提供的演示中综合标记规则来自动化该过程。

对研究设置的评论。虽然主题内实验在该论文样本中很受欢迎,但 iSeqL 是通过在线进行的主题间实验进行评估的,就像 RxFiddle 一样。有两个条件:(1) 一个版本的 iSeqL,模型的预测对用户可见;(2) 一个版本的 iSeqL,预测不可见。这种设置允许 iSeqL 的创建者评估他们关于交互界面的一些设计决策。具体来说,在标签界面中显示模型的预测是否会帮助用户识别将提高 ML 模型性能的相关短语?招募的用户的任务是建立一个机器学习模型,并通过提供相关短语来迭代改进它。

另一方面,Label-and-learn 和 Ruler 的用户研究是主题内实验。标记和学习在用户标记训练数据时可视化 ML 分类器成功的可能性。 Label-and-learn 的用户研究将其用于探索和标记数据的全功能可视化和界面与仅具有文本信息的标记界面的基本版本进行了比较。

我发现 Label-and-learn 的用户任务在 Ruler 和 iSeqL 的任务中是独一无二的。每个用户都被要求标记 500 个数据点来训练一个二元分类器。在用户标记为 50、100、200 和 400 个实例之后设置了检查点;为了评估用户对二元分类器的心理模型,向用户提供了一个简短的测验。该测验测试了用户对分类器决策的理解。

与帮助人类用户标记数据的 Label-and-learn 和 iSeqL 不同,Ruler 专注于自动生成标记规则。标签规则传统上是在一个名为 Jupyter 的系统中手工制作的。用户研究的设置很简单:将 Ruler 生成的标记规则与 Jupyter 中手工制作的标记规则进行比较。用户的任务是编写标记规则来训练用于垃圾邮件检测和情感分类的 ML 模型。他们记录了标签功能的个人和总体表现。

数据提取系统的比较用户评估

我们审查的数据提取系统帮助他们的用户快速准确地执行数据提取或数据转换:

- SEER:通过从用户突出显示的示例中自动生成提取规则来自动提取文本。

- ChartSense:半自动交互式图表数据提取工具。它集成了可以检测标记的算法,例如条形图中的条,折线图中的标记等。用户可以与系统交互以修复提取中的任何错误。

- Wrangler:用于清理和转换数据的交互式系统。系统从用户演示的数据操作中学习数据转换。

- Rousillon:一种编程系统,可以从用户提供的提取内容演示中学习编写复杂的 Web 自动化脚本。

- 表修复:交互式表修复管道。该管道自动提取表格,并带有对手机和平板电脑用户友好的界面,可以轻松修复表格提取中的错误。

对研究设置的评论。大多数数据提取工具的比较用户研究的设置很简单。指示用户完成一组提取任务。所有研究均为受试者内实验。这些系统与一个类似的系统进行了比较,该系统在帮助用户快速准确地完成任务方面缺少关键功能。

SEER 实验的用户的任务是提取文本实体,例如日期和百分比增加/减少。 SEER 与用户通过拖放界面手动创建提取规则的系统进行了比较。

ChartSense 实验的用户的任务是从条形图和折线图中提取数据。 ChartSense 与一个类似但有限的图表提取系统 WebPlotDigitizer(条形图和折线图的图表提取系统)进行了比较。

Wrangler 实验的用户的任务是执行数据清理任务,例如值提取、缺失值插补和表格重塑。 Wrangler 与 Microsoft Excel 进行了比较,后者允许用户通过一定程度的手动操作来完成这些数据清理任务。

Rousillon 实验的用户被分配了网络抓取任务。网页抓取是指从网站中提取数据。 Rousillon 与 Selenium 进行了比较,Selenium 是一个传统的 Web 自动化库,供编写 Web 抓取脚本的用户使用。

表修复有一个相当不同的用户研究设置。表修复被描述为一个表提取管道,而其用户研究则侧重于随附界面的能力,以帮助用户快速轻松地修复表提取系统中发现的错误。管道是独一无二的(在撰写本文时)。用户研究的条件由支持的用户交互和设备(手机或平板电脑)的不同组合定义。

Conclusions

这远非全面,仅简要概述了我在阅读比较用户评估时的一些观察结果。当我们投入大量时间、金钱和精力来构建这些系统时,我们还应该了解评估我们的系统是否帮助我们的用户和客户的量化方法。

References

文章出处登录后可见!