Multi-Interactive Memory Network for Aspect Based Multimodal Sentiment Analysis

论文地址:https://ojs.aaai.org/index.php/AAAI/article/view/3807

代码和数据集地址:https://github.com/xunan0812/MIMN

1、简介

方面级的情感分析的目标是为了识别一个句子中指定方面的情感极性,它可以分为一下两类:

- Aspect term:Aspect Term Sentiment Analysis的目标是预测每个实体的情感,实体为输入文本中提到的单词或者是短语。

- Aspect category:Aspect Category Sentiment Analysis的目标是检测预先定义的方面类别的有关情感。该类别可能不是输入文本中提到的单词或短语。

多模态情感分析则是利用多个模态(如文本、图像)的数据信息去分析情感极性。目前,方面级的情感分析基本上都是基于文本的,本文将基于方面的情感分析和多模态情感分析结合起来开展工作,提出了一个新的任务:基于方面的多模态情感分析,并为这一任务提出了多交互记忆网络(Multi-Interactive Memory Network,MIMN)。建立了一个新的多模态数据集,该数据集从ZOL.com上抓取,并在该数据集上评估模型。

在多模态数据中,文本和图像都与方面的情感高度相关。例如,在评价手机拍照效果时,客户可以写正面的文字和好的照片表示满意,相反使用负面文字和不好的图片来表达不满。文本和图像还可以相互促进,相互补充,以加强对特定方面的情感分析。在本文之前,在方面级和多模态情感分析的交叉点上还没有开展相关的工作。

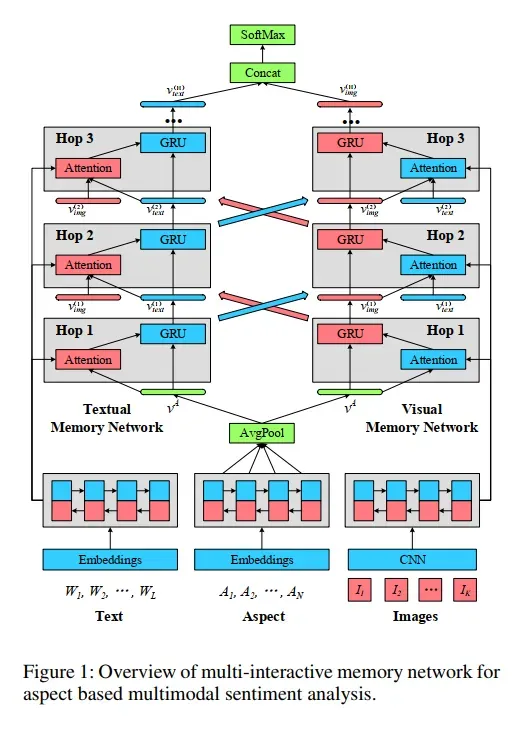

本文填补了研究空白,提出了基于方面的多模态情感分析任务,将图像模态数据引入到了传统的方面级情感分析。为了捕捉方面给文本和图像带来的影响,以及文本和图像相关的多种互动,本文提出了多交互记忆网络(MIMN)。该模型不仅学习跨模态数据时的交互影响,还学习单模态数据的自我影响。

本文有以下贡献:

- 提出了基于方面的多模态情感分析这一新课题。

- 提出了多交互记忆网络(MIMN),以捕捉多模态数据中的多种关联,以用于方面层面的情感分析,包括方面给图像带来的影响,以及文本和图像之间的相互作用。

- 提供了一个新的公开可用的多模态方面的情感数据集来评估模型,并在构建的数据集上显示了模型的有效性。

2、MIMN模型

给定一个样本,假设多模态输入包括一个文本内容和一个图像集

,该模型的目标是用给定的方面短语

来预测情感标签,其中

是文本的长度,

是图像的数量,

是方面短语的长度。下图为MIMN模型的整体架构。

文章出处登录后可见!

已经登录?立即刷新