个人 AI 的革命:Nvidia’s Chat with RTX 深度探索

Nvidia 推出的 Chat with RTX 预示着个人 AI 新时代的到来。2 月 13 日,Nvidia 官宣了自家的 AI 聊天机器人,这不仅是人工智能交互的渐进式改进;更代表了个人如何利用自己的数据进行洞察、研究和知识发现的巨大转变。Chat with RTX 专为配备强大的 RTX 30 或 40 系列 GPU 的 PC 设计,超越了聊天机器人的传统界限,提供了具有变革性和创新性的个性化 AI 体验。

文章目录

什么是 Chat with RTX

Chat with RTX 是 Nvidia 发布的一款 Demo 应用程序,您可以个性化 GPT 大语言模型 (LLM),使其连接到您自己的内容(文档、笔记、视频或其他数据)。利用检索增强生成 (RAG)、TensorRT-LLM 和 RTX 加速,您可以快速获得上下文相关答案。由于 Chat with RTX 全部在 Windows RTX PC 或工作站上本地运行,因此可以获得快速、安全的结果。

Chat with RTX 的优势

本地处理:隐私和性能的飞跃

Chat with RTX 的最重要优势之一是其本地处理功能。 通过直接在用户的 PC 上运行,它利用 Nvidia RTX GPU 的强大计算能力,在 AI 交互中提供前所未有的速度和响应能力。这种本地执行模型可确保敏感数据保留在用户设备的范围内,从而提供云上人工智能服务无法比拟的隐私和数据安全级别。这一功能的重要性怎么强调都不为过,因为它解决了数字时代对数据主权和隐私日益增长的担忧。

高级内容分析:深入内部

Chat with RTX 分析和总结 YouTube 视频和文档内容的能力堪称革命性的。它采用复杂的人工智能模型来消化大量信息,提取相关见解并以极高的准确性总结复杂的数据。这种功能对于从新闻和学术界到法律研究和市场分析等各个领域的专业人士来说都是一个福音,使他们能够以无与伦比的轻松和高效的方式筛选大型数据集和视频内容。 Chat with RTX 提供的深度分析超出了单纯的关键字匹配;它理解上下文,提取相关信息,并以连贯、简洁的方式呈现它。

用户界面友好:为各级用户提供支持

尽管拥有先进的基础架构,Chat with RTX 仍具有有用户友好的界面,使所有技术背景层次的用户都可以使用复杂的 AI。它可以通过网络浏览器访问,简化用户与人工智能交互的过程,使复杂的数据分析任务易于管理且直观。人工智能技术的民主化是向更广泛的受众提供强大的数据分析工具的关键一步,从而促进跨学科的创新和知识发现。

Chat with RTX 的核心技术

Chat with RTX 功能的核心在于 Mistral 或 Llama 2 等先进的 AI 模型,这些模型与 Nvidia Tensor 核心的计算能力相结合,可以促进快速、准确的数据查询。 硬件和软件之间的这种协同不仅体现了英伟达致力于突破人工智能技术界限的承诺,而且还让我们得以一睹个人计算的未来,其中人工智能在提高生产力和实现新形式的创造力方面发挥着核心作用。

得益于 TensorRT-LLM 的使用,大模型可以利用 NVIDIA 的 GPU 加速库进行高性能计算,提高运行效率,减少推理时间。TensorRT-LLM 为用户提供了一个易于使用的 Python API,用于定义大语言模型(LLM)并构建包含最先进 TensorRT 优化引擎,从而在 NVIDIA GPU 上高效执行推理。TensorRT-LLM 还包含创建执行这些 TensorRT 引擎的 Python 和 C++ 运行时组件。它还包括与 NVIDIA Triton 推理服务器集成的后端;一个用于服务 LLM 的生产质量系统。使用 TensorRT-LLM 构建的模型可以在从单个 GPU 到多个节点上的多个 GPU(使用张量并行和/或管道并行)的各种配置上执行。

Chat with RTX 的安装

尽管 Chat with RTX 集成了复杂的技术框架,但它的设计目标是安装简便和易于使用。只需有一个兼容的 RTX GPU,整个安装过程非常简单。

安装 Chat with RTX 的系统需求如下:

| 平台 | Windows |

|---|---|

| GPU | NVIDIA GeForce™ RTX 30 /40 系列 GPU NVIDIA RTX™ Ampere Ada Generation GPU(至少 8GB 显存) |

| 内存 | 至少 16GB |

| 操作系统 | Windows 11 |

| 驱动 | 535.11 或更高 |

| 硬盘 | 150GB 以上 |

初次安装需要下载一个 35.1G 的 zip 压缩包,解压后安装。安装后好需要进一步下载大于语言模型(Llama2 13B 或 Mistral 7B),整体安装完需要 130G 以上的硬盘空间。

运行后,Chat with RTX 会开启一个本地服务与个人本地数据进行交互,用户可以通过浏览器访问 Chat with RTX 的前端页面。

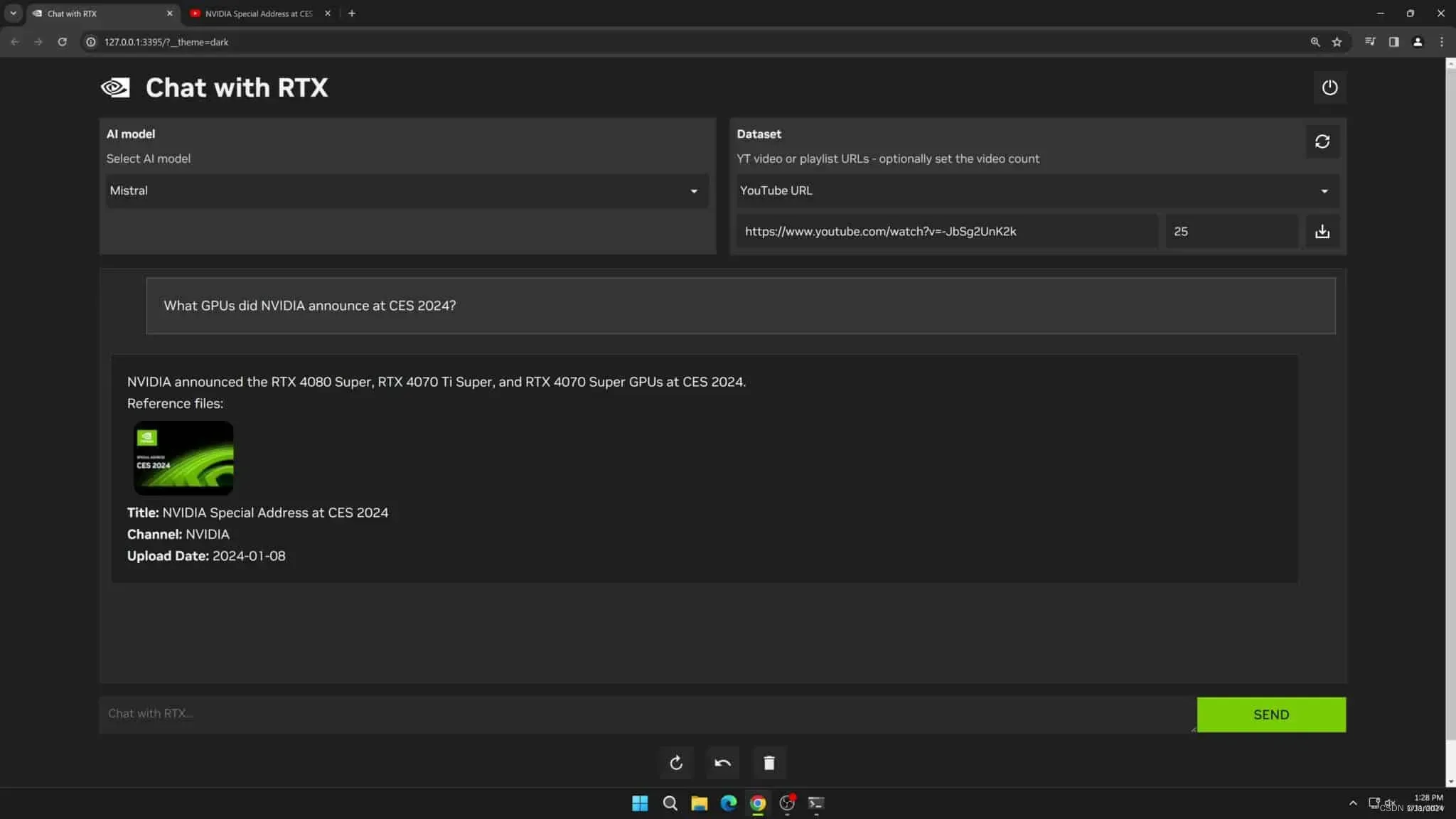

使用非常简单,左上角选择大语言模型,右上角设置要检索的数据,下方的输入框进行提示词提问。

总结

Nvidia Chat with RTX 不仅是一项技术奇迹,更向我们展示了个人 AI 的潜力。未来个人 AI 将成为我们数字生活不可或缺的一部分。Chat with RTX 标志着 AI 向更个性化、高效和安全的 AI 交互方式转变,赋予用户释放数据全部潜力的能力。当我们站在这个新时代的起点时,这种技术的意义深远,它不仅承诺提高我们对信息的理解和使用,还将激发我们在数字领域解决问题和抓住机遇方式上的创新。

Nvidia Chat with RTX 在个人 AI 是一次开创性的飞跃。通过将先进的 AI 模型与 RTX GPU 的原始处理能力相结合,Nvidia 打造了一个创新、实用且极为强大的工具。随着 Chat with RTX 的能力和应用的不断发展,我们将进入一个崭新的 AI 交互前沿,在这里个人数据分析变得更加容易访问、富有洞察力和安全。Chat with RTX 的旅程才刚刚开始,但它改革我们数字生活的潜力是不可否认的,标志着人工智能持续进化中的一个重要里程碑。

版权声明:本文为博主作者:JarodYv原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/jarodyv/article/details/136123162