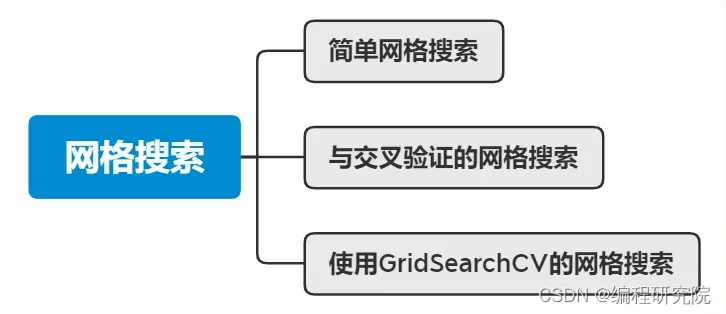

网格搜索,搜索的是参数,即在指定的参数范围内,按步长依次调整参数,利用调整的参数训练学习器,从所有的参数中找到在验证集上精度最高的参数,这其实是一个训练和比较的过程。本节介绍三种网格搜索方法:简单网格搜索、与交叉验证结合的网格搜索、使用GridSearchCV的网格搜索。

网格搜索方法

简单网格搜索

for循环遍历全部的参数设置,并找出最高分和对应的参数。

X_train, X_test, y_train, y_test=train_test_split(wine.data,

wine.target,

random_state=38)

best_score = 0

for alpha in [0.01,0.1,1.0,10.0]:

for max_iter in [100,1000,5000,10000]:

lasso = Lasso(alpha=alpha,max_iter=max_iter)

lasso.fit(X_train, y_train)

score = lasso.score(X_test, y_test)

if score > best_score:

best_score = score

best_parameters={'alpha':alpha,'最大迭代次数':max_iter}

print("模型最高分为:{:.3f}".format(best_score))

print('最佳参数设置:{}'.format(best_parameters))模型最高分为:0.889

最佳参数设置:{‘alpha’: 0.01, ‘最大迭代次数’: 100}

与交叉验证结合的网格搜索

交叉验证法和网格搜索法结合起来找到模型的最优参数。只用先前拆分好的X_train来进行交叉验证,以便我们找到最佳参数之后,再用来拟合X_test来看一下模型的得分。

for alpha in [0.01,0.1,1.0,10.0]:

for max_iter in [100,1000,5000,10000]:

lasso = Lasso(alpha=alpha,max_iter=max_iter)

scores = cross_val_score(lasso, X_train, y_train, cv=6)

score = np.mean(scores)

if score > best_score:

best_score = score

best_parameters={'alpha':alpha, '最大迭代数':max_iter}

print("模型最高分为:{:.3f}".format(best_score))

print('最佳参数设置:{}'.format(best_parameters))模型最高分为:0.865

最佳参数设置:{‘alpha’: 0.01, ‘最大迭代数’: 100}

lasso = Lasso(alpha=0.01, max_iter=100).fit(X_train, y_train)

print('测试数据集得分:{:.3f}'.format(lasso.score(X_test,y_test)))测试数据集得分:0.819

使用GridSearchCV的网格搜索

GridSearchCV本身就是将交叉验证和网格搜索封装在一起。GridSearchCV需要反复建模,所需要的计算时间往往更长。

from sklearn.model_selection import GridSearchCV

params = {'alpha':[0.01,0.1,1.0,10.0],

'max_iter':[100,1000,5000,10000]}

grid_search = GridSearchCV(lasso,params,cv=6)

grid_search.fit(X_train, y_train)

print('模型最高分:{:.3f}'.format(grid_search.score(X_test, y_test)))

print('最优参数:{}'.format(grid_search.best_params_))模型最高分:0.819

最优参数:{‘alpha’: 0.01, ‘max_iter’: 100}

print('交叉验证最高得分:{:.3f}'.format(grid_search.best_score_))交叉验证最高得分:0.865

分析:GridSearchCV有一个属性best_score_,这个属性会存储模型在交叉验证中所得的最高分,而不是在测试数据集上的得分。

想要完整代码的朋友,可toutiao搜索“编程研究坊”关注后s信我,回复“算法笔记23“获取

文章出处登录后可见!

已经登录?立即刷新