1 引言

该论文是关于对抗训练理论分析性的文章,目前对抗训练及其变体已被证明是抵御对抗攻击的最有效防御手段,但对抗训练的过程极其缓慢使其难以扩展到像ImageNet这样的大型数据集上,而且在对抗训练的过程中经常会出现模型过拟合现象。在该论文中,作者从训练样本的角度研究了这一现象,研究表明模型过拟合现象是依赖于训练样本,并且具有较大梯度范数的训练样本更有可能导致灾难性过拟合。因此,作者提出了一种简单但有效的方法,即自适应步长对抗训练 (ATAS)。 ATAS学习调整与其梯度范数成反比的训练样本自适应步长。理论分析表明,ATAS比常用的非自适应算法收敛得更快,在对各种对抗扰动进行评估时,ATAS始终可以减轻模型的过拟合现象,并且该算法在CIFAR10、CIFAR100和ImageNet等数据集上实现更高的模型鲁棒性。

论文链接: https://arxiv.org/abs/2206.02417v1

2 背景知识

FreeAT首先提出了一种快速对抗训练的方法,通过批量重复训练并同时优化模型参数和对抗扰动。YOPO采用了类似的策略来优化对抗损失函数。后来,单步法被证明比FreeAT和YOPO更有效。如果仔细调整超参数,带随机启动的FGSM(FGSM-RS)可用于一步生成对抗扰动,来训练鲁棒网络模型。ATTA方法则是利用对抗样本的可迁移性,使用干净样本作为对抗样本的初始化,具体的优化形式如下所示其中,

表示在第

轮中第

个样本

生成的对抗样本。ATTA显示出与FGSM-RS相当的鲁棒精度。SLAT与FGSM同时扰动输入和潜在值,确保更可靠的性能。这些单步方法会产生灾难性的过拟合现象,这意味着模型对PGD攻击的鲁棒性精度会突然下降到接近0,而对FGSM攻击的鲁棒精度迅速提高。为了防止模型过拟合现象,FGSM-GA添加了一个正则化器,用于对齐输入梯度的方向。另一项工作从损失函数的角度研究这一现象,发现模型过度现象是损失面高度扭曲的结果,并提出了一种通过沿梯度方向检查损失值来解决模型过拟合的新算法。然而,这两种算法都需要比FGSM-RS和ATTA更多的计算量。

3 论文算法

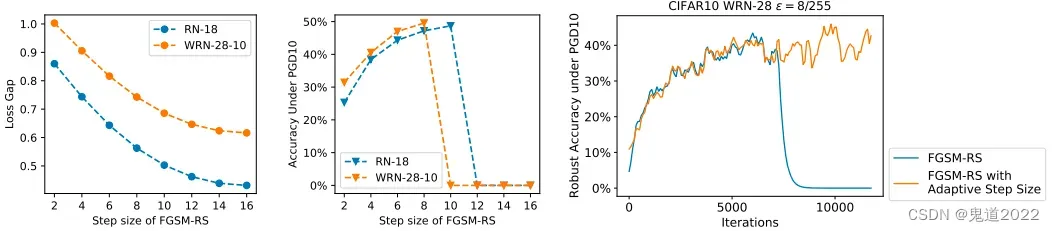

由之前的研究可知,对抗训练目标函数中内部最大化的步长对单步攻击方法的性能起着重要作用。过大的步长会将所有FGSM对抗扰动吸引到分类边界附近,导致灾难性过拟合现象,因此PGD多步攻击下的分类器对抗鲁棒性精度将降至零。然而,又不能简单地减小步长,因为如下图的第一张图和第二张图所示可以发现,增大步长可以增强对抗攻击并且能提高模型鲁棒性。

假设1: 训练损失函数

满足如下约束:

(1)是凸函数并且

在参数

下是平滑的;

和

的梯度在

范数满足如下公式

其中

(2)是凹函数并且

在每个样本

平滑。

在

范数球内并且半径为

。对于任意

和

,

,并且输入梯度满足如下公式

作者平均步参数轨迹得到近似最优点

这是分析随机梯度方法的标准技术,收敛间隙

上界为如下公式所示

引理1: 损失函数

满足假设1,目标函数

有如下收敛间隙不等式

证明: 根据引理1公式的左侧可得如下不等式: 第一个和第三个不等式遵循最优性条件,第二个不等式使用Jensen不等式。在证明定理1和定理2时,有以下几个梯度符号

ATAS方法也可以表示为自适应随机梯度下降块坐标上升法(ASGDBCA),在步骤中随机选取一个样本

,对参数

应用随机梯度下降,对输入

应用自适应块坐标上升。与SGDA不同,SGDA在每次迭代中更新

的所有维度,ASGDBCA只更新

的一些维度。ASGDBCA首先计算预调节参数

为

则

和

可以被优化为

ASGDBCA和ATAS的主要差异为

。为了证明ASGDBCA的收敛性,前置调节参数必须是非递减的。否则,ATAS可能不会像ADAM那样收敛。然而,ADAM的非收敛版本实际上在实际中对神经网络更有效。因此,ATAS仍然使用

作为预调节参数。

ATAS和ATTA的非自适应版本的随机梯度下降块坐标上升的公式如下所示

定理2: 在假设1的条件下,常数学习率

和

,则SGDBCA的界限为如下所示

定理1和2表明ASGDBCA比SGDBCA收敛更快。当较大时,SGDBCA和ASGDBCA中的间隔的第三项可以忽略不计。考虑到它们的第一项是相同的,主要区别是第二项中

和

关于

间隔界。它们的比率为如下所示

Cauchy-Schwarz不等式表明该比率始终大于1。当

具有长尾分布时,ASGDBCA和SGDBCA之间的差距会变得更大,这表明ATAS的收敛速度相对更快。

4 实验结果

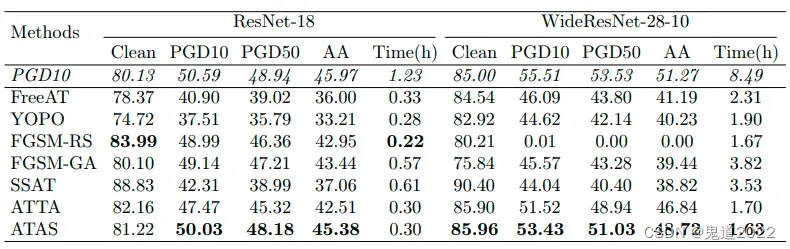

以下三个表格分别显示了不同方法在CIFAR10、CIFAR100和ImageNet数据集上的准确性和训练时间。需要注意的是,由于计算复杂性,作者没有足够的计算资源在ImageNet上执行标准对抗训练和SSAT。作者使用两个GPU来训练ImageNet的模型, 对于CIFAR10和CIFAR100,作者在单个GPU上评估训练时间。从以下结果可以直观的发现论文中提出的方法ATAS提高了在各种攻击(包括PGD10、PGD50和自动攻击)下的分类模型的鲁棒性,并且可以发现在训练中避免发生模型灾难性过拟合现象。

文章出处登录后可见!