一:前言

随着卷积神经网络的发展和普及,我们了解到增加神经网络的层数可以提高模型的训练精度和泛化能力,但简单地增加网络的深度,可能会出现梯度弥散和梯度爆炸等问题。传统对应的解决方案则是参数的初始化(weights initializatiton)和(batch normlization)批标准化,这样虽然解决了梯度的问题,但深度加深了,却带来了另外的问题,就是网络性能的退化问题。

二:什么是网络的退化问题?

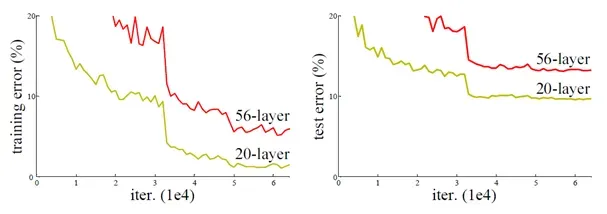

由上图可以看出,56-layer层的网络比20-layer的网络在训练集和测试集上的表现都要差,这里不是过拟合(过拟合是在训练集上表现得好,而在测试集中表现得很差),说明如果只是简单的增加网络深度,可能会使神经网络模型退化,进而丢失网络前面获取的特征。

三:ResNet意义

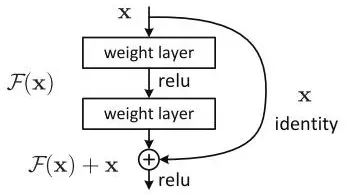

从图中残差块的结构中可以看出,当输入为x时其学习到的特征记为H(x),现在我们希望其可以学习到残差F(x)=H(x)-x,当残差为0时,此时残差快中仅仅做了恒等映射,至少模型可以保持原来的特征,使得网络不会因为层数加深而退化,从而拥有更好的性能。

文章出处登录后可见!

已经登录?立即刷新