多示例学习MIL

假设训练数据集中的每个数据是一个包(Bag),每个包都是一个示例(instance)的集合,每个包都有一个训练标记,而包中的示例是没有标记的;如果包中至少存在一个正标记的示例,则包被赋予正标记;而对于一个有负标记的包,其中所有的示例均为负标记。包是由多个示例组成的,在多示例学习中,包带有类别标签而示例不带类别标签,最终的目的是给出对新的包的类别预测。如果一个包里面存在至少一个被分类器判定标签为+的示例,则该包为正包;如果一个包里面所有的示例都被分类器判定标签为-,则该包为负包。

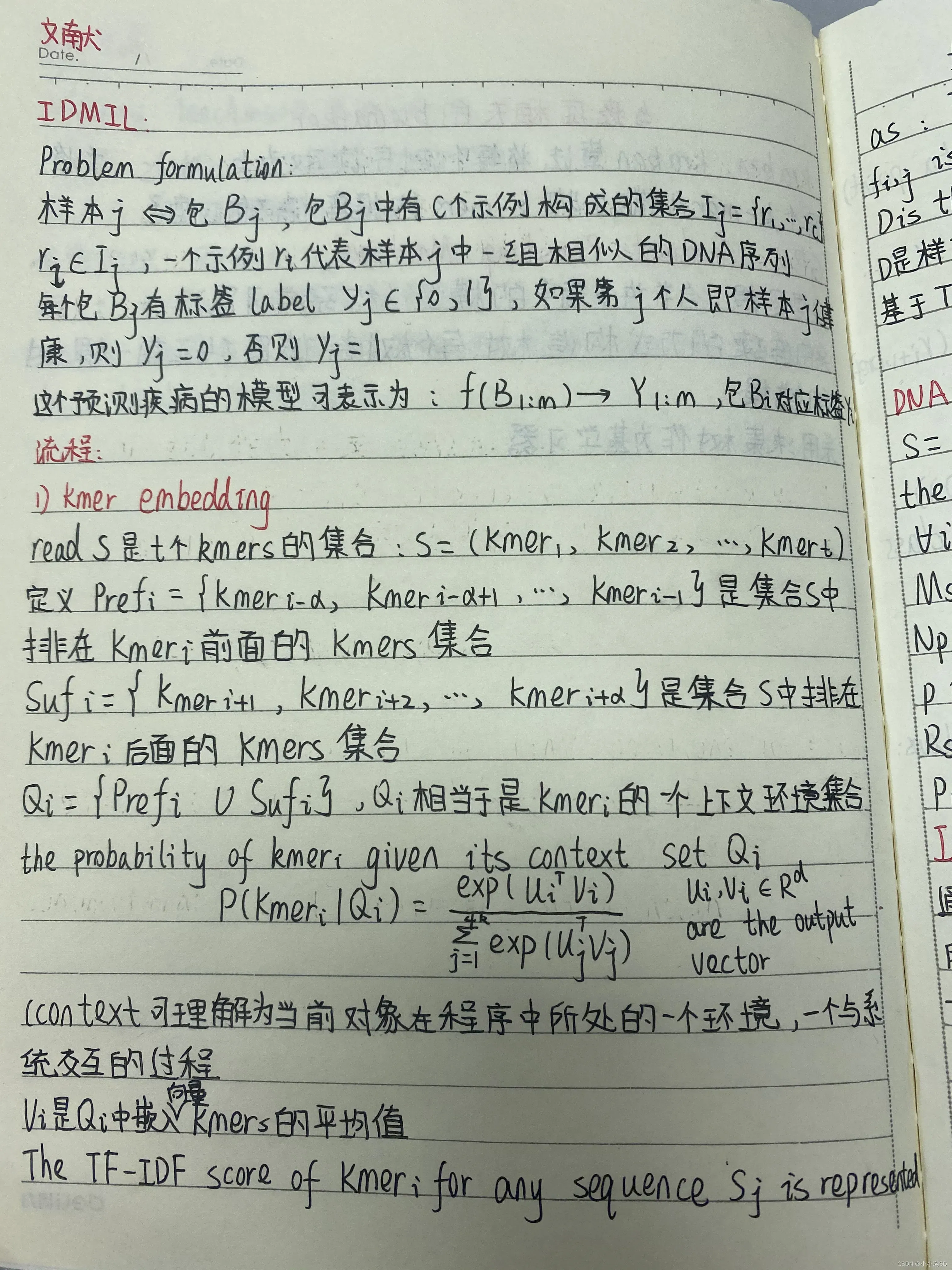

IDMIL

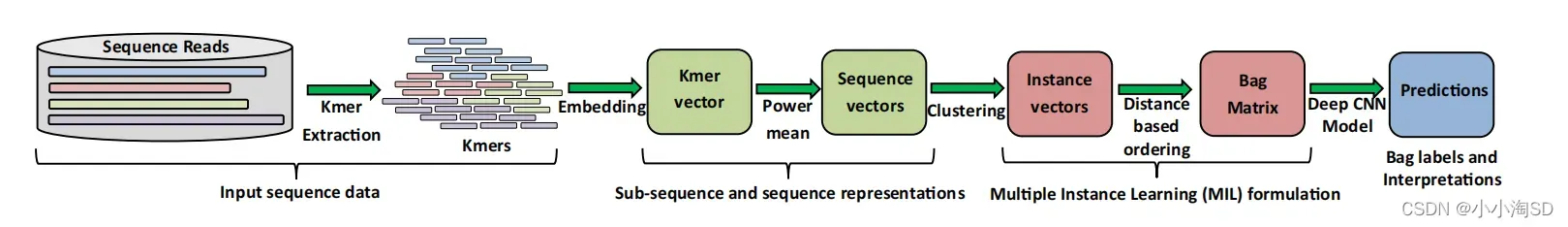

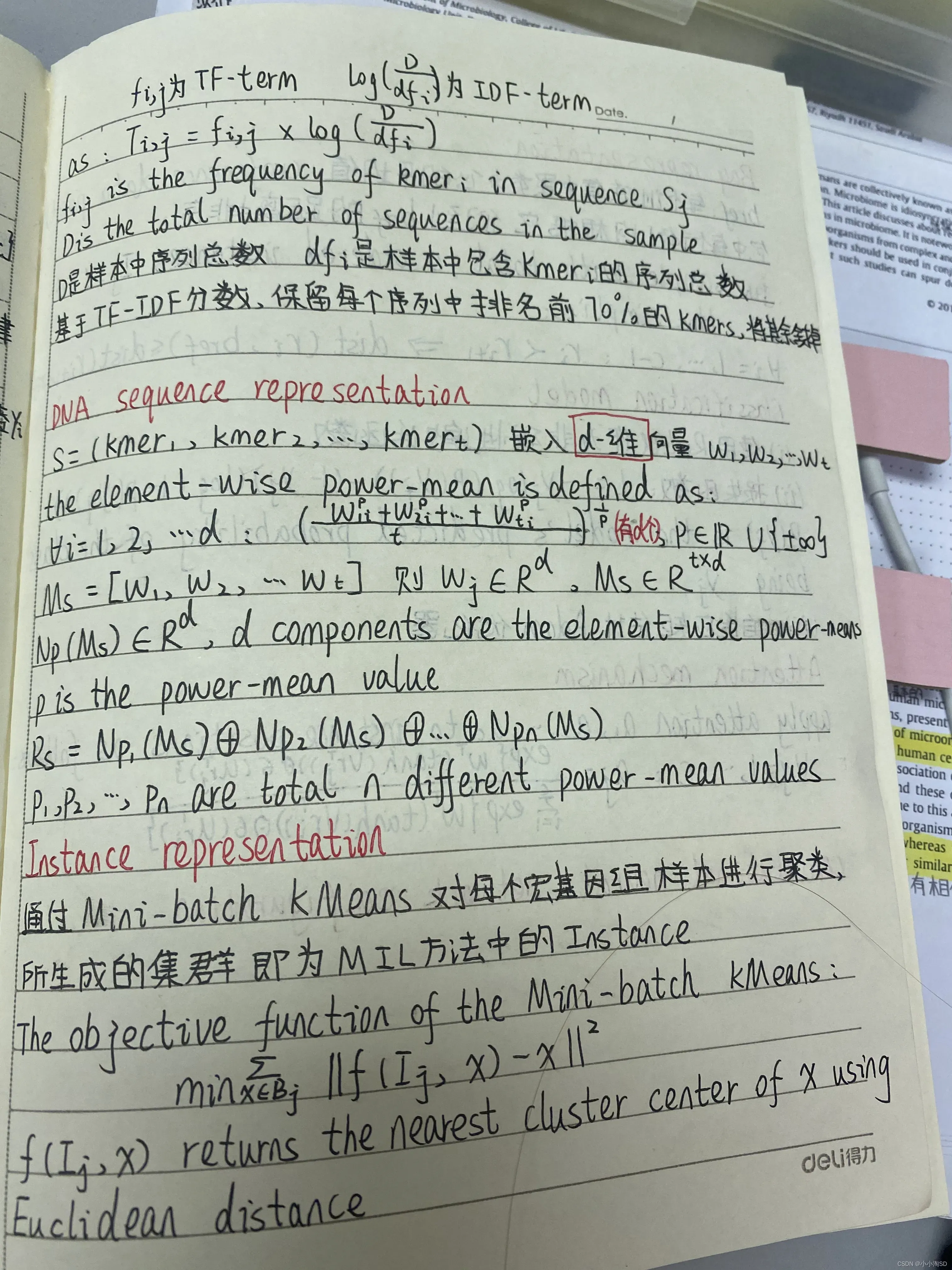

概述:首先将DNA子序列(kmers)嵌入到一个固定的维度中。kmer嵌入用于表示序列读取。执行聚类以创建MIL示例,形成MIL中的包,再对包进行分类,如健康或不健康。

CNN

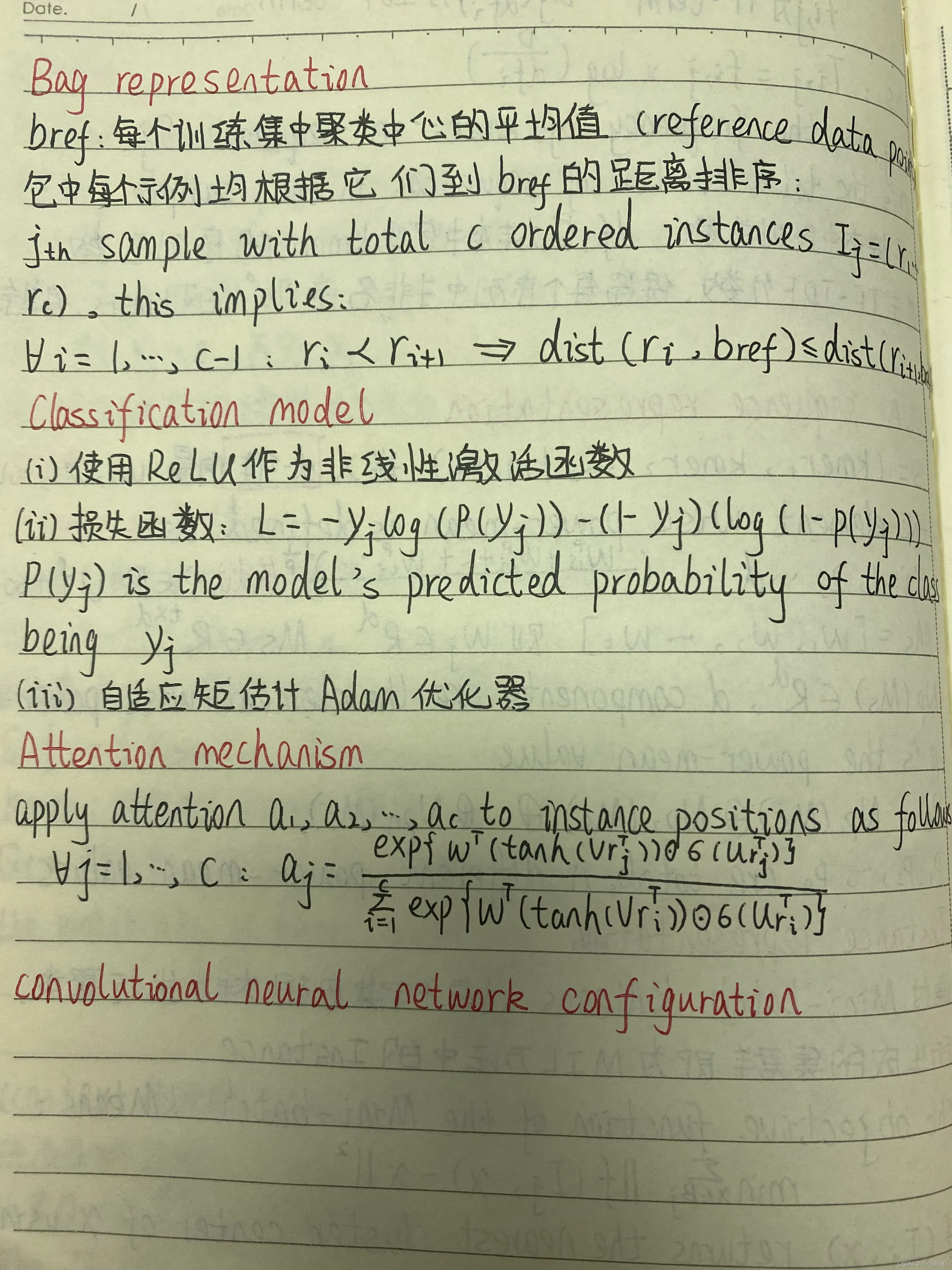

神经网络就是通过对这些张量进行线性运算,再经过激活函数的非线性运算,达到最终目标的过程。神经网络模型中有一些权重参数,这些参数对张量的运算过程有很大的影响。我们需要使用损失函数来推导这些参数,从而找到正确的梯度下降方向并更新该方向的参数。更新参数的方法是优化器。

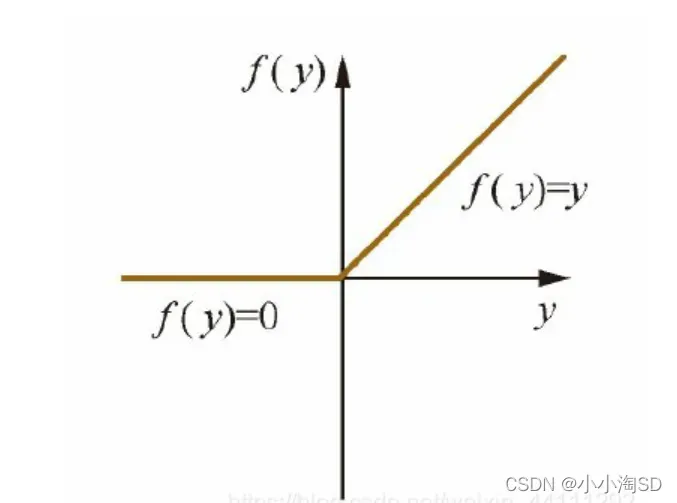

1)激活函数是神经网络中对输入数据进行计算的非线性函数,如果没有激活函数的加持,那么神经网络仅仅对输入数据做简单的线性变化,只能解决线性问题。本文中用到的是ReLU函数:

从计算的角度上,Sigmoid和Tanh激活函数均需要计算指数,复杂度高,而ReLU只需要一个阈值即可得到激活值。ReLU的非饱和性可以有效地解决梯度消失的问题,提供相对宽的激活边界。ReLU的单侧抑制提供了网络的稀疏表达能力。

2)损失函数:计算预测值与真实值之间差距的函数,损失函数中的参数就是神经网络模型中所用的参数,通过损失函数对参数求导后导数的正负号来判断参数更新的变化方向,若导数为正数,参数减小的方向会使损失函数减小;若导数为负数,参数增大的方向会使损失函数较小。

3)优化器:优化器是指更新神经网络模型参数所使用的算法。本文使用自适应矩估计(Adam)优化器

机型优势

Noise reduction ;Data utilization:不需要进行微生物图谱分析、序列组装;层次特征提取;

数据增强:数据增强过程和最小数量的学习权重确保模型避免过度拟合。

版权声明:本文为博主小小淘SD原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/m0_64195997/article/details/123163461