文章目录

- 一.简介

- 1.1 LLMOps

- 1.2 Dify

- 二.核心能力

- 三.Dify安装

- 3.1 快速启动

- 3.2 配置

- 四.Dify使用

- 五.调用开源模型

- 六.接通闭源模型

- 七.在 Dify.AI 探索不同模型潜力

- 7.1 快速切换,测验不同模型的表现

- 7.2 降低模型能力对比和选择的成本

一.简介

1.1 LLMOps

LLMOps(Large Language Model Operations)是一个涵盖了大型语言模型(如 GPT 系列)开发、部署、维护和优化的一整套实践和流程。LLMOps 的目标是确保高效、可扩展和安全地使用这些强大的 AI 模型来构建和运行实际应用程序。它涉及到模型训练、部署、监控、更新、安全性和合规性等方面。

1.2 Dify

Dify 一词源自 Define + Modify,意指定义并且持续的改进你的 AI 应用,它是为你而做的(Do it for you)。

如果你对诸如 GPT-4 之类的 LLM 技术高速发展感到惊奇和兴奋,迫不及待的想用它做点什么有用的东西!可你的头脑里又有一切令人困惑的问题:

- 我该如何“训练”一个基于我的内容的模型?

- 怎么让 AI 知道 2021 年以后的事情?

- 如何避免让 AI 跟用户胡说八道?

- 微调(Fine-tuning)和嵌入(Embedding)是什么意思?

那么,Dify 正好能满足你的需要。

Dify 的目标是让开发者(甚至非开发者)可以快速基于大型语言模型搭建出有用的东西,并确保它是可视化、可运营、可改进的。

你可以使用 Dify 快速搭建一个 Web App,其生成的前端代码可以托管在 Dify 上。如果你想基于这个 Web App 进一步开发,你可以从 GitHub 中得到这些 Template,部署到任何地方(例如 Vercel 或你的服务器)。或者,你也可以基于 WebAPI 开发你自己的 Web 前端、移动 App…总之,为你省下了后端开发的工作。

不止于此,Dify 的核心理念是在一个可视化的界面中创建、配置、改进你的应用。基于 LLM 的应用开发有一个持续改进的生命周期,你可能需要基于自己的内容让 AI 给予正确的回答,或是想提升 AI 的准确性和叙述风格,甚至让它去 YouTube 上下载一个字幕作为上下文。

这当中将会有些逻辑设计、上下文增强、数据准备等需要花些功夫的事情,如果没有工具你可能会寸步难行,我们称这个过程为 LLMOps。

简而言之,Dify 是一个易用的 LLMOps 平台,旨在让更多人可以创建可持续运营的原生 AI 应用。Dify 提供多种类型应用的可视化编排,应用可开箱即用,也能以后端即服务的 API 提供服务。

二.核心能力

1.可视化提示词编排:通过可视化界面创建和调试提示词,并在几分钟内发布 AI 应用程序。

2.与长上下文(数据集)的集成:使用您自己的数据作为上下文自动完成文本预处理,无需理解模糊概念和技术处理。

3.基于 API 的开发:后端即服务。直接访问 Web 应用程序或将 API 集成到您的应用程序中,无需担心复杂的后端架构和部署流程。

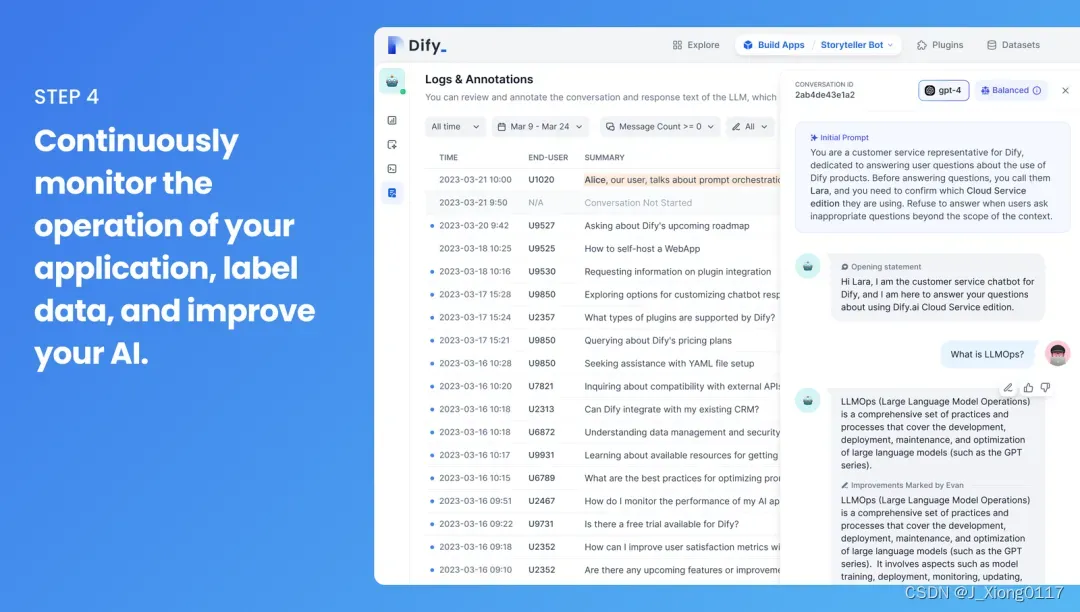

4.数据标注和改进:通过可视化审查 AI 日志并改善数据标注,观察 AI 推理过程并持续提高性能。

三.Dify安装

在安装 Dify 之前,请确保您的机器满足以下最低系统要求:

- CPU >= 1 Core

- RAM >= 4GB

3.1 快速启动

启动 Dify 服务器的最简单方法是运行docker-compose.yml 文件。在运行安装命令之前,请确保您的机器上安装了 Docker 和 Docker Compose:

cd docker

docker compose up -d

运行后,可以在浏览器上访问 http://localhost/install 进入 Dify 控制台并开始初始化安装操作。

3.2 配置

需要自定义配置,请参考 docker-compose.yml 文件中的注释,并手动设置环境配置,修改完毕后,请再次执行 docker-compose up -d。

四.Dify使用

只需四步,您就可以创建适应各种场景的人工智能应用,例如个性化聊天机器人、人工智能客服、基于专业知识的文本生成等。

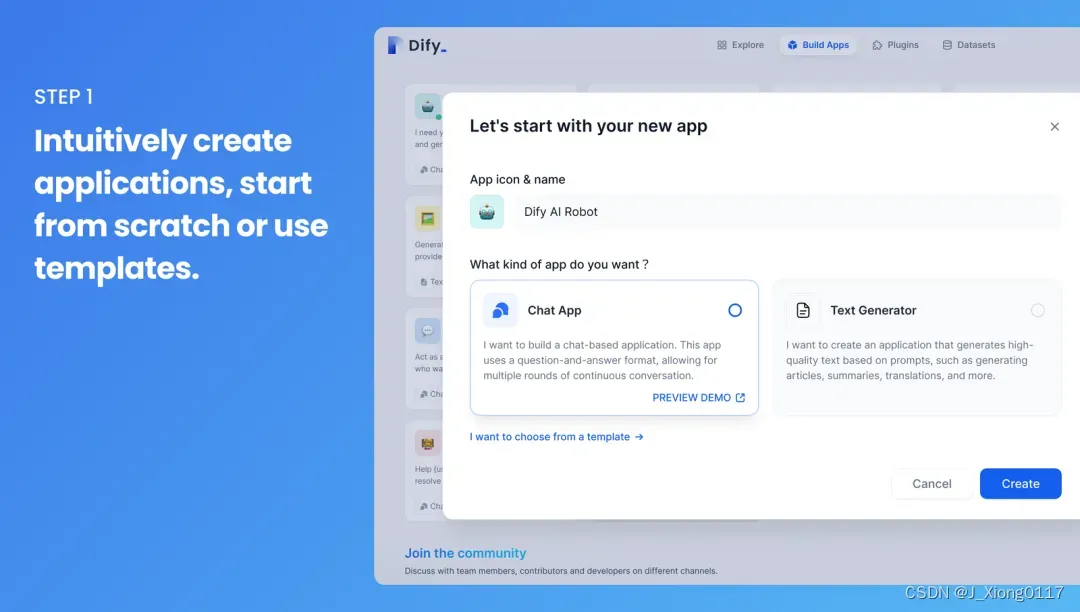

第一步:直接创建应用程序,可以从零开始或使用模板。

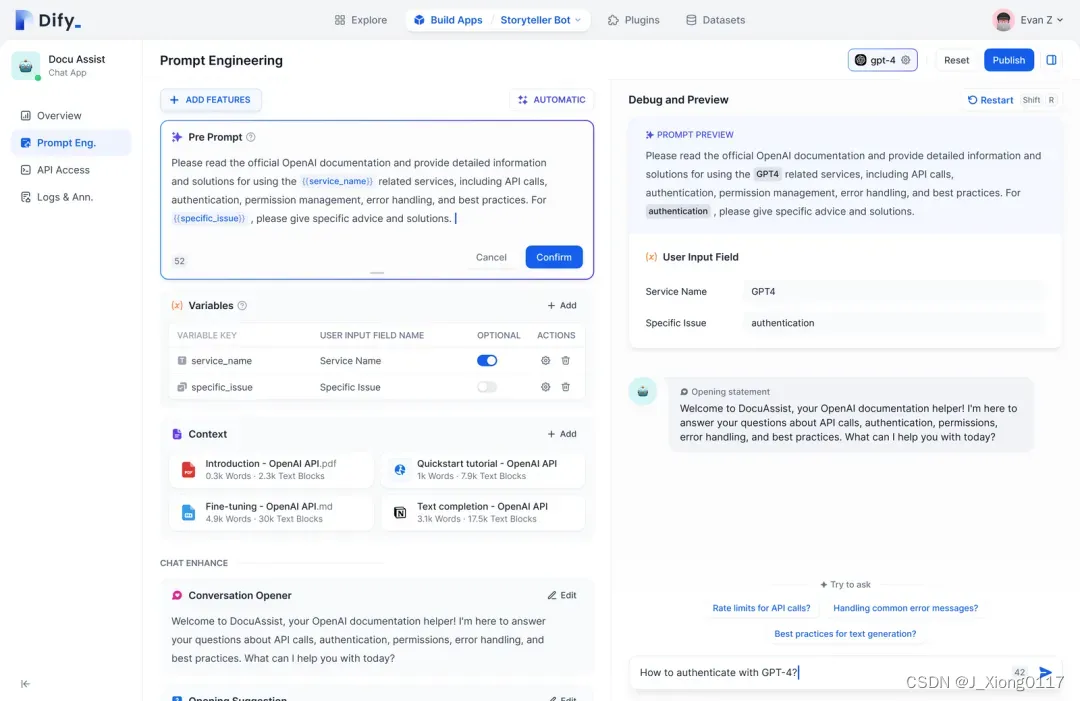

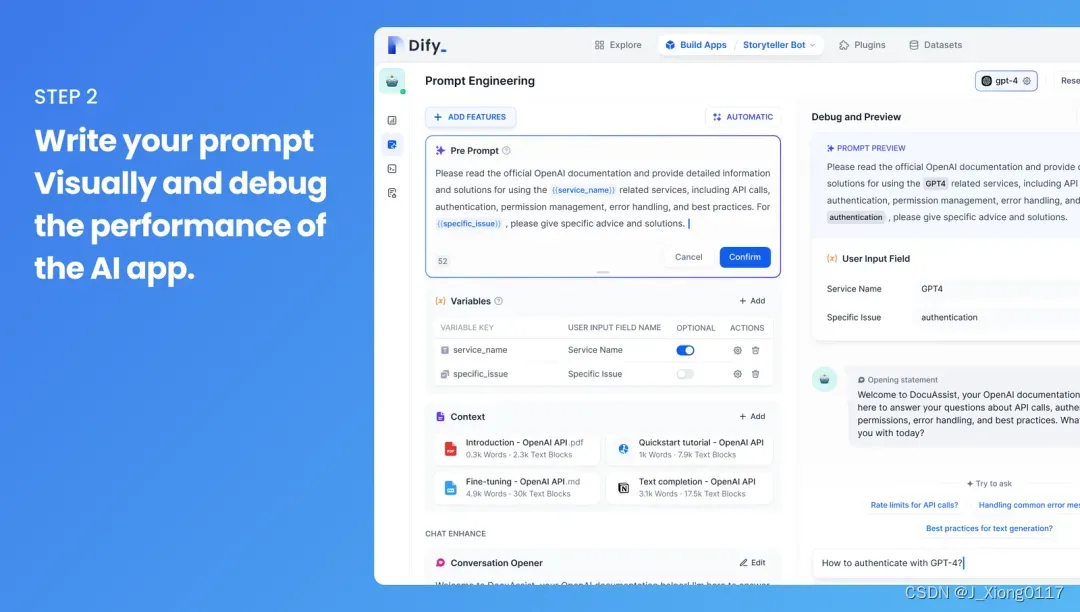

第二步:可以用可视化的方式编写你的提示词,然后调试你的 AI 应用。

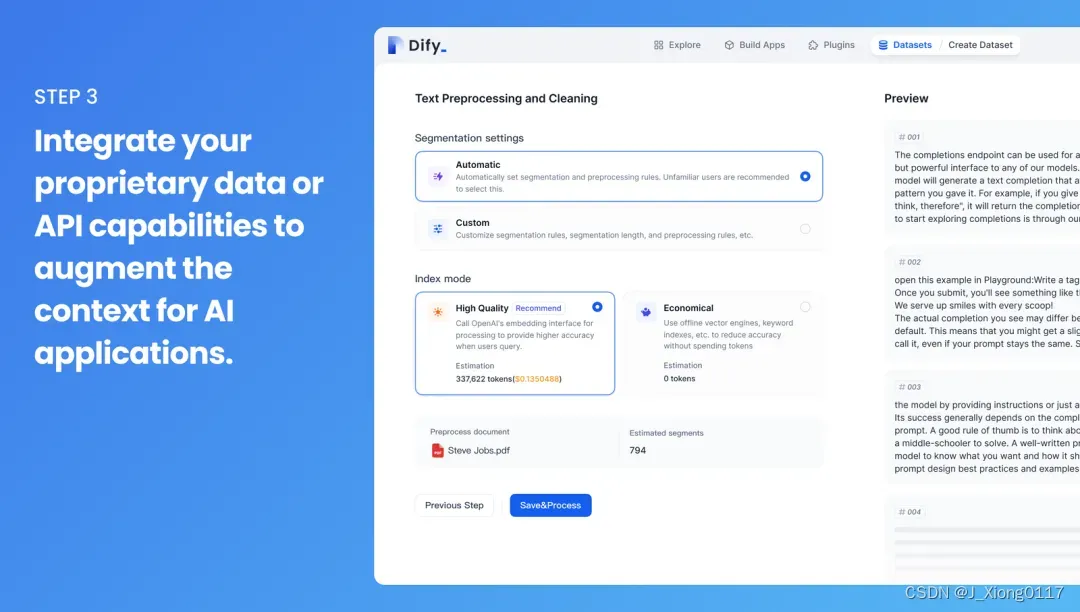

第三步:将您的私有数据或 API 功能集成到 Al 应用程序中,以增强上下文。

第四步:持续监控你的应用程序运行情况、标记数据,并改进您的人工智能。

Dify 已经陆续支持了全球前列的模型优秀代表:OpenAI 的 GPT 系列、Anthropic 的 Claude 系列、Azure OpenAI 系列。此外,还支持国内外知名的开源模型如:Llama2、ChatGLM、百川Baichuan、通义千问-7B 等,凡托管在 Hugging Face 及 Replicate 上的模型,在 Dify 上只需要输入 Hugging Face 、 Replicate 的 API token 和模型名称就可以轻松接入调用。即将支持插件功能,更能释放大语言模型的无限潜力。

五.调用开源模型

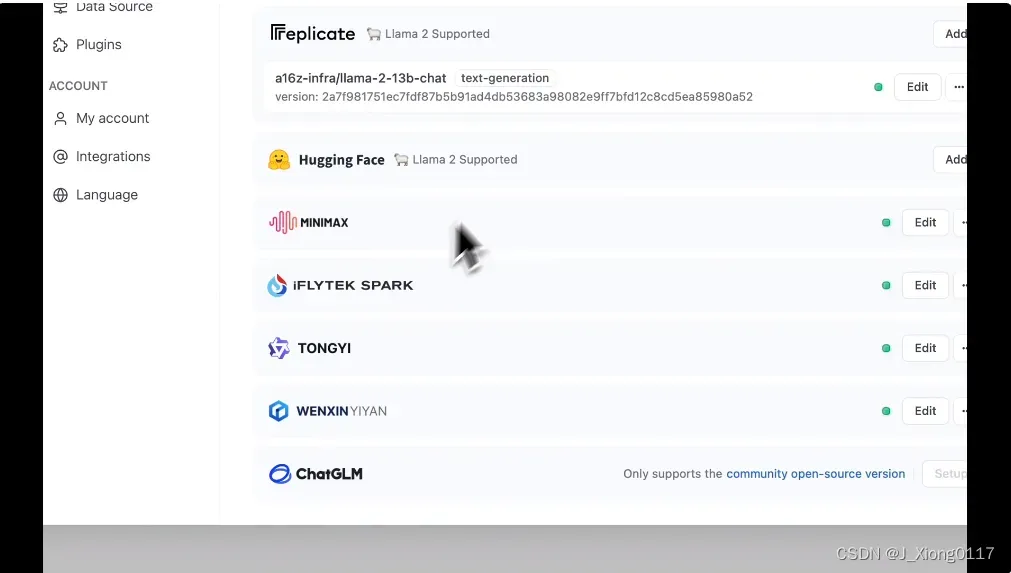

Dify 支持模型托管和部署平台 Replicate 和 Hugging Face 上所有的模型, Llama2、ChatGLM、百川 Baichuan、通义千问-7B 等你都可以轻松调用,快速构建性能优异且多样化的 AI 应用。

六.接通闭源模型

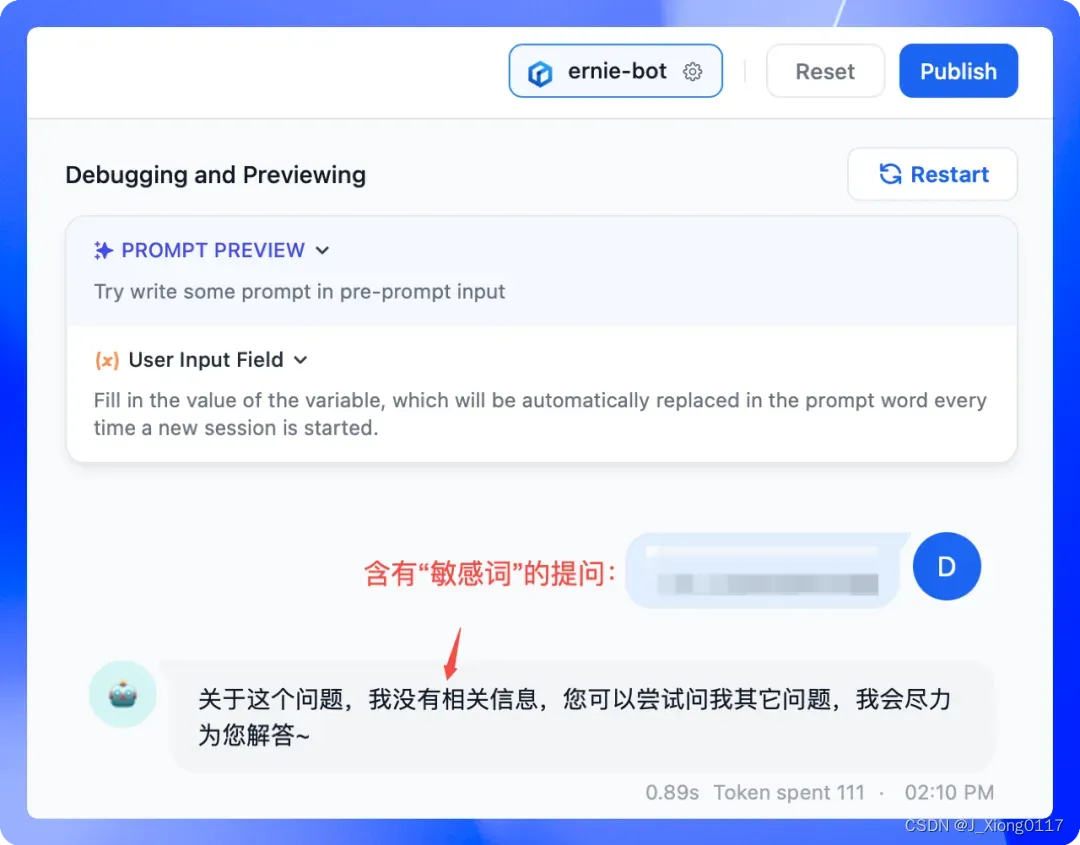

国内用户更关注的是模型的合规可控性,无疑国内闭源商用模型是最优选择。Dify 已接通国内闭源商用模型如文心一言、讯飞星火、MiniMax、通义千问,这些模型在安全性和价值观上更符合国情,满足合规审查和企业对可控性的需求。

以百度文心一言为例,用户在 Dify 用该模型创建应用时,关于“敏感词”的合规性问题会得到很好的处理:

Dify 为用户争取到讯飞星火、MiniMax 分别 300 万、100 万的 token 体验额度,建议提前探索评测,选定适合自己业务的模型,大规模开放后即可在 Dify 上创建安全合规的 AI 应用。

如何申请体验额度?

通过 Dify 设置 –> 模型供应商 –> 讯飞星火或 MiniMax 图标处点击【免费获取】:

- 讯飞星火:免费领取 300 万 token,需要从 Dify 的入口进入,完成讯飞星火开放平台的注册,返回 Dify 静候 5 分钟即可在 Dify 页面体现可用额度(仅限未注册过讯飞星火的手机号)。

- MiniMax:免费领取 100 万 token,只需点击【免费领取】即可到账额度,无需手动注册流程。

七.在 Dify.AI 探索不同模型潜力

7.1 快速切换,测验不同模型的表现

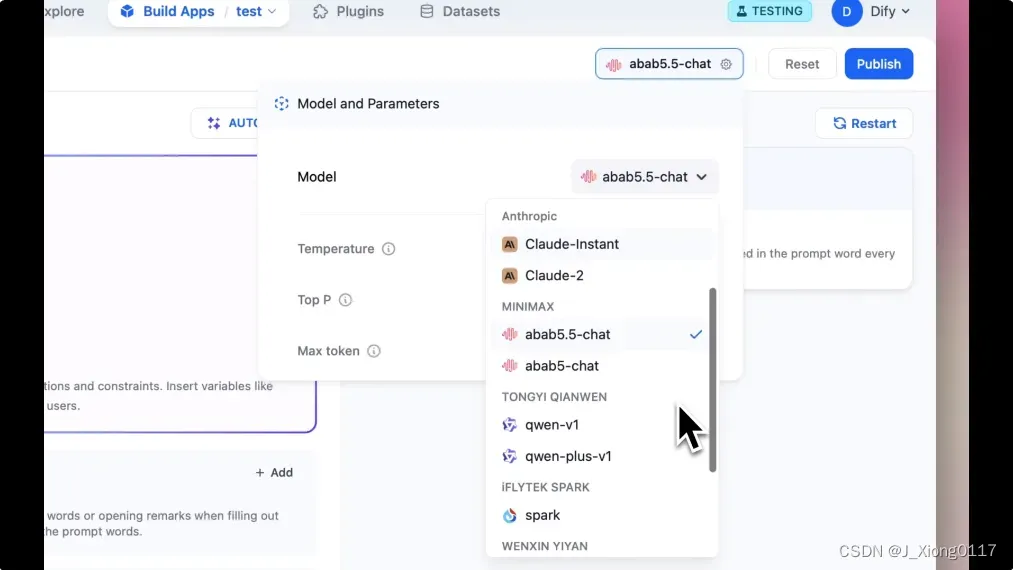

基于 Dify 上集成的 LLMs,你可以在应用制作的页面下快速切换不同模型,仅需几分钟就可以迅速评估在特定场景下各个模型的具体表现,这可以帮助你基于测试结果做出更明智的模型选择,获取最佳体验。

7.2 降低模型能力对比和选择的成本

过去,当你需要探索不同模型的能力边界,你需要逐个去研究不同模型的性能、不断调整不同模型的不同参数等,投入大量时间和精力。而现在基于 Dify,你只需要在应用的模型选择器中点击切换即可实现不同模型能力的反馈和对比。另外,Dify 已对各模型进行了预调优,设定最佳系统 Prompt,简化复杂的参数设置。你无需学习各模型的使用细节,直接在 Dify 上选择并得出最优模型方案。这极大降低了模型选择和调优的门槛,让你能更加高效地构建 LLM 应用。

文章出处登录后可见!