1 简介

论文题目:Crosslingual Transfer Learning for Relation and Event Extraction

viaWord Category and Class Alignments

论文来源:EMNLP 2021

组织:俄勒冈大学

论文链接:https://aclanthology.org/2021.emnlp-main.440.pdf

代码链接:

1.1 创新

- 提出一个新的方法对REE(关系抽取和事件抽取)进行跨语言迁移学习,利用类的语义和通用的词类别(词性和依赖关系)作为跨语言对齐表示向量的桥梁,利用未标注的目标语言数据,进行语言独立的表示学习。

2 Baseline

在ACE的三个子任务(关系抽取(给定实体提及)、事件检测、事件论元抽取(给实体件提及))上研究跨语言迁移,包括两种baseline:

2.1 仅使用源数据

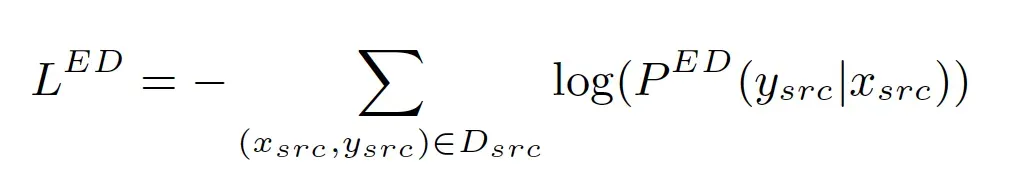

- BERTCRF:完成跨语言的事件检测任务,使用multilingual BERT进行编码,然后使用CRF学习标签之间的依赖,公式如下:

|

|

|

- GATE:完成跨语言的关系抽取和事件论元抽取,首先使用multilingual BERT进行编码,然后每个词向量拼接词性编码和依赖关系编码,通过一个Transformer层(基于语法的mask),最后进行分类。

2.2 使用未标注的目标语言数据

- Language Adversarial Training (LADV):使用一个语言辨别器,使其语言不可知,更好地跨语言迁移知识。具体做法是:首先用multilingual BERT进行编码,然后使用一个语言辨别器判断句子(句子编码为词编码的平均)是否属于源语言,使用Gradient Reversal Layer (GRL)反转梯度,防止语言辨别器正确识别,最后联合训练模型和语言辨别器。

- mBERT Finetuning (FMBERT):使用未标注的目标微调mBERT,预训练任务未mask language modeling(MLM)。

3 方法

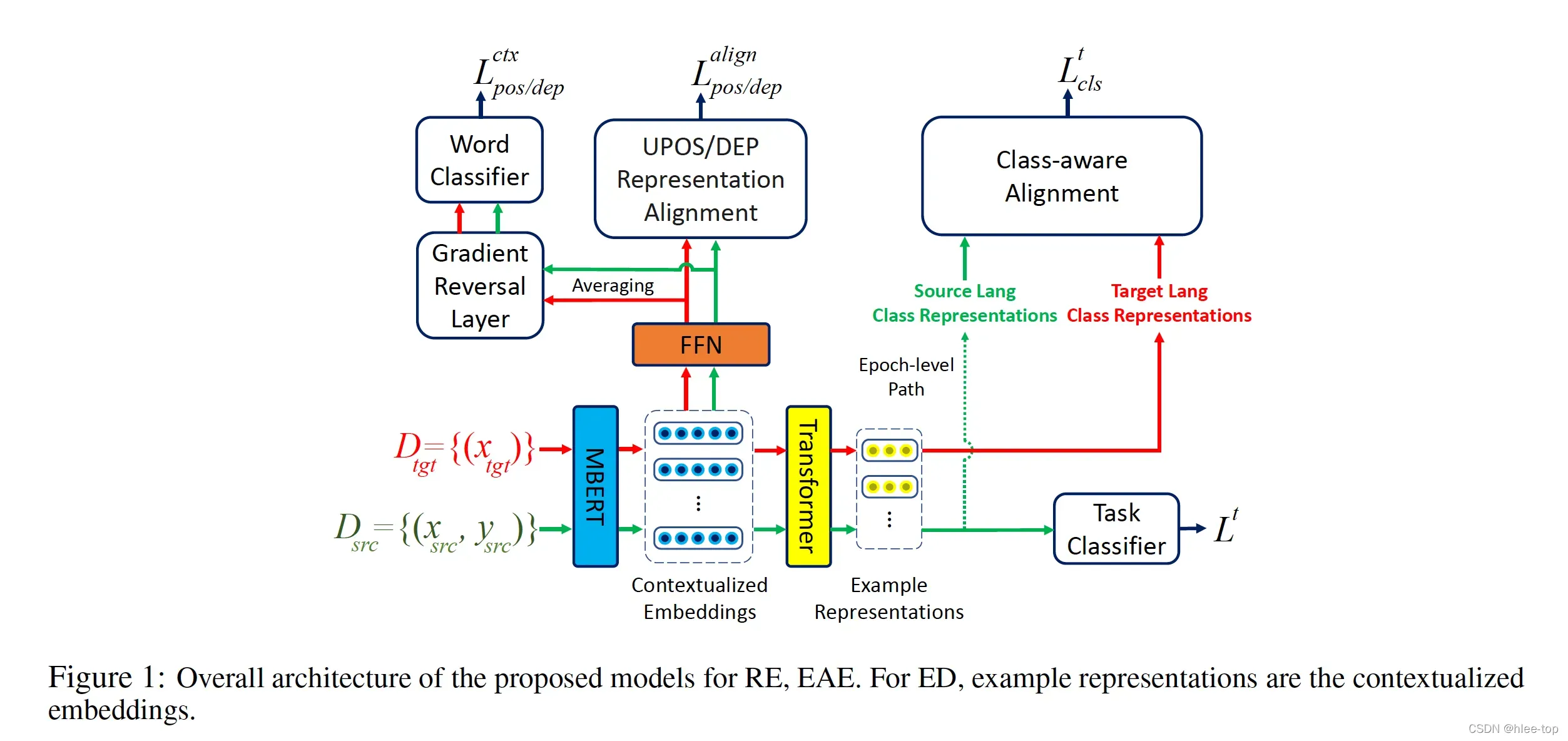

所提出模型的总体框架如上图所示,主要包括以下几个部分:

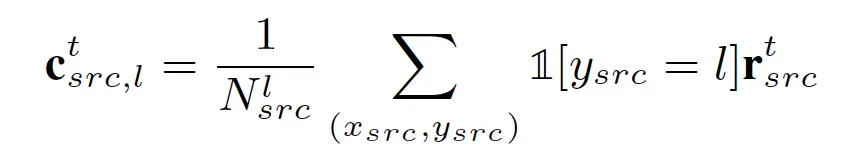

3.1 基于类别的对齐

在源语言中,使用平均向量(样本或者是词)计算类别L的向量表示;在目标语言中,由于没有标注,首先使用softmax计算一个概率分布,然后作为权重,计算类别L的向量表示,最后最小化负COS相似度(源语言的向量表示在每个epoch后获得,目标语言在每个),由于后面的epoch有更好的模型参数,添加一个自适应参数,具体公式如下:

|

|

|

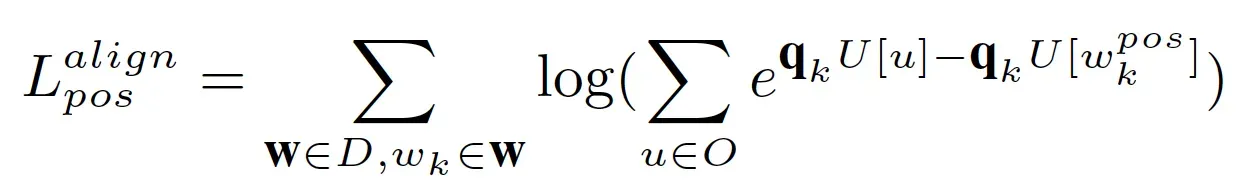

3.2 基于词类别的对齐

使用词性和依赖关系作为语言独立的知识,对其跨语言的表示。首先使用UDPipe工具获得文本中的词性和依赖关系,对于可能的词性,随机初始化编码表为U,对于每个词通过全连接获得一个向量表示,然后与U进行匹配,最大化与对应词性的相似度,最小化与其他词性的相似度,具体公式如下:

|

|

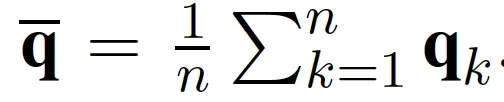

由于上述计算中包含上下文信息,可能带来噪声,为了希望

只关注词性信息,对

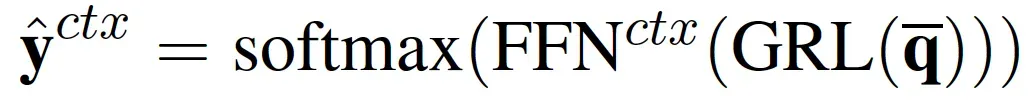

的上下文信息进行过滤,首先计算句子的平均向量,然后通过Gradient Reversal Layer (GRL),最后进行词分类(类别为词典大小),最小化Loss鼓励利用上下文信息,因此加入GRU,具体公式如下:

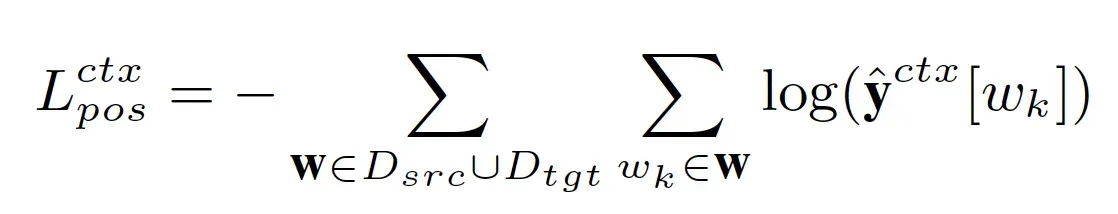

|

|

|

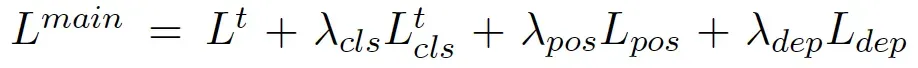

总的Loss为:

4 实验

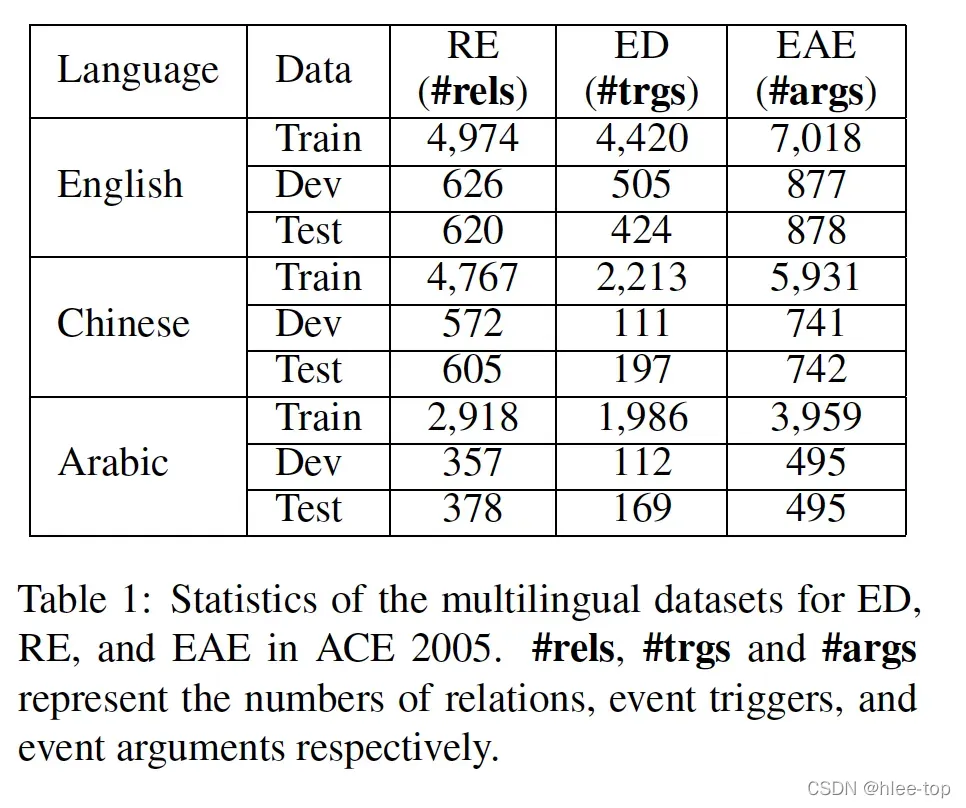

实验使用的数据集为ACE 2005,数据统计如下:

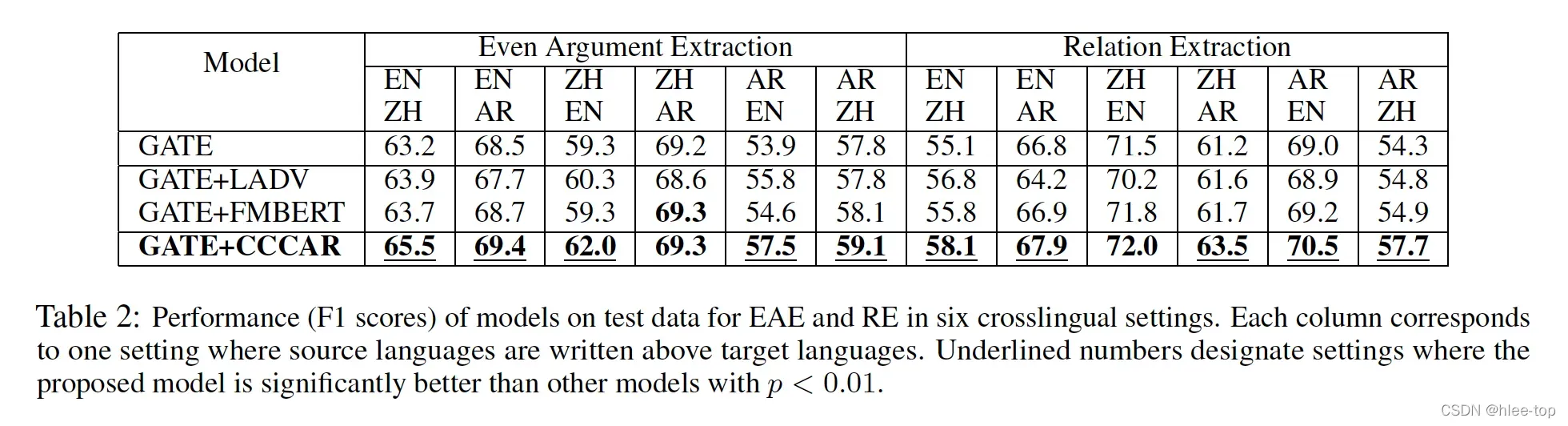

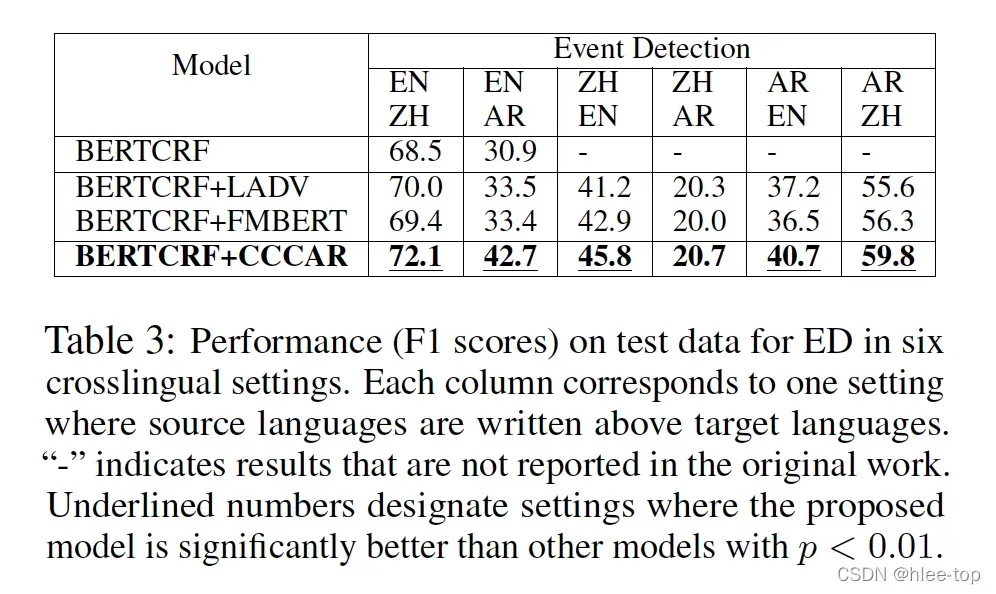

实验结果如下:

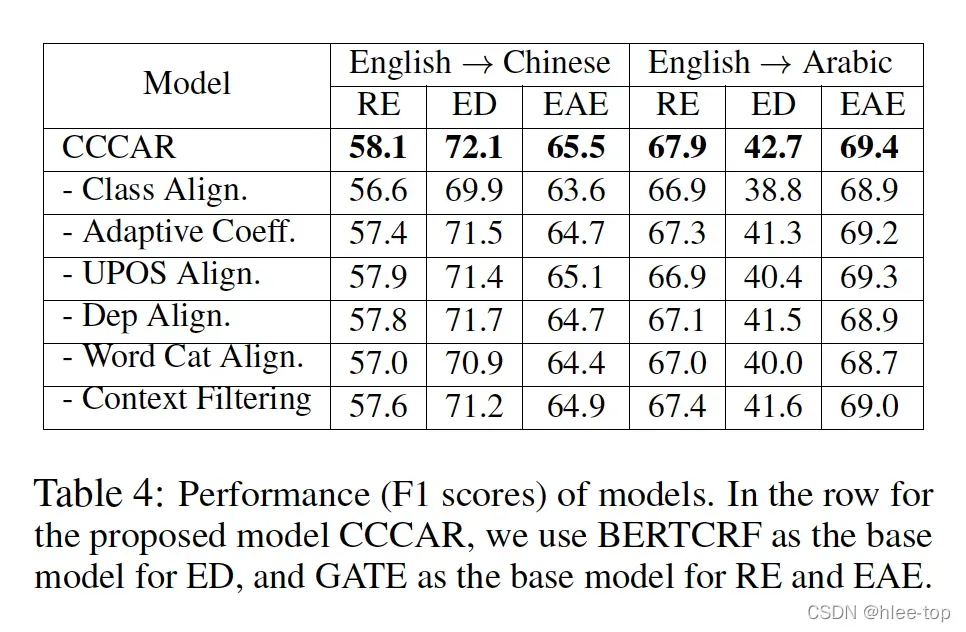

消融实验:

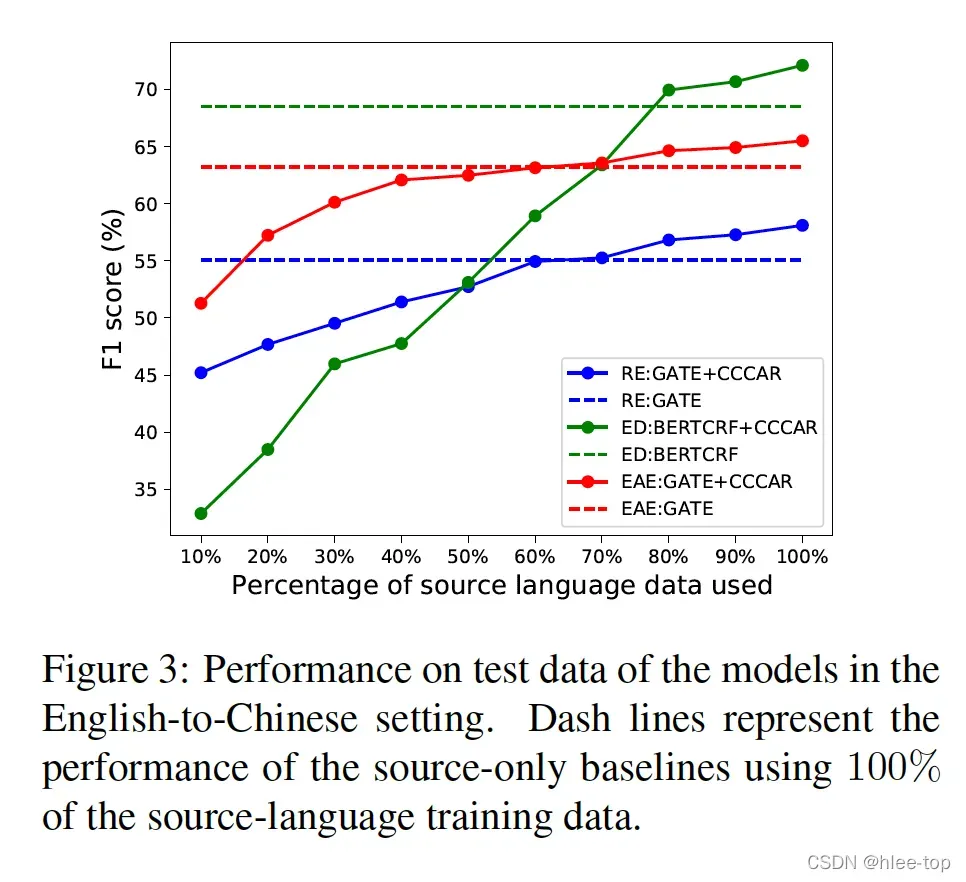

提出的模型使用了部分数据,性能提升如下:

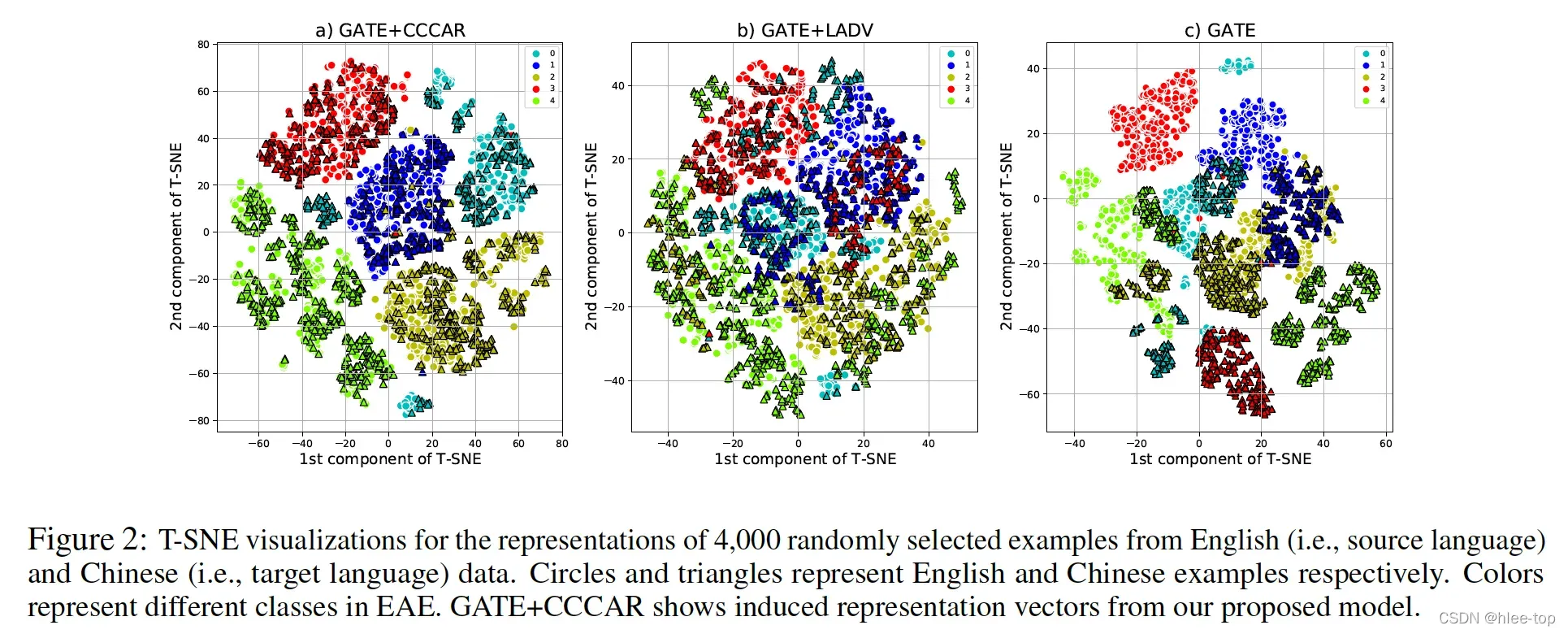

使用t-Distributed Stochastic Neighbor Embedding,可视化观察模型对齐的向量表示:

文章出处登录后可见!