目录

在快速发展的数字内容生成领域,焦点已从文本到图像 (T2I) 模型转移到更先进的视频扩散模型,特别是文本到视频 (T2V) 和图像到视频 (I2V)。今天要讲解的I2V-Adapter是一种用于视频扩散模型的通用图像生成视频适配器。

一. 项目与贡献概述

I2V-Adapter解决了 I2V 带来的复杂挑战:将静态图像转换为动态、逼真的视频序列,同时保留原始图像保真度。

传统方法通常涉及将整个图像集成到扩散过程中或使用预训练的编码器进行cross attention。然而,这些方法通常需要改变 T2I 模型的基本权重,从而限制了它们的可重用性。

I2V-Adapter推出了一种新颖的解决方案,即 I2V 适配器,旨在克服此类限制:

-

I2V-Adapter方法保留了 T2I 模型及其固有运动模块的结构完整性。I2V 适配器的工作方式是利用轻量级适配器模块,与输入图像并行处理噪声视频帧。该模块充当桥梁,有效地将输入链接到模型的自注意力机制,从而保持空间细节,而不需要对 T2I 模型进行结构更改。

-

I2V-Adapter 仅需要传统模型参数的一小部分,并确保与现有社区驱动的 T2I 模型和控制工具的兼容性。

-

I2V-Adapter实验结果证明了 I2V-Adapter 产生高质量视频输出的能力。这种性能,加上其多功能性和对可训练参数的需求减少,代表了人工智能驱动的视频生成领域的重大进步,特别是对于创意应用而言。

二. 方法详解

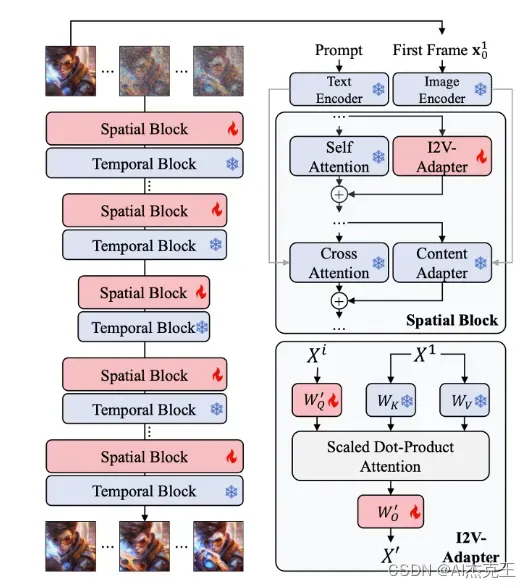

a. 整体框架图

- 给定参考图像和文本提示,I2V-Adapter的目标是从提供的图像开始生成视频序列。这项任务特别具有挑战性,因为它需要确保与第一帧的一致性、与提示的兼容性,并保持整个视频序列的连贯性。

- I2V-Adapter是一个即插即用模块,可将 T2V 扩散模型转换为 I2V 扩散模型。

- I2V-Adapter的核心设计是一种解耦的注意力机制,用于并行处理输入图像和噪声图像。

- 对 I2V-Adapter 的输出层进行零初始化,以确保模型启动时就像没有进行任何修改一样。进一步还利用内容适配器来提供高级语义信息来增强条件。

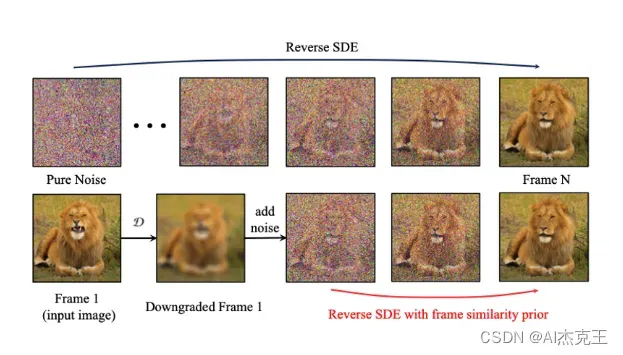

b. 帧相似性先验

为了稳定生成过程,I2V-Adapter还提出了额外的帧相似性先验。

I2V-Adapter的关键假设:

在相对较低的高斯噪声层面上,加噪的第一帧和加噪的后续帧的边缘分布足够接近。

在较高的层面上,假设在大多数短视频剪辑中,所有帧在结构上都是相似的,并且在被一定量的高斯噪声破坏后变得无法区分。

三. 一般化图像生成动画结果

四. 基于个性化 T2I 模型的动画结果

五. 结合ControlNet动画结果

六. 项目论文和代码

论文: https://arxiv.org/abs/2312.16693

代码:https://github.com/I2V-Adapter/I2V-Adapter-repo

七. 个人思考与总结

-

I2V-Adapter方法保留了 T2I 预训练模型的能力及其固有运动模块的结构完整性。这一点很重要,意味着可以充分利用社区各种个性化大模型,比如C站上的海量大模型。

-

I2V-Adapter 仅需要传统模型参数的一小部分,并确保与现有社区驱动的 T2I 模型和控制工具的兼容性。这点意味着模型权重小,需要训练的部分不多,相比微调整个基底模型训练更容易收敛。

欢迎加入AI杰克王的免费知识星球,海量干货等着你,一起探讨学习AIGC!

版权声明:本文为博主作者:AI杰克王原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/sinat_19868271/article/details/135328971