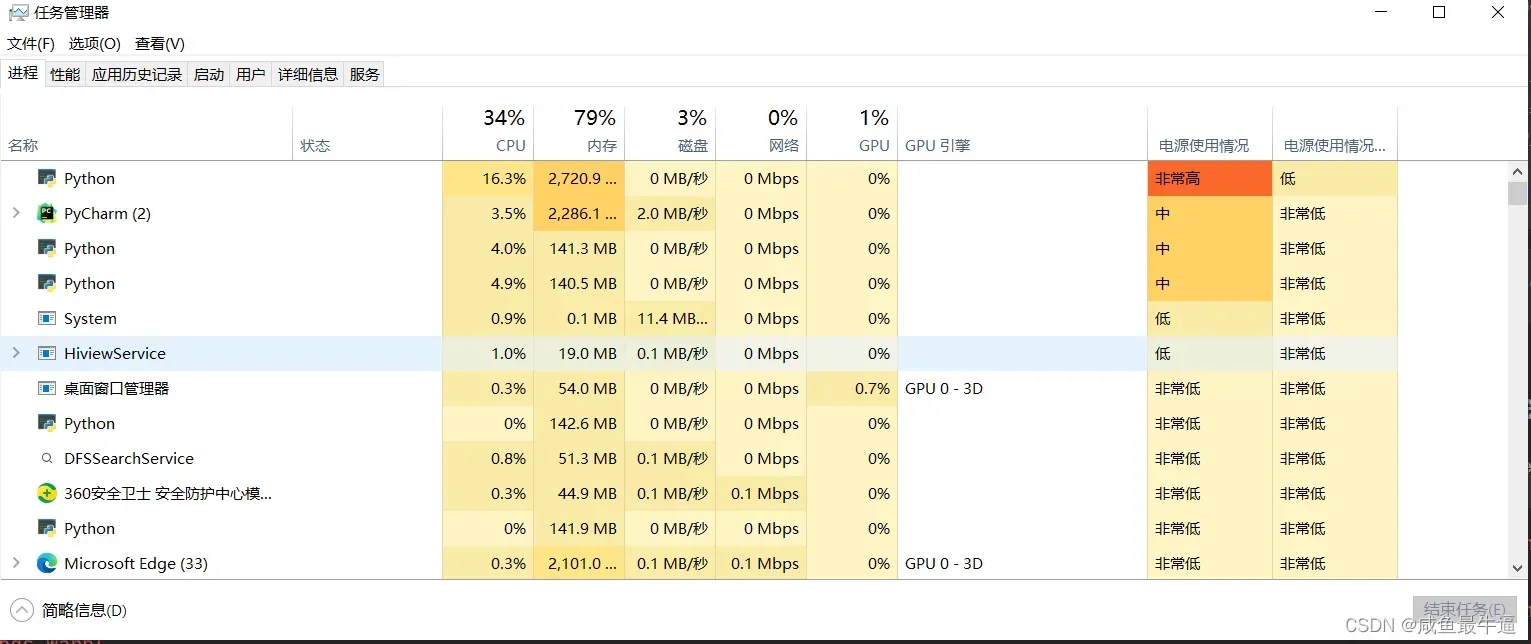

现象:

大概原因:GPU运算完毕后,花费了大量时间在写日志和存储pth文件,所以GPU使用率一直过低,CPU使用率一直很高。

具体原因分析参见【深度学习】踩坑日记:模型训练速度过慢,GPU利用率低

这里直接上解决办法:

- 减少日志IO操作频率

- 使用pin_memory和num_workers(num_workers调整不合适,会显示内存不够之类的问题,根据实际情况调整)

- 使用半精度训练

- 更好的显卡,更轻的模型

- 增大batch size提高epoch速度,但是收敛速度也会变慢,需要再适当升高学习率

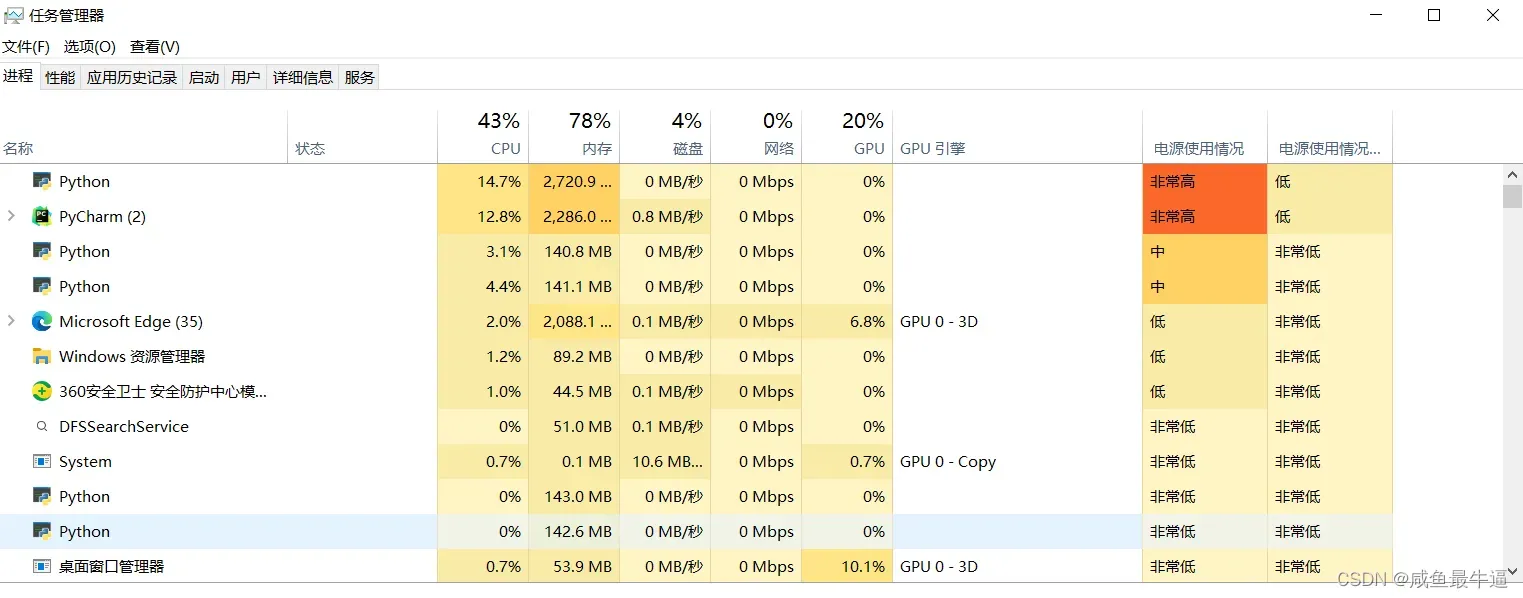

本文解决办法:这里我采用的是调整batch_size,由8调成10(本来想调成16,结果显示GPU内存不够,只能调到10):

文章出处登录后可见!

已经登录?立即刷新