DDPM:

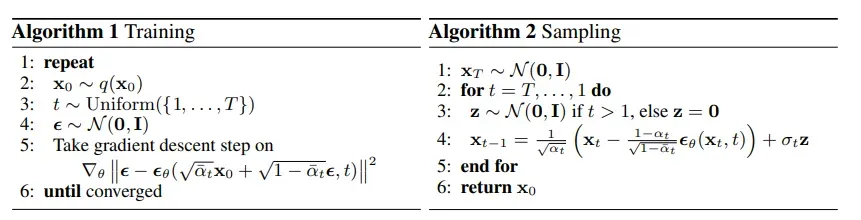

去噪扩散概率模型 (DDPM) 在没有对抗训练的情况下实现了高质量的图像生成,但它们需要模拟马尔可夫链的许多步骤才能生成样本。 为了加速采样,我们提出了去噪扩散隐式模型 (DDIM),这是一类更有效的迭代隐式概率模型,其训练过程与 DDPM 相同。 在 DDPM 中,生成过程被定义为马尔可夫扩散过程的逆过程。 我们构建了一类导致相同训练目标的非马尔可夫扩散过程,但其反向过程可以更快地进行采样。 我们凭经验证明,与 DDPM 相比,DDIM 可以在挂钟时间方面快 10 倍到 50 倍的速度生成高质量样本,允许我们权衡计算以换取样本质量,并且可以直接在潜在空间中执行具有语义意义的图像插值。

这些模型的一个关键缺点是它们需要多次迭代才能产生高质量的样本。对于 DDPM,这是因为生成过程(从噪声到数据)近似于前向扩散过程(从数据到噪声)的逆过程,前向扩散过程可能有数千步;需要遍历所有步骤才能生成单个样本,这与 GAN 相比要慢得多,后者只需要一次通过网络。例如,从 DDPM 中采样 50k 大小为 32 × 32 的图像大约需要 20 小时,但在 Nvidia 2080 Ti GPU 上从 GAN 中采样不到一分钟。对于较大的图像,这变得更加成问题,因为在同一 GPU 上采样 50k 大小为 256 × 256 的图像可能需要近 1000 小时。为了缩小 DDPM 和 GAN 之间的效率差距,我们提出了去噪扩散隐式模型 (DDIM)。

我们表明,由此产生的变分训练目标有一个共享的替代目标,这正是用于训练 DDPM 的目标。因此,我们可以通过选择不同的非马尔可夫扩散过程(第 4.1 节)和相应的反向生成马尔可夫链,从使用相同神经网络的大量生成模型中自由选择。

- DDIM 样本具有以下“一致性”属性,这不适用于 DDPM:如果我们从相同的初始潜在变量开始并生成多个具有不同长度马尔可夫链的样本,这些样本将具有相似的高级特征。

- 由于 DDIM 中的“一致性”,我们可以通过操纵 DDIM 中的初始潜在变量来执行具有语义意义的图像插值,这与 DDPM 不同

文章出处登录后可见!