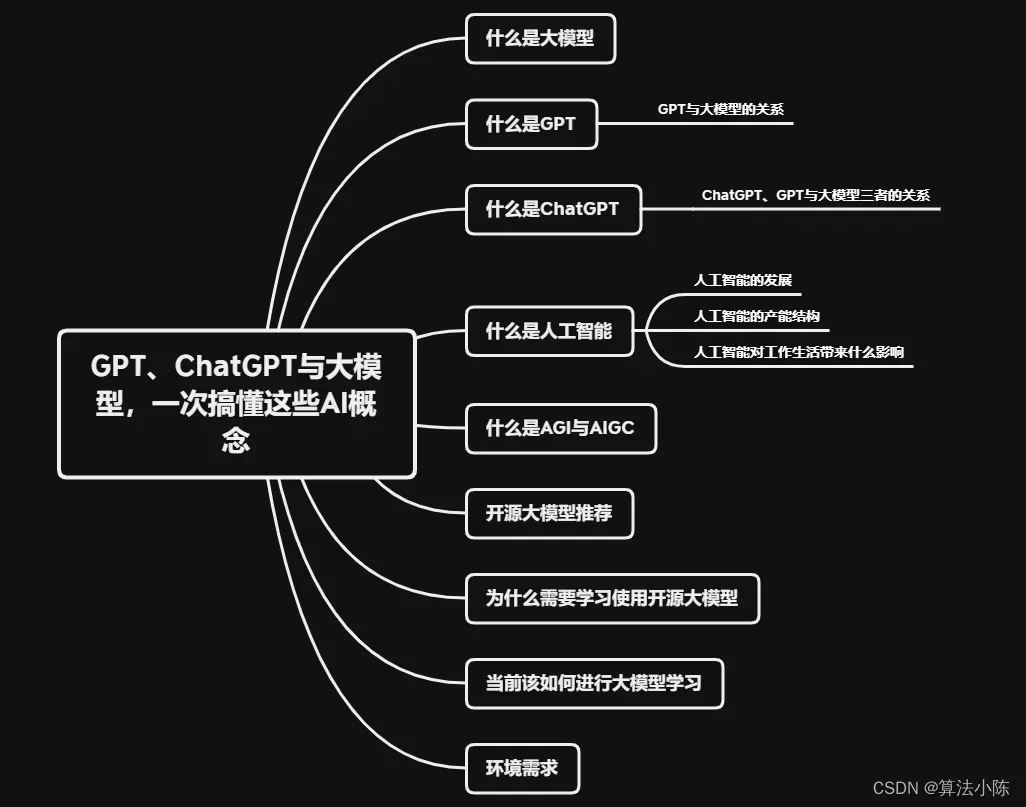

全文共5000余字,预计阅读时间约10~20分钟 | 满满干货,建议收藏!

一、什么是大模型

⼤模型全称为LLM(Large Language Model)是指⼤型的⾃然语⾔处理(NLP)模 型。

这些模型通常具有⼤量的参数,能够在海量⽆标签⽂本数据上进⾏预训练,从⽽学习到丰富的语⾔表示和知识。在这些模型中,”参数”可以被理解为模型学习任务所需要记住的信息。参数的数量通常与模型的复杂性和学习能力直接相关。更多的参数意味着模型可能具有更强的学习能力。

可以这么通俗的理解:如果一个模型”足够大”,那它就可以称为大模型。

二、什么是GPT

GPT,全称”Generative Pre-training Transformer”,是一个由OpenAI开发的自然语言处理(NLP)的模型。它的主要目标是理解和生成人类的自然语言。通过对大规模文本数据进行预训练,GPT模型能学习到语言的各种模式,如语法、句法、一词多义等,以及一些基础的世界知识。

总的来说,它通过预训练和生成技术,以及Transformer的自注意力机制,来理解和生成人类的自然语言。

2.1 GPT与大模型的关系

GPT-3 是一个具体的大模型的例子。当提到“大模型”时,通常是指具有大量参数的机器学习模型。

GPT-3是一个特别的大模型,因为它有1750亿个参数。这些参数使得GPT-3在处理语言任务时表现出强大的能力,例如:理解和生成自然语言文本、进行有深度和上下文的对话等。所以,可以说GPT-3是大模型的一个具体应用,显示了大模型的强大能力和可能性。

三、什么是ChatGPT

ChatGPT是基于GPT模型构建的基于Web端的“聊天机器人”,对于每一个对话提问,由后端已训练好的GPT3.5或GPT4模型进行预测,并实时返回文字预测的结果,从而实现对话任务。

总的来说,ChatGPT是一个能够生成文本,回答问题和进行自然语言对话的 AI 模型。它可以帮助我们完成各种任务,例如聊天,写作,信息检索和问题回答等。

如需了解更多关于ChatGPT的内容,如发展历程、ChatGPT能做什么等内容,可以看文章:轻松学习ChatGPT:告诉你为什么它能改变你的生活

目前ChatGPT可以使用免费的GPT-3.5和付费的Plus版GPT-4,一张图说明GPT-3.5和GPT-4的区别:

3.1 ChatGPT、GPT与大模型三者的关系

ChatGPT是一种特定的GPT应用,GPT是一种大模型,而大模型是一类具有大量参数的深度学习模型。

四、什么是人工智能

人工智能真正进入公众视野的事件是:2017年5月27日阿尔法围棋在与世界排名第一的围棋冠军柯洁进行的人机大战中以3比0的总比分胜出,随后宣布退役。这不仅象征着人工智能在特定领域已经超越了人类的能力,也标志着我们正式步入了人工智能时代。

人工智能,借助机器学习和海量计算能力的强大推动,正逐步提升其复杂性和应用广度。它已经成为推动我们进入新的智能时代的关键力量。全球各地的产业界深谙人工智能技术引领新一轮产业变革的重大意义,都在积极进行转型并提前布局,以适应这个全新的人工智能创新生态。

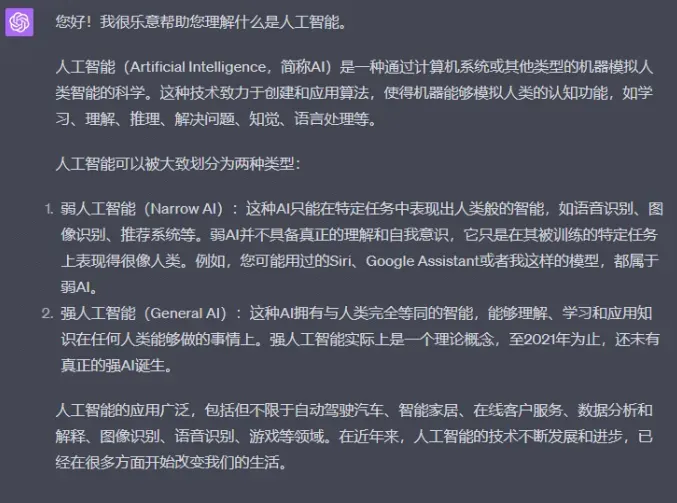

我们来问一问ChatGPT是怎么描述人工智能的。

Prompt:您好,请帮我解释一下什么是人工智能?

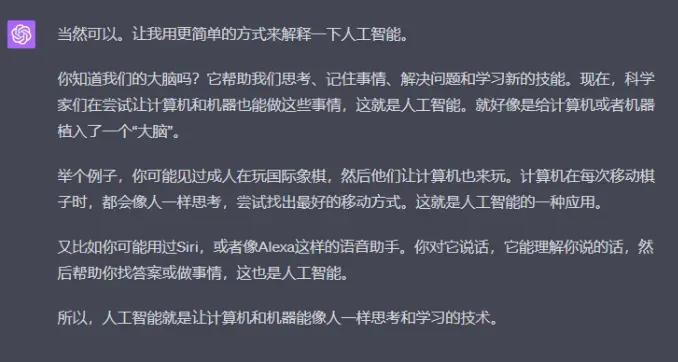

Prompt:您这样解释太专业了,很多人看不懂,能不能更通俗一点、更 生活化一点 ,甚至让儿童都能理解呢??

如同蒸汽时代的蒸汽机、电气时代的发电机、信息时代的计算机和互联网,人工智能(AI)正赋能各个产业,推动看人类进入智能时代。

一个经典的人工智能定义是:智能主体可以理解数据及从中学习,并利用知识实现特定目标和任务的能力。

4.1 人工智能的发展

人工智能,被誉为第四次科技革命的核心驱动力,现已步入其2.0时代。我们来回溯一下这个重要的发展轨迹。

在1956年,人工智能这一概念被提出,然而真正的爆发期始于2012年,标志着人工智能1.0时代的启动(2012年-2018年)。此时期的关键里程碑是AlexNet模型的问世,它开启了卷积神经网络(CNN)在图像识别领域的应用。2015年,机器在图像识别的准确率首次超过人类(错误率低于4%),这为计算机视觉技术在各个领域的应用奠定了基础。然而,这个时期的人工智能还面临一些挑战,如模型碎片化和泛化能力不足。

紧接着,人工智能进入了2.0时代(2017年至今)。在这个阶段,Google Brain团队于2017年提出了Transformer架构,这种架构在大模型领域奠定了主流算法基础。自2018年开始,大模型快速崛起,模型参数量呈现指数级增长。比如,2018年谷歌的模型参数首次超过一亿,而到了2022年,模型参数量已经达到了5400亿。这种“预训练+微调”的大模型策略有效地解决了1.0时代人工智能的泛化能力不足问题。伴随着新一代AI技术的不断发展,我们有望迎来全新一轮的技术创新周期。

4.2 人工智能的产能结构

人工智能产业链主要可划分为基础层、技术层以及应用层这三大部分:

首先,基础层关注基础支持平台的建设,包括传感器、AI芯片、数据服务和计算平台。目前,以约16%的市场份额,浪潮已经成为全球AI基础设施领域的龙头企业,其后分别是戴尔和HPE。

其次,技术层着重于核心技术的研发,主要涵盖算法模型、基础框架以及通用技术。

最后,应用层侧重于行业应用的发展,主要包含行业解决方案服务、硬件产品和软件产品。目前,人工智能在金融、家居、交通、医疗等领域已有重大进展,同时,自动驾驶汽车、无人机、智能机器人、智能语音助手等人工智能产品也在迅速发展。

资料来源:36氪研究院、国信证券经纪研究所

关于市场规模,随着模型参数的不断增加,算力需求也在快速增长。全球AI市场预计在2024年将超过6000亿美元,复合增速为27%。另一方面,中国AI市场预计在2024年将接近八千亿人民币,复合增速达44%,这显然高于全球整体增长速度。

目前,中国人工智能行业的主要竞争者包括浪潮、字节跳动、百度、腾讯、华为、阿里等公司。此外,商汤、旷视、科大讯飞等科技公司也已加入人工智能行业的竞争中。

4.3 人工智能对工作生活带来什么影响

人工智能已经广泛融入经济发展的各个领域,成为推动科技跨越发展、产业优化升级、生产力整体跃升的重要驱动力量,为新旧动能转换和经济高质量发展提供了有力支撑。具体来说,人工智能的影响主要体现在以下三个方面:

首先,人工智能正在使生产方式变得更加精益化。人工智能技术如自动化、数据驱动决策、实时监控和反馈、智能调度和优化以及连接和协同等,使得生产方式变得更加精益化。这些技术和方法的应用可以提高生产效率、质量控制、资源利用率和生产灵活性,从而推动企业的精益化生产和持续改进。

其次,人工智能正在使生活方式变得更便捷且智能化。近年来,人工智能已经深入到我们的日常生活中,如自动驾驶汽车、智能机器人、语音助手、智能音箱、智能医疗和智能家居等。这些应用不仅提升了我们生活的便捷性,同时也使我们的生活变得更加智能化。

最后,人工智能将会引领新的交往方式的出现。随着人工智能的深层次发展,人与人之间的交往方式正在发生变化。新的交往方式将会出现,由此促进人们交往方式的日新月异。从数字化社交网络到虚拟现实交互,人们的交往方式正在变得越来越多样化,可能会出现新的特殊符号、肢体交往等新式交往模式。

综上所述,人工智能正在全面地改变我们的生产、生活和交往方式,为我们步入高质量的经济社会发展新时代提供了有力的支持和驱动力。

五、什么是AGI与AIGC

“AGI” 是 “Artificial General Intelligence” 的缩写,中文通常称为”人工通用智能”。AGI是一种理论上的形式的人工智能,指的是能够执行任何人类智能任务的机器。

简单来说,AGI能够理解、学习、适应和应对一切类型的任务,不仅仅是在某个特定的、窄范围的任务上超越人类,比如我们现在见到的大部分AI。有专家预测,GPT-5将会是第一代AGI。

而AIGC,即(AI Generated Content),就是利用AI创造的内容。

六、开源大模型推荐

-

LLaMa:LLaMa是Meta AI公司开源的一组大规模语言模型,参数范围从7B到65B。它们在多达14,000亿tokens的语料上进行了训练。其中,LLaMA-13B在大部分基准测评上超过了GPT3(175B),6B可在个人GPU上使用,13B时性能相当于GPT3(175B),训练复杂度高于ChatGLM。

-

ChatGLM:ChatGLM-6B是清华大学知识工程和数据挖掘小组发布的一个开源的、支持中英双语的对话语言模型,基于General Language Model (GLM)架构,具有62亿参数。根据智谱AI公司的GLM-130B修改而来,结合模型量化技术,可以在消费级的显卡上进行本地部署(INT4量化级别下最低只需6GB显存)。

-

Alpaca:斯坦福大学根据LLAMA7B模型训练得到,性能接近GPT3.5,测试中发现中文支持较差。

-

MOSS:复旦大学团队开发,是一个支持中英双语和多种插件的开源对话语言模型,moss-moon系列模型具有160亿参数,在FP16精度下可在单张A100/A800或两张3090显卡运行,在INT4/8精度下可在单张3090显卡运行。MOSS基座语言模型在约七千亿中英文以及代码单词上预训练得到,后续经过对话指令微调、插件增强学习和人类偏好训练具备多轮对话能力及使用多种插件的能力,同样,经测试对中文支持一般。

-

miniGPT4:沙特国安大学的华人团队,未公布参数,使用4块A100(80G显存)GPU训练得到,本地部署最低需要12G显存,具备多模态能力。即除了识别文字外,还可识别图像,可以根据图像输出文字。

-

GPT4ALL:基于LLAMA7B模型微调得到,训练数据采用了OpenAlGPT-3.5-Turbo模型创建的对话语料和其他语料,GPT-3.5-TurboAPI总花费500刀,全部语料均已开源,本地部署需要至少16G显存,缺乏中文训练语料,因此对中文支持较差。

七、为什么需要学习使用开源大模型

首先,目前GPT大模型的使用受到国内外的双重限制,这对于用户的操作空间产生了较大影响。此外,保证数据安全性对于企业来说至关重要,使用GPT大模型可能会存在数据泄露等安全隐患,这无疑增加了使用风险。

其次,在经济层面,使用GPT大模型通常是按量计费的,如果需要大规模使用,就需要支付相对较高的费用。这对于需要控制成本的企业来说,无疑增加了其运营压力。

再次,GPT大模型虽然可以进行微调,但是无法从训练语料层面进行定制化训练。这可能会导致中文对话显得稍显生硬,不够自然,无法满足一些特定需求。

因此,学习并使用开源大模型具有很大的必要性。它们不仅可以帮助我们避免上述问题,还可以根据我们的具体需求进行定制化训练,从而更好地满足我们的需求。

八、当前该如何进行大模型学习

目前大厂提出的大模型都不是开源模型,且大都处于测试阶段。

所以目前学习阶段建议选择OpenAl的GPT模型进行学习和实践。因为其GPT大模型底层原理、参数信息等未公开,所以应围绕API调用、微调方法、数据预处理方法等进行学习和实践,并以应用为主。

九、环境需求

如需继续跟进大模型研发相关技术,您需要具备以下要求:

- 具备基本的Python基础

- OpenAI账号

- 如果有6G以上(推荐8G 以上)的显卡,则可本地安装部署,若没有显卡,则可以考虑 在线GPU进行计算;(

- 教程能力:对标大模型研发工程师

十、结语

在这篇文章中,我们揭示了人工智能、大模型、GPT、以及ChatGPT的概念及它们潜在关系。希望这篇文章为你解开了这些概念的纷繁复杂,让你对人工智能以及其在我们的工作和生活中的影响有了更深的理解。

最后,感谢您阅读这篇文章!如果您觉得有所收获,别忘了点赞、收藏并关注我,这是我持续创作的动力。您有任何问题或建议,都可以在评论区留言,我会尽力回答并接受您的反馈。如果您希望了解某个特定主题,也欢迎告诉我,我会乐于创作与之相关的文章。谢谢您的支持,期待与您共同成长!

期待与您在未来的学习中共同成长。

最后,给大家送上干货!建议大家点赞&收藏,Mark住别丢了。有高质量资料免费送!

文章出处登录后可见!