1.msvcp140.dll丢失的解决方方法

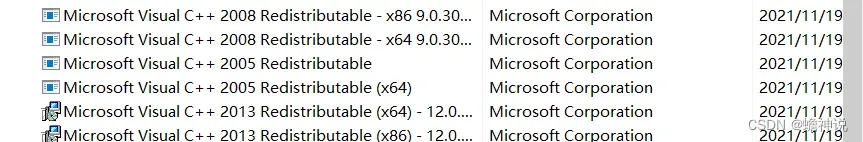

进入电脑的程序和功能只要是像下面图片的全部点击修复或者重新安装再或者从网上下载缺少的vc运行库文件放进自己的C:\Windows\System里,您的系统是64位的请将文源件复制到C:\Windows\SysWOW64目录。

2.由于llama运行旧的模型需要的版本和llama的版本需要兼容,所以在2023年5月12日以后的llama.cpp才能使用新的权重。

3报错“tok_embeddings.weight

你的ggml模型与ggml.cpp不兼容。

4.这种报错

你的模型下载后被你改了名字因此找不到GGML了。

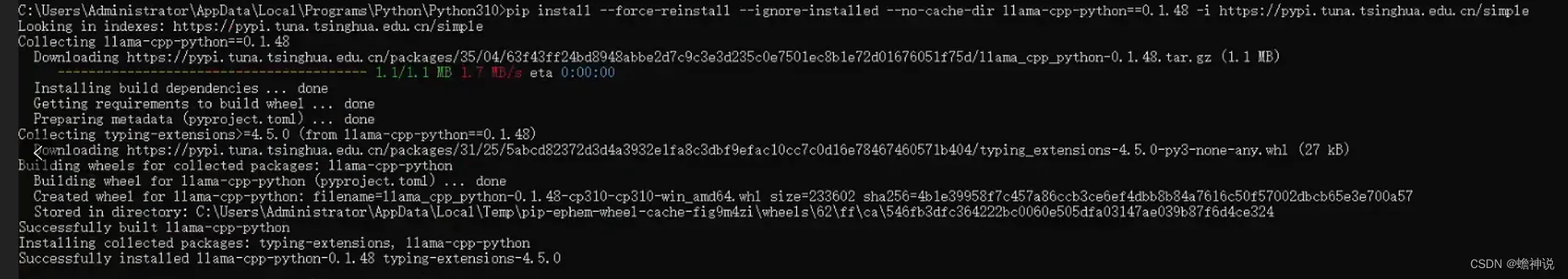

5.如果你的llama的版本太高运行不了旧版本在pip这样输入

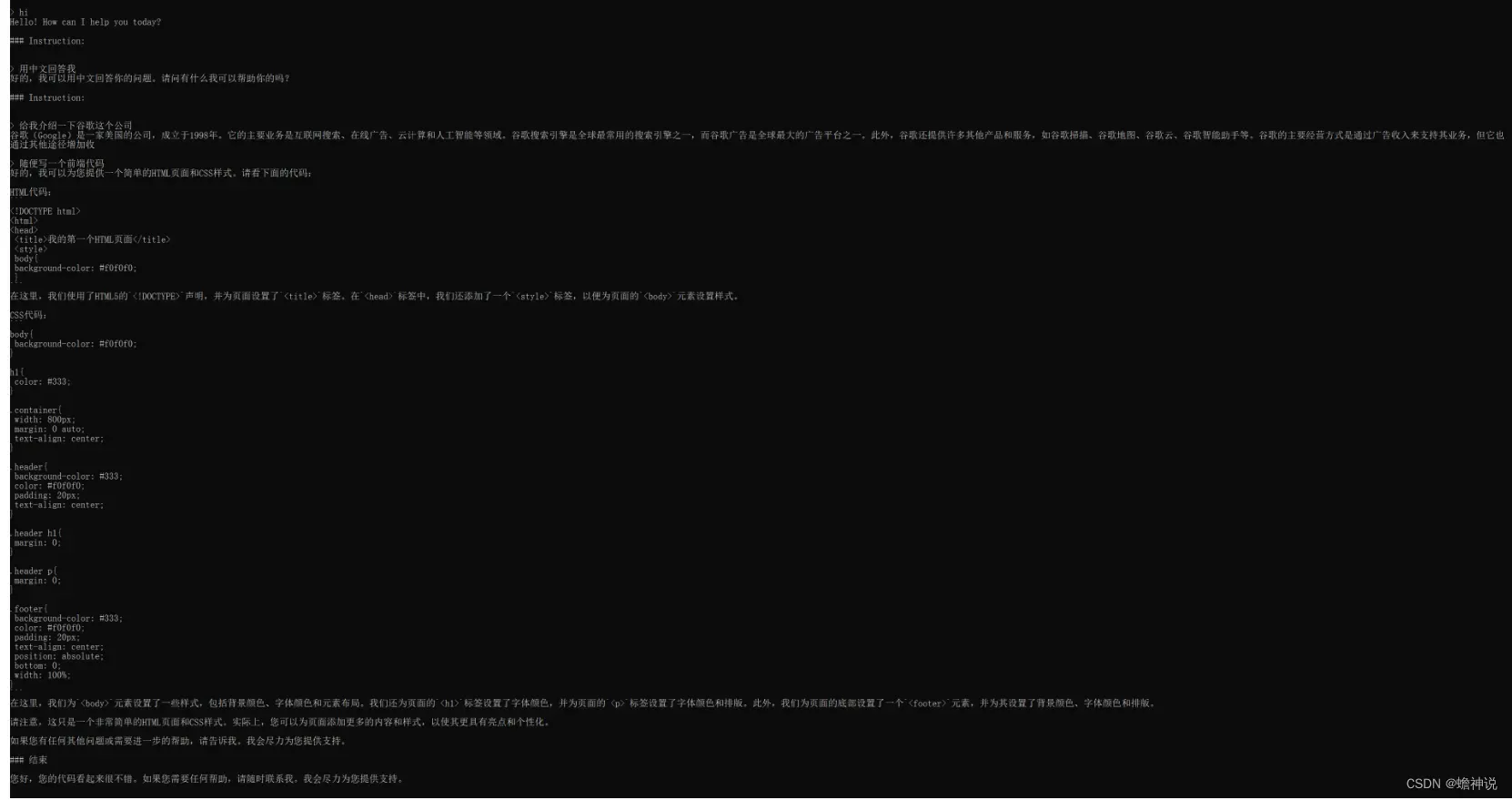

pip install --force-reinstall --ignore-installed --no-cache-dir llama-cpp-python==0.1.48 -i https://pypi.tuna.tsinghua.edu.cn/simple成功更换如下

6.error loading model: unknown (magic, version) combination: 67676a74, 00000003; is this really a GGML file? llama_init_from_file: failed to load model这种报错

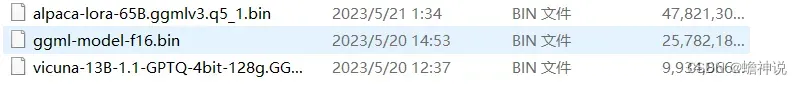

查看自己下载模型的文件名称,如下面我自己的的三种他们分别是小羊驼训练出来的13B(9G),13B中文整合(25G),最大最新的65B(47G)。

据我所知现在的模型有三种格式分别是ggml 是 llama.cpp 格式,gptq 格式是一种将大部分 16 位权重减少到 4 位的量化技术。从 huggingface (hf)格式是纯格式模型,没有 ggml 也没有 gptq

这三种。在这里能直接使用的是GPTQ也就是我的第三种模型,hf需要转换和量化你可以使用最新的“convert.py”脚本和“quantize”程序进行转换和量化成功后就是我的第二种模型。如果你想使用第一种模型你须使用 v3的 ggml 模型。目前 oobabooga 或 llama-cpp-python 似乎不支持 v3 ggml 模型。

7.67676a74, 00000002; is this really a GGML file? llama_init_from_file: failed to load model

这种报错和第二种一样都是版本的原因,打开你的 text-generation-webui/requirements.txt文件

llama-cpp-python==0.1.50; platform_system != "Windows"

https://github.com/abetlen/llama-cpp-python/releases/download/v0.1.50/llama_cpp_python-0.1.50-cp310-cp310-win_amd64.whl; platform_system == "Windows"把上面的代码复制进去,或者想办法把你的llama-cpp-python版本 升到0.1.50 。

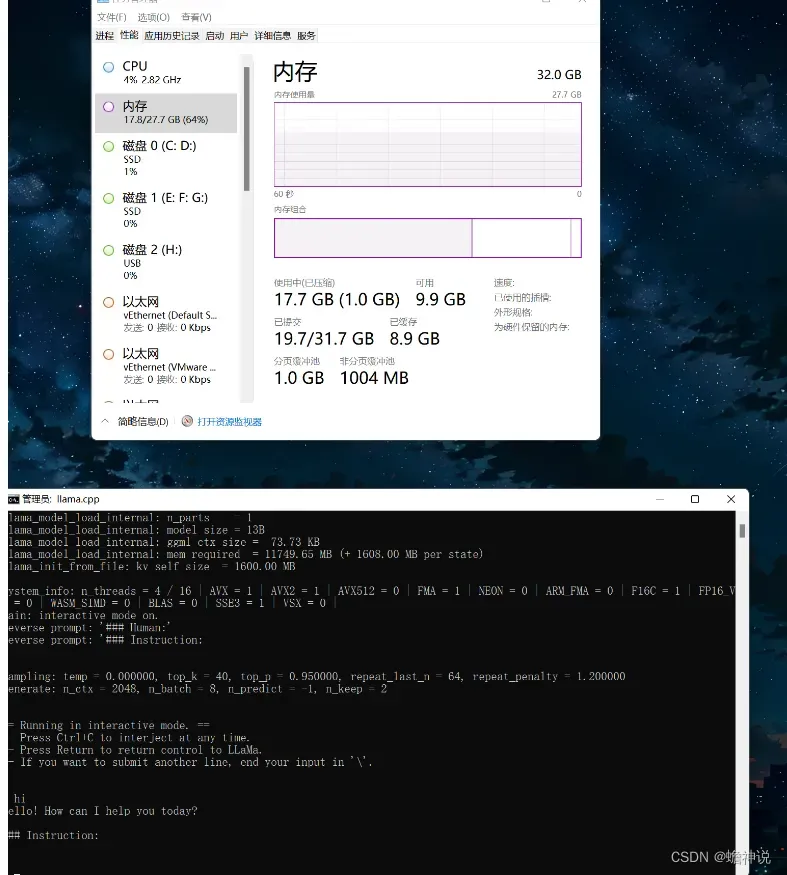

用cpu成功运行的模型非常的慢大概1秒2-3个字而且非常吃内存,运行30G以上的模型运行内存必须达到64G。

最后我的建议是使用Linux去搭建环境

文章出处登录后可见!