说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后获取。

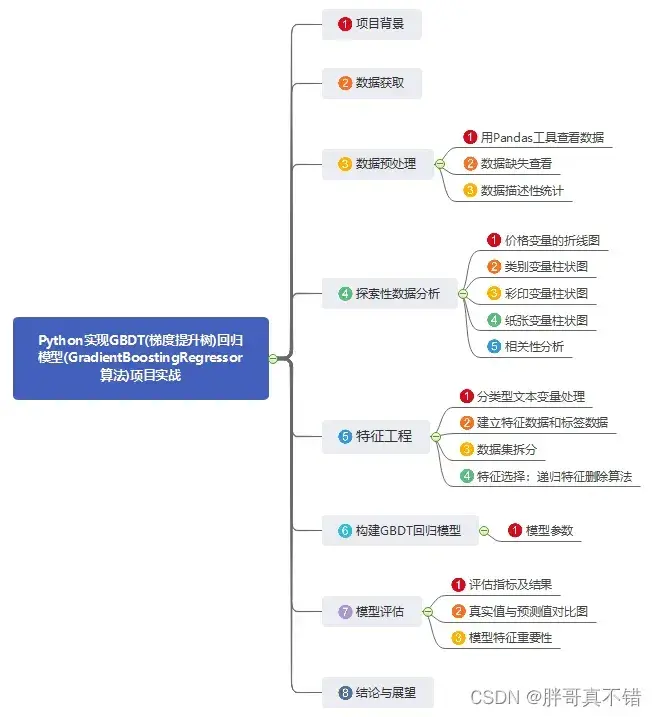

1.项目背景

GBDT是Gradient Boosting Decision Tree(梯度提升树)的缩写。出版社在对图书进行定价时会考虑图书的页数、纸张、类别、内容、作者及读者等很多因素,用人工来分析较为烦琐,并且容易遗漏。如果能建立一个模型综合考虑各方面因素对图书进行定价,那么就能更加科学合理地节约成本、提升效率,并在满足读者需求的同时促进销售,挖掘更多潜在利润。该GBDT算法产品定价模型也可以用于其他领域的产品定价,如金融产品的定价。

2.数据获取

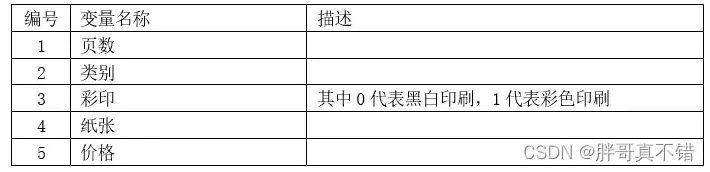

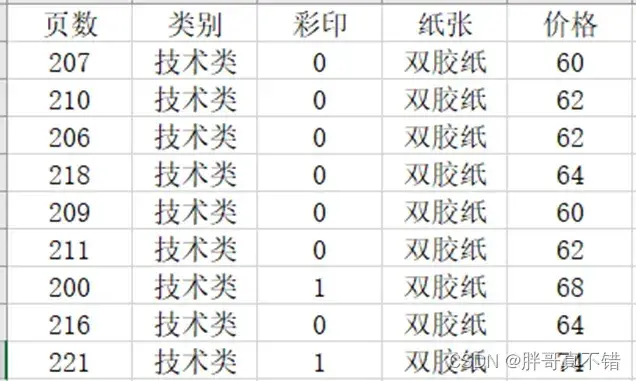

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

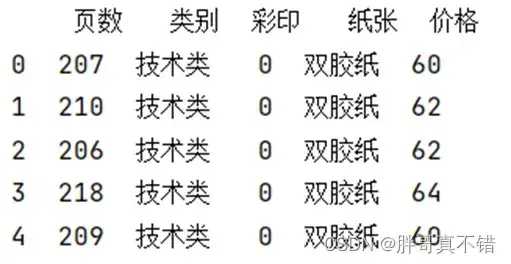

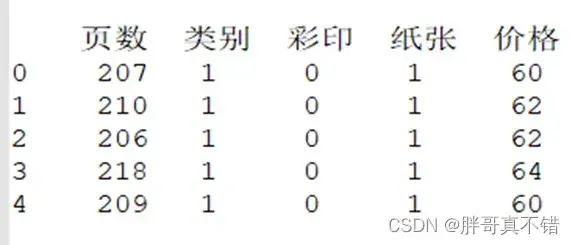

数据详情如下(部分展示):

3.数据预处理

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

关键代码:

3.2数据缺失查看

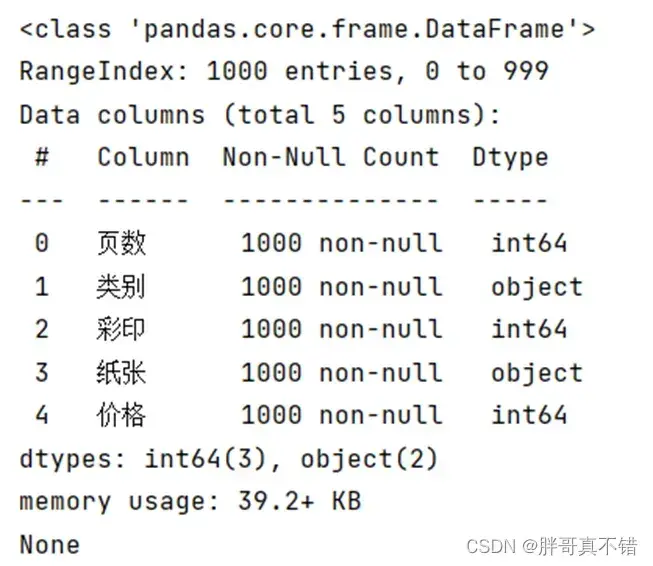

使用Pandas工具的info()方法查看数据信息:

从上图可以看到,总共有5个变量,数据中无缺失值,共1000条数据。

关键代码:

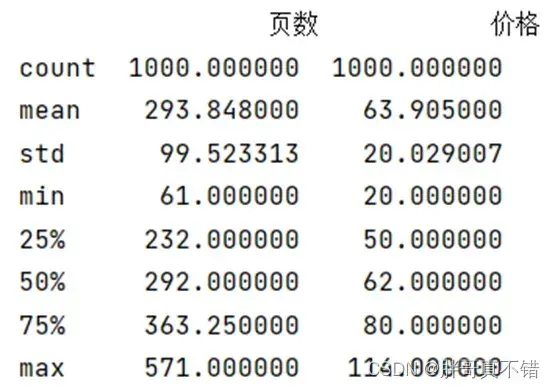

3.3数据描述性统计

通过Pandas工具的describe()方法来查看数据的平均值、标准差、最小值、分位数、最大值。

关键代码如下:

4.探索性数据分析

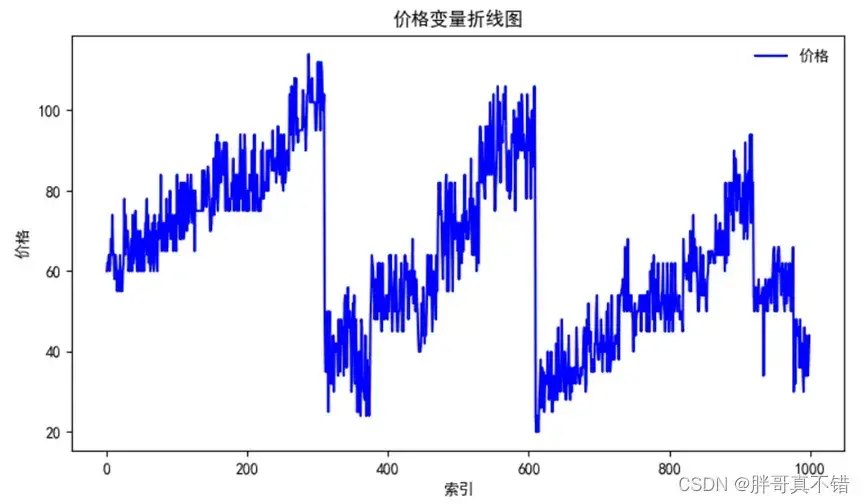

4.1 价格变量的折线图

用Matplotlib工具的plot()方法绘制折线图:

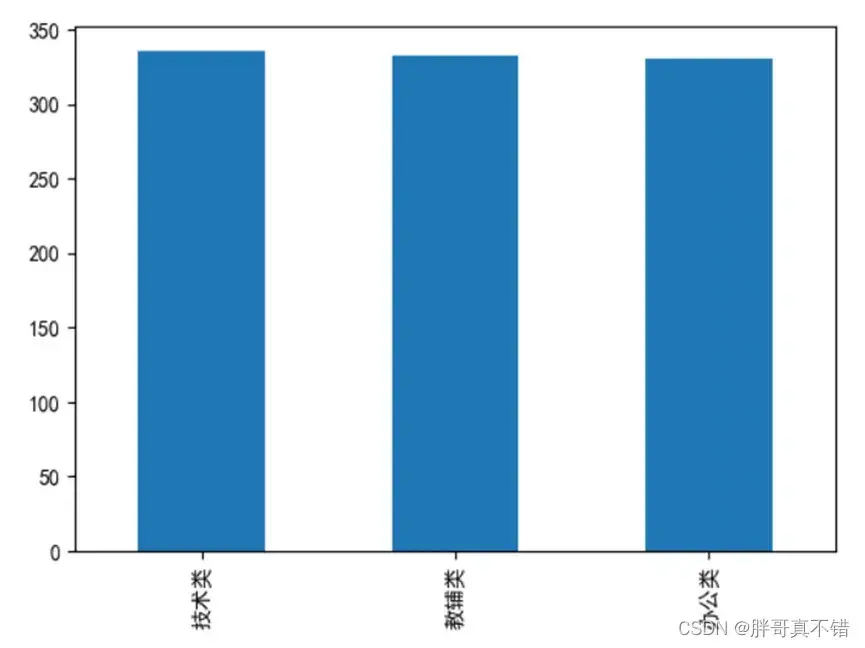

4.2 类别变量柱状图

用Pandas工具的plot(kind=‘bar’)方法绘制柱状图:

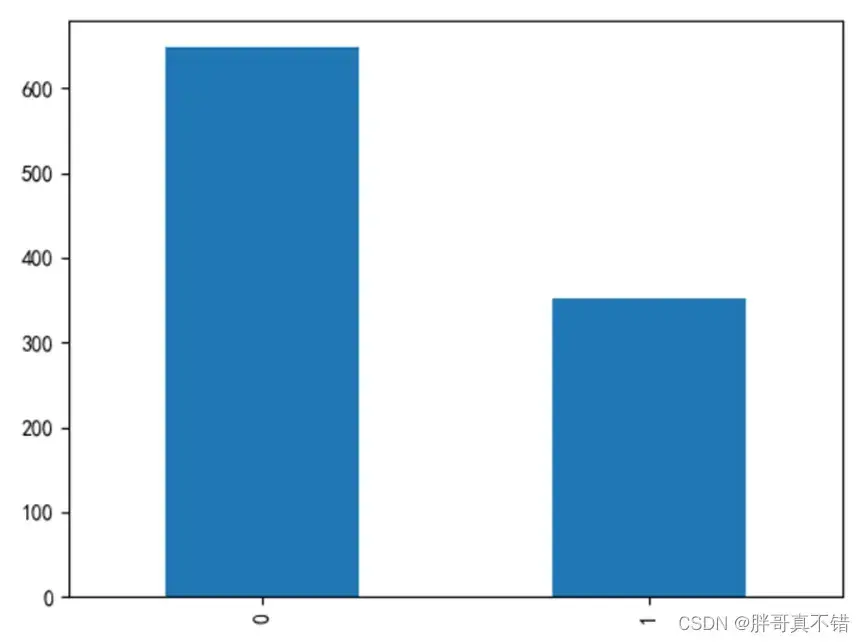

4.3 彩印变量柱状图

用Pandas工具的plot(kind=‘bar’)方法绘制柱状图:

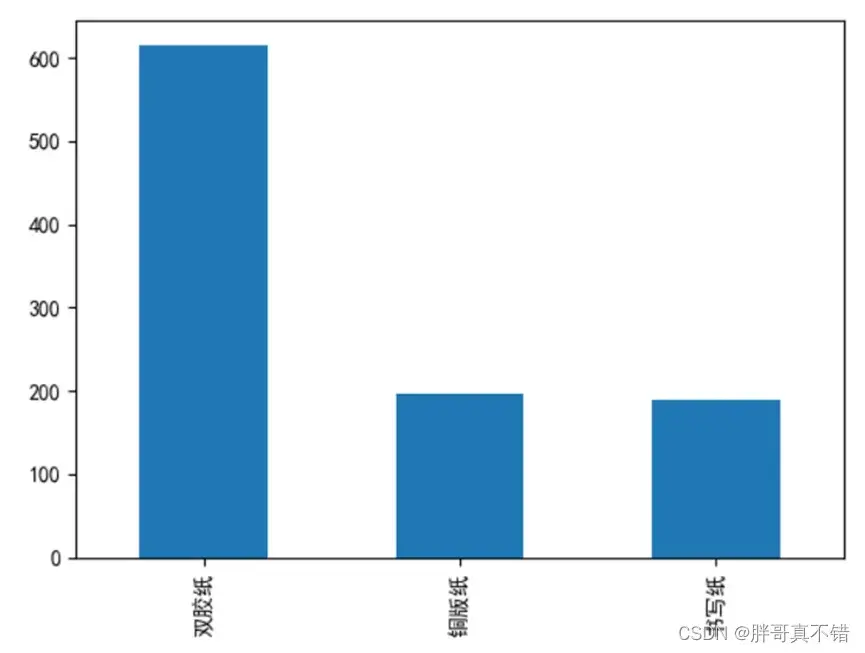

4.4 纸张变量柱状图

用Pandas工具的plot(kind=‘bar’)方法绘制柱状图:

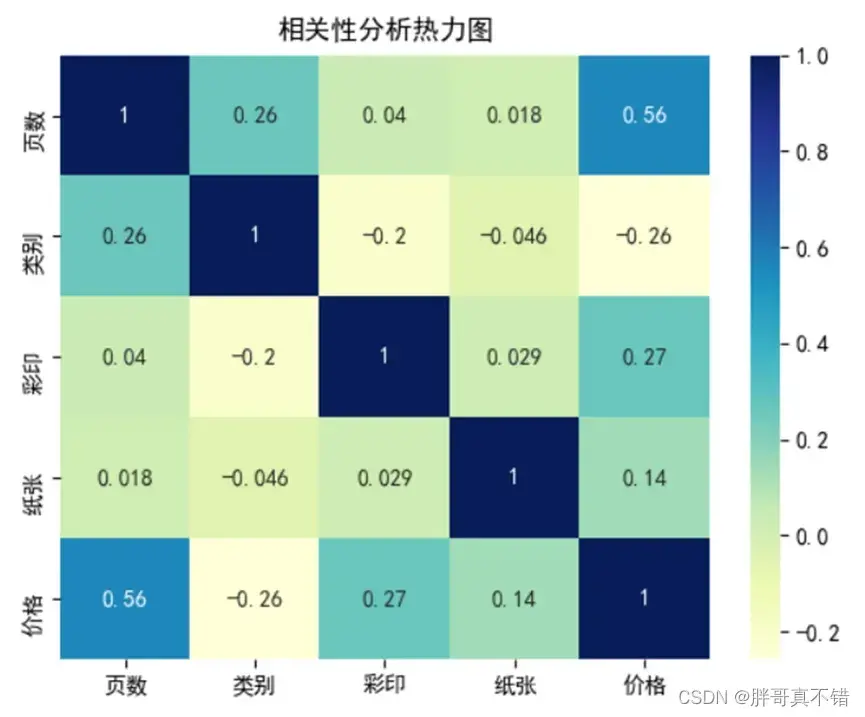

4.5 相关性分析

从上图中可以看到,数值越大相关性越强,正值是正相关、负值是负相关。

5.特征工程

5.1 分类型文本变量处理

在数据集中,类别和纸张变量为分类型文本变量,本文变量无法直接应用于机器学习,需要转换成数值型变量,本项目使用LabelEncoder()标签编码进行转换,转换后的结果为:

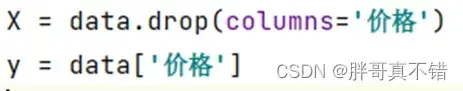

5.2 建立特征数据和标签数据

关键代码如下:

5.3 数据集拆分

通过train_test_split()方法按照80%训练集、20%测试集进行划分,关键代码如下:

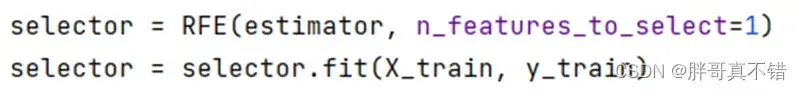

5.4 特征选择:递归特征删除算法

使用RFE()方法进行特征选择,返回特征的贡献情况,关键代码如下:

返回的结果:

返回的是特征贡献度,可以看到最大的是 页数变量,最小的是 彩印变量。这个在实际应用过程中,根据需要进行选择,由于本案例使用的特征变量不多,所以后续的建模中,所有特征变量都参与。

6.构建GBDT回归模型

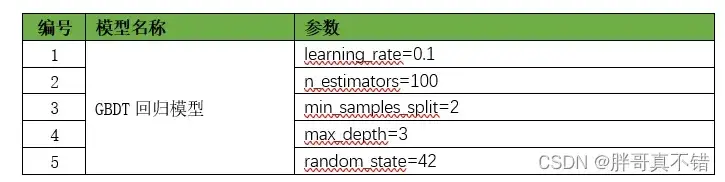

主要使用GradientBoostingRegressor算法,用于目标回归。

6.1模型参数

7.模型评估

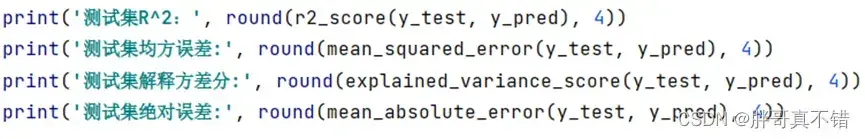

7.1评估指标及结果

评估指标主要包括可解释方差值、平均绝对误差、均方误差、R方值等等。

从上表可以看出,R方为84.65% 可解释方差值为84.74%,GBDT回归模型效果良好。

关键代码如下:

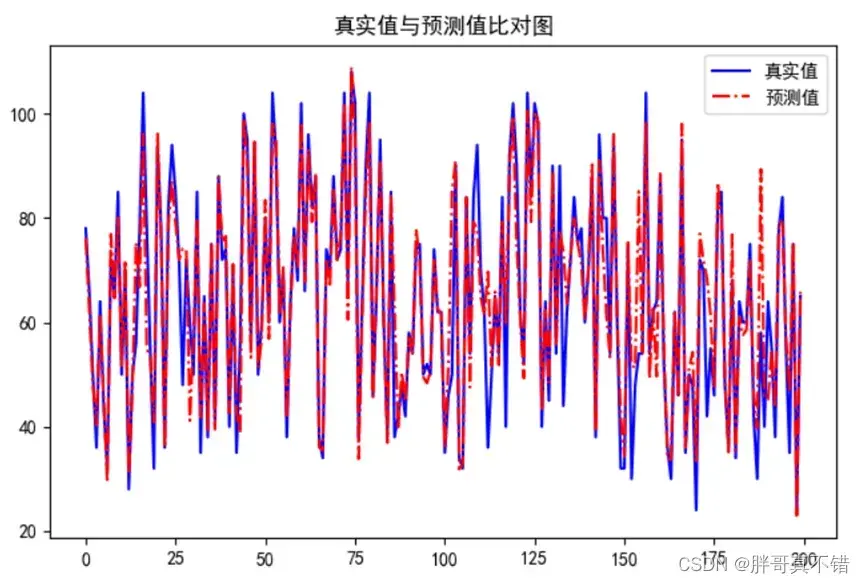

7.2 真实值与预测值对比图

从上图可以看出真实值和预测值波动基本一致,模型拟合效果良好。

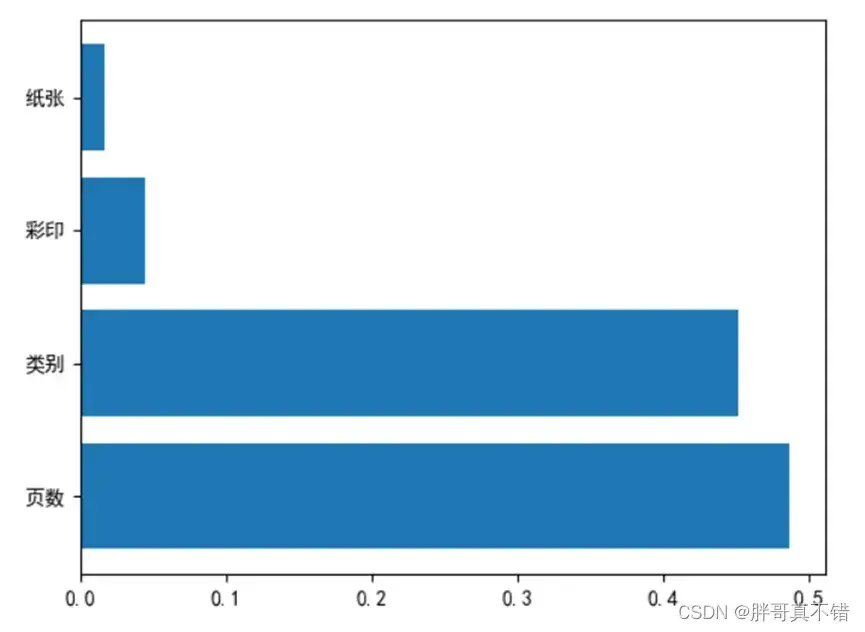

7.3 模型特征重要性

特征重要性如图所示:

从上图可以看到特征变量对此模型的重要性依次为:页数、类别、彩印、纸张。

8.结论与展望

综上所述,本文采用了GBDT回归模型,最终证明了我们提出的模型效果良好。此模型可用于日常产品的定价。

本次机器学习项目实战所需的资料,项目资源如下:

项目说明:

链接:https://pan.baidu.com/s/1dW3S1a6KGdUHK90W-lmA4w

提取码:bcbp网盘如果失效,可以添加博主微信:zy10178083

文章出处登录后可见!