【DataWhale学习】Day3~9-3章线性模型——西瓜书学习摘录笔记

函数的性质

在研究线性模型之前,我们先要对凸集下一个定义:

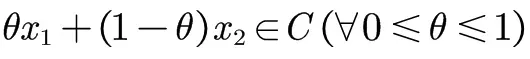

对集合C内的任意两点x1、x2 ∈ C,若它们之间的连线上的所有点仍属于集合C,即

则我们称集合C为“凸”的,即C是一个凸集(convex set)

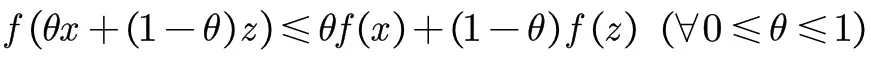

对定义在凸集上的函数f:Rd->R,令定义域内的x、z都满足

则我们称函数f(.)为凸的,即f(.)是一个凸函数(convex function)

我们对于线性模型的参数估计都是通过凸函数完成的,所以对于一般模型证明其定义在凸集是非常重要的,这里的内容后续补充

分割线====

需要注意的是,一些数学变换依旧能保持函数的凸性,如:

1、若 f 是凸函数,则*g(x) = f(Ax+b)*也是凸函数;

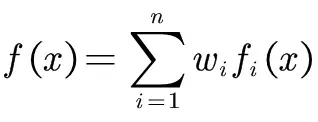

2、若f1、…、fn是凸函数,w1,…,wn ≥ 0,则

也是凸函数。

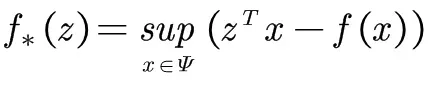

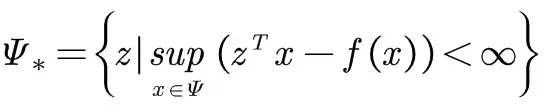

函数 f:Rd->R的共轭函数(conjugate function)定义为

其定义域

共轭函数拥有很好地性质:

无论原函数是否为凸函数,共轭函数一定是凸函数——解决了函数为非凸函数的方法

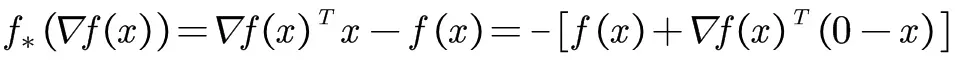

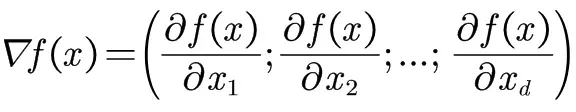

若函数 f 可微,则

其中,

最优化基础

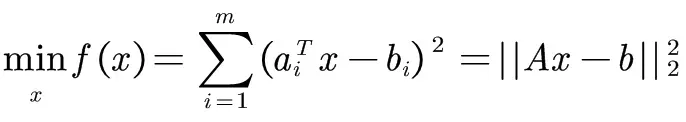

一个简单的优化问题是最小二乘(Least Square):

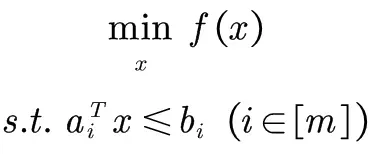

线性规划(linear programming)问题如:

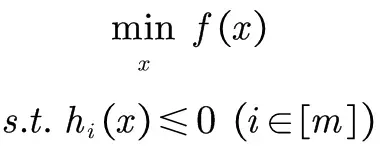

一般地,一个优化问题可以表示为

线性回归

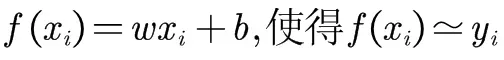

目标:学习w和b使得

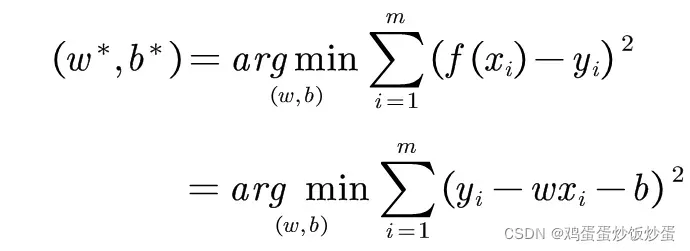

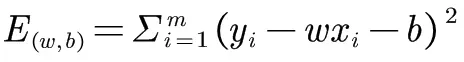

其最关键的是衡量 f(x)与 y 的差别,采用均方差度量的方式,可以通过调整w和b的值使得均方误差值最小化,即有

而求解w和b的使

最小化的过程,称为线性回归模型的最小二乘“参数估计”(parameter estimation),可将

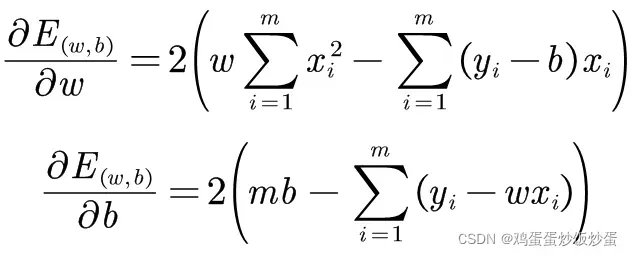

分别对w和b求导,得到

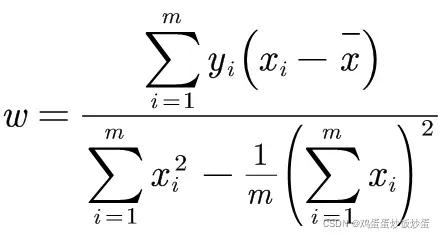

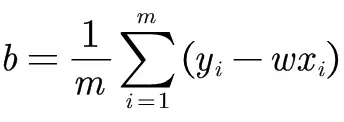

令上式为0可得到w和b的最优解

这里不做对多元线性回归的讨论

对数几率回归

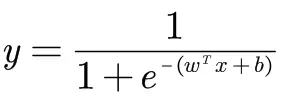

思想很简单,上述线性回归是对于线性模型就行回归学习,对数几率回归是对于分类任务进行学习,而实际中我们只需找一个单调可微函数将分类任务的真实标记 y 与线性回归模型的预测值联系起来,最理想的是“单位阶跃函数”(unit-step function),但是由于其并不连续,不能用作可微的线性模型中,因此采用近似单位阶跃函数的“替代函数”(surrogate function),并希望它能够单调可微。对数几率函数(logistic function)就是这样的函数,我们结合线性模型可以得到:

那么该如何确定里面的w和b呢?这里不做详细推导,直接上结论

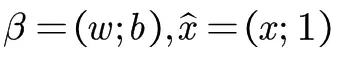

令

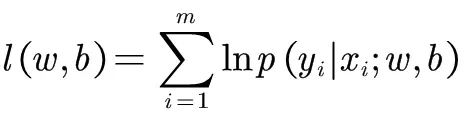

,采用极大似然法(maximum likelihood method)对于

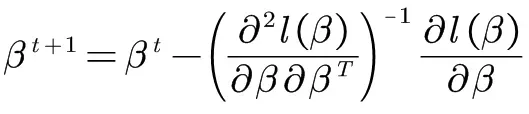

采用牛顿法或梯度下降法都可以得到公式

以牛顿法为例,t+1轮迭代解的更新公式为

版权声明:本文为博主鸡蛋蛋炒饭炒蛋原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/weixin_46139709/article/details/122552120