论文信息

论文标题:Simple Contrastive Graph Clustering

论文作者:Yue Liu, Xihong Yang, Sihang Zhou, Xinwang Liu

论文来源:2022,arXiv

论文地址:download

论文代码:download

1 Introduction

贡献:

提出了一种简单的对比深度图聚类方法,称为 。

不需要预训练,并为网络训练节省时间和空间;

提出了一种新的仅在增强的属性空间中进行数据扰动的数据增强方法;

设计了一种新的面向邻居的对比损失,以保持跨视图的结构一致性;

2 Method

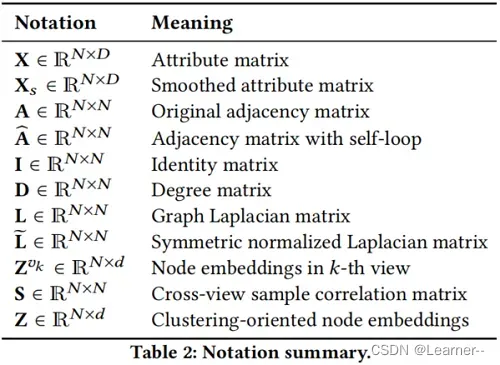

2.1 Notations and Problem Definition

2.2 Overall Framework

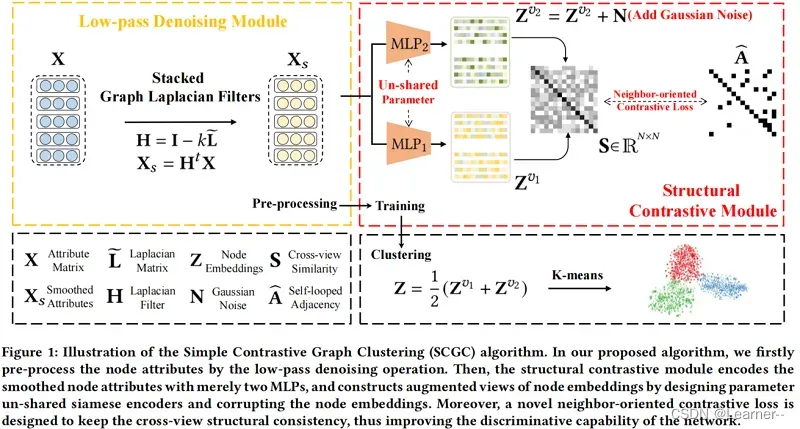

整体框架:

2.3 Low-pass Denoising Operation

[5, 18, 44] 证明了拉普拉斯滤波器可以达到与图卷积运算相同的效果。所以引入一个低通去噪操作,在训练前将邻居信息聚合作为一个独立的预处理。这样,属性中的高频噪声将被有效地过滤掉。

具体地说,采用了一个图的拉普拉斯滤波器作为公式:

为实值,对于

的选择,在所有实验中遵循 AGE[5] 并设置

。随后,将

层图拉普拉斯滤波器堆栈如下:

其中, 为平滑的属性矩阵。通过这种低通去噪操作,过滤掉了属性中的高频噪声,从而提高了聚类性能和训练效率。

2.4 Structural Contrastive Module

结构对比模块(SCM),保持两个不同的视图的结构一致性,从而提高网络的鉴别能力。

具体来说,首先用设计的参数非共享MLP编码器对平滑属性 进行编码,然后用

-norm 对学习到的节点嵌入进行归一化如下

其中, 和

表示两个增广视图学习到的节点嵌入。

和

具有相同体系结构,但参数不共享,因此

和

在训练过程中会包含不同的语义信息。

此外,简单地在 中加入随机高斯噪声,进一步保持了两种视图之间的差异:

其中, 从高斯分布

中采样。总之,通过设计参数非共享编码器,直接破坏节点嵌入,而不是对图引入复杂的数据增强,构造了两个增强视图

和

,从而提高了训练效率。此外,[17,28,32]最近的研究表明,图上的复杂数据扩充,如加边、掉边和图扩散,可能会导致语义漂移。

随后,设计了一种新的面向邻居的对比损失来保持横视图结构的一致性。具体地,计算 和

之间的交叉视点样本相似矩阵

:

其中, 表示第一个视图中第

个节点嵌入与第二个视图中第

个节点嵌入的余弦相似度。然后,我们强制交叉视图样本相似度矩阵

等于自环邻接矩阵

,公式如下:

其中, 表示

,

表示

。在这里,将交叉视图同一节点的邻居视为正样本,而将其他非邻居节点视为负样本。然后把正样本拉在一起,同时推开负样本。更准确地说,在

中,第一项迫使节点即使在两个不同的视图中也与它们的邻居保持一致,而第二项则使节点与其非邻居之间的一致最小化。

2.5 Fusion and Clustering

在本节中,以线性的方式融合节点嵌入的两个增强视图,公式如下:

其中, 表示生成的面向聚类的节点嵌入。然后在

上直接执行K-means算法,得到聚类结果。

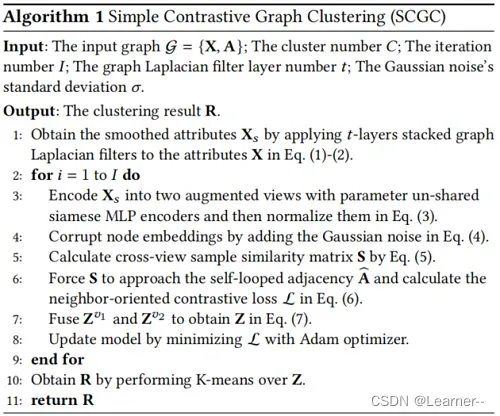

2.6 Algorithm

SCGC 算法如下:

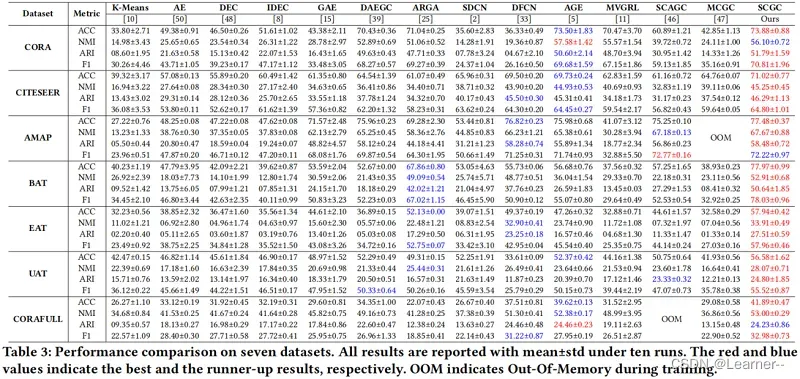

3 Experiment

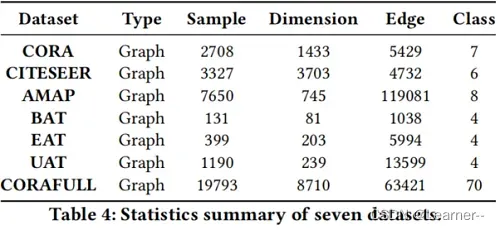

数据集

聚类实验

4 Conclusion

本文提出了一种对比深度图聚类方法,即简单对比图聚类(SCGC),从网络架构、数据增强和目标函数等方面改进了现有的方法。至于架构我们的网络主要包括预处理和网络骨干两个部分。具体地说,一个简单的低通去噪操作将邻居信息聚合作为一个独立的预处理。通过该操作,我们有效地过滤掉了属性中的高频噪声,从而提高了聚类性能。此外,只有两个mlp作为骨干。对于数据增强,我们通过设置参数非共享的编码器和破坏节点嵌入来构造不同的图视图,而不是在图上引入复杂的操作。此外,我们提出了一种新的面向邻居的对比损失来保持横视图结构的一致性,从而提高了网络的鉴别能力。得益于SCGC的简单性,它不需要预训练,并且节省了网络训练的时间和空间。值得注意的是,我们的算法优于最近的对比深度聚类竞争对手,平均加速速度至少为7倍。在7个数据集上的大量实验结果证明了SCGC的有效性和优越性。今后,为大规模图数据设计深度图聚类方法是值得尝试的。

5 Reference

[2] Structural deep clustering network

[4] Multi-view attribute graph convolution networks for clustering

[5] Adaptive graph encoder for attributed graph embedding

[11] Contrastive multi-view representation learning on graphs

[15] Variational graph auto-encoders

[17] Augmentation-Free Self-Supervised Learning on Graphs

[18] Deeper insights into graph convolutional networks for semi-supervised learning

[20] Multilayer Graph Contrastive Clustering Network

[21] Deep Graph Clustering via Dual Correlation Reduction

[22] Improved Dual Correlation Reduction Network

[25] Learning graph embedding with adversarial training methods

[26] Symmetric graph convolutional autoencoder for unsupervised graph representation learning

[27] Attention-driven Graph Clustering Network

[29] Adversarial graph embedding for ensemble clustering

[33] Deep Fusion Clustering Network

[39] Attributed graph clustering: A deep attentional embedding approach.

[40] Mgae: Marginalized graph autoencoder for graph clustering

[44] Simplifying graph convolutional networks

[46] Self-supervised Contrastive Attributed Graph Clustering

[47] Multi-view graph embedding clustering network: Joint self-supervision and block diagonal representation

[55] Graph debiased contrastive learning with joint representation clustering.

文章出处登录后可见!