可解释性与公平性的关系

可解释模型更可能公平的 3 个原因

可解释性和公平性似乎齐头并进。可解释性涉及了解模型如何进行预测。公平涉及了解预测是否偏向某些群体。这些特征在负责任的 AI 框架和 ML 会议中一直一起提到。然而,可解释性并不一定意味着公平。[0][1]

话虽如此,可解释的模型仍然更有可能是公平的。这种关联有 3 个关键原因。对于可解释的模型,更容易确定不公平的原因。在可解释的模型中纠正不公平也更容易。一些方法,例如证明解释,甚至依赖于可解释性。最后,这两个特征通过在 AI 系统中建立信任的目标相关联。我们将深入讨论这些原因。

用不可知的方法测量偏差

在深入研究这些内容之前,让我们讨论一下如何分析公平性。这也将帮助我们理解为什么这不是可解释性和公平性相关的原因之一。通常,公平性度量与模型无关。这意味着它们可以与任何模型一起使用。这包括固有的可解释模型,如线性回归和决策树。它还包括可解释性较差的模型,例如随机森林甚至神经网络。[0][1]

准确性将是衡量公平性的一个简单示例。具体来说,我们将比较模型在不同人群中的准确性。在这里,子组由种族或性别等敏感特征定义。如果其中一个子组的准确性显着降低,则表明该模型对该组不公平。

要计算这种公平性度量,我们需要的只是模型的预测和实际的目标变量。我们不需要研究模型本身的内部运作。这意味着计算可解释模型和难以解释模型的度量同样容易。换句话说,如果模型不公平,可解释性并不能更容易理解。问题是,像这样的衡量标准并不能告诉我们为什么一个模型是不公平的。

原因1:更容易识别不公平的原因

造成不公平的原因多种多样。这些包括用于训练模型的数据中的偏差。具体来说,历史偏差、代理变量和不平衡的数据集可能导致不公平的预测。我们围绕算法的选择以及用户与模型的交互方式也会引入偏见。对于可解释的模型,更容易识别这些来源。[0]

这是因为,对于可解释的模型,更容易理解模型的工作原理。这意味着我们清楚地了解哪些功能很重要。我们还了解这些特征与目标变量之间的关系。通常,与神经网络等模型相比,算法和成本函数也简单得多。所有这些都让我们更容易找出导致模型不公平的原因。

与这个原因相关的是模型的构建方式。通常,当您构建可解释的模型(例如线性回归)时,您最终会挑选出最终的 8 到 12 个模型特征。您还将花时间使用该领域的领域知识将特征趋势与预期进行比较。确实,更多的考虑是在特征选择上。只要我们考虑到公平性,我们就可以在模型开发过程的早期提出问题。这意味着您甚至可以在将偏差引入模型之前识别它们的来源。[0]

原因2:更容易纠正偏见

对于可解释的模型,纠正不公平也更容易。这部分源于上面讨论的第一个原因。我们纠正不公平的方法可能取决于不公平的原因。由于更容易确定原因,因此更容易选择最佳方法来纠正它。例如,我们可以纠正不公平模型的方法之一是删除代理变量。这些特征与种族或性别等敏感特征高度相关。[0]

像随机森林这样的模型可以有多达 30-40 个特征。模型结构还允许特征之间的交互。这种复杂性使得很难理解任何代理变量和目标变量之间的关系。更难理解这种关系是否会导致不公平的决定。最终,决定删除哪些代理变量更加困难。[0]

可以对算法本身进行其他更正。例如,我们可以调整成本函数以考虑公平性。这可能涉及添加惩罚不公平决定的惩罚参数。换句话说,模型的目标不仅仅是做出准确的预测,还要做出公平的预测。可解释模型的算法和成本函数通常更简单。这使得调整它们更容易。

确保公平的方法也可以超越上述定量方法。打击不公平的一个重要方法是为用户提供预测解释。然后赋予用户挑战这些预测的能力。我们越了解模型的工作原理,就越容易以人性化的方式进行解释。换句话说,可解释性使给出好的解释变得更容易。[0]

原因 3:它们都是为了建立信任

最重要的原因是可解释性和公平性的共同目标。它们都是关于建立对人工智能系统的信任。这主要是通过减少这些系统可能造成的危害来实现的。那就是我们不会相信我们认为会对我们造成伤害的东西。

我们更有可能相信我们理解的东西。此外,我们越了解某事,就越能确定它不会造成伤害。从这个意义上说,可解释性建立了信任。公平的目标更加直接。它旨在减少不公平决定形式的伤害。最终,一个关心对其 AI 系统信任的组织将关心可解释性和公平性。

这就是为什么你会经常在责任人工智能框架中看到公平性和可解释性一起提到的原因。这些是旨在定义开发人工智能系统的道德准则和最佳实践的治理框架。除了公平性和可解释性之外,这些框架还涵盖了安全、安保和隐私等主题。谷歌、微软和 IBM 等公司都有自己的框架。他们明白客户不会使用他们不信任的系统。[0][1][2][3]

人工智能的发展为改善世界各地人们的生活创造了新的机会,从商业到医疗保健再到教育。它还提出了有关在这些系统中构建公平性、可解释性、隐私和安全性的最佳方式的新问题。

— 谷歌人工智能关于负责任的人工智能实践[0]

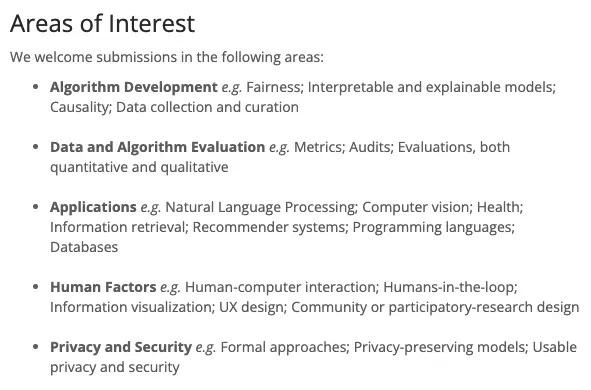

出于类似的原因,公平性和可解释性是相关的研究主题。例如,您可以在下面看到 FAccT 2022 会议论文的一些感兴趣的领域。这是关于公平、问责和透明度的会议。公平性和可解释性是算法开发中首先提到的主题。对减少 AI 系统危害感兴趣的研究人员将对这两个主题感兴趣。

对信任的需求是公平和可解释性之间关系的真正驱动力。我们看到可解释模型的特征也拉近了这种关系。在此过程中,我们触及了一些与公平相关的话题。这就是产生不公平的原因、分析公平和保证公平的途径。以下三篇文章深入探讨了这些主题。

我希望你觉得这篇文章有帮助!如果你想看到更多,你可以成为我推荐的成员之一来支持我。您将可以访问媒体上的所有文章,我将获得您的部分费用。[0]

Image Sources

所有图片都是我自己的或从 www.flaticon.com 获得。对于后者,我拥有其高级计划中定义的“完整许可”。[0][1]

References

Birhane, A.,(2021)算法不公正:一种关系伦理方法。 https://www.sciencedirect.com/science/article/pii/S2666389921000155[0]

Pessach, D. 和 Shmueli, E.,(2020 年),算法公平。 https://arxiv.org/abs/2001.09784[0]

Mehrabi, N.、Morstatter, F.、Saxena, N.、Lerman, K. 和 Galstyan, A., (2021),关于机器学习中的偏见和公平性的调查。 https://arxiv.org/abs/1908.09635[0]

文章出处登录后可见!