0. 前言

人脸处理是人工智能中的热门话题,它可以利用计算机视觉算法自动从人脸中提取大量信息,如身份、意图、情感等;虽然对象跟踪试图在整个视频序列中估计对象的轨迹,但只有目标的初始位置是已知的,将两者结合起来会产生许多有趣的应用。由于外观变化、遮挡、快速运动、运动模糊和尺度变化等多种因素,人脸跟踪非常具有挑战性。

1. 人脸追踪技术简介

基于判别相关滤波器 (discriminative correlation filter,DCF) 的视觉跟踪器具有优异的性能和较高的计算效率,可用于实时应用程序。DCF跟踪器是一种非常流行的基于边界框跟踪的方法。

在dlib库中实现了基于DCF的跟踪器,可以很方便的将其用于对象跟踪。在本文中,我们将介绍如何使用此跟踪器进行人脸和用户选择对象的跟踪,这种方法也称为判别尺度空间跟踪器 (Discriminative Scale Space Tracker,DSST),追踪器仅需要输入原始视频和目标初始位置的边界框,然后跟踪器自动预测目标的轨迹。

2. 使用基于 dlib DCF 的跟踪器进行人脸跟踪

在进行人脸追踪时,我们首先使用dlib人脸检测器进行初始化,然后使用基于dlib DCF的跟踪器DSST进行人脸跟踪。调用以下函数初始化相关跟踪器:

tracker = dlib.correlation_tracker()

这将使用默认值 (filter_size = 6, num_scale_levels = 5, scale_window_size = 23, regularizer_space = 0.001, nu_space = 0.025, regularizer_scale = 0.001, nu_scale = 0.025, scale_pyramid_alpha = 1.020) 初始化跟踪器。filter_size和num_scale_levels的值越大,跟踪精度越高,但它需要算力也更大;filter_size的推荐使用值为5、6和7;num_scale_levels的推荐使用值为4、5和6。

使用tracker.start_track()可以开始跟踪。在开始追踪前,我们需要先执行人脸检测,并将检测到的人脸位置传递给这个方法:

if tracking_face is False:

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 尝试检测人脸以初始化跟踪器

rects = detector(gray, 0)

# 检查是否检测到人脸

if len(rects) > 0:

# 开始追踪

tracker.start_track(frame, rects[0])

tracking_face = True

当检测到人脸后,人脸跟踪器将开始跟踪边界框内的内容。为了更新被跟踪对象的位置,需要调用tracker.update()方法:

tracker.update(frame)

tracker.update()方法更新跟踪器并返回衡量跟踪器置信度的指标,此指标可用于使用人脸检测重新初始化跟踪器。

要获取被跟踪对象的位置,需要调用tracker.get_position()方法:

pos = tracker.get_position()

tracker.get_position()方法返回被跟踪对象的位置。最后,绘制人脸的预测位置:

cv2.rectangle(frame, (int(pos.left()), int(pos.top())), (int(pos.right()), int(pos.bottom())), (0, 255, 0), 3)

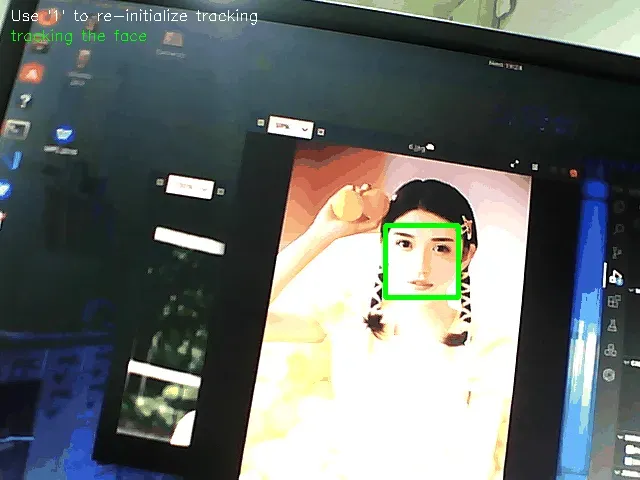

下图是人脸跟踪算法的跟踪效果过程:

在上图中,可以看到算法当前正在跟踪检测到的人脸,同时还可以按数字 1 以重新初始化跟踪。

2.1 完整代码

完整代码如下所示,同时我们需要提供按下数字1时重新初始化跟踪器的选项。

import cv2

import dlib

def draw_text_info():

# 绘制文本的位置

menu_pos_1 = (10, 20)

menu_pos_2 = (10, 40)

# 绘制菜单信息

cv2.putText(frame, "Use '1' to re-initialize tracking", menu_pos_1, cv2.FONT_HERSHEY_SIMPLEX, 0.5, (255, 255, 255))

if tracking_face:

cv2.putText(frame, "tracking the face", menu_pos_2, cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0))

else:

cv2.putText(frame, "detecting a face to initialize tracking...", menu_pos_2, cv2.FONT_HERSHEY_SIMPLEX, 0.5,

(0, 0, 255))

# 创建视频捕获对象

capture = cv2.VideoCapture(0)

# 加载人脸检测器

detector = dlib.get_frontal_face_detector()

# 初始化追踪器

tracker = dlib.correlation_tracker()

# 当前是否在追踪人脸

tracking_face = False

while True:

# 捕获视频帧

ret, frame = capture.read()

# 绘制基本信息

draw_text_info()

if tracking_face is False:

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 尝试检测人脸以初始化跟踪器

rects = detector(gray, 0)

# 通过判断是否检测到人脸来决定是否启动追踪

if len(rects) > 0:

# Start tracking:

tracker.start_track(frame, rects[0])

tracking_face = True

if tracking_face is True:

# 更新跟踪器并打印测量跟踪器的置信度

print(tracker.update(frame))

# 获取被跟踪对象的位置

pos = tracker.get_position()

# 绘制被跟踪对象的位置

cv2.rectangle(frame, (int(pos.left()), int(pos.top())), (int(pos.right()), int(pos.bottom())), (0, 255, 0), 3)

# 捕获键盘事件

key = 0xFF & cv2.waitKey(1)

# 按 1 初始化追踪器

if key == ord("1"):

tracking_face = False

# 按 q 退出

if key == ord('q'):

break

# 显示结果

cv2.imshow("Face tracking using dlib frontal face detector and correlation filters for tracking", frame)

# 释放所有资源

capture.release()

cv2.destroyAllWindows()

3. 使用基于 dlib DCF 的跟踪器进行对象跟踪

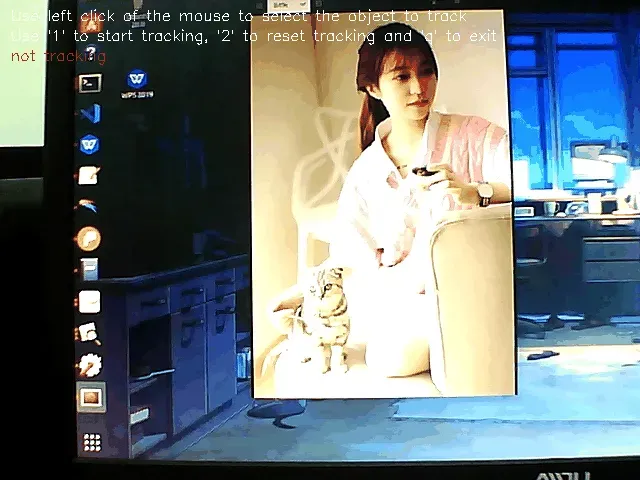

除了人脸外,基于dlib DCF的跟踪器可以用于跟踪任意对象。接下来,我们使用鼠标选择要跟踪的对象,并监听键盘事件,如果按1,将开始跟踪预定义边界框内的对象;如果按2,预定义的边界框将被清空,跟踪算法将停止,并等待用户选择另一个边界框。

例如,我们对检测小姐姐并不感兴趣,而更喜欢猫,那么我们可以首先用鼠标绘制矩形框选择喵咪,然后按1开始追踪小猫咪,如果我们想要追踪其他物体,可以按2重新绘制矩形框并进行追踪。如下所示,我们可以看到算法跟踪对象并进行实时输出:

3.2 完整代码

完整的代码如下所示:

import cv2

import dlib

def draw_text_info():

# 绘制文本的位置

menu_pos_1 = (10, 20)

menu_pos_2 = (10, 40)

menu_pos_3 = (10, 60)

# 菜单项

info_1 = "Use left click of the mouse to select the object to track"

info_2 = "Use '1' to start tracking, '2' to reset tracking and 'q' to exit"

# 绘制菜单信息

cv2.putText(frame, "Use '1' to re-initialize tracking", menu_pos_1, cv2.FONT_HERSHEY_SIMPLEX, 0.5, (255, 255, 255))

cv2.putText(frame, info_2, menu_pos_2, cv2.FONT_HERSHEY_SIMPLEX, 0.5, (255, 255, 255))

if tracking_state:

cv2.putText(frame, "tracking", menu_pos_3, cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0))

else:

cv2.putText(frame, "not tracking", menu_pos_3, cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 0, 255))

# 用于保存要跟踪的对象坐标的结构

points = []

def mouse_event_handler(event, x, y, flags, param):

# 对全局变量的引用

global points

# 添加要跟踪的对象的左上角坐标

if event == cv2.EVENT_LBUTTONDOWN:

points = [(x, y)]

# 添加要跟踪的对象的右下角坐标:

elif event == cv2.EVENT_LBUTTONUP:

points.append((x, y))

# 创建视频捕获对象

capture = cv2.VideoCapture(0)

# 窗口名

window_name = "Object tracking using dlib correlation filter algorithm"

# 创建窗口

cv2.namedWindow(window_name)

# 绑定鼠标事件

cv2.setMouseCallback(window_name, mouse_event_handler)

# 初始化跟踪器

tracker = dlib.correlation_tracker()

tracking_state = False

while True:

# 捕获视频帧

ret, frame = capture.read()

# 绘制菜单项

draw_text_info()

# 设置并绘制一个矩形,跟踪矩形框内的对象

if len(points) == 2:

cv2.rectangle(frame, points[0], points[1], (0, 0, 255), 3)

dlib_rectangle = dlib.rectangle(points[0][0], points[0][1], points[1][0], points[1][1])

if tracking_face is True:

# 更新跟踪器并打印测量跟踪器的置信度

print(tracker.update(frame))

# 获取被跟踪对象的位置

pos = tracker.get_position()

# 绘制被跟踪对象的位置

cv2.rectangle(frame, (int(pos.left()), int(pos.top())), (int(pos.right()), int(pos.bottom())), (0, 255, 0), 3)

# 捕获键盘事件

key = 0xFF & cv2.waitKey(1)

# 按下 1 键,开始追踪

if key == ord("1"):

if len(points) == 2:

# Start tracking:

tracker.start_track(frame, dlib_rectangle)

tracking_state = True

points = []

# 按下 2 键,停止跟踪

if key == ord("2"):

points = []

tracking_state = False

# 按下 q 键,返回

if key == ord('q'):

break

# 展示结果图像

cv2.imshow(window_name, frame)

# 释放资源

capture.release()

cv2.destroyAllWindows()

概括

dlib库实现了基于DCF的跟踪器,非常适合用于进行人脸追踪,使用dlib.correlation_tracker()函数初始化跟踪器,tracker.start_track()函数用于开始追踪对象,tracker.update()函数更新追踪器并且返回追踪器置信度,若要获取被跟踪对象的位置需要使用tracker.get_position()函数。

系列链接

OpenCV-Python实战(1)——OpenCV简介与图像处理基础

OpenCV-Python实战(2)——图像与视频文件的处理

OpenCV-Python实战(3)——OpenCV中绘制图形与文本

OpenCV-Python实战(4)——OpenCV常见图像处理技术

OpenCV-Python实战(5)——OpenCV图像运算

OpenCV-Python实战(6)——OpenCV中的色彩空间和色彩映射

OpenCV-Python实战(7)——直方图详解

OpenCV-Python实战(8)——直方图均衡化

OpenCV-Python实战(9)——OpenCV用于图像分割的阈值技术

OpenCV-Python实战(10)——OpenCV轮廓检测

OpenCV-Python实战(11)——OpenCV轮廓检测相关应用

OpenCV-Python实战(12)——一文详解AR增强现实

OpenCV-Python实战(13)——OpenCV与机器学习的碰撞

OpenCV-Python实战(14)——人脸检测详解

OpenCV-Python实战(15)——面部特征点检测详解

版权声明:本文为博主盼小辉丶原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/LOVEmy134611/article/details/121156026