本文将以AIGC生成3D模型探索与实践为主题,结合电商平台的应用需求,探讨如何利用AIGC技术实现3D模型的个性化生成、大规模生产和快速推广,以及其对于电商行业的推动作用。

背景

随着电商平台的兴起,3D模型已经成为展示商品的重要手段,手机天猫正在积极探索3D相关的投放场景,电商商品3D化,可以使得用户在APP中,实时浏览3D商品模型,更直观地了解商品的外观颜色、形状结构、物理材质等信息,为用户带来更好的消费体验,为虚实结合带来更多可能,后续也可以用于AR\VR等内容生产。然而,传统的3D模型生成方法存在着效率低、精度不够高、难以满足个性化需求等问题,导致商家在展示商品时难以达到理想的效果。而AIGC(Artificial Intelligence in Graphics and Computing)技术的出现,为3D模型的生成提供了全新的思路和方法。AIGC技术可以利用人工智能和计算机图形学的结合,实现更加高效、准确和灵活的3D模型生成。

技术模型

▐ NeRF 神经辐射场

2020年,谷歌提出神经辐射场3D建模方法NeRF,可以渲染出较高质量的图片,不需要人工修模,3D建模成本较低,为大规模3D模型生产带来了新思路。起初淘宝Meta 团队主要致力于 提升 NeRF重建效果(布料细节清晰度、商品文字清晰度等提升),使其渲染清晰度达到工业落地标准。

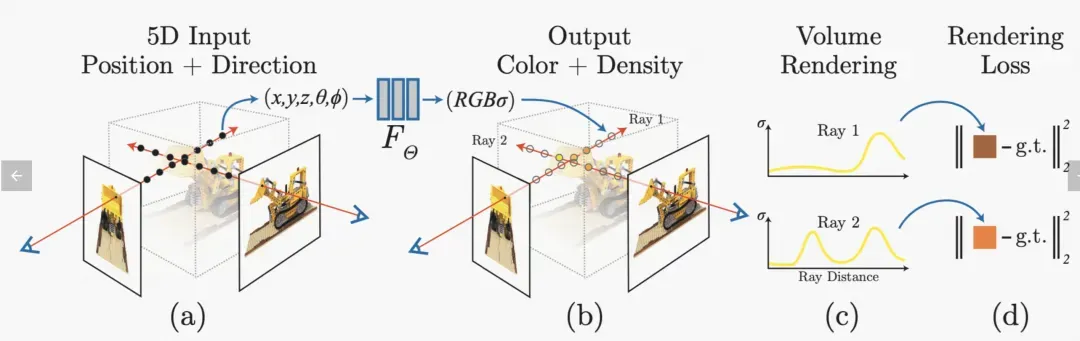

神经辐射场(NeRF)是一个简单的全连接网络(权重约为5MB),经过训练,可以使用渲染损失再现单个场景的输入视图。网络直接从空间位置和观看方向(5D输入)映射到颜色和不透明度(4D输出),充当“体积”,因此我们可以使用体积渲染来渲染新视图。神经辐射场是一种面向三维隐式空间建模的深度学习模型,这种深度学习模型又称全连接神经网络(又称多层感知机)。NeRF 所要做的任务是 Novel View Synthesis,一般翻译为新视角合成任务,定义是:在已知视角下对场景进行一系列的捕获 (包括拍摄到的图像,以及每张图像对应的内外参),不需要中间三维重建的过程,仅根据位姿内参和图像,合成新视角下的图像。在基于Nerf的表示方法下,三维空间被表示为一组可学习且连续的辐射场,由输入视角+位置学习后,得到密度+色彩。

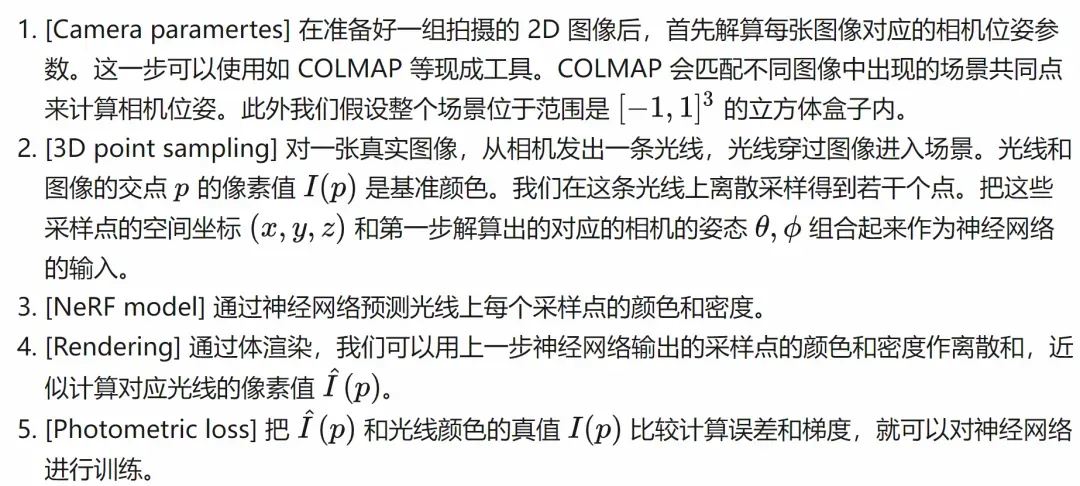

▐ Point-E

尽管基于Rerf的相关生成模型在text-to-3D的相关任务下取得了较大的进展, 但是大部分的的方法通常需要多个GPU小时才能生成一个样本。这与最先进的生成图像模型形成了鲜明的对比,后者可以在几秒钟或几分钟内生成样本。2022年OpenAI又提出 Point-E的一种独特的3D点云生成方法,该方法可以在单个GPU上仅用1-2分钟生成3D模型。Point-E首先使用文本到图像扩散模型生成单个合成视图,然后使用一个扩散模型在生成的图像的条件下产生3D点云。虽然Point-E在样本质量方面仍然不如最先进的方法,但它在样本生成速度上比最先进的方法快1到2个数量级。

Code地址:https://github.com/openai/point-e

▐ Shap-E

OpenAI再次发布了一款升级模型Shap-E,相比基于点云的显式生成模型Point-E,Shap-E直接生成隐函数的参数来渲染纹理和神经辐射场,收敛速度更快,在更高维的多表示输出空间中实现了更好的样本质量!Shap-E是一种条件生成模型,用于生成3D资产。与最近的3D生成模型只能生成单个输出表示不同,Shap-E直接生成可以呈现为纹理网格和神经辐射场的隐式函数参数。Shap-E分两个阶段:首先训练一个编码器,将3D资产确定性地映射到隐式函数的参数中;其次,在编码器输出上训练条件扩散模型。Shap-E在大型配对的3D和文本数据集上训练时,得到的模型能够在几秒钟内生成复杂而多样化的3D资产。与点云上的显式生成模型Point-E相比,尽管建模了更高维度的多重表示输出空间,Shap-E收敛更快,并达到了更好的样本质量。

git: https://github.com/openai/shap-e/tree/main

|  |  |  |

|  |  |  |

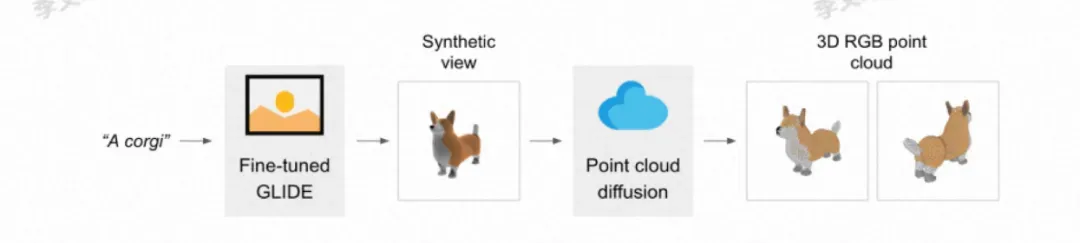

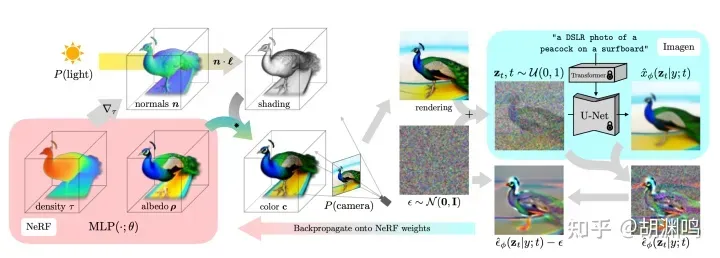

▐ DreamFusion

DreamFusion是谷歌提出的一种Text-to-3D模型,大体思路是通过 2D 生成模型(如 Imagen)生成多个视角的 3D 视图,然后用NeRF 重建。这里面有个“鸡生蛋蛋生鸡”的问题:如果没有一个训练得比较好的 NeRF,Imagen 吐出的图会视角之间没有consistency;而没有 consistent 的多视角图,又得不到一个好的 NeRF。于是作者想了个类似 GAN 的方法,NeRF 和 Imagen 来回迭代。好处是多样性比较强,问题也比较明显,因为需要两边来回迭代 15,000 次,生成一个模型就需要在 4 块 TPUv4 上训练 1.5 小时。

DreamFusion: 3D NeRF 和 2D 生成模型来回迭代优化

https://github.com/ashawkey/stable-dreamfusion

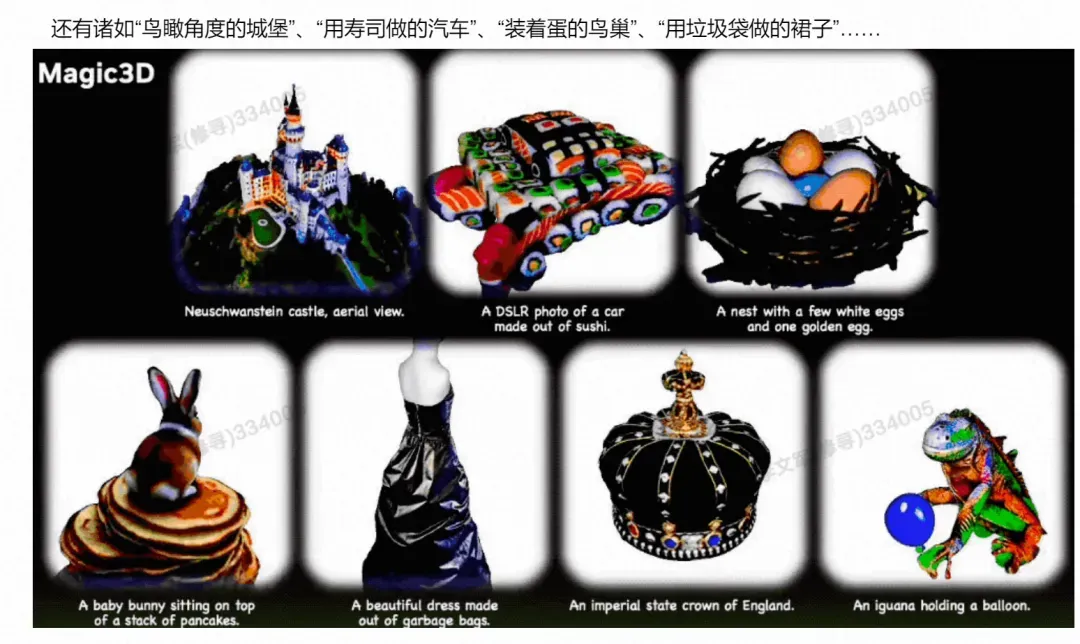

▐ Magic3D

2022年11月,英伟达(Nvidia)提出的Magic3D模型在DreamFusion的基础上提出了两步优化策略:首先用与DreamFusion相似的扩散模型生成低分辨率、简单渲染的哈希网格三维模型,之后再采用与传统计算机图形学相似的方法对三维模型进行更高质量的渲染。

与DreamFusion相比,Magic3D模型生成的三维模型分辨率更高,且渲染效果更好,生成效率也有了显著的提升。由于Magic3D模型的渲染方式与传统计算机图形学有非常紧密的关系,且其生成结果可以直接在标准的图像软件中进行查看,因此Magic3D模型可以更好地与传统三维生成工作进行衔接。鉴于各方面优势,Magic3D模型已经具备进行产业应用的能力基础。

在Magic3D模型之后,学界与业界也提出了更多三维生成模型,在生成质量、生成效率、硬件需求、场景应用等方面均进行了更深入的探讨,也有着较为明显的优势与缺陷。

模型实践

本地机器配置如下:

显卡:英伟达3060 12G

CPU:Intel I9-13900KF

内存:64GB

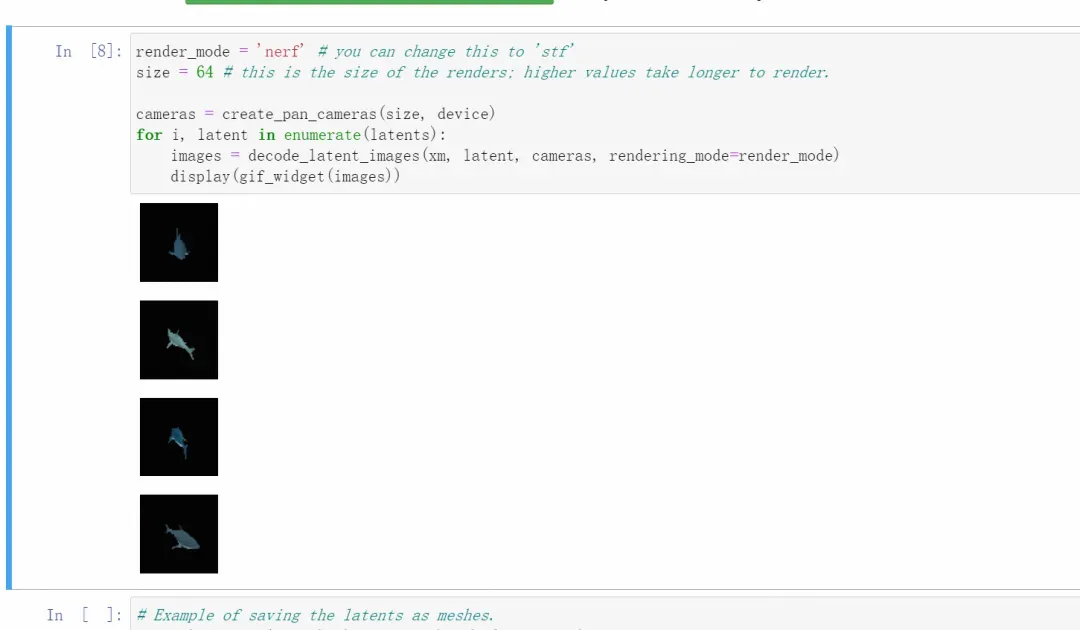

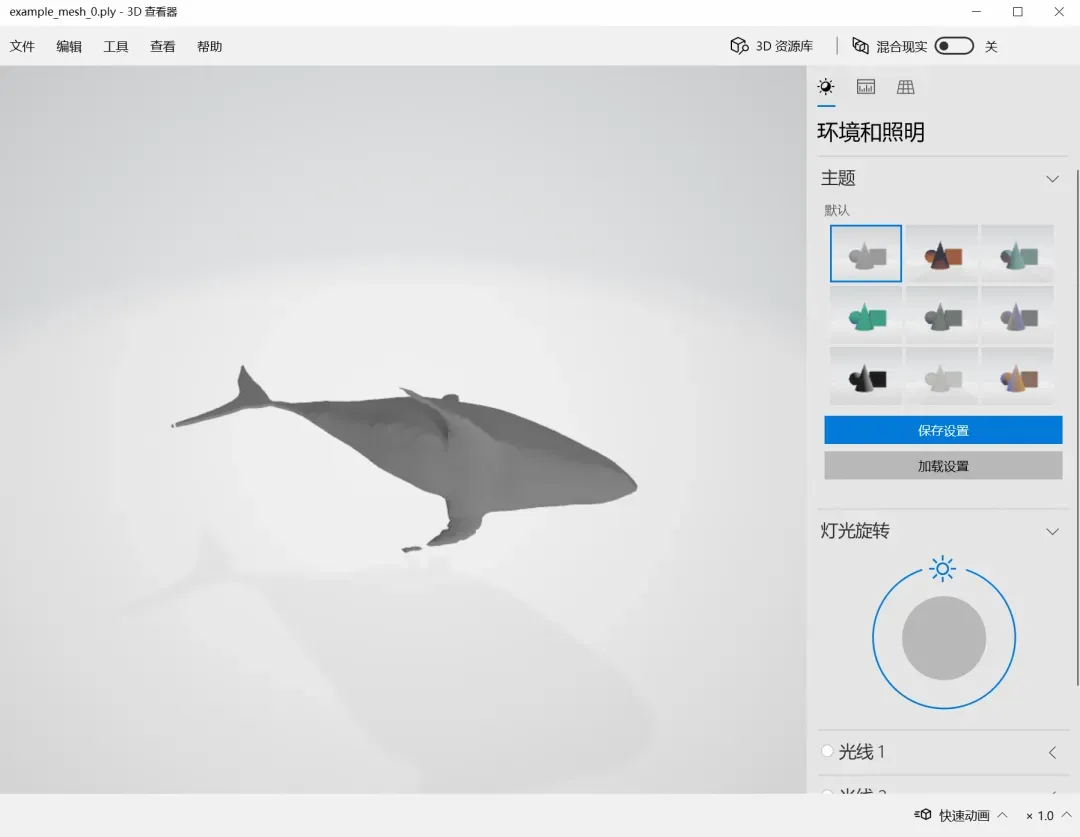

▐ Shap-E

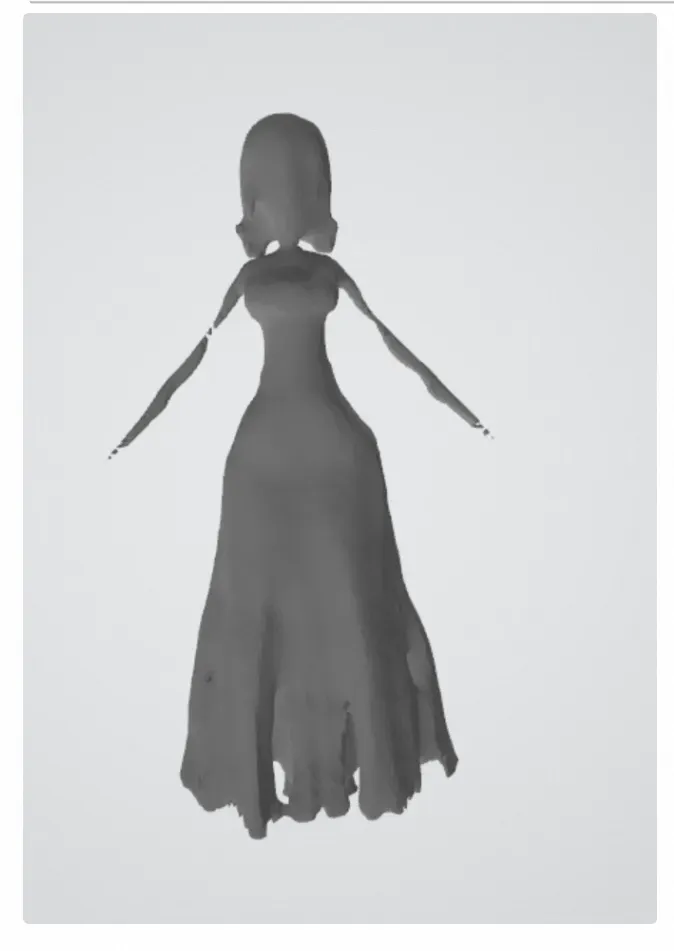

我们在本地通过cuda部署了Shap-E模型,使用Jupyter Notebook 来进行代码测试,经测试生成一个3d模型的平均时长为5分钟,但是生成的模型细节、质量等都较差。

git: https://github.com/openai/shap-e/tree/main

DEMO

|  |  |  |

|  |  |  |

Prompt:A shark

Prompt:“A beautiful girl in a long dress”

▐ AvatarCLIP

我们基于顶会论文在本地部署了AvatarCLIP,AvatarCLIP是一个基于Zero-shot的文本驱动的三维数字人模型与动作生成器。训练一个精模至少需要10h以上的时间,生成的模型包含基础的人体骨骼,可以通过mixamo平台绑定骨骼获取不错的动画效果,但是近看面部、手部等处细节比较差。项目地址:https://hongfz16.github.io/projects/AvatarCLIP.html

Prompt:a 3d rendering of a XX in unreal engine

生成一个宇航员的前1/5过程:

产出的梅西模型在mixamo平台绑定骨骼后的动画效果:

业界的应用场景

▐ 文本生成平面贴图

barium.ai(地址:https://unity.com/cn)

spline.design(地址:https://spline.design/)

Maliang(地址:https://www.bilibili.com/video/BV1A24y1x7vD/)

▐ 根据几何(mesh)在 UV 空间生成贴图(“AI 画贴图”)

Meshy.ai (地址:https://www.meshy.ai/)

Polyhive.ai(地址:https://polyhive.ai/)

▐ 文本直接生成 3D 模型

目前还没有真正公测的产品

aigc生成3D模型目前存在的一些问题

数据质量问题:由于采集数据的不准确或缺失,可能导致3D模型中存在缺陷、错位或其他问题。

计算机性能问题:在生成复杂的3D模型时,需要大量的计算和存储资源,计算机性能不足可能导致生成效果差。

纹理映射问题:生成的3D模型需要进行纹理映射,但是在现实世界中很难找到完美匹配的纹理图像,这可能导致纹理不自然或者出现缝隙等问题。

模型解释问题:生成的3D模型需要能够被人理解和识别,但是可能存在歧义或者难以解释的地方,导致使用者无法充分利用模型。

参考资料

https://www.zhihu.com/search?type=content&q=DreamFusion

Taichi NeRF (下): 关于 3D AIGC 的务实探讨(地址:https://zhuanlan.zhihu.com/p/613679756)

Taichi NeRF(上):不写 CUDA 也能开发、部署 Instant NGP

详解神经渲染算法NeRF及其发展(地址:https://zhuanlan.zhihu.com/p/612102573)

https://github.com/awesome-NeRF/awesome-NeRF

团队介绍

我们是大淘宝技术-手猫技术-营销&导购团队,我作为一支专注于手机天猫创新的商业化及导购场景探索的团队,我们团队紧密依托淘天集团强大的互联网背景,致力于为手机天猫带来更高效、更具创新性的技术支持和商业化的导购场景。

我们的团队成员来自不同的技术领域和营销导购领域,拥有丰富的技术经验和营销经验。我们不断探索并实践新的技术,创新商业化的导购场景,并将这些创新技术应用于手机天猫业务中,提高了用户体验和平台运营效率。

作为一支技术创新和商业化的团队,我们致力于为手机天猫带来更广阔的商业化空间和更高效的技术支持,赢得了用户和客户的高度评价和认可。

我们团队一直秉承“技术领先、用户至上”的理念,不断探索创新、提升技术水平,为手机天猫的导购场景和商业化发展做出重要贡献。

¤ 拓展阅读 ¤

文章出处登录后可见!